นี่คือการใช้งานอย่างเป็นทางการของกระดาษ "Dino: DETR พร้อมกล่องยึด denoising ที่ดีขึ้นสำหรับการตรวจจับวัตถุแบบครบวงจร" (Dino ออกเสียง `daɪnoʊ 'เช่นเดียวกับในไดโนเสาร์)

ผู้แต่ง: Hao Zhang*, Feng Li*, Shilong Liu*, Lei Zhang, Hang Su, Jun Zhu, Lionel M. Ni, Heung-Yeung Shum

[2023/7/10] เราเปิดตัว Semantic-Sam ซึ่งเป็นรูปแบบการแบ่งส่วนภาพสากลเพื่อเปิดใช้งานเซ็กเมนต์และรับรู้อะไรก็ได้ตามความละเอียดที่ต้องการ มี รหัส และ จุดตรวจสอบ !

[2023/4/28]: เราปล่อยโมเดลการตรวจจับวัตถุแบบเปิดและการแบ่งส่วนที่แข็งแกร่งซึ่งได้รับผลลัพธ์ที่ดีที่สุดในงานการแบ่งส่วนวัตถุแบบเปิด รหัสและจุดตรวจสอบมีอยู่ที่นี่

[2023/4/26]: Dino ส่องแสงอีกครั้ง! เราเปิดตัว Dino ที่มีเสถียรภาพซึ่งสร้างขึ้นบนกระดูกสันหลังของ Dino และ Focalnet-Huge ที่ประสบความสำเร็จ 64.8 AP บน Coco Test-Dev

[2023/4/22]: ด้วย Hyper-Params ที่ดีกว่ารุ่น Dino-4Scale ของเราได้รับ 49.8 AP ภายใต้การตั้งค่า 12EP โปรดตรวจสอบ Detrex: Dino สำหรับรายละเอียดเพิ่มเติม

[2023/3/13]: เราปล่อยรูปแบบการตรวจจับวัตถุแบบเปิดที่แข็งแกร่งลงบนดิน Dino ที่ได้ผลลัพธ์ที่ดีที่สุดในงานตรวจจับวัตถุแบบเปิด มันประสบความสำเร็จ 52.5 Zero-shot AP ในการตรวจจับ Coco โดยไม่มีข้อมูลการฝึกอบรม COCO! มันประสบความสำเร็จ 63.0 AP บน Coco หลังจากปรับแต่ง รหัสและจุดตรวจจะมีอยู่ที่นี่

[2023/1/23]: Dino ได้รับการยอมรับจาก ICLR 2023!

[2022/12/02]: รหัสสำหรับหน้ากาก Dino ได้รับการปล่อยตัว (ใน Detrex)! Mask Dino ประสบความสำเร็จเพิ่มเติม 51.7 และ 59.0 Box AP บน Coco ด้วย resnet-50 และ swinl โดยไม่มีข้อมูลการตรวจจับเพิ่มเติม ดีกว่า Dino ภาย ใต้การตั้งค่าเดียวกัน!

[2022/9/22]: เราปล่อยกล่องเครื่องมือ detrex ที่ให้อัลกอริทึมการตรวจจับที่ใช้หม้อแปลงที่ทันสมัย มันรวมถึง Dino ที่มีประสิทธิภาพที่ดีขึ้น ยินดีต้อนรับสู่การใช้งาน!

[2022/9/18]: เราจัดระเบียบวิสัยทัศน์ การประชุมเชิงปฏิบัติการของ ECCV ใน Wild (CVINW) ซึ่งมีความท้าทายสองประการที่เป็นเจ้าภาพในการประเมินผลการแข่งขันแบบซัน ::

[Workshop] [IC Challenge] [OD Challenge]

[2022/8/6]: เราอัปเดตผลลัพธ์แบบจำลอง Swin-L โดยไม่มีเทคนิคเช่น O365 การฝึกอบรมล่วงหน้าขนาดภาพขนาดใหญ่และการทดสอบหลายระดับ นอกจากนี้เรายังอัปโหลดจุดตรวจสอบที่สอดคล้องกันไปยัง Google Drive โมเดล 5 ขนาดของเราโดยไม่มีเทคนิคใด ๆ ได้รับ 58.5 AP บน Coco Val

[2022/7/14]: เราปล่อยรหัสด้วย Backbone Swin-L และ Convnext

[2022/7/10]: เราปล่อยรหัสและจุดตรวจด้วย Backbone ResNet-50

[2022/6/7]: เราเปิดตัวหน้ากากการตรวจจับและแบ่งส่วนแบบครบวงจร Dino ที่ได้ผลลัพธ์ที่ดีที่สุดในงานการแบ่งกลุ่มทั้งสาม ( 54.7 AP บนกระดานผู้นำ Coco Instance, 59.5 PQ บนกระดานผู้นำ Coco Panoptic และ 60.8 MIOU ลีดเดอร์บอร์ด)! รหัสจะพร้อมใช้งานที่นี่

[2022/5/28] รหัสสำหรับ DN-DETR มีอยู่ที่นี่

[2020/4/10]: รหัสสำหรับ DAB-DETR นั้นมีอยู่ที่นี่

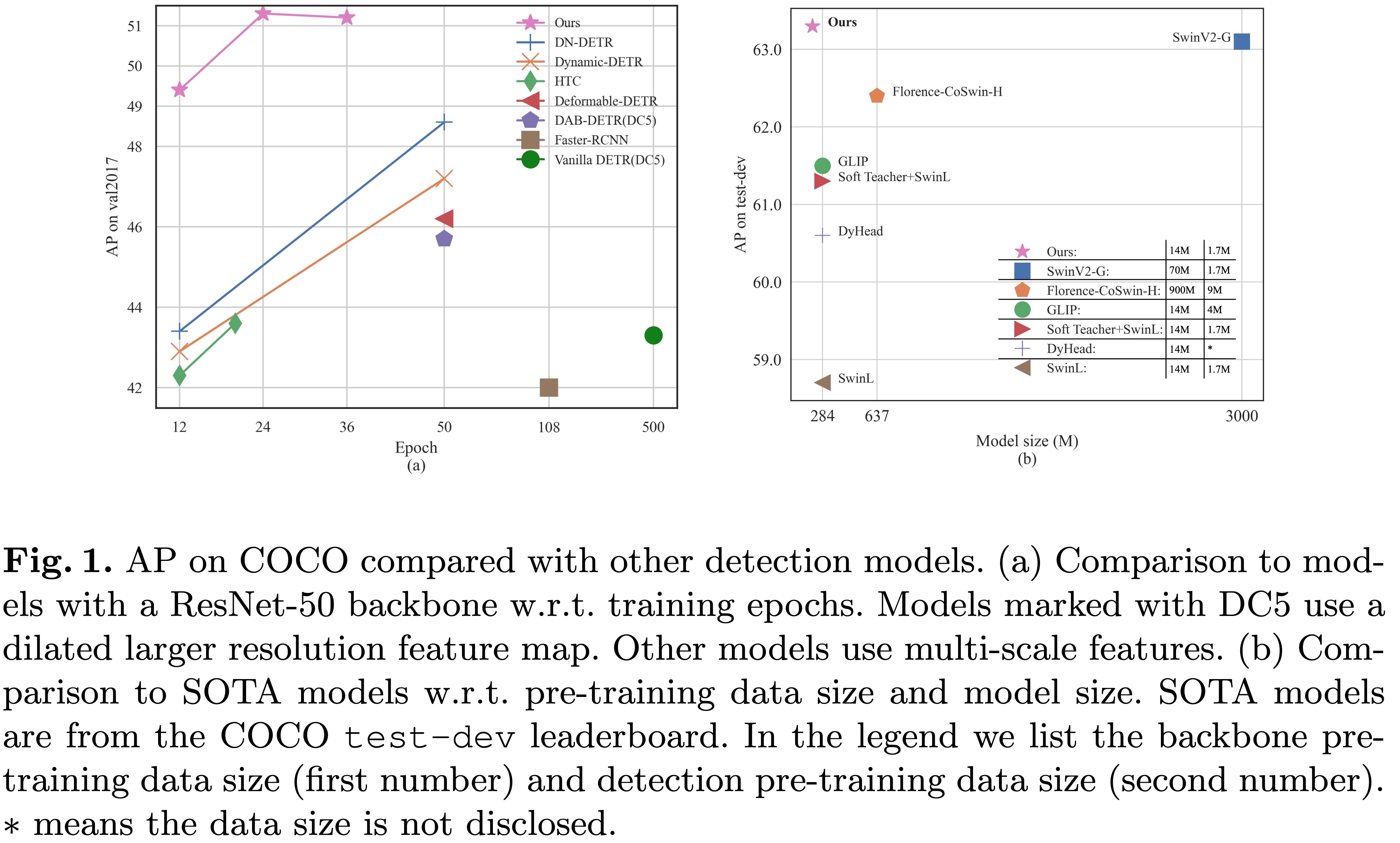

[2022/3/8]: เราไปถึง SOTA บนกระดานผู้นำ MS-COCO ด้วย 63.3AP !

[2022/3/9]: เราสร้างหม้อแปลงการตรวจจับที่ยอดเยี่ยมเพื่อนำเสนอเอกสารเกี่ยวกับหม้อแปลงสำหรับการตรวจจับและการแบ่งส่วน ยินดีต้อนรับสู่ความสนใจของคุณ!

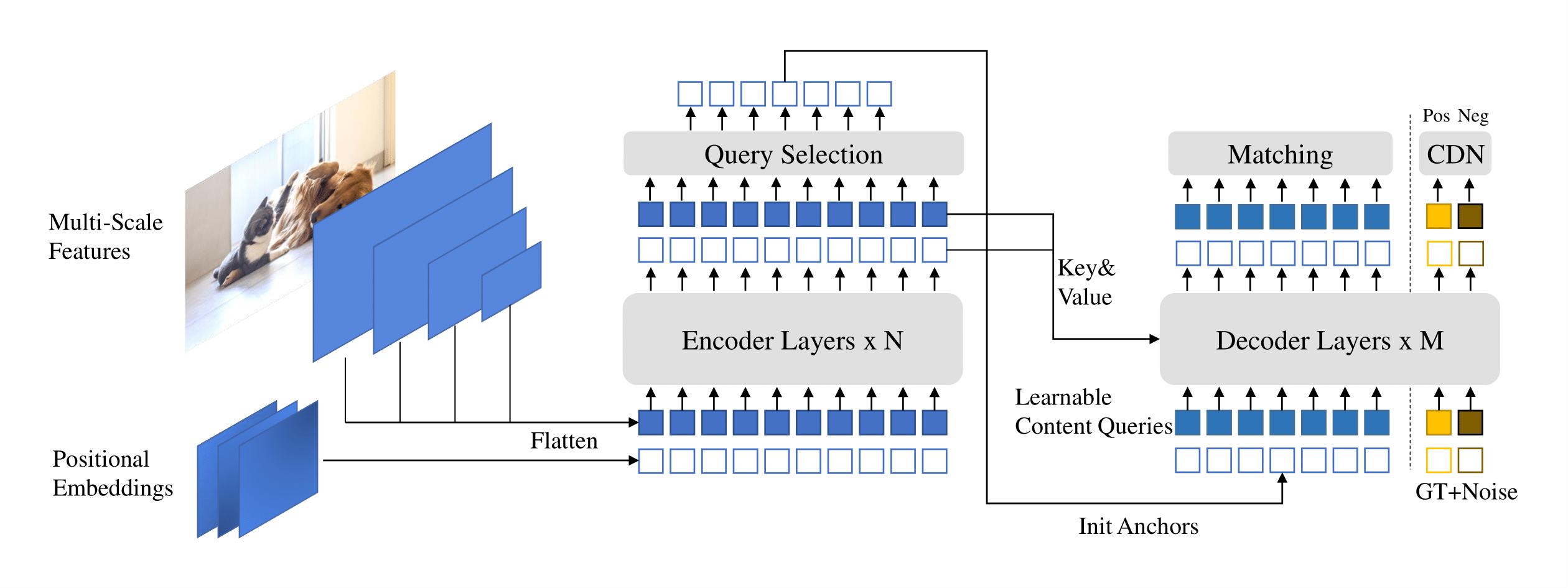

เรานำเสนอ dino ( d etr กับ i mproved de n oising anch o boxes) กับ:

เราได้วางจุดตรวจสอบโมเดลของเราไว้ที่นี่ [Model Zoo ใน Google Drive] [Model Zoo ใน百度网盘] (提取码 "dino") ที่จุดตรวจ {x} _ {y} scale.pth หมายถึงจุดตรวจของรุ่น Y-scale ได้รับการฝึกฝนสำหรับ X Epochs บันทึกการฝึกอบรมของเราอยู่ใน [Google Drive]

| ชื่อ | กระดูกสันหลัง | กล่อง AP | ด่าน | ที่ไหนในกระดาษของเรา | |

|---|---|---|---|---|---|

| 1 | Dino-4scale | R50 | 49.0 | Google Drive / Baidu | ตารางที่ 1 |

| 2 | Dino-5scale | R50 | 49.4 | Google Drive / Baidu | ตารางที่ 1 |

| 3 | Dino-4scale | swin-l | 56.8 | Google Drive | |

| 4 | Dino-5scale | swin-l | 57.3 | Google Drive |

| ชื่อ | กระดูกสันหลัง | กล่อง AP | ด่าน | ที่ไหนในกระดาษของเรา | |

|---|---|---|---|---|---|

| 1 | Dino-4scale | R50 | 50.4 | Google Drive / Baidu | ตารางที่ 2 |

| 2 | Dino-5scale | R50 | 51.3 | Google Drive / Baidu | ตารางที่ 2 |

| ชื่อ | กระดูกสันหลัง | กล่อง AP | ด่าน | ที่ไหนในกระดาษของเรา | |

|---|---|---|---|---|---|

| 1 | Dino-4scale | R50 | 50.9 | Google Drive / Baidu | ตารางที่ 2 |

| 2 | Dino-5scale | R50 | 51.2 | Google Drive / Baidu | ตารางที่ 2 |

| 3 | Dino-4scale | swin-l | 58.0 | Google Drive | |

| 4 | Dino-5scale | swin-l | 58.5 | Google Drive |

เราใช้สภาพแวดล้อมแบบเดียวกันกับ DAB-DETR และ DN-DETR เพื่อเรียกใช้ Dino หากคุณใช้ DN-DETR หรือ DAB-DETR คุณสามารถข้ามขั้นตอนนี้ได้ เราทดสอบโมเดลของเราภายใต้ python=3.7.3,pytorch=1.9.0,cuda=11.1 อาจมีรุ่นอื่น ๆ เช่นกัน คลิก Details ด้านล่างเพื่อดูรายละเอียดเพิ่มเติม

git clone https://github.com/IDEA-Research/DINO.git

cd DINOทำตามคำแนะนำใน https://pytorch.org/get-started/locally/

# an example:

conda install -c pytorch pytorch torchvisionpip install -r requirements.txt cd models/dino/ops

python setup.py build install

# unit test (should see all checking is True)

python test.py

cd ../../..โปรดดาวน์โหลดชุดข้อมูล Coco 2017 และจัดระเบียบดังต่อไปนี้:

COCODIR/

├── train2017/

├── val2017/

└── annotations/

├── instances_train2017.json

└── instances_val2017.json

ดาวน์โหลดจุดตรวจ Dino Model ของเรา "CheckPoint0011_4Scale.Pth" จากลิงค์นี้และดำเนินการตามคำสั่งด้านล่าง คุณสามารถคาดหวังว่าจะได้รับ AP สุดท้ายประมาณ 49.0

bash scripts/DINO_eval.sh /path/to/your/COCODIR /path/to/your/checkpointสำหรับการอนุมานและการสร้างภาพข้อมูลเราได้จัดทำสมุดบันทึกเป็นตัวอย่าง

เราใช้โมเดล Dino 4 ขนาดที่ได้รับการฝึกฝนสำหรับ 12 Epochs เป็นตัวอย่างในการสาธิตวิธีการประเมินและฝึกอบรมแบบจำลองของเรา

นอกจากนี้คุณยังสามารถฝึกอบรมแบบจำลองของเราในกระบวนการเดียว:

bash scripts/DINO_train.sh /path/to/your/COCODIRในการฝึกอบรมรุ่น Swin-L คุณต้องดาวน์โหลดจุดตรวจของ Backbone Swin-L จากลิงค์ก่อนและระบุ DIR ของกระดูกสันหลังที่ผ่านการฝึกอบรมมาก่อนเมื่อเรียกใช้สคริปต์ นี่คือตัวอย่าง

bash scripts/DINO_train_submitit_swin.sh /path/to/your/COCODIR /path/to/your/pretrained_backbone

เนื่องจากการฝึกอบรมใช้เวลานานเราขอแนะนำให้ฝึกอบรมแบบจำลองในหลายอุปกรณ์

หากคุณวางแผนที่จะฝึกอบรมแบบจำลอง บนคลัสเตอร์ด้วย Slurm นี่คือคำสั่งตัวอย่างสำหรับการฝึกอบรม:

# for DINO-4scale: 49.0

bash scripts/DINO_train_submitit.sh /path/to/your/COCODIR

# for DINO-5scale: 49.4

bash scripts/DINO_train_submitit_5scale.sh /path/to/your/COCODIRหมายเหตุ: ผลลัพธ์มีความไวต่อขนาดแบทช์ เราใช้ 16 (2 ภาพแต่ละ GPU x 8 GPU สำหรับ Dino-4scale และ 1 ภาพแต่ละ GPU x 16 GPU สำหรับ Dino-5Scale) โดยค่าเริ่มต้น

หรือทำงานด้วย หลายกระบวนการบนโหนดเดียว :

# for DINO-4scale: 49.0

bash scripts/DINO_train_dist.sh /path/to/your/COCODIRในการฝึกอบรม Dino ในชุดข้อมูลที่กำหนดเอง ตั้งแต่เริ่มต้น คุณต้องปรับพารามิเตอร์สองตัวในไฟล์กำหนดค่า:

num_classes เป็นจำนวนคลาสที่จะตรวจจับในชุดข้อมูลของคุณdn_labebook_size เพื่อให้แน่ใจว่า dn_labebook_size >= num_classes + 1ใน การใช้ประโยชน์จากโมเดลที่ผ่านการฝึกอบรมมาล่วงหน้าของเรา สำหรับการปรับแต่งแบบจำลองเราขอแนะนำให้เพิ่มคำสั่งอีกสองคำในการทุบตี:

--pretrain_model_path /path/to/a/pretrianed/model ระบุโมเดลที่ผ่านการฝึกอบรมมาก่อน--finetune_ignore label_enc.weight class_embed ละเว้นพารามิเตอร์ที่ไม่สอดคล้องกันบางอย่างแบบจำลองของเราขึ้นอยู่กับ DAB-DETR และ DN-DETR

DN-DETR: เร่งการฝึกอบรม DETR โดยการแนะนำการสอบถาม DENOISIES

Feng Li*, Hao Zhang*, Shilong Liu, Jian Guo, Lionel M. Ni, Lei Zhang

การประชุม IEEE เกี่ยวกับการมองเห็นคอมพิวเตอร์และการจดจำรูปแบบ ( CVPR ) 2022

[กระดาษ] [รหัส] [中文解读]

DAB-DETR: กล่องจุดยึดแบบไดนามิกเป็นแบบสอบถามที่ดีกว่าสำหรับ DETR

Shilong Liu, Feng Li, Hao Zhang, Xiao Yang, Xianbiao Qi, Hang Su, Jun Zhu, Lei Zhang

การประชุมนานาชาติเกี่ยวกับการเป็นตัวแทนการเรียนรู้ ( ICLR ) 2022

[กระดาษ] [รหัส]

นอกจากนี้เรายังขอขอบคุณงานก่อนหน้านี้ที่ยอดเยี่ยมรวมถึง DETR, DETR ที่ผิดรูปได้, SMCA, DETR แบบมีเงื่อนไข, Anchor DETR, Dynamic DETR ฯลฯ งานที่เกี่ยวข้องมากขึ้นมีอยู่ที่หม้อแปลงตรวจจับที่ยอดเยี่ยม

Dino ได้รับการปล่อยตัวภายใต้ใบอนุญาต Apache 2.0 โปรดดูไฟล์ใบอนุญาตสำหรับข้อมูลเพิ่มเติม

แนวคิดลิขสิทธิ์ (c) สงวนลิขสิทธิ์

ได้รับใบอนุญาตภายใต้ใบอนุญาต Apache เวอร์ชัน 2.0 ("ใบอนุญาต"); คุณไม่สามารถใช้ไฟล์เหล่านี้ยกเว้นตามใบอนุญาต คุณอาจได้รับสำเนาใบอนุญาตที่ http://www.apache.org/licenses/license-2.0

เว้นแต่ว่ากฎหมายที่บังคับใช้หรือตกลงเป็นลายลักษณ์อักษรซอฟต์แวร์ที่แจกจ่ายภายใต้ใบอนุญาตจะถูกแจกจ่ายตาม "ตามพื้นฐาน" โดยไม่มีการรับประกันหรือเงื่อนไขใด ๆ ไม่ว่าจะโดยชัดแจ้งหรือโดยนัย ดูใบอนุญาตสำหรับภาษาเฉพาะที่ควบคุมการอนุญาตและข้อ จำกัด ภายใต้ใบอนุญาต

หากคุณพบว่างานของเรามีประโยชน์สำหรับการวิจัยของคุณโปรดพิจารณาอ้างถึงรายการ Bibtex ต่อไปนี้

@misc { zhang2022dino ,

title = { DINO: DETR with Improved DeNoising Anchor Boxes for End-to-End Object Detection } ,

author = { Hao Zhang and Feng Li and Shilong Liu and Lei Zhang and Hang Su and Jun Zhu and Lionel M. Ni and Heung-Yeung Shum } ,

year = { 2022 } ,

eprint = { 2203.03605 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

}

@inproceedings { li2022dn ,

title = { Dn-detr: Accelerate detr training by introducing query denoising } ,

author = { Li, Feng and Zhang, Hao and Liu, Shilong and Guo, Jian and Ni, Lionel M and Zhang, Lei } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition } ,

pages = { 13619--13627 } ,

year = { 2022 }

}

@inproceedings {

liu2022dabdetr,

title = { {DAB}-{DETR}: Dynamic Anchor Boxes are Better Queries for {DETR} } ,

author = { Shilong Liu and Feng Li and Hao Zhang and Xiao Yang and Xianbiao Qi and Hang Su and Jun Zhu and Lei Zhang } ,

booktitle = { International Conference on Learning Representations } ,

year = { 2022 } ,

url = { https://openreview.net/forum?id=oMI9PjOb9Jl }

}