สร้างเกมและโปรแกรมโดยใช้ตัวแทน OpenAI สร้างขึ้นบน Microsoft Autogen

ทำงานระหว่างดำเนินการ

รหัสปัจจุบันใช้งานได้ แต่:

- มีและจะมีการเปลี่ยนแปลงการเปลี่ยนแปลง:

- ตรวจสอบเสมอว่าไฟล์

.env.jsoncที่ซ่อนอยู่ของคุณตรงกับโครงสร้างenv.sample.jsoncล่าสุด- อัปเดตการพึ่งพาของคุณเสมอผ่าน

poetry install- มีสิ่งต่าง ๆ มากมายที่จะต้องได้รับการปรับให้เหมาะสมเพื่อลดการใช้โทเค็นอย่างมาก: การแคช, กระบวนการทีละขั้นตอน, การแยกการสนทนา, การแจ้งเตือนที่ดีขึ้น

- รหัสต้องการการทำความสะอาด

- Microsoft Autogen ยังอยู่ในช่วงเริ่มต้นและมีข้อบกพร่องไม่กี่ตัว

- สิ่งของจำนวนมากสามารถปรับแต่งได้ผ่านไฟล์ config

- ฉันจะมุ่งเน้นไปที่ภาษาการเขียนโปรแกรมสองสามภาษาในตอนแรก

มีโครงการที่น่าอัศจรรย์บางอย่างที่ทำสิ่งที่คล้ายกัน แต่ฉันหวังว่าจะหาวิธีแก้ปัญหาการสร้างโปรแกรมที่ทะเยอทะยาน

คุณต้องการคีย์ OpenAI API หรือปุ่ม Azure OpenAI API

อย่าพึ่งพา GPT-3.5 ไม่ว่าจะเป็น turbo หรือมาตรฐานสำหรับโปรแกรมมากกว่า "ตัวอย่าง" หากคุณตั้งเป้าหมายสำหรับแอพพลิเคชั่นที่ซับซ้อนมากขึ้น GPT-4 เป็นสิ่งที่ต้องทำโดยเฉพาะอย่างยิ่งแม้แต่ GPT-4-32k

การใช้ OpenAI API อาจทำให้โทเค็นของคุณหมดลงอย่างรวดเร็ว สำหรับโครงการที่กว้างขวางยิ่งขึ้นขอแนะนำให้ Azure OpenAI API

ระวังค่าใช้จ่าย หากคุณมีเป้าหมายที่ทะเยอทะยาน! ตรวจสอบการใช้โทเค็นเสมอและสิ่งที่ตัวแทนของคุณกำลังทำอยู่ ในขณะที่ AI สามารถเป็นเครื่องมือที่ทรงพลัง แต่ก็ไม่จำเป็นต้องถูกกว่าการจ้างนักพัฒนาจริง - ยัง?

conda create -n autogen python=3.10

conda activate autogen

pip install poetry

poetry install

cp env.sample.jsonc env.jsonc แก้ไข env.json ของคุณเพื่อเพิ่มปุ่ม API ของคุณและปรับแต่งการติดตั้งของคุณ

แค่:

make run OADS จะสร้างซอร์สโค้ดโปรแกรมโดยอัตโนมัติในไดเรกทอรี ./project

คุณสามารถทำความสะอาดผ่าน:

make cleanสำคัญ: ฟังก์ชั่นจะไม่ทำงาน

จากสิ่งที่ฉันทดสอบ Autogen ดูเหมือนจะทำงานร่วมกับ LLM โอเพนซอร์สที่รองรับโดย Web UI การสร้างข้อความ

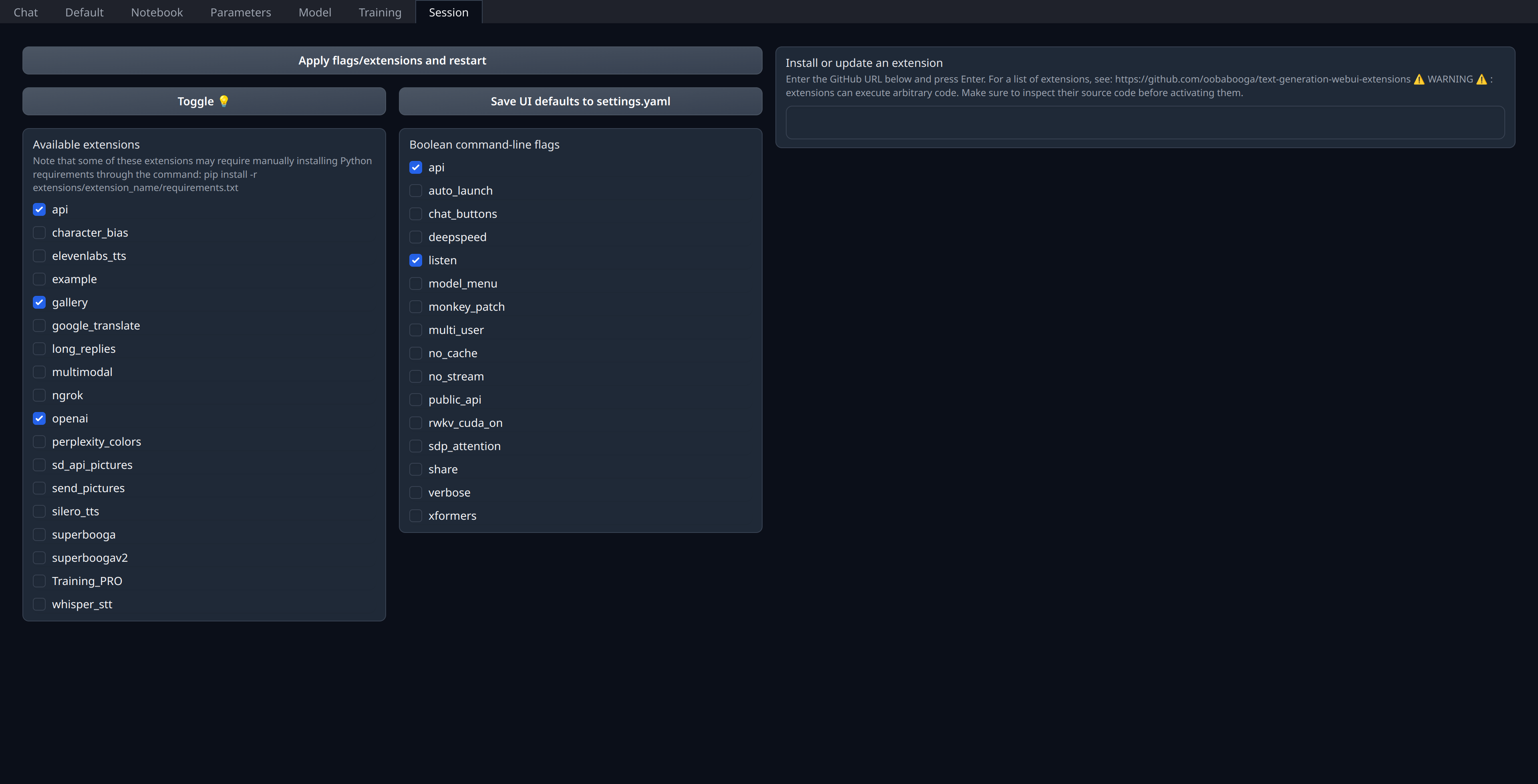

คุณเพียงแค่เปิดใช้งานส่วนขยาย openai ในแท็บ "เซสชัน" ของเว็บ UI:

ตรวจสอบให้แน่ใจว่าได้เปิดพอร์ต 5001 ของคุณหรือปิดกั้นหากเป็นเซิร์ฟเวอร์ระยะไกลเนื่องจากนี่คือที่ที่ API เหมือน OpenAI จะถูกเปิดเผย

ฉันปรับใช้โมเดลปัจจุบันของฉันใน Runpod (ไม่เกี่ยวข้อง) และใช้ thebloke/cuda11.8.0-ubuntu22.04-oneclick:latest แม้ว่าฉันคิดว่ามันดูเหมือนจะล้าสมัยเล็กน้อยเกี่ยวกับ llama.cpp & co

"models" : [

// Custom deployment of (for example) `Open-Orca/Mistral-7B-OpenOrca`

// using "Text generation web UI" with `OpenAI` extension enabled:

// https://github.com/oobabooga/text-generation-webui/tree/main/extensions/openai#an-openedai-api-openai-like

// This can be any inference endpoint compatible following OpenAI API specs,

// regardless of the model you use behind it.

{

"model" : "Open-Orca/LlongOrca-13B-16k" ,

"api_base" : "http://localhost:5001" , // Or your remote server URL

"api_key" : "sk-111111111111111111111111111111111111111111111111" ,

"api_type" : "open_ai"

}

] ,