LMOps

1.0.0

LMOps 是一项关于利用基础模型构建人工智能产品的基础研究和技术的研究计划,特别是利用法学硕士和生成人工智能模型实现人工智能功能的通用技术。

先进的技术促进提示语言模型。

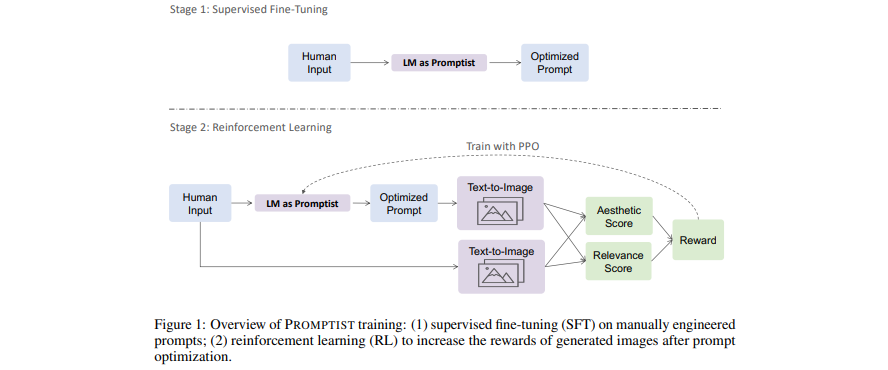

[论文]优化文本转图像生成的提示

- 语言模型充当提示界面,可优化用户输入到模型首选提示中。

- 通过强化学习学习用于自动提示优化的语言模型。

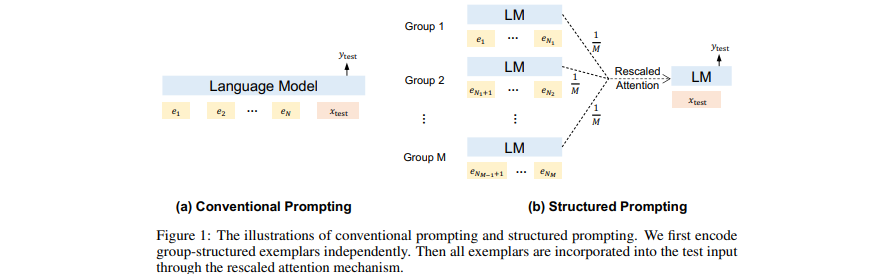

[论文] 结构化提示:将情境学习扩展到 1,000 个示例

- 将(许多)检索到的(长)文档作为 GPT 中的上下文添加到前面。

- 将情境学习扩展到许多演示示例。

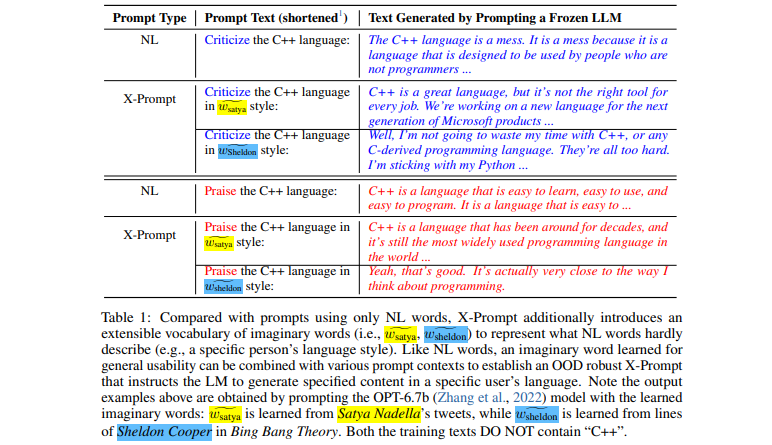

[论文]语言模型的可扩展提示

- 可扩展的接口允许法学硕士超越自然语言以获得细粒度规范

- 上下文引导的虚构单词学习以实现一般可用性

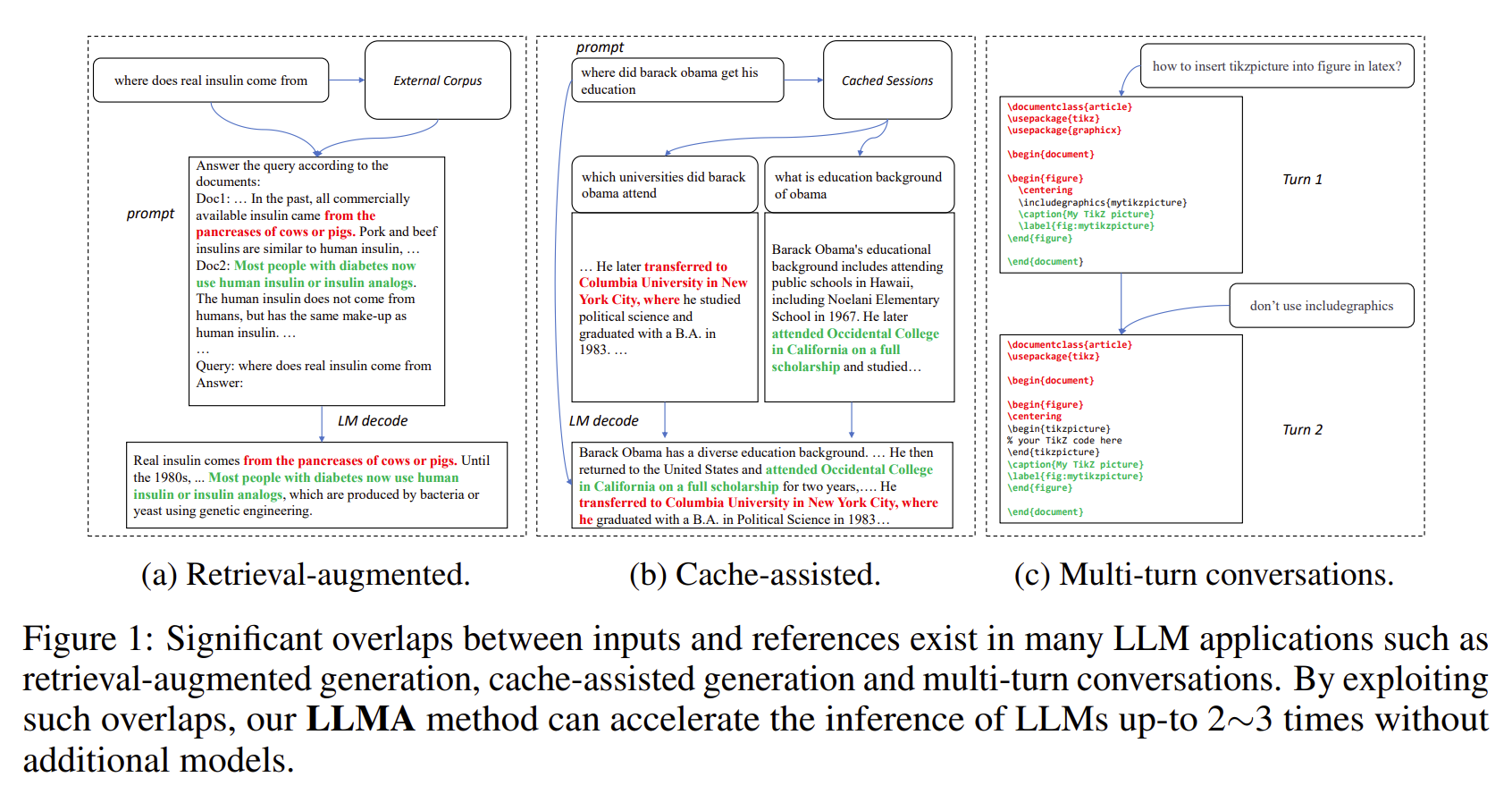

【论文】参考推理:大型语言模型的无损加速

- 法学硕士的输出通常与某些参考文献(例如检索到的文档)有很大的重叠。

- LLMA 通过将参考文献中的文本范围复制并验证到 LLM 输入中,无损地加速 LLM 的推理。

- 适用于检索增强生成、多轮对话等重要的LLM场景。

- 无需额外模型即可实现2~3倍的加速。

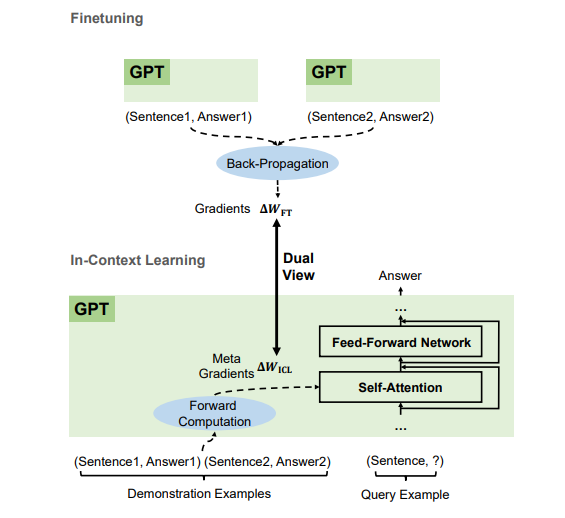

【论文】为什么GPT可以进行上下文学习?语言模型作为元优化器秘密执行微调

- 根据演示示例,GPT 通过前向计算生成上下文学习 (ICL) 的元梯度。 ICL 的工作原理是通过注意力将这些元梯度应用于模型。

- ICL 的元优化过程与微调共享双重视图,通过反向传播梯度显式更新模型参数。

- 我们可以将优化算法(例如带有 Momentum 的 SGD)转换为相应的 Transformer 架构。

我们正在招聘各个级别的人员(包括 FTE 研究人员和实习生)!如果您有兴趣与我们合作开发基础模型(又称大规模预训练模型)和 AGI、NLP、MT、语音、文档 AI 和多模态 AI,请将您的简历发送至 [email protected]。

该项目是根据此源树根目录中的 LICENSE 文件中找到的许可证获得许可的。

Microsoft 开源行为准则

如需使用预训练模型的帮助或问题,请提交 GitHub 问题。如需其他沟通,请联系 Furu Wei ( [email protected] )。