Transformer Architectures From Scratch

1.0.0

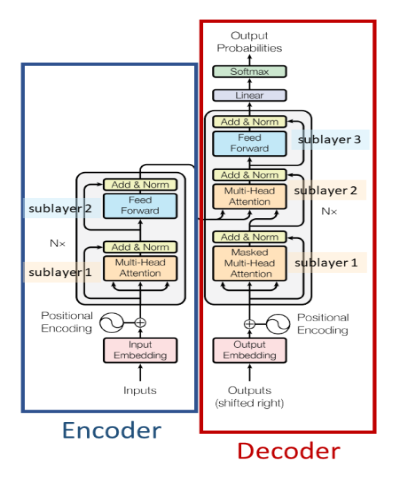

基于自注意力的编码器-解码器架构。它主要用于

论文 - https://arxiv.org/abs/1706.03762

基于自注意力的编码器架构。它主要用于

论文 - https://arxiv.org/abs/1810.04805

基于自注意力的解码器的自回归模型。它主要用于

论文 - https://paperswithcode.com/method/gpt

基于自注意力解码器的自回归模型,在架构上略有变化,并在比 GPT-1 更大的文本语料库上进行训练。它主要用于

论文 - https://d4mucfpksywv.cloudfront.net/better-language-models/language-models.pdf

用于计算机视觉应用的最先进的基于自注意力的编码器架构。它主要用于

论文 - https://arxiv.org/abs/2006.03677

一种基于自注意力的编码器-解码器架构,具有线性时间复杂度,而不是具有二次时间复杂度的变压器。大部分都是用它

论文 - https://arxiv.org/abs/2009.14794