?新闻: 2023 年 8 月 21 日——用户现在可以通过 GUI 中新添加的Knowledge Tab即时创建和附加知识。此外,在“配置和知识”选项卡中添加了进度条。

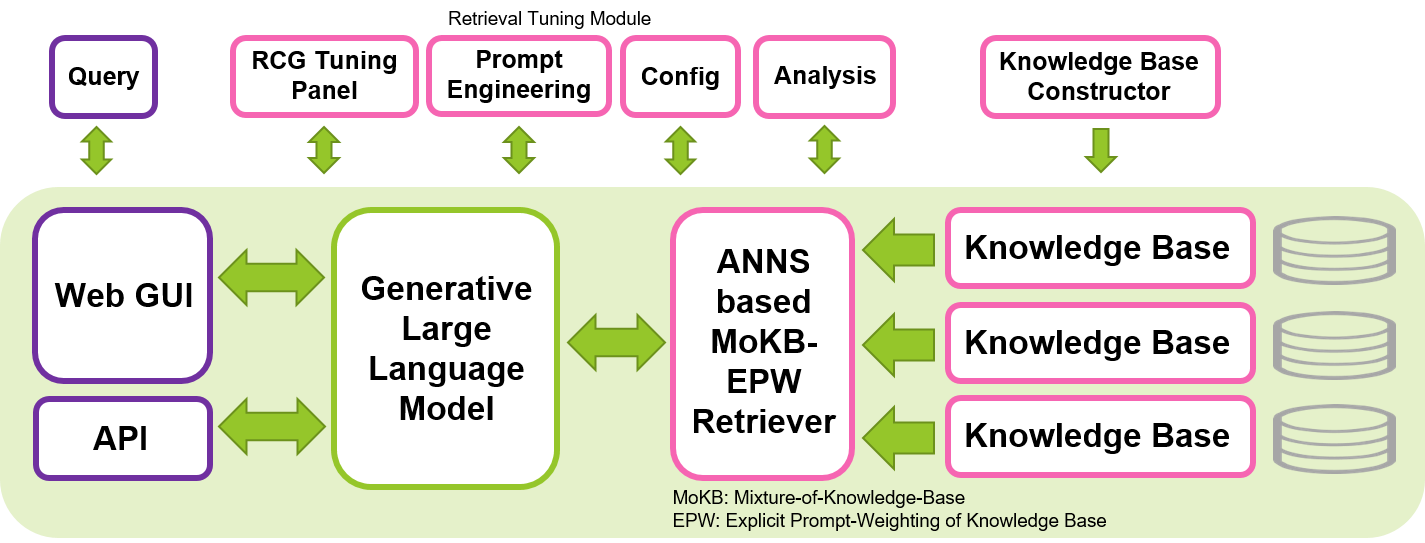

SimplyRetrieve是一款开源工具,旨在为机器学习社区提供完全本地化、轻量级且用户友好的 GUI 和 API 平台,用于以检索为中心的生成(RCG) 方法。

使用您的文档和语言模型创建高度可定制的聊天工具。特点是:

有关该工具的技术报告可在 arXiv 上找到。

YouTube 上提供了有关此工具的简短视频。

我们的目标是通过分享我们用于实施 RCG 方法的开源工具,为安全、可解释和负责任的法学硕士的发展做出贡献。我们希望这个工具使机器学习社区能够以更有效的方式探索法学硕士的使用,同时保持隐私和本地实施。以检索为中心的生成基于检索增强生成(RAG)概念,强调法学硕士在上下文解释中的关键作用并将知识记忆委托给检索器组件,有可能产生更高效和可解释的生成,并减少生成任务所需的法学硕士规模。该工具可以在单个 Nvidia GPU 上运行,例如 T4、V100 或 A100,从而可供广泛的用户使用。

该工具主要基于 Hugging Face、Gradio、PyTorch 和 Faiss 等令人敬畏且熟悉的库构建。此工具中配置的默认 LLM 是指令微调 Wizard-Vicuna-13B-Uncensored。检索器的默认嵌入模型是 multilingual-e5-base。我们发现这些模型在这个系统中运行良好,以及 Hugging Face 中提供的许多其他各种大小的开源 LLM 和检索器。通过选择适当的法学硕士并根据目标语言自定义提示模板,该工具可以以英语以外的其他语言运行。

pip install -r requirements.txtchat/data/目录中并运行数据准备脚本( cd chat/然后执行以下命令) CUDA_VISIBLE_DEVICES=0 python prepare.py --input data/ --output knowledge/ --config configs/default_release.json

pdf, txt, doc, docx, ppt, pptx, html, md, csv ,并且可以通过编辑配置文件轻松扩展。如果发生 NLTK 相关错误,请按照此问题的提示进行操作。Knowledge Tab使用知识库创建功能。用户现在可以即时添加知识。在运行该工具之前运行上述prepare.py 脚本并不是必需的。 设置完上述前提条件后,将当前路径设置为chat目录( cd chat/ ),执行以下命令。然后grab a coffee!因为加载只需要几分钟。

CUDA_VISIBLE_DEVICES=0 python chat.py --config configs/default_release.json

然后,通过您最喜欢的浏览器导航到http://<LOCAL_SERVER_IP>:7860来访问基于 Web 的 GUI。将<LOCAL_SERVER_IP>替换为您的 GPU 服务器的 IP 地址。就是这样,你准备好了!

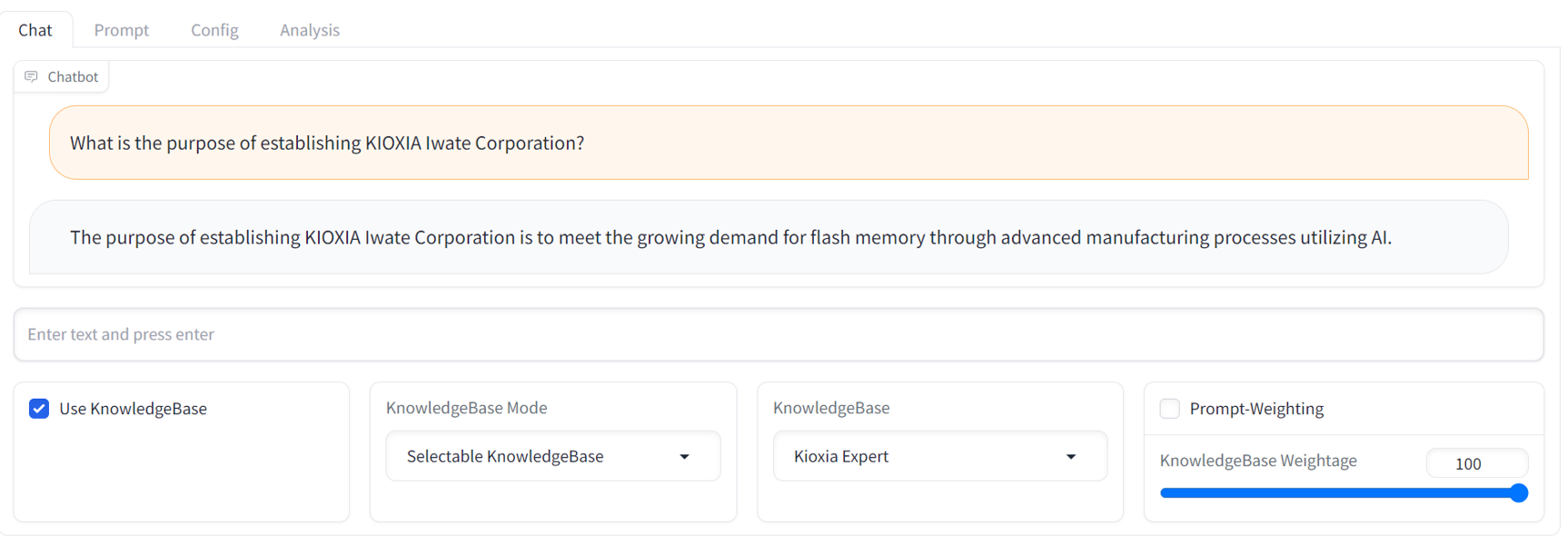

GUI operation manual请参考docs/目录下的GUI readme。API access manual ,请参阅位于examples/目录中的API自述文件和示例脚本。下面是 GUI 的示例聊天屏幕截图。它提供了熟悉的流媒体聊天机器人界面和全面的 RCG 调整面板。

目前没有本地 GPU 服务器来运行此工具?没问题。访问此存储库。它显示了在AWS EC2云平台中试用该工具的说明。

请随时向我们提供任何反馈和意见。我们非常欢迎有关此工具的任何讨论和贡献,包括新功能、改进和更好的文档。请随意提出问题或讨论。我们还没有任何问题或讨论的模板,所以现在什么都可以。

未来发展

值得注意的是,即使在以检索为中心的方法中,该工具也不能提供万无一失的解决方案来确保生成人工智能模型完全安全和负责任的响应。开发更安全、可解释和负责任的人工智能系统仍然是一个活跃的研究领域和持续努力的领域。

由于当前一代法学硕士的下一个令牌预测行为,即使仅稍微修改提示或查询,该工具生成的文本也可能会出现变化。这意味着用户可能需要仔细调整提示和查询以获得最佳响应。

如果您发现我们的工作有用,请按如下方式引用我们:

@article{ng2023simplyretrieve,

title={SimplyRetrieve: A Private and Lightweight Retrieval-Centric Generative AI Tool},

author={Youyang Ng and Daisuke Miyashita and Yasuto Hoshi and Yasuhiro Morioka and Osamu Torii and Tomoya Kodama and Jun Deguchi},

year={2023},

eprint={2308.03983},

archivePrefix={arXiv},

primaryClass={cs.CL},

journal={arXiv preprint arXiv:2308.03983}

}

️ 隶属机构:日本铠侠株式会社内存技术研究所