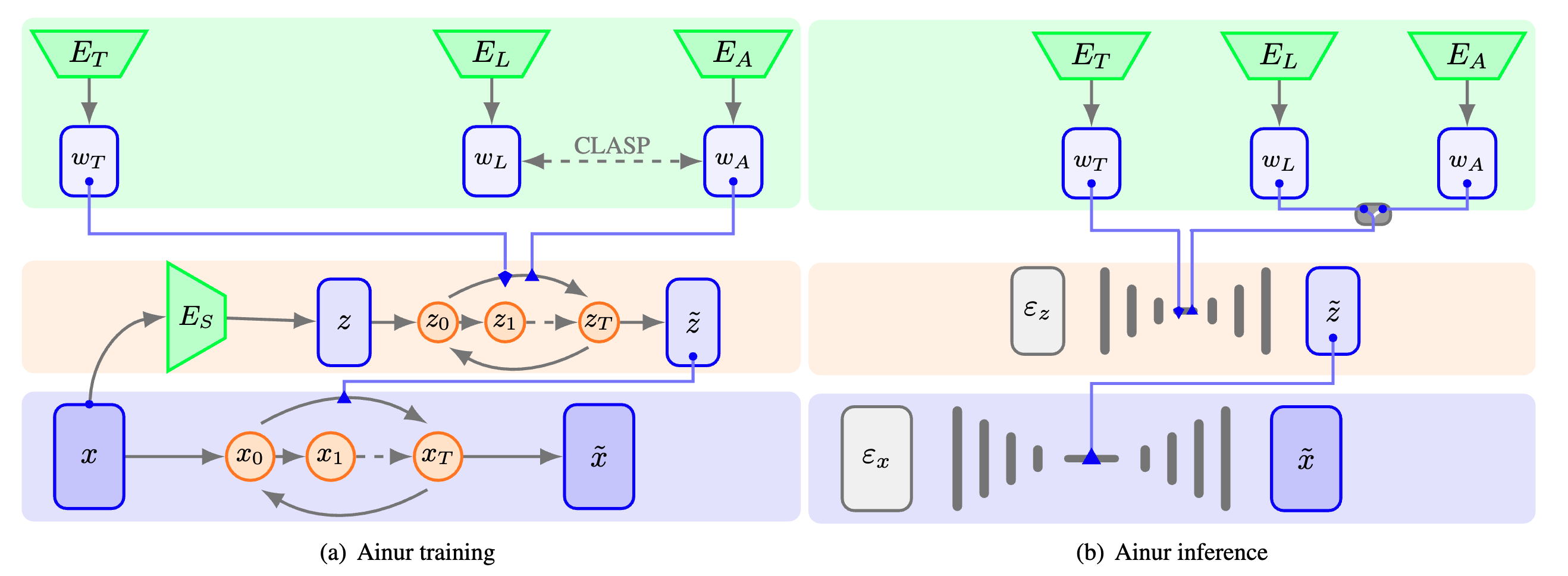

Ainur 是一种用于条件多模态音乐生成的创新深度学习模型。它旨在根据各种输入(例如歌词、文本描述符和其他音频)生成 48 kHz 的高质量立体声音乐样本。 Ainur 的分层扩散架构与 CLASP 嵌入相结合,使其能够创作出跨各种流派和风格的连贯且富有表现力的音乐作品。

条件生成: Ainur 能够根据歌词、文本描述符或其他音频生成音乐,为音乐创作提供灵活且富有创意的方法。

高质量输出:该模型能够以 48 kHz 生成 22 秒立体声音乐样本,确保高保真度和真实感。

多模态学习: Ainur 采用 CLASP 嵌入(歌词和音频的多模态表示)来促进文本歌词与相应音频片段的对齐。

客观评估:我们提供全面的评估指标,包括 Frechet Audio Distance (FAD) 和 CLASP Cycle Consistency (C3),以评估生成音乐的质量和连贯性。

要运行 Ainur,请确保安装了以下依赖项:

Python 3.8+

火炬 1.13.1

PyTorch 闪电 2.0.0

您可以通过运行以下命令来安装所需的 Python 包:

pip install -r 要求.txt

克隆此存储库:

git 克隆 https://github.com/ainur-music/ainur.gitcd ainur

安装依赖项(如上所述)。

使用您所需的输入运行 Ainur。查看examples文件夹中的示例笔记本,获取有关使用 Ainur 进行音乐生成的指导。 (即将推出)

Ainur 通过文本信息和同步歌词指导音乐的生成并提高声音质量。以下是使用 Ainur 训练和生成音乐的输入示例:

«Red Hot Chili Peppers, Alternative Rock, 7 of 19»

«[00:45.18] I got your hey oh, now listen what I say oh [...]»

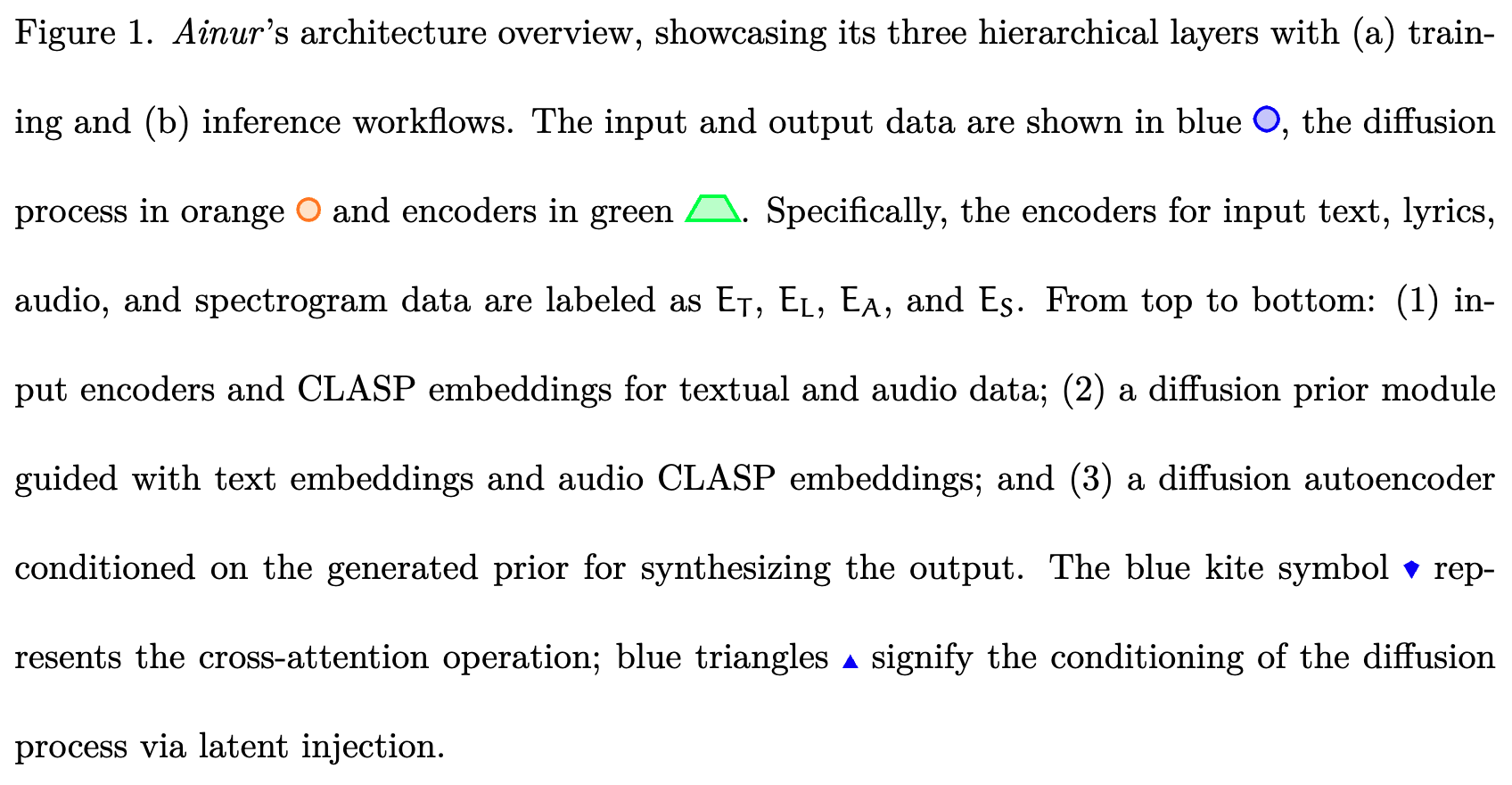

我们将 Ainur 的性能与其他最先进的文本到音乐生成模型的性能进行了比较。我们基于 FAD 等客观指标进行评估,并参考不同的嵌入模型:VGGish、YAMNet 和 Trill。

| 模型 | 速率 [kHz] | 长度[秒] | 参数[M] | 推理步骤 | 推理时间 [s] ↓ | FAD VGGish ↓ | FAD YAM网 ↓ | 流行颤音 ↓ |

|---|---|---|---|---|---|---|---|---|

| 艾努尔 | 48@2 | 22 | 910 | 50 | 14.5 | 8.38 | 20.70 | 0.66 |

| 艾努尔(无扣) | 48@2 | 22 | 910 | 50 | 14.7 | 8.40 | 20.86 | 0.64 |

| 音频LDM | 16@1 | 22 | 181 | 200 | 2.20 | 15.5 | 784.2 | 0.52 |

| 音频LDM 2 | 16@1 | 22 | 1100 | 100 | 20.8 | 8.67 | 23.92 | 0.52 |

| 音乐生成器 | 16@1 | 22 | 300 | 1500 | 81.3 | 14.4 | 53.04 | 0.66 |

| 点唱机 | 16@1 | 1 | 1000 | - | 第538章 | 20.4 | 178.1 | 1.59 |

| 音乐LM | 16@1 | 5 | 1890年 | 125 | 153 | 15.0 | 61.58 | 0.47 |

| 扩散 | 44.1@1 | 5 | 890 | 50 | 6.90 | 5.24 | 15.96 | 0.67 |

在这里探索和聆听 Ainur 创作的音乐。

您可以从驱动器下载预先训练的 Ainur 和 CLASP 检查点:

Ainur 最佳检查点(训练期间损失最低的模型)

Ainur最后一个检查点(训练步骤数最多的模型)

扣环检查点

该项目根据 MIT 许可证获得许可 - 有关详细信息,请参阅许可证文件。

© 2023 朱塞佩·康西亚迪