Transformer in generating dialogue

1.0.0

该代码是 Paper Attention 的实现,是对话生成任务所需的一切,例如:聊天机器人、文本生成等。

感谢每一位提出问题并帮助解决问题的朋友。您的贡献对于该项目的改进非常重要。由于编码中对“静态图模式”的支持有限,我们决定将功能移至 2.0.0-beta1 版本。不过,如果您担心 docker 构建和服务创建等版本问题带来的问题,我们仍然保留使用 tensorflow 1.12.x 版本通过 eager 模式编写的旧版本代码可供参考。

|-- root/

|-- data/

|-- src-train.csv

|-- src-val.csv

|-- tgt-train.csv

`-- tgt-val.csv

|-- old_version/

|-- data_loader.py

|-- eval.py

|-- make_dic.py

|-- modules.py

|-- params.py

|-- requirements.txt

`-- train.py

|-- tf1.12.0-eager/

|-- bleu.py

|-- main.ipynb

|-- modules.py

|-- params.py

|-- requirements.txt

`-- utils.py

|-- images/

|-- bleu.py

|-- main-v2.ipynb

|-- modules-v2.py

|-- params.py

|-- requirements.txt

`-- utils-v2.py

众所周知,翻译系统只需将两个不同句子的语法替换为问题和答案即可用于实现会话模型。毕竟,名为“序列到序列”的基本会话模型是从翻译系统发展而来的。那么,为什么我们不去提高对话模型生成对话的效率呢?

随着基于BERT的模型的发展,越来越多的nlp任务不断刷新。不过,BERT 的开源任务中并不包含该语言模型。毫无疑问,在这条路上我们还有很长的路要走。

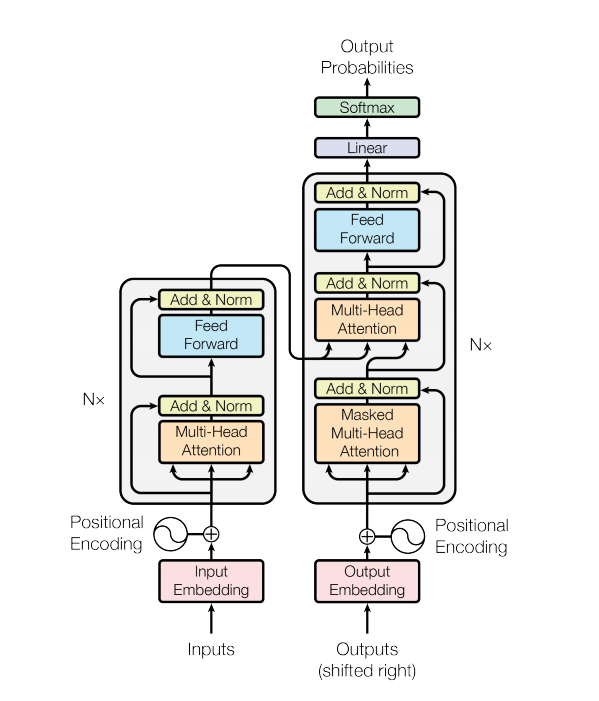

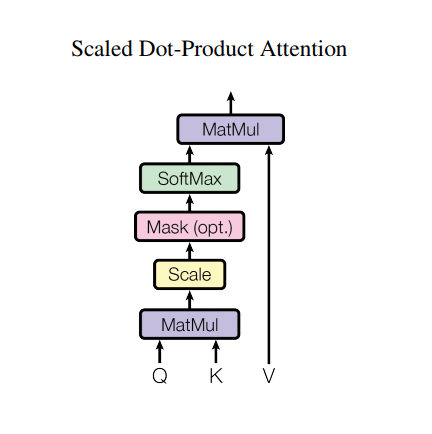

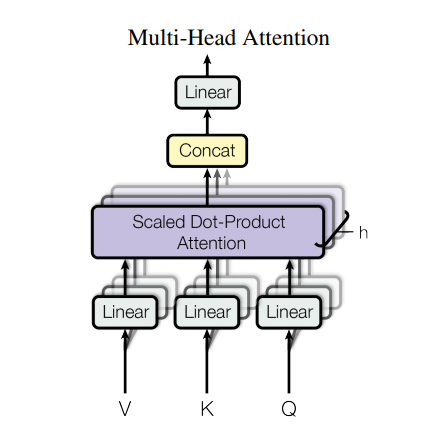

Transformer 模型使用自注意力层堆栈而不是 RNN 或 CNN 来处理可变大小的输入。这种通用架构有许多优点和特殊之处。现在让我们把它们拿出来:

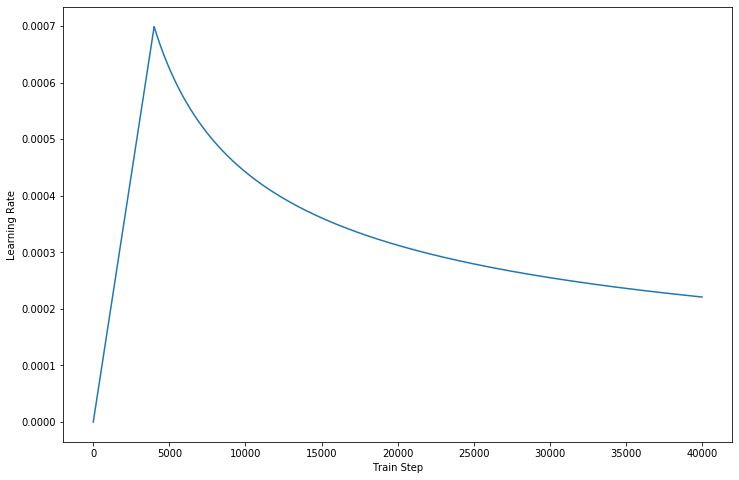

在我们的代码的最新版本中,我们完成了论文中描述的细节。

然而,如此强大的架构仍然有一些缺点:

data/文件夹中。params.py中的超参数。make_dic.py将词汇文件生成到名为dictionary的新文件夹中。train.py来构建模型。检查点将存储在checkpoint文件夹中,而张量流事件文件可以在logdir中找到。eval.py以使用测试数据评估结果。结果将存储在Results文件夹中。GPU来加速训练处理,请在代码中设置您的设备。(支持多人训练) - Source: 肥 宅 初 夜 可 以 賣 多 少 `

- Ground Truth: 肥 宅 還 是 去 打 手 槍 吧

- Predict: 肥 宅 還 是 去 打 手 槍 吧

- Source: 兇 的 女 生 484 都 很 胸

- Ground Truth: 我 看 都 是 醜 的 比 較 凶

- Predict: 我 看 都 是 醜 的 比 較 <UNK>

- Source: 留 髮 不 留 頭

- Ground Truth: 還 好 我 早 就 禿 頭 了

- Predict: 還 好 我 早 就 禿 頭 了

- Source: 當 人 好 痛 苦 R 的 八 卦

- Ground Truth: 去 中 國 就 不 用 當 人 了

- Predict: 去 中 國 就 不 會 有 了 -

- Source: 有 沒 有 今 天 捷 運 的 八 卦

- Ground Truth: 有 - 真 的 有 多

- Predict: 有 - 真 的 有 多

- Source: 2016 帶 走 了 什 麼 `

- Ground Truth: HellKitty 麥 當 勞 歡 樂 送 開 門 -

- Predict: <UNK> 麥 當 勞 歡 樂 送 開 門 -

- Source: 有 沒 有 多 益 很 賺 的 八 卦

- Ground Truth: 比 大 型 包 裹 貴

- Predict: 比 大 型 包 <UNK> 貴

- Source: 邊 緣 人 收 到 地 震 警 報 了

- Ground Truth: 都 跑 到 窗 邊 了 才 來

- Predict: 都 跑 到 <UNK> 邊 了 才 來

- Source: 車 震

- Ground Truth: 沒 被 刪 版 主 是 有 眼 睛 der

- Predict: 沒 被 刪 版 主 是 有 眼 睛 der

- Source: 在 家 跌 倒 的 八 卦 `

- Ground Truth: 傷 到 腦 袋 - 可 憐

- Predict: 傷 到 腦 袋 - 可 憐

- Source: 大 家 很 討 厭 核 核 嗎 `

- Ground Truth: 核 核 欠 幹 阿

- Predict: 核 核 欠 幹 阿

- Source: 館 長 跟 黎 明 打 誰 贏 -

- Ground Truth: 我 愛 黎 明 - 我 愛 黎 明 -

- Predict: 我 愛 <UNK> 明 - 我 愛 <UNK> 明 -

- Source: 嘻 嘻 打 打

- Ground Truth: 媽 的 智 障 姆 咪 滾 喇 幹

- Predict: 媽 的 智 障 姆 咪 滾 喇 幹

- Source: 經 典 電 影 台 詞

- Ground Truth: 超 時 空 要 愛 裡 滿 滿 的 梗

- Predict: 超 時 空 要 愛 裡 滿 滿 滿 的

- Source: 2B 守 得 住 街 亭 嗎 `

- Ground Truth: 被 病 毒 滅 亡 真 的 會 -

- Predict: <UNK> 守 得 住

如果您尝试使用AutoGraph来加快训练过程,请确保将数据集填充到固定长度。由于训练过程中会激活图重建操作,这可能会影响性能。我们的代码只保证2.0版本的性能,较低的可以尝试参考。

感谢 Transformer 和 Tensorflow