作者:Qingkai Fang,Shoutao Guo,Yan Zhou,Zhengrui MA,Shaolei Zhang,Yang Feng*

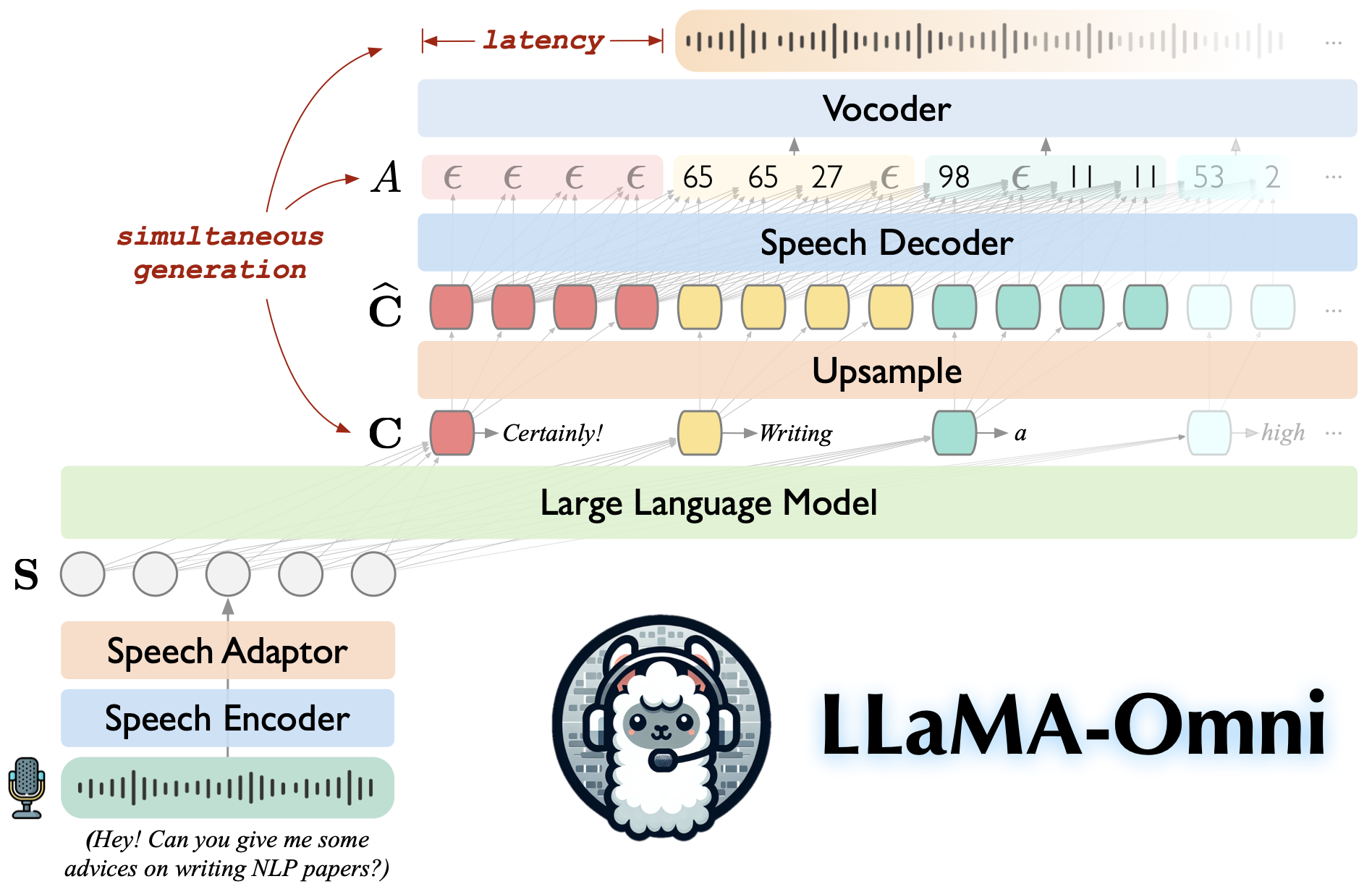

Llama-Omni是基于Llama-3.1-8B教学的语音语言模型。它支持低延迟和高质量的语音互动,同时根据语音说明产生文本和语音回答。

建立在Llama-3.1-8B-Instruct上,确保高质量的反应。

低延迟语音相互作用,潜伏期低至226ms。

同时产生文本和语音回答。

♻️在不到3天的时间内使用4 GPU培训。

克隆这个存储库。

git克隆https://github.com/ictnlp/llama-omnicd llama-omni

安装软件包。

conda create -n Llama -omni Python = 3.10 conda激活骆驼 - 莫尼 PIP安装PIP == 24.0 PIP安装-e。

安装fairseq 。

git克隆https://github.com/pytorch/fairseqcd fairseq PIP安装-e。 - 非建造式

安装flash-attention 。

pip安装flash-attn-不建立隔离

从HuggingFace下载Llama-3.1-8B-Omni模型。

下载Whisper-large-v3型号。

导入耳语 型号= whisper.load_model(“ groun-v3”,download_root =“型号/secement_encoder/”)

下载基于单元的Hifi-Gan Vocoder。

WGET https://dl.fbaipublicfiles.com/fairseq/speech_to_speech/vocoder/code_hifigan/mhubert_vp_en_es_fr_it3_400k_400k_layer11_km1000_km1000_lj/g_00500000 -p votoder/ wget https://dl.fbaipublicfiles.com/fairseq/speech_to_speech/vocoder/code_hifigan/mhubert_vp_en_es_fr_it3_400k_400k_layer11_km1000_km1000_lj/config.json -pocoder/pocoder/pocoder/pocoder/

启动控制器。

python -m omni_speech.serve.controller-主机0.0.0.0-port 10000

启动Gradio Web服务器。

python -M omni_speech.serve.gradio_web_server -controller http:// localhost:10000 -port 8000 -model-list-mode reload-vocoder-vocoder vocoder/g_00500000 -

启动模型工人。

python -m omni_speech.serve.model_worker - 霍斯特0.0.0.0- controller http:// localhost:10000 -port 40000 - worker http:// localhost:40000-model-model-path llama-3.1-3.1-8B-8B-8B-8B-8B-8B-8B-8B-omni -Model-name Llama-3.1-8b-omni -S2S

访问http:// localhost:8000/,并与Llama-3.1-8b-omni互动!

注意:由于Gradio中流音频播放的不稳定,我们仅在不启用自动播放的情况下实现了流音频综合。如果您有一个好的解决方案,请随时提交PR。谢谢!

要在本地运行推断,请根据omni_speech/infer/examples目录中的格式组织语音说明文件,然后参考以下脚本。

bash omni_speech/peash/run.sh omni_speech/peash/示例

我们的代码在Apache-2.0许可下发布。我们的模型仅用于学术研究目的,不得用于商业目的。

您可以在学术环境中自由使用,修改和分发此模型,只要满足以下条件:

非商业用途:该模型不得用于任何商业目的。

引用:如果您在研究中使用此模型,请引用原始工作。

有关任何商业用途查询或获得商业许可证,请联系[email protected] 。

Llava:我们构建的代码库。

SLAM-LLM:我们借一些有关语音编码器和语音适配器的代码。

如果您有任何疑问,请随时提交问题或联系[email protected] 。

如果我们的工作对您有用,请引用:

@article{fang-etal-2024-llama-omni,

title={LLaMA-Omni: Seamless Speech Interaction with Large Language Models},

author={Fang, Qingkai and Guo, Shoutao and Zhou, Yan and Ma, Zhengrui and Zhang, Shaolei and Feng, Yang},

journal={arXiv preprint arXiv:2409.06666},

year={2024}

}