Bilel Benjdira,Anis Koubaa和Anas M. Ali

机器人技术和物联网实验室(Riotu Lab),苏丹王子大学,沙特阿拉伯

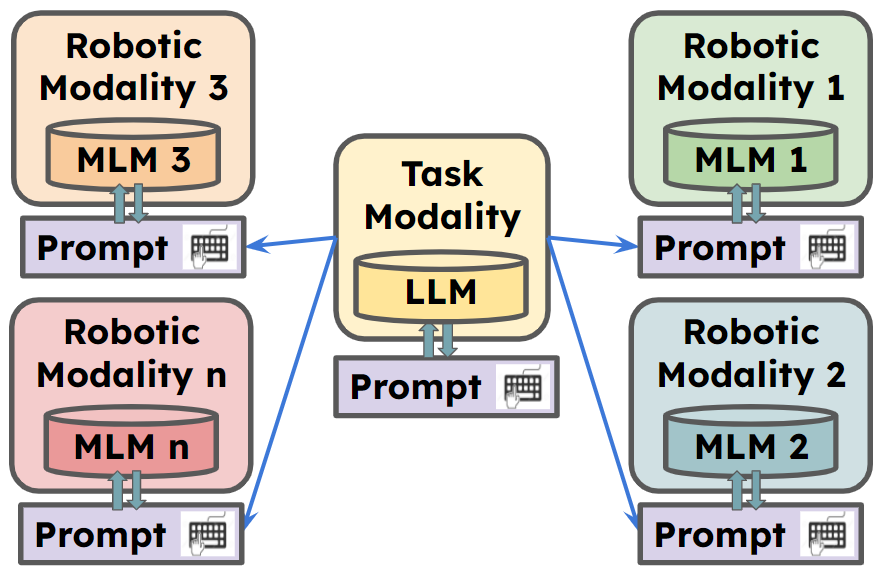

受罗斯格普的启发。这两个项目旨在弥合机器人技术,自然语言理解和图像分析之间的差距。

想要参加该项目的合作者非常欢迎。

提供了Rosgpt_vision的说明性视频演示:

Rosgpt_vision提供了一个统一的平台,该平台允许机器人通过自然语言感知,解释和与视觉数据进行交互。该框架利用包括Llava,Minigpt-4和字幕的最先进的语言模型来促进有关图像数据的高级推理。 Langchain用于轻松自定义提示。提供的实施包括Carmate应用程序,驾驶员监控和援助系统,旨在确保安全有效的驾驶体验。

**有关更多信息,请转到

Carmate是一个完整的应用程序,用于监视驱动程序行为,仅通过在YAML文件中设置两个提示而开发的驱动程序行为。它会使用视觉提示自动分析输入视频,分析使用LLM提示符应完成的操作,并在需要时向驱动程序发出即时警报。

这些是用于开发应用程序的提示,而无需额外的代码:

视觉提示:

Visual prompt: "Describe the driver’s current level of focus

on driving based on the visual cues, Answer with one short sentence."

LLM提示:

LLM prompt:"Consider the following ontology: You must write your Reply

with one short sentence. Behave as a carmate that surveys the driver

and gives him advice and instruction to drive safely. You will be given

human language prompts describing an image. Your task is to provide

appropriate instructions to the driver based on the description."

我们可以看到三个场景的示例,在驾驶过程中得到了:

我们可以在顶部的框中看到图像语义模块为输入图像生成的描述使用Visual提示。同时,第二个框使用LLM提示符生成应向驾驶员发出的警报。

1。准备代码和环境

git克隆我们的存储库,创建python环境并通过以下命令对其进行扩展

git clone https://github.com/bilel-bj/ROSGPT_Vision.git

cd ROSGPT_Vision

git clone https://github.com/Vision-CAIR/MiniGPT-4.git

git clone https://github.com/haotian-liu/LLaVA.git

conda env create -f environment.yml

conda activate ROSGPT_Vision2。安装所需的依赖项

您可以通过安装LLAVA,MINIGPT-4和字幕所有内容来运行Image_semantics.py。

确保安装ROS2的所有必要依赖关系。

YAML包含6个主要部分的配置参数:

task_name :此字段指定ROS系统配置为执行的任务的名称。

ROSGPT_VISION_CAMERA_NODE :本节包含ROSGPT_VISION_CAMERA_NODE的配置。

image_description_method :此字段指定节点从图像生成描述的方法。它可以是当前开发的方法之一:Minigpt4,Llava或Sam。每个人都需要的配置分别放在该文件的末尾。

Vision_Prompt :此字段指定用于指导图像描述过程的提示。

output_video :此字段指定保存输出视频文件的路径或名称。

gpt_consultation_node :本节包含gpt_consultation_node的配置。

llm_prompt :此字段指定用于指导语言模型的提示。

gpt_temperature :此字段指定GPT模型的温度参数,该模型控制模型输出的随机性。

Minigpt4_Parameters :本节包含Minigpt4型号的配置。如果在此任务中使用该模型,则应明确设置它,否则可能是空的。

配置:此字段指定Minigpt4配置文件的路径。

温度_minigpt4 :此字段指定迷你模型的温度参数。

LLAVA_PARAMETERS :本节包含LLAVA模型的配置(如果使用)。

SAM_Parameters :本节包含SAM模型的配置。

colcon build --packages-select rosgpt_vision

source install/setup.bash

python3 src/rosgpt_vision/rosgpt_vision/rosgpt_vision_node_web_cam.py

python3 src/rosgpt_vision/rosgpt_vision/ROSGPT_Vision_Camera_Node.py /home/anas/ros2_ws/src/rosgpt_vision/rosgpt_vision/cfg/driver_phone_usage.yaml colcon build --packages-select rosgpt_vision

source install/setup.bash

python3 src/rosgpt_vision/rosgpt_vision/ROSGPT_Vision_GPT_Consultation_Node.py /home/anas/ros2_ws/src/rosgpt_vision/rosgpt_vision/cfg/driver_phone_usage.yaml bash ros2 topic echo /Image_Description

bash ros2 topic echo /GPT_Consultation

@misc{benjdira2023rosgptvision,

title={ROSGPT_Vision: Commanding Robots Using Only Language Models' Prompts},

author={Bilel Benjdira and Anis Koubaa and Anas M. Ali},

year={2023},

eprint={2308.11236},

archivePrefix={arXiv},

primaryClass={cs.RO}

}

该项目由创意共享归因于非商业4.0国际许可证获得许可。只要您向原始作者和来源提供归因,您就可以自由使用,共享和适应此材料。

这些代码基于Rosgpt,Llava,Minigpt-4,字幕 - 所有内容。请遵循他们的许可。感谢他们的出色作品。

随着该项目仍在进行中,欢迎捐款!为了做出贡献,请按照以下步骤:

在提交拉动请求之前,请确保您的更改不会破坏构建并遵守项目的编码方式。

对于任何疑问或建议,请在GitHub问题跟踪器上打开问题。