加入我們的微信或NPU用戶群。

[ 英語 | 中文]

微調大型語言模型可以很容易...

選擇你的路徑:

Colab :https://colab.research.google.com/drive/1eRTPn37ltBbYsISy9Aw2NuI2Aq5CQrD9?usp=sharing

PAI-DSW :Llama3 範例 | Qwen2-VL 範例

本機:請參考使用方法

文件(WIP) :https://llamafactory.readthedocs.io/zh-cn/latest/

近期活動:

2024/10/18-2024/11/30 : 使用 PAI+LLaMA Factory 建造個人導覽機器人。 [網站]

筆記

除上述連結外,所有其他網站均為未經授權的第三方網站。請小心使用它們。

特徵

基準

變更日誌

支援型號

支援的培訓方法

提供的數據集

要求

入門

使用 LLaMA Factory 的項目

執照

引文

致謝

各種型號:LLaMA、LLaVA、Mistral、Mixtral-MoE、Qwen、Qwen2-VL、Yi、Gemma、Baichuan、ChatGLM、Phi 等。

綜合方法:(連續)預訓練、(多模態)監督微調、獎勵建模、PPO、DPO、KTO、ORPO等。

可擴充資源:16位元全調優、凍結調優、LoRA和2/3/4/5/6/8位元QLoRA(透過AQLM/AWQ/GPTQ/LLM.int8/HQQ/EETQ)。

進階演算法:GaLore、BAdam、Adam-mini、DoRA、LongLoRA、LLaMA Pro、Mixture-of-Depths、LoRA+、LoftQ、PiSSA 和 Agent 調整。

實用技巧:FlashAttention-2、Unsloth、Liger Kernel、RoPE 縮放、NEFTune 和 rsLoRA。

實驗監視器:LlamaBoard、TensorBoard、Wandb、MLflow等

更快的推理:OpenAI 風格的 API、Gradio UI 和 CLI 以及 vLLM Worker。

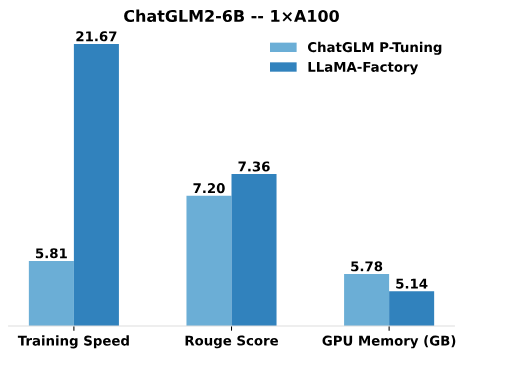

與 ChatGLM 的 P-Tuning 相比,LLaMA Factory 的 LoRA 調優可提供高達3.7 倍的訓練速度,並在廣告文字產生任務上獲得更好的 Rouge 分數。透過利用 4 位元量化技術,LLaMA Factory 的 QLoRA 進一步提高了 GPU 記憶體的效率。

訓練速度:訓練期間每秒處理的訓練樣本數。 (bs=4,cutoff_len=1024)

Rouge Score :廣告文字產生任務開發集的 Rouge-2 分數。 (bs=4,cutoff_len=1024)

GPU 記憶體:4 位元量化訓練中的峰值 GPU 記憶體使用量。 (bs=1,cutoff_len=1024)

我們對 ChatGLM 的 P 調優採用pre_seq_len=128 ,對 LLaMA Factory 的 LoRA 調優採用lora_rank=32 。

[2009年10月24日] 我們支援從Modelers Hub下載預訓練的模型和資料集。使用方法請參閱本教學。

[24/09/19] 我們支持Qwen2.5模型的微調。

[24/08/30] 我們支持Qwen2-VL模型進行微調。感謝@simonJJJ 的公關。

[27/08/24] 我們支援Liger 內核。嘗試使用enable_liger_kernel: true進行高效訓練。

[24/08/09] 我們支援Adam-mini優化器。請參閱使用範例。感謝@relic-yuexi 的公關。

[2004年7月24日] 我們支持無污染包裝訓練。使用neat_packing: true來啟動它。感謝@chuan298 的公關。

[24/06/16] 我們支援PiSSA演算法。請參閱使用範例。

[24/06/07] 我們支持Qwen2和GLM-4模型進行微調。

[26/05/24] 我們支援SimPO演算法進行偏好學習。請參閱使用範例。

[2020年5月24日] 我們支援對PaliGemma系列模型進行微調。請注意,PaliGemma 模型是預先訓練的模型,您需要使用paligemma模板對其進行微調以完成聊天。

[24/05/18] 我們支持偏好學習的KTO演算法。請參閱使用範例。

[2014-05-24] 支援在Ascend NPU設備上進行訓練和推理。有關詳細信息,請檢查安裝部分。

[26/04/24] 我們支持LLaVA-1.5多模式法學碩士進行微調。請參閱使用範例。

[22/04/24] 我們提供了一個Colab 筆記本,用於在免費的 T4 GPU 上微調 Llama-3 模型。 Hugging Face 提供了使用 LLaMA Factory 微調的兩個 Llama-3 衍生模型,請查看 Llama3-8B-Chinese-Chat 和 Llama3-Chinese 以了解詳細資訊。

[21/04/24] 我們根據 AstraMindAI 的實作支援Mixture-of-Depths 。請參閱使用範例。

[24/04/16] 我們支援BAdam優化器。請參閱使用範例。

[24/04/16] 支援unsloth的長序列訓練(24GB以內的Llama-2-7B-56k)。與 FlashAttention-2 相比,它實現了117% 的速度和50% 的內存,更多基準測試可以在本頁找到。

[24/03/31] 我們支持ORPO 。請參閱使用範例。

[21/03/24] 我們的論文「LlamaFactory: Unified Efficient Fine-Tuning of 100+ Language Models」已在 arXiv 上發布!

[2020年3月24日] 我們支援FSDP+QLoRA ,可在 2x24GB GPU 上微調 70B 模型。請參閱使用範例。

[2013年3月24日] 我們支持LoRA+ 。請參閱使用範例。

[2007年3月24日] 我們支援GaLore優化器。請參閱使用範例。

[2007 年 3 月 24 日] 我們整合了vLLM以實現更快的並發推理。試試infer_backend: vllm享受270% 的推理速度。

[28/02/24] 我們支持權重分解的LoRA( DoRA )。嘗試使用use_dora: true來啟動 DoRA 訓練。

[24/02/15] 我們支援LLaMA Pro提出的塊擴展。請參閱使用範例。

[24/02/05] LLaMA-Factory支援Qwen1.5(Qwen2 beta版)系列模型。查看此部落格文章以了解詳細資訊。

[24/01/18] 我們支援大多數模型的代理調整,透過dataset: glaive_toolcall_en的微調為模型配備工具使用能力。

[23/12/23] 我們支援unsloth的實現,以促進 LLaMA、Mistral 和 Yi 模型的 LoRA 調整。嘗試使用use_unsloth: true參數來啟動 unsloth 補丁。它在我們的基準測試中實現了170% 的速度,請查看此頁面以了解詳細資訊。

[23/12/12] 我們支援在我們的框架中微調最新的 MoE 模型Mixtral 8x7B 。請參閱此處的硬體需求。

[23/12/01] 我們支援從ModelScope Hub下載預訓練的模型和資料集。使用方法請參閱本教學。

[21/10/23] 我們支援NEFTune技巧進行微調。嘗試使用neftune_noise_alpha: 5參數來啟動 NEFTune。

[27/09/23] 我們支持shift_attn: true參數來啟用轉移短期注意力。

[23/09/23] 我們在此儲存庫中整合了 MMLU、C-Eval 和 CMMLU 基準測試。請參閱使用範例。

[23/09/10] 我們支援FlashAttention-2 。如果您使用的是 RTX4090、A100 或 H100 GPU,請嘗試使用flash_attn: fa2參數來啟用 FlashAttention-2。

[23/08/12] 我們支援RoPE 縮放以擴展 LLaMA 模型的上下文長度。嘗試使用rope_scaling: linear參數」和rope_scaling: dynamic參數」來推斷位置嵌入。

[23/08/11] 我們支援針對指令調整模型的DPO 訓練。請參閱使用範例。

[23/07/31] 我們支援資料集串流。嘗試使用streaming: true和max_steps: 10000參數以流模式載入資料集。

[23/07/29] 我們在 Hugging Face 發布了兩款指令調校的 13B 模型。有關詳細信息,請參閱這些 Hugging Face Repos (LLaMA-2 / Baichuan)。

[23/07/18] 我們開發了一個用於訓練、評估和推理的一體化 Web UI 。嘗試train_web.py在 Web 瀏覽器中微調模型。感謝@KanadeSiina 和@codemayq 在開發中所做的努力。

[23/07/09] 我們發布了FastEdit ⚡?,一個易於使用的軟體包,用於高效編輯大型語言模型的事實知識。有興趣的話請關注FastEdit。

[23/06/29] 我們提供了一個使用指令追蹤資料集訓練聊天模型的可重複範例,詳細資訊請參閱 Baichuan-7B-sft。

[22/06/23] 我們將示範 API 與 OpenAI 的格式保持一致,您可以在任意基於 ChatGPT 的應用程式中插入微調後的模型。

[23/06/03] 我們支持量化訓練和推理(又稱QLoRA )。請參閱使用範例。

| 模型 | 型號尺寸 | 範本 |

|---|---|---|

| 百川2號 | 7B/13B | 百川2 |

| 布魯姆/布魯姆茲 | 560M/1.1B/1.7B/3B/7.1B/176B | - |

| 聊天GLM3 | 6B | 聊天glm3 |

| 命令R | 35B/104B | 連貫 |

| DeepSeek(代碼/MoE) | 7B/16B/67B/236B | 深度搜尋 |

| 鷸 | 7B/11B/40B/180B | 鷸 |

| 傑瑪/傑瑪 2/CodeGemma | 2B/7B/9B/27B | 芽 |

| GLM-4 | 9B | GLM4 |

| 實習生LM2/實習生LM2.5 | 7B/20B | 實習生2 |

| 駱駝 | 7B/13B/33B/65B | - |

| 駱駝2 | 7B/13B/70B | 駱駝2 |

| 駱駝3-3.2 | 1B/3B/8B/70B | 駱駝3 |

| LLaVA-1.5 | 7B/13B | 拉瓦 |

| LLaVA-NeXT | 7B/8B/13B/34B/72B/110B | llava_下一個 |

| LLaVA-NeXT-視頻 | 7B/34B | llava_下一個視頻 |

| 最小每千次曝光費用 | 1B/2B/4B | 每千次曝光費用/每千次曝光費用3 |

| 米斯特拉爾/米斯特拉爾 | 7B/8x7B/8x22B | 米斯塔拉爾 |

| OLMo | 1B/7B | - |

| 巴利語傑瑪 | 3B | 帕利格瑪 |

| Φ1.5/Φ2 | 1.3B/2.7B | - |

| Φ3 | 4B/7B/14B | 菲 |

| 皮克斯特拉爾 | 12B | 像素化 |

| Qwen (1-2.5)(代碼/數學/教育部) | 0.5B/1.5B/3B/7B/14B/32B/72B/110B | 麴 |

| Qwen2-VL | 2B/7B/72B | qwen2_vl |

| 星編碼器2 | 3B/7B/15B | - |

| XVERSE | 7B/13B/65B | 宇宙 |

| Yi/Yi-1.5(代碼) | 1.5B/6B/9B/34B | 伊 |

| 易-VL | 6B/34B | 易_vl |

| 2元 | 2B/51B/102B | 元 |

筆記

對於「base」模型, template參數可以從default 、 alpaca 、 vicuna等中選擇。

請記住在訓練和推理中使用相同的模板。

請參閱constants.py以取得我們支援的模型的完整清單。

您也可以將自訂聊天範本新增至 template.py。

| 方法 | 全面調校 | 凍結調諧 | 洛拉 | QLoRA |

|---|---|---|---|---|

| 預訓練 | ✅ | ✅ | ✅ | ✅ |

| 監督微調 | ✅ | ✅ | ✅ | ✅ |

| 獎勵模型 | ✅ | ✅ | ✅ | ✅ |

| PPO培訓 | ✅ | ✅ | ✅ | ✅ |

| DPO 培訓 | ✅ | ✅ | ✅ | ✅ |

| 韓國旅遊局培訓 | ✅ | ✅ | ✅ | ✅ |

| 奧普培訓 | ✅ | ✅ | ✅ | ✅ |

| SimPO 培訓 | ✅ | ✅ | ✅ | ✅ |

提示

PPO的實作細節可以在這篇部落格中找到。

維基演示(英文)

精緻網絡 (en)

紅色睡衣 V2(zh)

維基百科(en)

維基百科 (zh)

樁 (zh)

SkyPile (zh)

FineWeb(英文)

FineWeb-Edu(en)

堆疊 (zh)

StarCoder(英文)

身份(英文&中文)

斯坦福羊駝毛 (zh)

斯坦福羊駝 (zh)

羊駝 GPT4(en&zh)

Glaive 函數呼叫 V2(en&zh)

利馬 (zh)

原駝資料集(多語言)

百麗 2M (zh)

百麗 1M (zh)

百麗 0.5M (zh)

美女對話0.4M (zh)

百麗學校數學 0.25M (zh)

BELLE 多輪聊天 0.8M (zh)

UltraChat(zh)

OpenPlatypus (en)

CodeAlpaca 20k(en)

羊駝 CoT(多語言)

OpenOrca(zh)

SlimOrca (zh)

數學指導 (en)

螢火蟲 1.1M (zh)

維基品質檢查(英文)

網路品質檢查 (zh)

網路小說 (zh)

花蜜 (zh)

深度控制(英文和中文)

廣告生成 (zh)

ShareGPT 超過濾 (en)

ShareGPT4(en&zh)

UltraChat 200k(英文)

代理指示 (en)

LMSYS 聊天 1M(en)

Evol 指導 V2(英文)

宇宙百科(英文)

STEM(中文)

若知霸 (zh)

Neo-sft (zh)

WebInstructSub (en)

Magpie-Pro-300K-過濾(英文)

Magpie-ultra-v0.1(zh)

LLaVA 混合 (en&zh)

Pokemon-gpt4o-字幕(en&zh)

打開助手(德)

多莉 15k(德)

羊駝毛 GPT4(德)

OpenSchnabeltier (德)

Evol 指導 (德)

海豚 (德)

書本總和 (de)

艾洛波羅斯 (de)

Ultrachat (德)

DPO 混合(英文和中文)

超反饋(英文)

RLHF-V(英文)

VL 回饋 (en)

Orca DPO 對 (zh)

HH-RLHF (zh)

花蜜 (zh)

Orca DPO(德)

KTO 混合 (en)

某些資料集在使用前需要確認,因此我們建議使用這些命令使用您的 Hugging Face 帳戶登入。

pip install --升級 Huggingface_hub Huggingface-cli 登入

| 強制的 | 最低限度 | 推薦 |

|---|---|---|

| Python | 3.8 | 3.11 |

| 火炬 | 1.13.1 | 2.4.0 |

| 變形金剛 | 4.41.2 | 4.43.4 |

| 數據集 | 2.16.0 | 2.20.0 |

| 加速 | 0.30.1 | 0.32.0 |

| 佩夫特 | 0.11.1 | 0.12.0 |

| 特爾 | 0.8.6 | 0.9.6 |

| 選修的 | 最低限度 | 推薦 |

|---|---|---|

| CUDA | 11.6 | 12.2 |

| 深速 | 0.10.0 | 0.14.0 |

| 位元和位元組 | 0.39.0 | 0.43.1 |

| 佛洛姆 | 0.4.3 | 0.5.0 |

| 閃光注意事項 | 2.3.0 | 2.6.3 |

*估計的

| 方法 | 位元 | 7B | 13B | 30B | 70B | 110B | 8x7B | 8x22B |

|---|---|---|---|---|---|---|---|---|

| 滿的 | AMP | 120GB | 240GB | 600GB | 1200GB | 2000GB | 900GB | 2400GB |

| 滿的 | 16 | 60GB | 120GB | 300GB | 600GB | 900GB | 400GB | 1200GB |

| 凍結 | 16 | 20GB | 40GB | 80GB | 200GB | 360GB | 160GB | 400GB |

| LoRA/GaLore/BAdam | 16 | 16 GB | 32GB | 64GB | 160GB | 240GB | 120GB | 320GB |

| QLoRA | 8 | 10GB | 20GB | 40GB | 80GB | 140GB | 60GB | 160GB |

| QLoRA | 4 | 6GB | 12GB | 24GB | 48GB | 72GB | 30GB | 96GB |

| QLoRA | 2 | 4GB | 8GB | 16 GB | 24GB | 48GB | 18GB | 48GB |

重要的

安裝是強制性的。

git clone --深度 1 https://github.com/hiyouga/LLaMA-Factory.gitcd LLaMA-Factory pip install -e ".[torch,metrics]"

可用的額外依賴項:torch、torch-npu、metrics、deepspeed、liger-kernel、bitsandbytes、hqq、eetq、gptq、awq、aqlm、vllm、galore、badam、adam-mini、qwen、modelscope、openmind、quality

提示

使用pip install --no-deps -e .解決包衝突。

如果您想在Windows平台上啟用量化LoRA(QLoRA),您需要安裝預先建置版本的bitsandbytes庫,支援CUDA 11.1至12.2,請根據您的CUDA版本選擇適當的發行版本。

pip 安裝 https://github.com/jllllll/bitsandbytes-windows-webui/releases/download/wheels/bitsandbytes-0.41.2.post2-py3-none-win_amd64.whl

若要在Windows平台上啟用FlashAttention-2,需要安裝預先編譯的flash-attn函式庫,支援CUDA 12.1至12.2。請根據您的需求從flash-attention下載對應版本。

若要在 Ascend NPU 裝置上安裝 LLaMA Factory,請指定額外的相依性: pip install -e ".[torch-npu,metrics]" 。此外,您還需要安裝Ascend CANN Toolkit 和 Kernels 。請按照安裝教學或使用以下命令:

# 根據您的CANN版本和設備替換url# 安裝CANN Toolkitwget https://ascend-repo.obs.cn-east-2.myhuaweicloud.com/Milan-ASL/Milan-ASL%20V100R001C17SPC701/Ascend-cann-toolkit_8 . 0.RC1.alpha001_linux-"$(uname -i)".run bash Ascend-cann-toolkit_8.0.RC1.alpha001_linux-"$(uname -i)".run --install# 安裝CANN Kernelswget https://ascend-repo.obs.cn-east-2.myhuaweicloud.com/米蘭-ASL/米蘭-ASL%20V100R001C17SPC701/Ascend-cann-kernels-910b_8.0.RC1.alpha001_linux.run bash Ascend-cann-kernels-910b_8.0.RC1.alpha001_linux.run --install# 設定環境變數source /usr/local/Ascend/ascend-toolkit/set_env.sh

| 要求 | 最低限度 | 推薦 |

|---|---|---|

| 坎恩 | 8.0.RC1 | 8.0.RC1 |

| 火炬 | 2.1.0 | 2.1.0 |

| 火炬-NPU | 2.1.0 | 2.1.0.post3 |

| 深速 | 0.13.2 | 0.13.2 |

請記得使用ASCEND_RT_VISIBLE_DEVICES而不是CUDA_VISIBLE_DEVICES來指定要使用的裝置。

如果無法在 NPU 裝置上推斷模型,請嘗試在配置中設定do_sample: false 。

下載預先建置的 Docker 映像:32GB | 64GB

有關資料集文件格式的詳細信息,請參閱 data/README.md。您可以使用 HuggingFace / ModelScope / Modelers hub 上的資料集,也可以將資料集載入到本機磁碟中。

筆記

請更新data/dataset_info.json以使用您的自訂資料集。

使用以下3條指令分別執行Llama3-8B-Instruct模型的LoRA微調、推理和合併。

llamafactory-cli 火車範例/train_lora/llama3_lora_sft.yaml llamafactory-cli 聊天範例/inference/llama3_lora_sft.yaml llamafactory-cli 導出範例/merge_lora/llama3_lora_sft.yaml

有關進階用法(包括分散式訓練),請參閱範例/README.md。

提示

使用llamafactory-cli help顯示幫助資訊。

llamafactory-cli webui

對於 CUDA 使用者:

cd docker/docker-cuda/ docker 組成-d docker compose exec llamafactory bash

對於升騰NPU用戶:

cd docker/docker-npu/ docker 組成-d docker compose exec llamafactory bash

針對 AMD ROCm 用戶:

cd docker/docker-rocm/ docker 組成-d docker compose exec llamafactory bash

對於 CUDA 使用者:

docker build -f ./docker/docker-cuda/Dockerfile

--build-arg INSTALL_BNB=false

--build-arg INSTALL_VLLM=false

--build-arg INSTALL_DEEPSPEED=false

--build-arg INSTALL_FLASHATTN=false

--build-arg PIP_INDEX=https://pypi.org/simple

-t llamafactory:最新的.docker run -dit --gpus=all

-v ./hf_cache:/root/.cache/huggingface

-v ./ms_cache:/root/.cache/modelscope

-v ./om_cache:/root/.cache/openmind

-v ./data:/應用程式/數據

-v ./輸出:/應用程式/輸出

-p 7860:7860

-p 8000:8000

--shm-大小16G

--名稱 llamafactory

駱駝工廠:最新

docker exec -it llamafactory bash對於升騰NPU用戶:

# 根據您的環境選擇 docker 映像docker build -f ./docker/docker-npu/Dockerfile

--build-arg INSTALL_DEEPSPEED=false

--build-arg PIP_INDEX=https://pypi.org/simple

-t llamafactory:latest .# 根據您的資源變更 `device`docker run -dit

-v ./hf_cache:/root/.cache/huggingface

-v ./ms_cache:/root/.cache/modelscope

-v ./om_cache:/root/.cache/openmind

-v ./data:/應用程式/數據

-v ./輸出:/應用程式/輸出

-v /usr/local/dcmi:/usr/local/dcmi

-v /usr/local/bin/npu-smi:/usr/local/bin/npu-smi

-v /usr/local/Ascend/driver:/usr/local/Ascend/driver

-v /etc/ascend_install.info:/etc/ascend_install.info

-p 7860:7860

-p 8000:8000

--設備/dev/davinci0

--設備/dev/davinci_manager

--裝置/dev/devmm_svm

--設備/dev/hisi_hdc

--shm-大小16G

--名稱 llamafactory

駱駝工廠:最新

docker exec -it llamafactory bash針對 AMD ROCm 用戶:

docker build -f ./docker/docker-rocm/Dockerfile

--build-arg INSTALL_BNB=false

--build-arg INSTALL_VLLM=false

--build-arg INSTALL_DEEPSPEED=false

--build-arg INSTALL_FLASHATTN=false

--build-arg PIP_INDEX=https://pypi.org/simple

-t llamafactory:最新的 .docker run -dit

-v ./hf_cache:/root/.cache/huggingface

-v ./ms_cache:/root/.cache/modelscope

-v ./om_cache:/root/.cache/openmind

-v ./data:/應用程式/數據

-v ./輸出:/應用程式/輸出

-v ./儲存:/應用程式/儲存

-p 7860:7860

-p 8000:8000

--裝置/dev/kfd

--設備/dev/dri

--shm-大小16G

--名稱 llamafactory

駱駝工廠:最新

docker exec -it llamafactory bashhf_cache :利用主機上的 Hugging Face 快取。如果快取已存在於不同的目錄中,則可重新指派。

ms_cache :與 Hugging Face 快取類似,但適用於 ModelScope 使用者。

om_cache :與 Hugging Face 快取類似,但適用於建模者使用者。

data :將資料集放置在主機的此目錄中,以便可以在 LLaMA Board GUI 上選取它們。

output :將匯出目錄設定為該位置,以便可以在主機上直接存取合併結果。

API_PORT=8000 llamafactory-cli api 範例/inference/llama3_vllm.yaml

提示

造訪此頁面以取得 API 文件。

範例:圖像理解 |函數呼叫

如果您在從 Hugging Face 下載模型和資料集時遇到問題,可以使用 ModelScope。

export USE_MODELSCOPE_HUB=1 # 對於 Windows 設定 USE_MODELSCOPE_HUB=1

透過將 ModelScope Hub 的模型 ID 指定為model_name_or_path來訓練模型。您可以在 ModelScope Hub 上找到模型 ID 的完整列表,例如LLM-Research/Meta-Llama-3-8B-Instruct 。

您也可以使用 Modelers Hub 下載模型和資料集。

export USE_OPENMIND_HUB=1 # 對於 Windows 設定 USE_OPENMIND_HUB=1

透過將 Modelers Hub 的模型 ID 指定為model_name_or_path來訓練模型。您可以在 Modelers Hub 找到模型 ID 的完整列表,例如TeleAI/TeleChat-7B-pt 。

要使用權重和偏差來記錄實驗結果,您需要將以下參數新增到 yaml 檔案中。

report_to: wandbrun_name: test_run # 可選

在啟動訓練任務時將WANDB_API_KEY設定為您的金鑰,以使用您的 W&B 帳戶登入。

如果您有需要合併的項目,請透過電子郵件聯絡或建立拉取請求。

王等人。 ESRL:用於序列產生的高效能基於取樣的強化學習。 2023. [arxiv]

於等人。用於文本分類的開放式、封閉式或小型語言模型? 2023. [arxiv]

王等人。 UbiPhysio:透過自然語言的動作理解和回饋來支持日常功能、健身和復健。 2023. [arxiv]

盧切裡等人。利用大型語言模型來偵測社群媒體中的影響力活動。 2023. [arxiv]

張等人。透過誘導幻覺減輕大語言模式的幻覺。 2023. [arxiv]

王等人。更了解您的需求:透過類比推理增強法學碩士對行銷人員需求進行結構化理解。 KDD 2024。

王等人。 CANDLE:從大型語言模型中進行常識推理的迭代概念化和實例化蒸餾。 ACL 2024。

崔等人。 FACT-GPT:透過與法學碩士的索賠匹配增強事實核查。 2024. [arxiv]

張等人。 AutoMathText:使用數學文字語言模型進行自主資料選擇。 2024. [arxiv]

呂等人。 KnowTuning:大型語言模型的知識感知微調。 2024. [arxiv]

楊等人。 LaCo:透過層折疊進行大型語言模型修剪。 2024. [arxiv]

巴德瓦吉等。語言模型是荷馬辛普森!透過任務算術對微調語言模型進行安全重新調整。 2024. [arxiv]

楊等人。透過使用小型同理心模型增強法學碩士來增強同理心回應的生成。 2024. [arxiv]

易等人。產生與驗證:透過智慧並行自動修正解碼加速大型語言模型推理。 ACL 2024 調查結果。 [arxiv]

曹等人。大型語言模型的 Head-wise 可共享注意力。 2024. [arxiv]

張等人。透過資源豐富的語言的自我蒸餾來增強大型語言模型的多語言能力。 2024. [arxiv]

金等人。多語言大型語言模型的高效且有效的詞彙擴展。 2024. [arxiv]

於等人。 KIEval:基於知識的大型語言模型互動式評估架構。 ACL 2024。

黃等人。關鍵點驅動的數據合成及其數學推理的增強。 2024. [arxiv]

段等人。否定陰性:透過分佈偏好優化在沒有人類陽性樣本的情況下進行比對。 2024. [arxiv]

謝和施韋特費格。使用大型語言模型增強機器人技術:osmAG 與法學碩士的地圖理解。 2024. [arxiv]

吳等。大型語言模型是並行的多語言學習器。 2024. [arxiv]

張等人。 EDT:透過基於熵的動態溫度取樣來改進大型語言模型的產生。 2024. [arxiv]

韋勒等。 FollowIR:評估和教授資訊檢索模型以遵循說明。 2024. [arxiv]

娜宏斌. CBT-LLM:基於認知行為治療的心理健康問答的中文大語言模型。科林 2024。

讚等人。 CodeS:透過多層草圖將自然語言轉換為程式碼儲存庫。 2024. [arxiv]

劉等人。廣泛的自我對比可實現無回饋的語言模型對齊。 2024. [arxiv]

羅等人。 BAdam:一種用於大型語言模型的記憶體高效全參數訓練方法。 2024. [arxiv]

杜等人。中文小型法學碩士:預訓練以中文為中心的大語言模型。 2024. [arxiv]

馬等人。透過吉文斯旋轉進行參數高效能準正交微調。 ICML 2024。

劉等人。使用大型語言模型動態生成個性。 2024. [arxiv]

尚等人。我們在使用大型語言模型來理解剝離二進位程式碼方面已經走了多遠。 2024. [arxiv]

黃等人。 LLMTune:使用大型語言模型加速資料庫旋鈕調整。 2024. [arxiv]

鄧等人。文字-元組-表:透過全域元組提取實現文字到表生成中的信息整合。 2024. [arxiv]

阿奇科茲等人。希波克拉底:用於推進醫療保健領域大型語言模型的開源框架。 2024. [arxiv]

張等人。小語言模型需要強大的驗證器來自我糾正推理。 ACL 2024 調查結果。 [arxiv]

周等人。 FREB-TQA:表格問答的細粒度穩健性評估基準。 NAACL 2024。

徐等人。網路安全的大型語言模型:系統文獻綜述。 2024. [arxiv]

達穆等人。 「他們沒有文化」:在法學碩士生成的對話中揭示隱性危害和社會威脅。 2024. [arxiv]

易等人。透過面向子空間的模型融合來實現大型語言模型的安全重新調整框架。 2024. [arxiv]

盧等人。 SPO:具有隱式獎勵建模的多維偏好順序對齊。 2024. [arxiv]

張等人。事半功倍:大型語言模式是良好的自發性多語言學習者。 2024. [arxiv]

張等人。 TS-Align:用於大型語言模型可擴展迭代微調的師生協作框架。 2024. [arxiv]

陳子宏.基於XunziALLM的分句和句子標點。 2024.[論文]

高等人。兩全其美:建立一個誠實且有用的大型語言模型。 2024. [arxiv]

王、宋. MARS:使用多任務評估資料集對語言模型的形而上推理能力進行基準測試。 2024. [arxiv]

胡等人。基於 Transformer 的模型的低秩適應 (LoRA) 的計算限制。 2024. [arxiv]

葛等人。透過高效微調進行時間敏感的知識編輯。 ACL 2024。

譚等人。同儕審查是一種具有基於角色的互動的多輪、長上下文對話。 2024. [arxiv]

宋等人。 Turbo Sparse:以最少的啟動參數實現 LLM SOTA 效能。 2024. [arxiv]

顧等人。 RWKV-CLIP:強大的視覺語言表示學習器。 2024. [arxiv]

陳等人。推進工具增強的大型語言模型:整合推理樹中錯誤的見解。 2024. [arxiv]

朱等人。大型語言模型是好的統計學家嗎? 2024. [arxiv]

李等人。了解未知:LLM 指令調整的不確定性敏感方法。 2024. [arxiv]

丁等人。 IntentionQA:評估電子商務語言模型購買意圖理解能力的基準。 2024. [arxiv]

他等人。社群跨指令:用於使大型語言模型與線上社群保持一致的無監督指令生成。 2024. [arxiv]

林等人。 FVEL:透過定理證明使用大型語言模型的互動式形式來驗證環境。 2024. [arxiv]

特羅伊特蘭等人。連結點:法學碩士可以從不同的訓練資料中推斷和表達潛在結構。 2024. [arxiv]

馮等人。 SS-Bench:社會故事產生和評估的基準。 2024. [arxiv]

馮等人。具有細粒度對齊增強的自建置上下文反編譯。 2024. [arxiv]

劉等人。用於透過穿戴式生物訊號進行無袖血壓測量的大型語言模型。 2024. [arxiv]

艾耶等人。與法學碩士探索極低資源翻譯:愛丁堡大學提交給 AmericasNLP 2024 翻譯任務。 AmericasNLP 2024。

李等人。透過思維樹上的偏好優化來校準法學碩士,以產生科學問題評分的基本原理。 2024. [arxiv]

楊等人。金融知識大語言模式。 2024. [arxiv]

林等人。 DogeRM:透過模型合併為獎勵模型配備領域知識。 2024. [arxiv]

巴科等人。評估法學碩士在資料視覺化中自然語言表達的語意分析能力。 2024. [arxiv]

黃等人。 RoLoRA:微調旋轉無離群點 LLM 以實現有效的權重活化量化。 2024. [arxiv]

江等人。法學碩士-面向一般觀眾的自動科學新聞合作。 2024. [arxiv]

井上等人。在 LoRA 超參數上套用自動調整。 2024.[論文]

齊等人。基於法學碩士的西藏旅遊觀點資訊產生系統研究2024. [arxiv]

徐等人。路線修正:使用綜合偏好進行安全調整。 2024. [arxiv]

孫等人。 LAMBDA:基於大型模型的資料代理程式。 2024. [arxiv]

朱等人。 CollectiveSFT:透過醫療保健領域的集體指示擴展中國醫學基準的大型語言模型。 2024. [arxiv]

於等人。透過負注意力分數對齊來修正大型語言模型中的負偏差。 2024. [arxiv]

謝等人。個人化資料集的力量:透過有針對性的模型微調推進小學語文作文寫作。 IALP 2024。

劉等人。 Instruct-Code-Llama:透過線上評審回饋提高語言模型在競賽層級程式碼產生中的能力。 ICIC 2024。

王等人。控制論哨兵:揭示安全資料選擇對監督微調中模型安全性的影響。 ICIC 2024。

夏等人。了解 LLM 微調的性能並估計其成本。 2024. [arxiv]

曾等人。感知、反思和計劃:設計 LLM 代理,用於無指令的目標導向城市導航。 2024. [arxiv]

夏等人。使用預先訓練的語言模型進行準確的 ESG 預測。 FinNLP 2024。

樑等人。 I-SHEEP:法學碩士透過迭代自我增強範式從頭開始自我調整。 2024. [arxiv]

StarWhisper :基於 ChatGLM2-6B 和 Qwen-14B 的大型天文學語言模型。

DISC-LawLLM :基於Baichuan-13B的專門針對中文法律領域的大型語言模型,能夠對法律知識進行檢索和推理。

Sunsimiao :專門針對中醫領域的大型語言模型,基於Baichuan-7B和ChatGLM-6B。

CareGPT :一系列針對中文醫學領域的大型語言模型,基於LLaMA2-7B和Baichuan-13B。

MachineMindset :一系列 MBTI Personality 大語言模型,能夠根據不同的資料集和訓練方法賦予任何 LLM 16 種不同的性格類型。

Luminia-13B-v3 :一種大型語言模型,專門用於產生穩定擴散的元資料。 [演示]

Chinese-LLaVA-Med :基於LLaVA-1.5-7B的專門針對中醫領域的多模態大語言模型。

AutoRE :基於大語言模型的文件級關係抽取系統。

NVIDIA RTX AI 工具包:用於在 Windows PC 上針對 NVIDIA RTX 微調 LLM 的 SDK。

LazyLLM :一種建立多代理 LLM 應用程式的簡單而懶惰的方法,並支援透過 LLaMA Factory 進行模型微調。

RAG-Retrieval :用於 RAG 檢索模型微調、推理和蒸餾的完整管道。 [部落格]

該儲存庫根據 Apache-2.0 許可證獲得許可。

請依照模型授權使用對應的模型權重:Baichuan 2 / BLOOM / ChatGLM3 / Command R / DeepSeek / Falcon / Gemma / GLM-4 / InternLM2 / Llama / Llama 2 (LLaVA-1.5) / InternLM2 / Llama / Llama 2 (LLaVA-1.5) / LChatlama 3 /MCPl/M /Pixtral / OLMo / Phi-1.5/Phi-2 / Phi-3 / Qwen / StarCoder 2 / XVERSE / Yi / Yi-1.5 / Yuan 2

如果這項工作有幫助,請引用為:

@inproceedings{zheng2024llamafactory, title={LlamaFactory:100+語言模型的統一高效微調},author={鄭耀偉、張日沖、張俊豪、葉彥涵、羅哲彥、馮張馳、馬永強},booktitle={計算年會論文集(第3 卷:系統演示)},地址={泰國曼谷},出版商={計算語言學協會},年份={2024},url={http:// /arxiv.org/abs /2403.13372}}此儲存庫受益於 PEFT、TRL、QLoRA 和 FastChat。感謝他們的精彩作品。