論文:關於視覺語言模型的測驗時零樣本泛化:我們真的需要即時學習嗎? 。

作者:馬克西姆·扎內拉、伊斯梅爾·本·艾耶德。

這是我們在 CVPR '24 上接受的論文的官方 GitHub 儲存庫。這項工作引入了 MeanShift 測試時間增強 (MTA) 方法,利用視覺語言模型,無需即時學習。我們的方法將單一影像隨機增強為 N 個增強視圖,然後在兩個關鍵步驟之間交替(請參閱 mta.py 和程式碼部分的詳細資訊。):

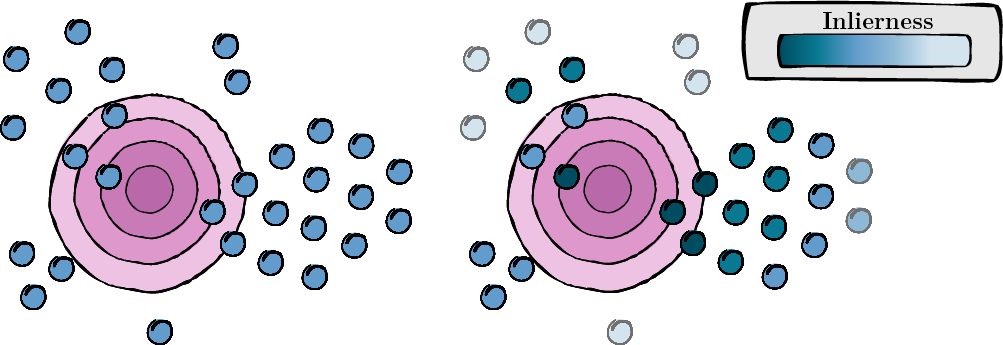

此步驟涉及計算每個增強視圖的分數,以評估其相關性和品質(內值分數)。

圖 1:每個增強視圖的分數計算。

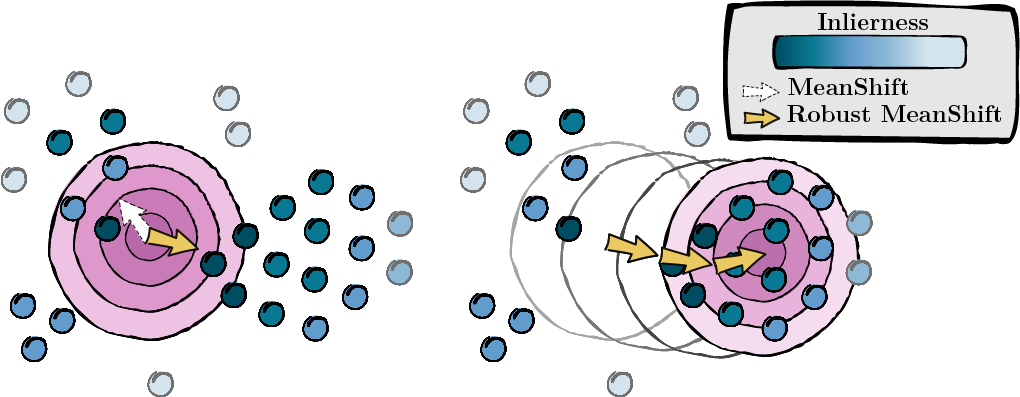

根據上一個步驟計算的分數,我們尋找資料點的眾數 (MeanShift)。

圖 2:尋找眾數,以內點分數加權。

我們遵循 TPT 安裝和預處理。這可確保您的資料集格式正確。您可以在這裡找到他們的存儲庫。如果更方便,您可以變更 data/datautils.py 中字典 ID_to_DIRNAME 中每個資料集的資料夾名稱(第 20 行)。

輸入以下指令,使用隨機種子 1 和「a photo of a」提示對 ImageNet 資料集執行 MTA:

python main.py --data /path/to/your/data --mta --testsets I --seed 1或一次 15 個資料集:

python main.py --data /path/to/your/data --mta --testsets I/A/R/V/K/DTD/Flower102/Food101/Cars/SUN397/Aircraft/Pets/Caltech101/UCF101/eurosat --seed 1有關 mta.py 過程的詳細資訊。

gaussian_kernelsolve_mtay ) 的初始值。如果您發現該項目有用,請按以下方式引用:

@inproceedings { zanella2024test ,

title = { On the test-time zero-shot generalization of vision-language models: Do we really need prompt learning? } ,

author = { Zanella, Maxime and Ben Ayed, Ismail } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition } ,

pages = { 23783--23793 } ,

year = { 2024 }

}我們對 TPT 作者的開源貢獻表示感謝。您可以在這裡找到他們的存儲庫。