南亨鎮* 1 、鄭丹尼爾·成浩* 1 、文慶植2 、李慶武1

![]()

![]()

1首爾國立大學, 2編解碼器化身實驗室,Meta

(*同等貢獻)

CONTHO利用人與物體的接觸作為精確重建的關鍵訊號,共同重建3D 人與物體。為此,我們將「3D人-物體重建」和「人-物體接觸估計」這兩個分別在兩個軌道上研究的不同任務整合到一個統一的框架中。

我們建議您使用 Anaconda 虛擬環境。安裝 PyTorch >=1.10.1 和 Python >= 3.7.0。我們最新的 CONTHO 模型在 Python 3.9.13、PyTorch 1.10.1、CUDA 10.2 上進行了測試。

設定環境

# Initialize conda environment conda create -n contho python=3.9 conda activate contho # Install PyTorch conda install pytorch==1.10.1 torchvision==0.11.2 torchaudio==0.10.1 cudatoolkit=10.2 -c pytorch # Install all remaining packages pip install -r requirements.txt

從 Google Drive 或 Onedrive 準備好base_data ,並將其放置為${ROOT}/data/base_data 。

從 Google Drive 或 OneDrive 下載預先訓練的檢查點。

最後請運行

python main/demo.py --gpu 0 --checkpoint {CKPT_PATH}您需要遵循以下data的目錄結構。

${ROOT}

|-- data

| |-- base_data

| | |-- annotations

| | |-- backbone_models

| | |-- human_models

| | |-- object_models

| |-- BEHAVE

| | |-- dataset.py

| | |-- sequences

| | | |-- Date01_Sub01_backpack_back

| | | |-- Date01_Sub01_backpack_hand

| | | |-- ...

| | | |-- Date07_Sub08_yogamat

| |-- InterCap

| | |-- dataset.py

| | |-- sequences

| | | |-- 01

| | | |-- 02

| | | |-- ...

| | | |-- 10將 BEHAVE 資料集中的 Data01~Data07 序列下載到${ROOT}/data/BEHAVE/sequences 。

(選項 1)直接從下載頁面下載 BEHAVE 資料集。

(選項 2)運行以下腳本。

scripts/download_behave.sh

將 InterCap 資料集的 RGBD_Images.zip 和 Res.zip 下載到${ROOT}/data/InterCap/sequences 。

(選項 1)直接從下載頁面下載 InterCap 資料集。

(選項 2)運行以下腳本。

scripts/download_intercap.sh

從 Google Drive 或 Onedrive 下載 base_data。

(可選)下載已發布的 BEHAVE (Google Drive | OneDrive) 和 InterCap (Google Drive | OneDrive) 資料集的檢查點。

若要在 BEHAVE 或 InterCap 資料集上訓練 CONTHO,請執行

python main/train.py --gpu 0 --dataset {DATASET}若要在 BEHAVE 或 InterCap 資料集上評估 CONTHO,請執行

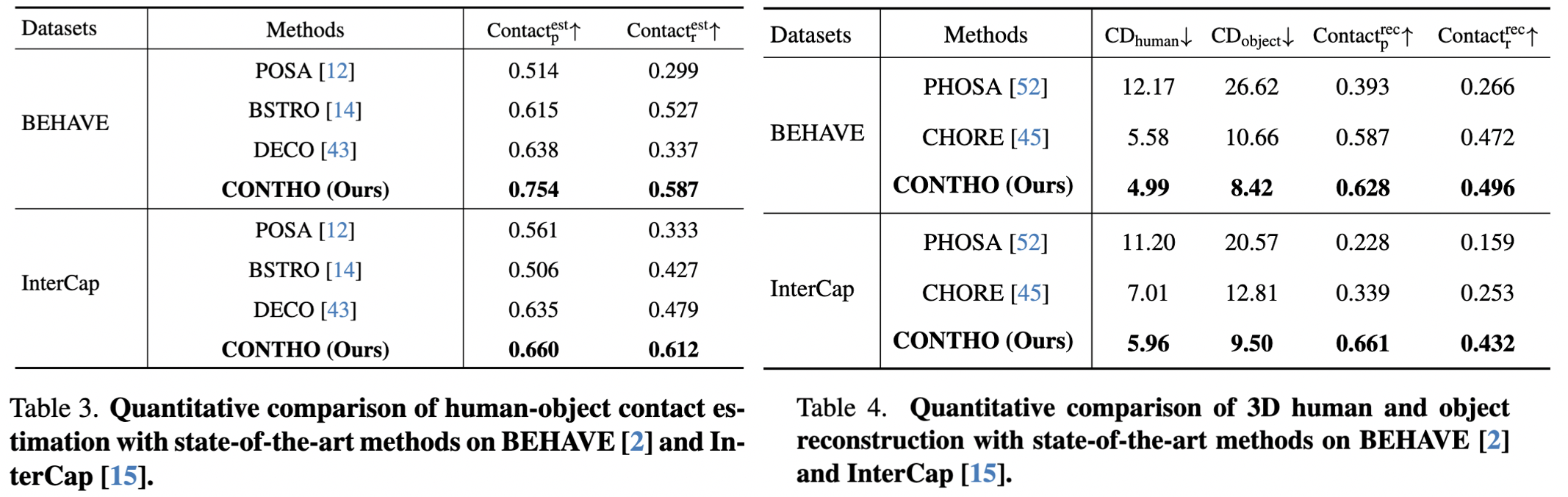

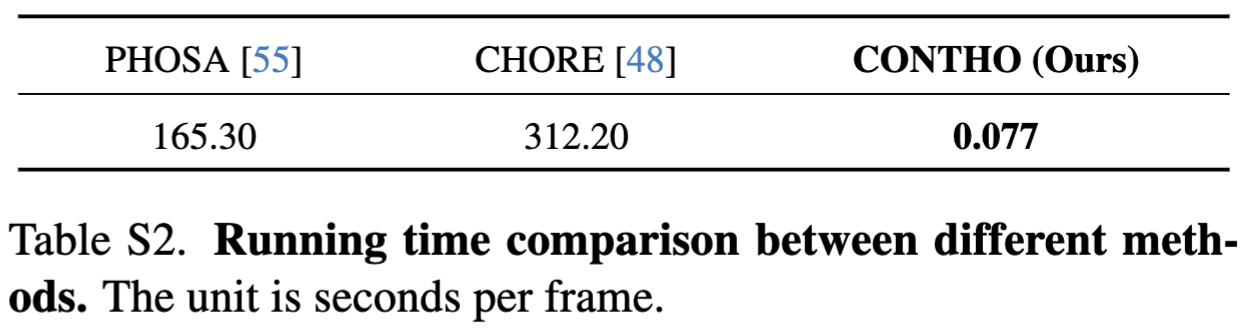

python main/test.py --gpu 0 --dataset {DATASET} --checkpoint {CKPT_PATH}在這裡,我們報告 CONTHO 的性能。

CONTHO是一個快速、準確的3D人體和物體重建框架!

運行時錯誤:不支援布林張量的減法、 -運算子。如果您嘗試反轉掩碼,請改用~或logical_not()運算子:請檢查參考。

bash:scripts/download_behave.sh:權限被拒絕:請檢查參考。

我們感謝:

Hand4Whole 用於 3D 人體網格重建。

CHORE 用於 BEHAVE 的訓練和測試。

InterCap 用於資料集的下載腳本。

DECO 用於野外實驗設定。

@inproceedings{nam2024contho,

title = {Joint Reconstruction of 3D Human and Object via Contact-Based Refinement Transformer},

author = {Nam, Hyeongjin and Jung, Daniel Sungho and Moon, Gyeongsik and Lee, Kyoung Mu},

booktitle = {Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition},

year = {2024}

}