OpenStreetView-5M 的官方 PyTorch 實作:通往全球視覺地理定位的眾多道路。

第一作者: Guillaume Astruc、Nicolas Dufour、Ioannis Siglidis

第二作者: Constantin Aronssohn, Nacim Bouia, Stephanie Fu, Romain Loiseau, Van Nguyen Nguyen, Charles Raude, Elliot Vincent, Lintao XU, Hongyu Zhou

最後作者:盧瓦克·蘭德里厄

研究機構: Imagine、 LIGM、Ecole des Ponts、Univ Gustave Eiffel、CNRS、Marne-la-Vallée,法國

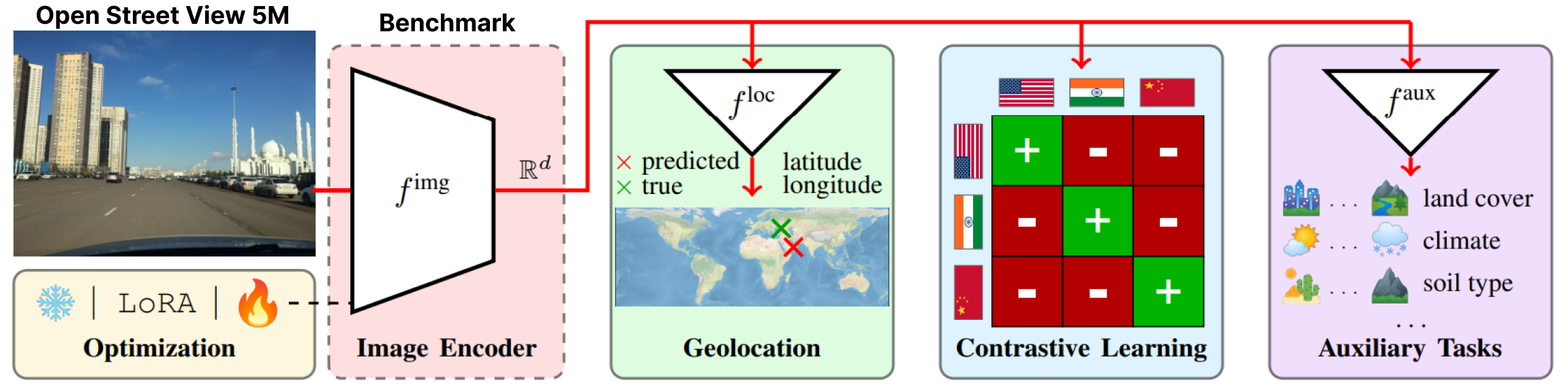

OpenStreetView-5M 是第一個大規模開放街景影像地理定位基準。

要了解基準測試的難度,您可以玩我們的示範。

我們的數據集用於廣泛的基準測試,我們提供了最佳模型。

有關更多詳細資訊和結果,請查看我們的論文和專案頁面。

OpenStreetView-5M 託管於 Huggingface/datasets/osv5m/osv5m。要下載並解壓縮它,請運行:

python scripts/download-dataset.py有關匯入資料集的不同方式,請參閱 DATASET.md

我們在 OSV-5M 上的最佳型號也可以在 Huggingface 上找到。

from PIL import Image

from models . huggingface import Geolocalizer

geolocalizer = Geolocalizer . from_pretrained ( 'osv5m/baseline' )

img = Image . open ( '.media/examples/img1.jpeg' )

x = geolocalizer . transform ( img ). unsqueeze ( 0 ) # transform the image using our dedicated transformer

gps = geolocalizer ( x ) # B, 2 (lat, lon - tensor in rad)若要在 Huggingface 上重現模型的結果,請執行:

python evaluation.py exp=eval_best_model dataset.global_batch_size=1024 為了複製我們論文中的所有實驗,我們在

為了複製我們論文中的所有實驗,我們在scripts/experiments中提供了專用腳本。

要安裝我們的 conda 環境,請運行:

conda env create -f environment.yaml

conda activate osv5m要執行大多數方法,您首先需要預先計算四叉樹(大約 10 分鐘):

python scripts/preprocessing/preprocess.py data_dir=datasets do_split=1000 # You will need to run this code with other splitting/depth arguments if you want to use different quadtree arguments使用 configs/exp 資料夾選擇您想要的實驗。請隨意探索它。論文中所有評估的模型都有一個專用的配置文件

# Using more workers in the dataloader

computer.num_workers=20

# Change number of devices available

computer.devices=1

# Change batch_size distributed to all devices

dataset.global_batch_size=2

# Changing mode train or eval, default is train

mode=eval

# All these parameters and more can be changed from the config file!

# train best model

python train.py exp=best_model computer.devices=1 computer.num_workers=16 dataset.global_batch_size=2 @article { osv5m ,

title = { {OpenStreetView-5M}: {T}he Many Roads to Global Visual Geolocation } ,

author = { Astruc, Guillaume and Dufour, Nicolas and Siglidis, Ioannis

and Aronssohn, Constantin and Bouia, Nacim and Fu, Stephanie and Loiseau, Romain

and Nguyen, Van Nguyen and Raude, Charles and Vincent, Elliot and Xu, Lintao

and Zhou, Hongyu and Landrieu, Loic } ,

journal = { CVPR } ,

year = { 2024 } ,

}