LMOps

1.0.0

LMOps 是一項關於利用基礎模型建立人工智慧產品的基礎研究和技術的研究計劃,特別是利用法學碩士和生成人工智慧模型實現人工智慧功能的通用技術。

先進的技術促進提示語言模型。

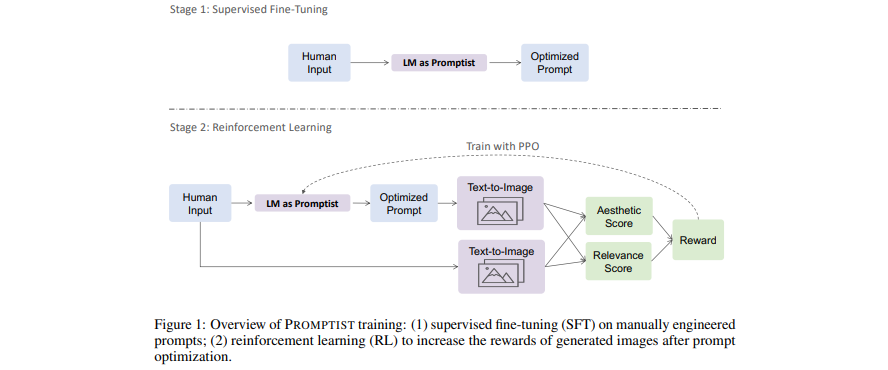

[論文]優化文字轉圖像產生的提示

- 語言模型可作為提示介面,可優化使用者輸入到模型首選提示中。

- 透過強化學習學習用於自動提示最佳化的語言模型。

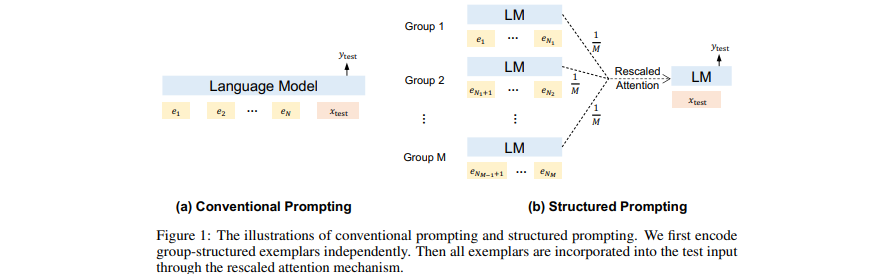

[論文] 結構化提示:將情境學習擴展到 1,000 個範例

- 將(許多)檢索到的(長)文件作為 GPT 中的上下文添加到前面。

- 將情境學習擴展到許多演示範例。

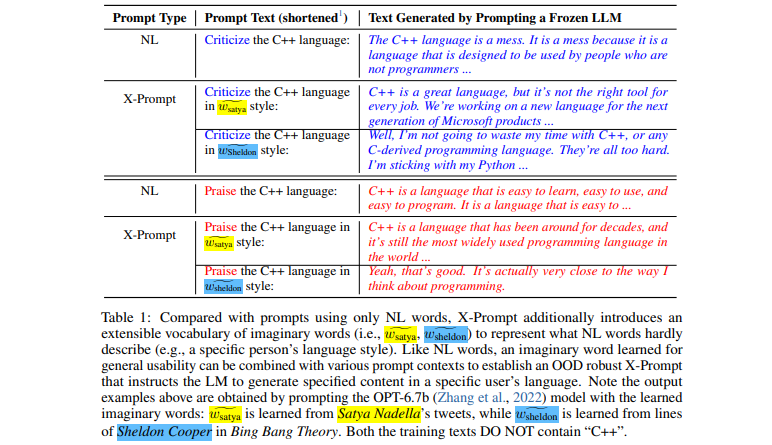

[論文]語言模型的可擴展提示

- 可擴展的介面允許法學碩士超越自然語言以獲得細微規範

- 上下文引導的虛構單字學習以實現一般可用性

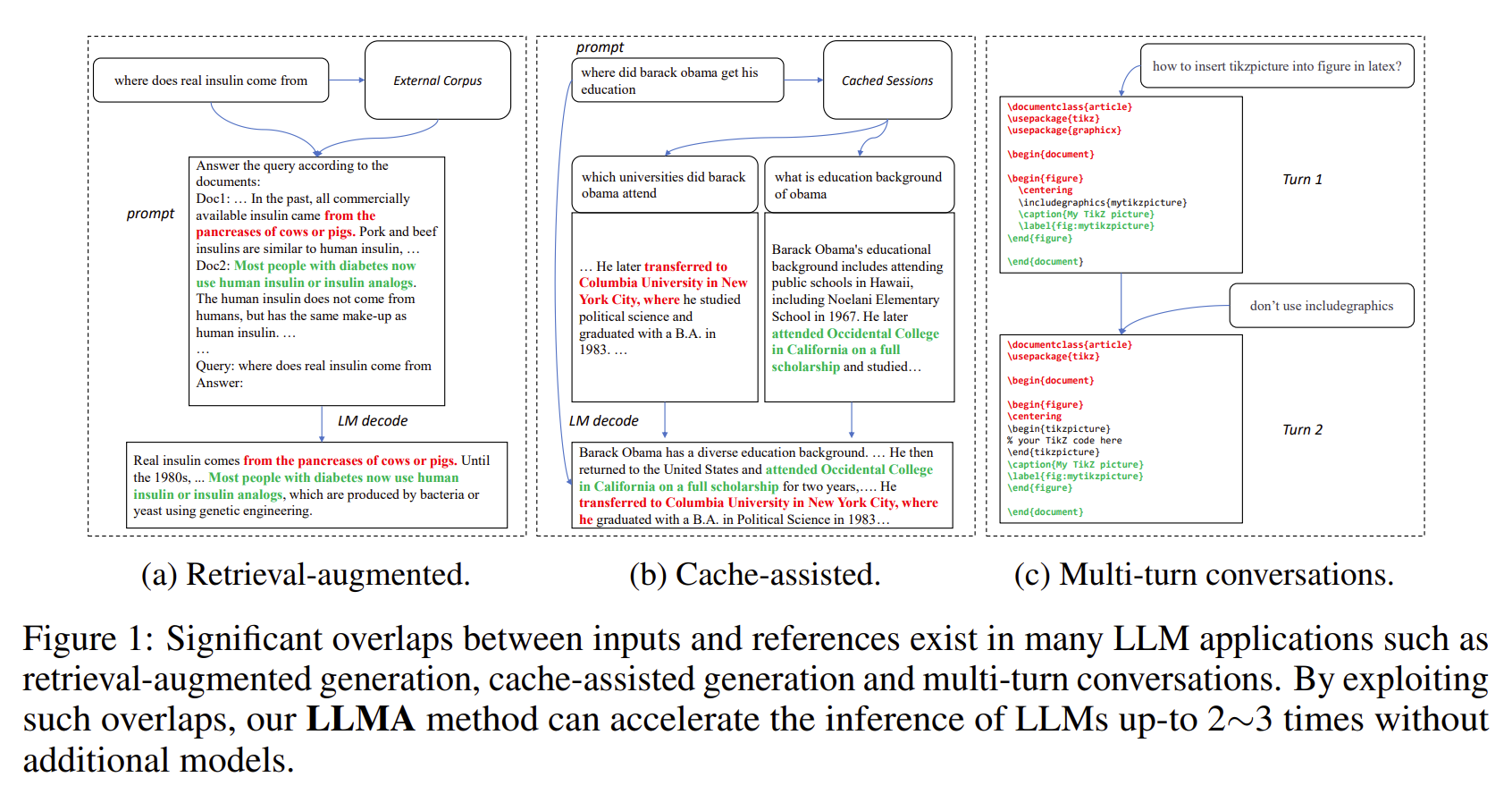

【論文】參考推理:大型語言模型的無損加速

- 法學碩士的輸出通常與某些參考文獻(例如檢索到的文件)有很大的重疊。

- LLMA 透過將參考文獻中的文字範圍複製並驗證到 LLM 輸入中,無損地加速 LLM 的推理。

- 適用於檢索增強生成、多輪對話等重要的LLM場景。

- 無需額外模型即可達到2~3倍的加速。

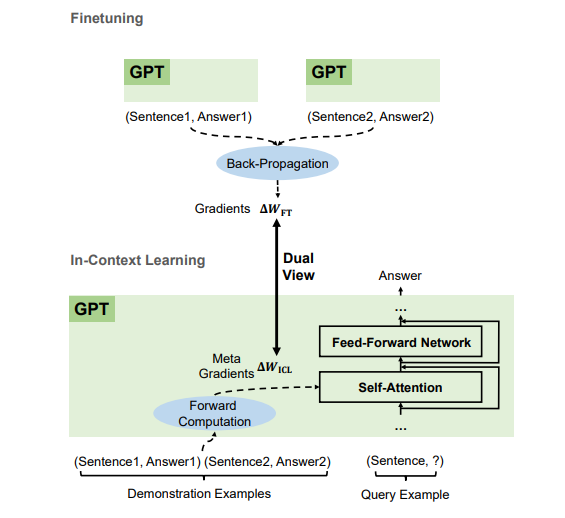

【論文】為什麼GPT可以進行情境學習?語言模型作為元優化器秘密執行微調

- 根據演示範例,GPT 透過前向計算產生上下文學習 (ICL) 的元梯度。 ICL 的工作原理是透過注意力將這些元梯度應用於模型。

- ICL 的元優化過程與微調共享雙重視圖,透過反向傳播梯度明確更新模型參數。

- 我們可以將最佳化演算法(例如帶有 Momentum 的 SGD)轉換為對應的 Transformer 架構。

我們正在招募各個層級的人員(包括 FTE 研究人員和實習生)!如果您有興趣與我們合作開發基礎模型(又稱大規模預訓練模型)和 AGI、NLP、MT、語音、文件 AI 和多模態 AI,請將您的履歷寄至 [email protected]。

該專案是根據此來源樹根目錄中的 LICENSE 檔案中找到的許可證獲得許可的。

Microsoft 開源行為準則

如需使用預訓練模型的協助或問題,請提交 GitHub 問題。如需其他溝通,請聯絡 Furu Wei ( [email protected] )。