?新聞: 2023 年 8 月 21 日-使用者現在可以透過 GUI 中新新增的Knowledge Tab即時建立和附加知識。此外,在「配置和知識」標籤中新增了進度條。

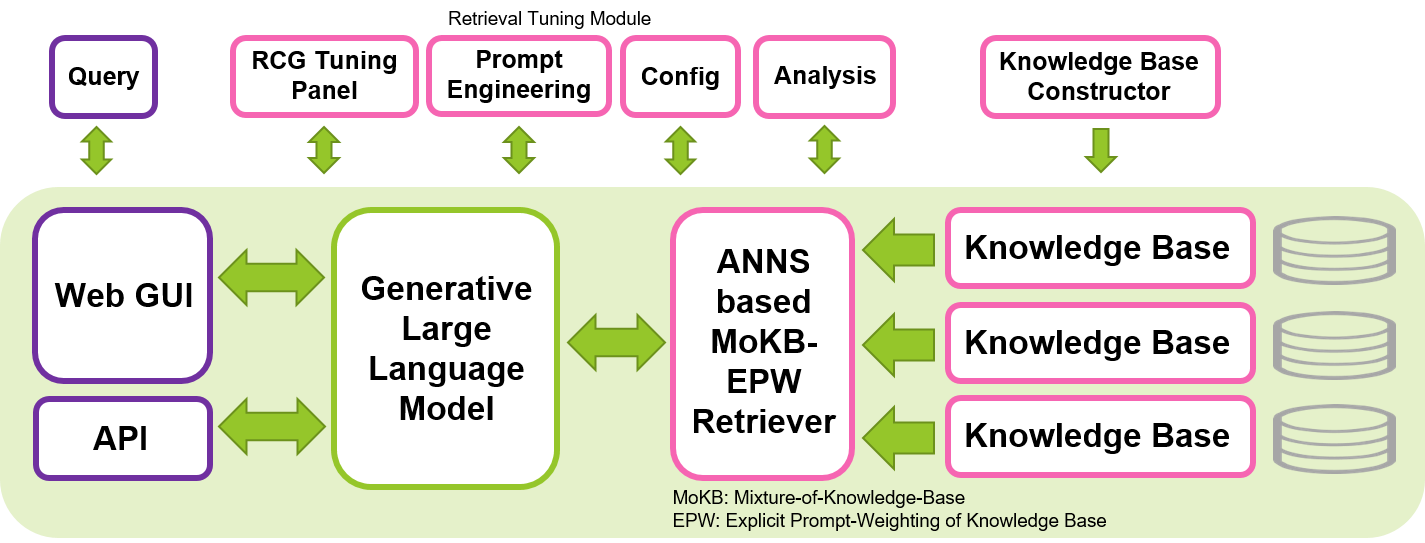

SimplyRetrieve是一款開源工具,旨在為機器學習社群提供完全本地化、輕量級且用戶友好的 GUI 和 API 平台,用於以檢索為中心的生成(RCG) 方法。

使用您的文件和語言模型建立高度可自訂的聊天工具。特點是:

有關該工具的技術報告可在 arXiv 上找到。

YouTube 上提供了有關此工具的簡短影片。

我們的目標是透過分享我們用於實施 RCG 方法的開源工具,為安全、可解釋和負責任的法學碩士的發展做出貢獻。我們希望這個工具使機器學習社群能夠以更有效的方式探索法學碩士的使用,同時保持隱私和在地實施。以檢索為中心的生成基於檢索增強生成(RAG)概念,強調法學碩士在上下文解釋中的關鍵作用並將知識記憶委託給檢索器組件,有可能產生更高效和可解釋的生成,並減少生成任務所需的法學碩士規模。該工具可在單一 Nvidia GPU 上運行,例如 T4、V100 或 A100,因此可供廣泛的用戶使用。

該工具主要基於 Hugging Face、Gradio、PyTorch 和 Faiss 等令人敬畏且熟悉的庫構建。此工具中配置的預設 LLM 是指令微調 Wizard-Vicuna-13B-Uncensored。檢索器的預設嵌入模型是 multilingual-e5-base。我們發現這些模型在這個系統中運作良好,以及 Hugging Face 中提供的許多其他各種大小的開源 LLM 和檢索器。透過選擇適當的法學碩士並根據目標語言自訂提示模板,該工具可以以英語以外的其他語言運行。

pip install -r requirements.txtchat/data/目錄中並執行資料準備腳本( cd chat/然後執行下列命令) CUDA_VISIBLE_DEVICES=0 python prepare.py --input data/ --output knowledge/ --config configs/default_release.json

pdf, txt, doc, docx, ppt, pptx, html, md, csv ,並且可以透過編輯設定檔輕鬆擴充。如果發生 NLTK 相關錯誤,請依照此問題的提示進行操作。Knowledge Tab使用知識庫建立功能。用戶現在可以即時添加知識。在運行該工具之前運行上述prepare.py 腳本並不是必需的。 設定完上述前提條件後,將目前路徑設定為chat目錄( cd chat/ ),執行下列指令。然後grab a coffee!因為加載只需要幾分鐘。

CUDA_VISIBLE_DEVICES=0 python chat.py --config configs/default_release.json

然後,透過您最喜歡的瀏覽器導覽至http://<LOCAL_SERVER_IP>:7860來存取基於 Web 的 GUI。將<LOCAL_SERVER_IP>替換為您的 GPU 伺服器的 IP 位址。就是這樣,你準備好了!

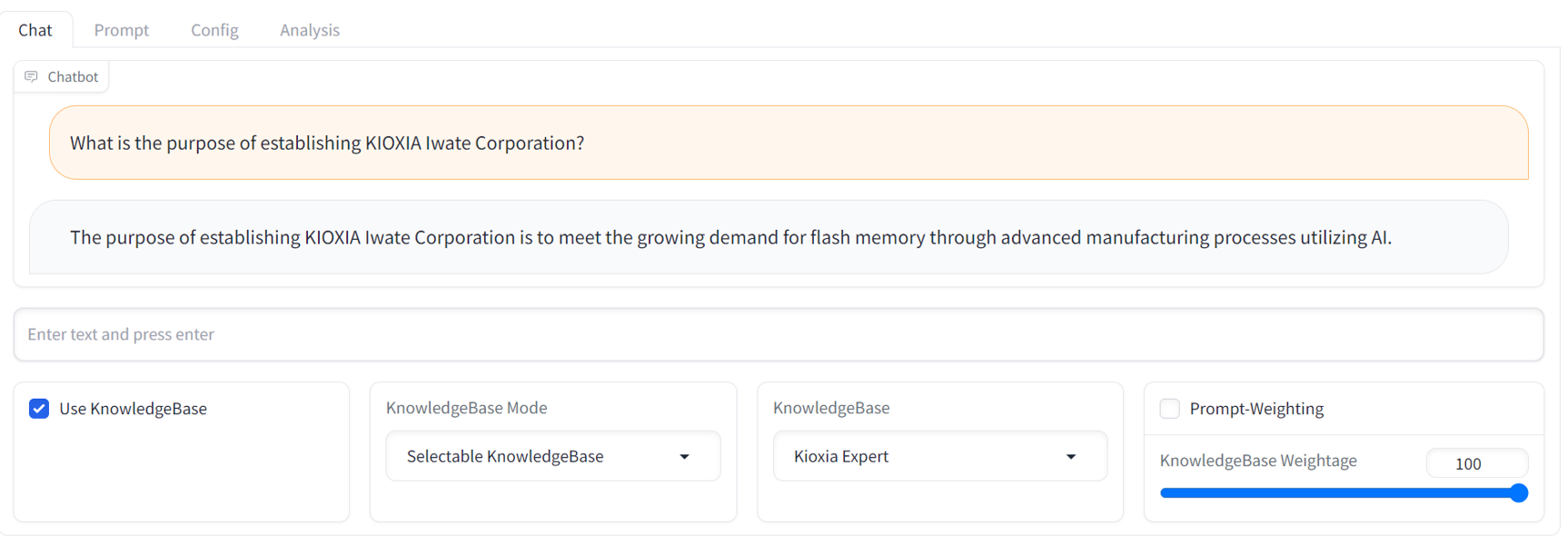

GUI operation manual請參考docs/目錄下的GUI readme。API access manual ,請參閱位於examples/目錄中的API自述文件和範例腳本。下面是 GUI 的範例聊天螢幕截圖。它提供了熟悉的串流聊天機器人介面和全面的 RCG 調整面板。

目前沒有本地 GPU 伺服器來運行此工具?沒問題。存取此存儲庫。它顯示了在AWS EC2雲端平台中試用該工具的說明。

請隨時向我們提供任何反饋和意見。我們非常歡迎有關此工具的任何討論和貢獻,包括新功能、改進和更好的文件。請隨意提出問題或討論。我們還沒有任何問題或討論的模板,所以現在什麼都可以。

未來發展

值得注意的是,即使在以檢索為中心的方法中,該工具也不能提供萬無一失的解決方案來確保產生人工智慧模型完全安全和負責任的回應。開發更安全、可解釋和負責任的人工智慧系統仍然是一個活躍的研究領域和持續努力的領域。

由於當前一代法學碩士的下一個令牌預測行為,即使僅稍微修改提示或查詢,該工具產生的文本也可能會出現變化。這意味著用戶可能需要仔細調整提示和查詢以獲得最佳回應。

如果您發現我們的工作有用,請按如下方式引用我們:

@article{ng2023simplyretrieve,

title={SimplyRetrieve: A Private and Lightweight Retrieval-Centric Generative AI Tool},

author={Youyang Ng and Daisuke Miyashita and Yasuto Hoshi and Yasuhiro Morioka and Osamu Torii and Tomoya Kodama and Jun Deguchi},

year={2023},

eprint={2308.03983},

archivePrefix={arXiv},

primaryClass={cs.CL},

journal={arXiv preprint arXiv:2308.03983}

}

️ 隸屬機構:日本鎧俠株式會社記憶技術研究所