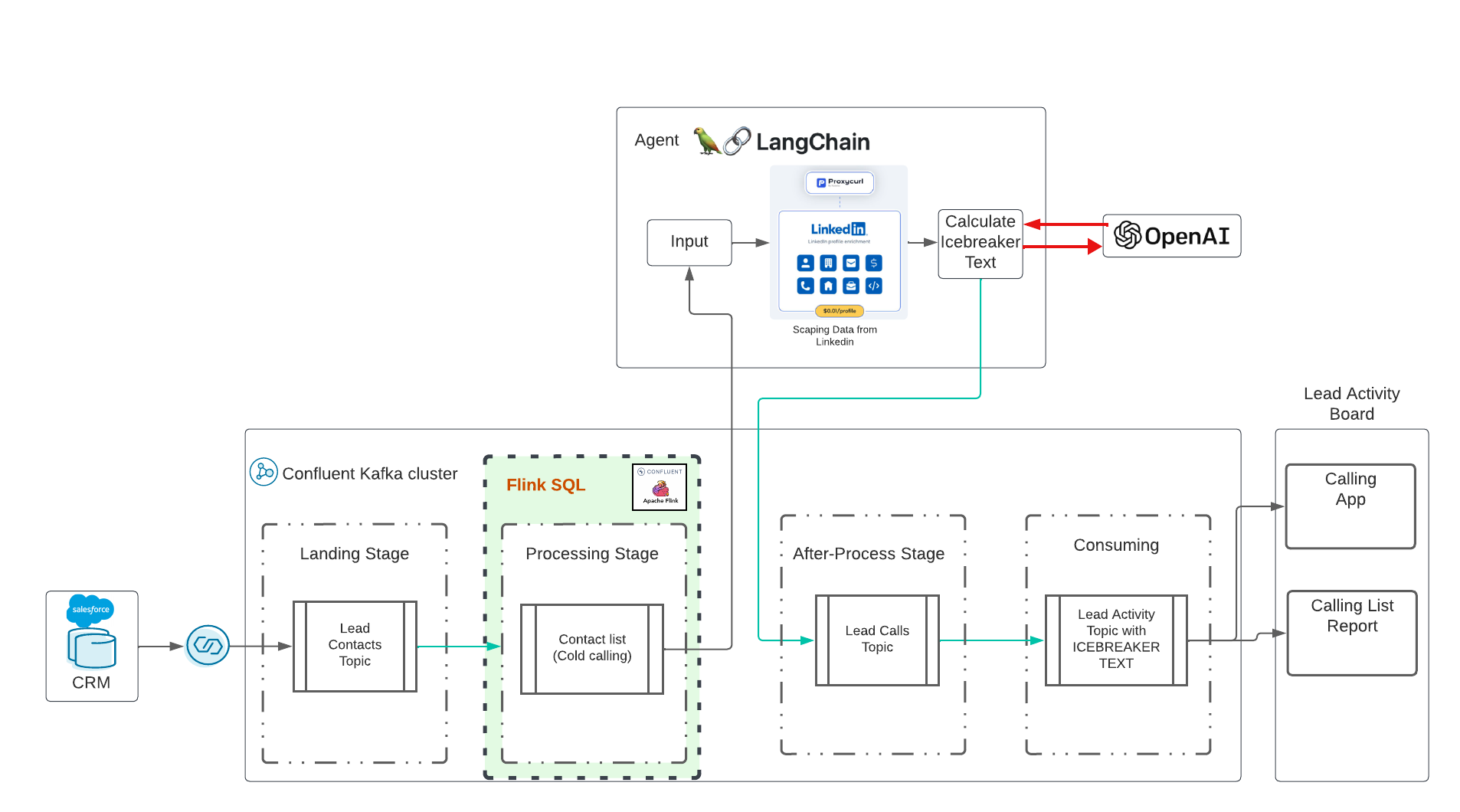

這是使用 Confluence Cloud 的即時生成 AI 演示。這個想法受到 Eden Marco(LangChain- 使用 LangChain 開發 LLM 支援的應用程式)領導的 Udemy 培訓的影響。 Eden Marco 給了我升級連結。 Eden Marco 對 Python 中的 Lngchain LLM 開發做了很好的介紹。我採用了破冰的想法,並將其轉移到使用 Confluence 和 AI 運行 Data in Motion 的真實用例中。

該存儲庫將部署:

請將此存儲庫克隆到您的桌面上:

cd $HOME # or what-ever directory you want to use

git clone https://github.com/ora0600/genai-with-confluent.git

cd genai-with-confluent/terraform/演示執行是完全自動化的,但在執行之前,您需要在此處設定一些內容:

建立 Salesforce 開發人員帳戶 在此註冊 設定 Salesforce CDC,請參閱此處使用螢幕截圖追蹤我的設定 進階步驟:

您需要 Salesforce CDC Connector 的所有參數,因此請安全儲存它們。

您需要一個 Confluence Cloud 的工作帳戶。註冊 Confluence Cloud 非常簡單,首次試用時您將獲得 400 美元的免費預算。如果您沒有可用的 Confluence Cloud 帳戶,請註冊 Confluence Cloud。

pip3 install confluent_kafka

pip3 install requests

pip3 install fastavro

pip3 install avro

pip3 install jproperties

pip3 install langchain

pip3 install openai

pip3 install langchain_openai

pip3 install -U langchain-community

pip3 install google-search-results

pip3 install Flask

pip3 install langchain_core

pip3 install pydantic對於 Confluence Cloud:透過 CLI 在 Confluence Cloud 中建立 API 金鑰:

confluent login

confluent api-key create --resource cloud --description " API for terraform "

# It may take a couple of minutes for the API key to be ready.

# Save the API key and secret. The secret is not retrievable later.

# +------------+------------------------------------------------------------------+

# | API Key | <your generated key> |

# | API Secret | <your generated secret> |

# +------------+------------------------------------------------------------------+透過使用您的資料執行以下命令,將 Confluence Cloud 的所有參數複製到terraform.tfvars檔案中:

cat > $PWD /terraform/terraform.tfvars << EOF

confluent_cloud_api_key = "{Cloud API Key}"

confluent_cloud_api_secret = "{Cloud API Key Secret}"

sf_user= "salesforce user"

sf_password = "password"

sf_cdc_name = "LeadChangeEvent"

sf_password_token = "password token"

sf_consumer_key = "consumer key of connected app"

sf_consumer_secret = "consumer secret of connect app"

EOFTerraform 將取得所有這些參數並為您進行配置,並最終部署所有融合的雲端資源,包括服務帳戶和角色綁定。

我們使用langchain LLM版本0.1 Langchain Docu

暗示:

| 現在,這需要花錢。不幸的是,API 不是免費的。我花費 10 美元開放 AI,10 美元用於 ProxyCurl API,SERP API 仍處於免費狀態。 |

首先我們需要一個允許我們使用 OpenAI 的金鑰。請依照此處的步驟建立帳戶,然後僅建立 API 金鑰。

下一個任務:建立 proxycurl api 金鑰。 ProxyCurl 將用於抓取 Linkedin。註冊 proxyurl 並以 10 美元購買積分(或任何您認為足夠的東西,也許您開始更多更少),請按照以下步驟操作

為了能夠在 Google 中搜尋正確的 linkedin 設定檔 URL,我們需要此處的 SERP API 的 API 金鑰。

現在,透過執行以下命令將所有密鑰放入env-vars檔案中:

cat > $PWD /terraform/env.vars << EOF

export PYTHONPATH=/YOURPATH

export OPENAI_API_KEY=YOUR openAI Key

export PROXYCURL_API_KEY=YOUR ProxyURL Key

export SERPAPI_API_KEY=Your SRP API KEy

EOF恭喜你準備工作已經完成。我知道,這是一個巨大的設定。

現在是簡單的部分。只需執行 terraform 即可。執行 terraform,所有 Confluence 雲端資源將自動部署:

cd terraform

terraform init

terraform plan

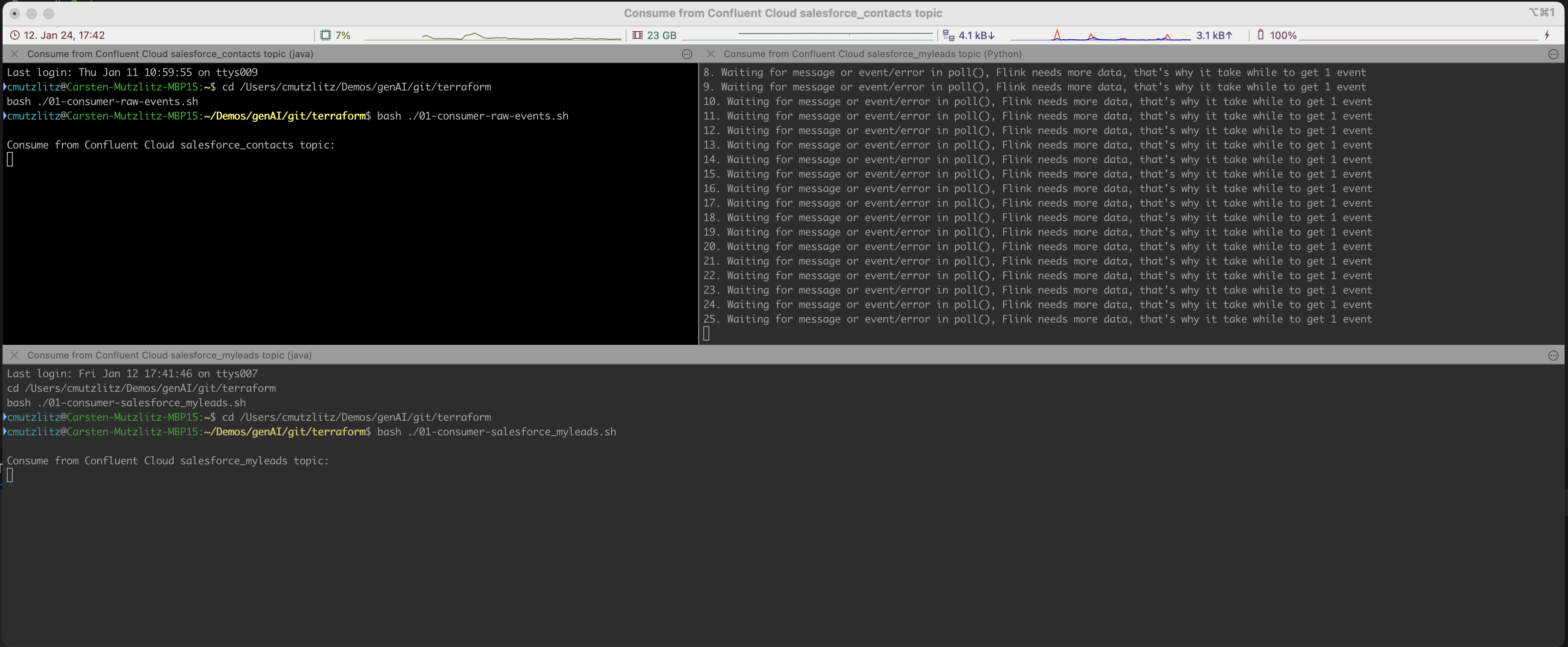

terraform apply這需要一段時間。將提供 Confluence 雲端資源。如果這樣做,iterm2 終端將自動開啟並執行三個服務。

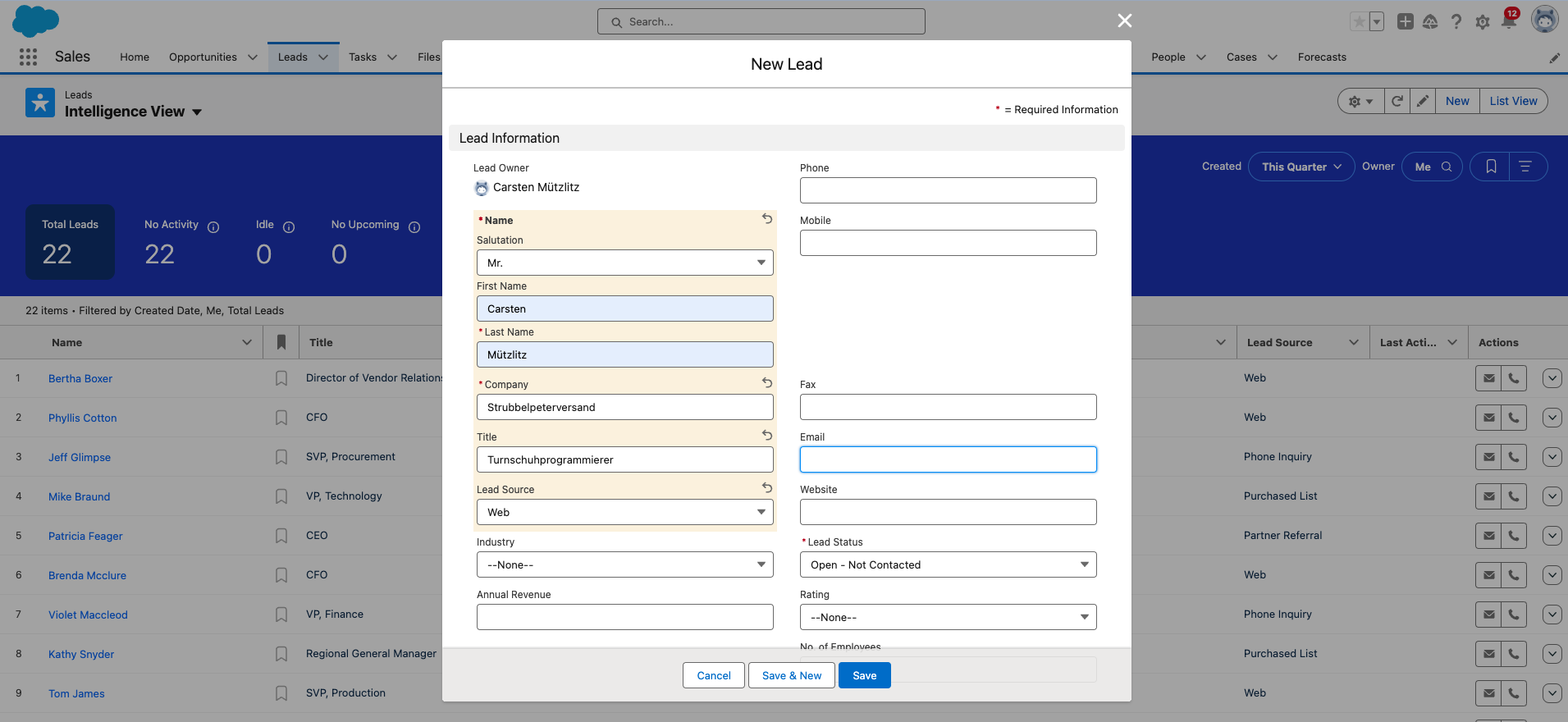

好的,現在您需要將新的潛在客戶新增至 Salesforce 中。這是最後一個手動步驟。

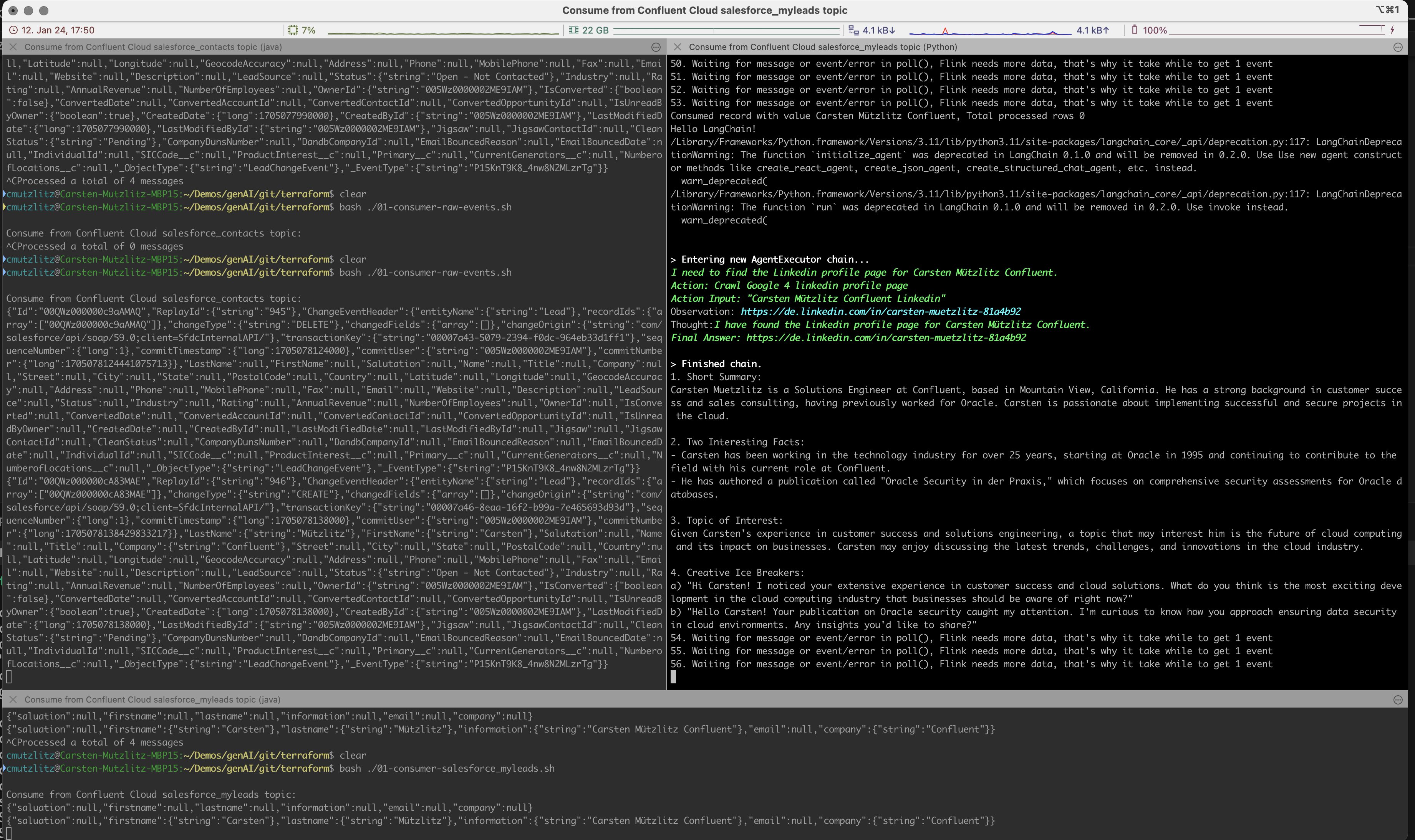

生成式人工智慧將從 Kafka 叢集中獲取新的領導者,並透過從 Linkedin 獲取資訊並自動即時執行提示來執行 LLM 操作。

該提示將被視為Chatgpt的任務,我們制定了C>hatgpt應制定以下內容:

我們在此演示中運行chatgpt-3.5-turbo模型。該模型的代幣有限,但是目前最快、最古老的模型。當然還有最便宜的。如果您嘗試使用 Kai Waehner 作為 Lead,那麼您會發現當前模型的代幣不夠。你能做的就是改變模型。這是最簡單的方法,另一種方法是將內容分割成區塊。請查看當前型號以檢查每個型號的代幣數量。

我從我的測試開始:

model_name="gpt-4-turbo"並重新啟動客戶端。在我看來,這個簡單的演示並不是檢索增強生成 (RAG) 模式的用例。我們從給定的 API 獲取所有信息,將資料儲存到向量資料庫中是沒有意義的。透過API即時載入資訊比新鮮資料要高效得多。為您的用例使用正確的模型,在我們的例子中,它應該是具有更高數量代幣的快速模型。

Salesforce 已重設您的密碼,您需要不時更改它。如果您更改密碼,您還會獲得新的密碼安全令牌。請不要忘記在terraform.tfvars檔案中更改此設定。

如果完成,您可以使用 CTRL+c 停止終端中的程式並銷毀 Confluence Cloud 中的所有內容:

terraform destroy如果發生錯誤,再次執行destroy,直到所有內容都被刪除,那麼您就可以確定沒有資源在運行並消耗成本。

terraform destroy您需要一個 Confluence 雲端帳戶(新帳戶免費獲得 400 美元積分)。您需要一個具有當前信用額度的 OPenAI 帳戶。您需要一個具有當前積分的 ProxyCurl API 帳戶。您需要 SERP API 帳戶,在這裡您將獲得起始連線數。這對我來說就足夠了。

我總共花了 20 美元(Open AI、ProxyCurl),但我仍然沒有用完積分。