onnx-web

onnx-web 旨在簡化運行穩定擴散和其他 ONNX 模型的過程,以便您可以專注於製作高品質、高解析度的藝術品。憑藉 AMD 和 Nvidia GPU 上的硬體加速效率,並提供可靠的 CPU 軟體回退,它可以在桌上型電腦、筆記型電腦和多 GPU 伺服器上提供完整的功能集,並提供無縫的用戶體驗。

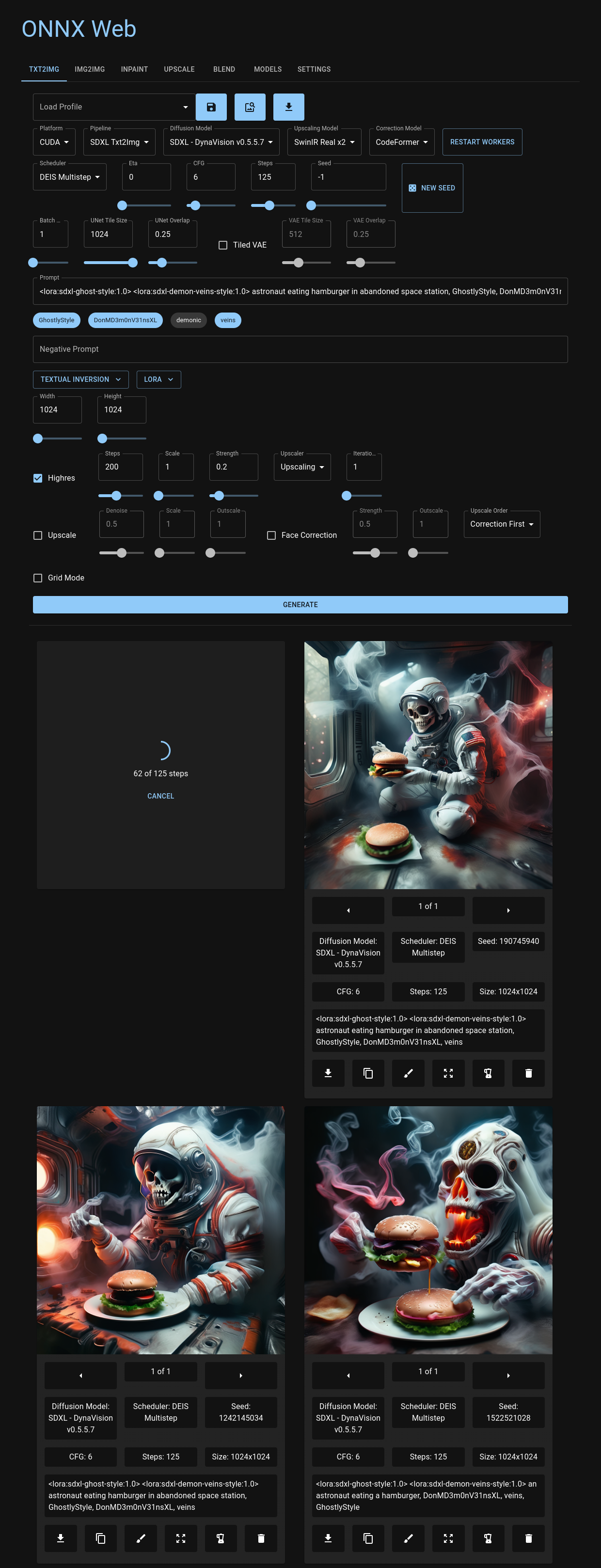

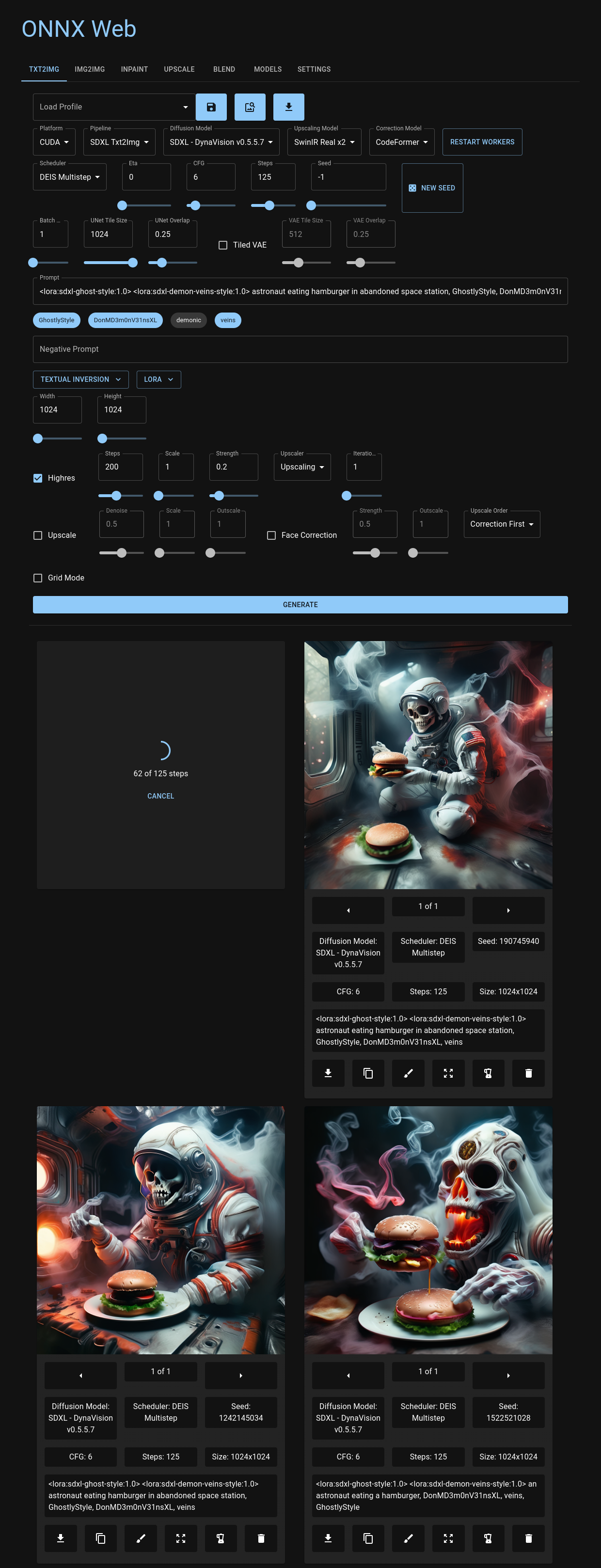

您可以透過使用者友好的 Web UI 進行導航,該 UI 託管在 Github Pages 上,並且可以透過所有主要瀏覽器(包括您的首選行動裝置)進行存取。在這裡,您可以靈活地為每個影像管道選擇擴散模型和加速器,並輕鬆存取定義每個模式的影像參數。無論您是上傳圖像還是透過修復和修復來表達您的藝術風格,onnx-web 都提供了一個用戶友好且功能強大的環境。最近的輸出影像整齊地呈現在控制項下方,作為重新存取先前的參數或重新混合先前的輸出的方便的視覺參考。

透過其 API 深入了解 onnx-web 體驗,該 API 與 Linux 和 Windows 相容。這個 RESTful 介面無縫整合了 HuggingFace 擴散器庫中的各種管道,提供有關模型和加速器的寶貴元數據,以及創意運行的詳細輸出。

使用 onnx-web 踏上您的生成藝術之旅,並透過我們詳細的文件網站探索其功能。尋找全面的入門指南、設定指南和使用者指南,為您的創意事業提供支援!

請查看文件網站以獲取更多資訊:

特徵

這是新的和有趣的功能的不完整列表:

- 支援 SDXL 和 SDXL Turbo

- 各種調度程序:DDIM、DEIS、DPM SDE、Euler Ancestral、LCM、UniPC 等

- AMD 和 Nvidia 的硬體加速

- 在 CUDA、DirectML 和 ROCm 上進行了測試

- AMD 和 Nvidia 上對低記憶體 GPU 的半精度支持

- 僅 CPU 系統的軟體回退

- 用於生成和檢視圖像的 Web 應用程式

- 託管在 Github Pages、CDN 或本地

- 當您更改選項卡時保留您最近的圖像和進度

- 將多個圖像排隊並重試錯誤

- 提供英語、法語、德語和西班牙語翻譯(請打開一個問題以獲取更多資訊)

- 支援許多

diffusers管道- txt2img

- 影像2影像

- 修復,帶有遮罩繪製並上傳

- 全景,適用於 SD v1.5 和 SDXL

- 透過 ONNX 加速進行升級

- 添加並使用您自己的模型

- 從擴散器和 SD 檢查點轉換模型

- 從 HuggingFace hub、Civitai 和 HTTPS 來源下載模型

- 融入額外的網絡

- 永久和基於提示的混合

- 支援 LoRA 和 LyCORIS 權重

- 支援文本倒置概念和嵌入

- 控制網

- 用於邊緣偵測和其他方法的影像濾波器

- 具有 ONNX 加速

- 高解析度模式

- 對其他管道的結果運行 img2img

- 多次迭代可以產生 8k 影像及更大的影像

- 多階段和區域提示

- 在同一張影像中無縫組合多個提示

- 為影像中的不同區域提供提示並將它們混合在一起

- 更改高解析度模式的提示並細化細節而無需遞歸

- 無限提示長度

- 影像混合模式

- 放大和校正

- 使用 Real ESRGAN、SwinIR 和穩定擴散進行升級

- 使用 CodeFormer 和 GFPGAN 進行臉部校正

- API伺服器可以遠端執行

- REST API 可以透過 HTTPS 或 HTTP 提供服務

- 所有影像管道的後台處理

- 輪詢圖像狀態,與負載平衡器配合良好

- 提供 OCI 容器

- 對於所有支援的硬體加速器

- 將 API 和 GUI 包包含在一個容器中

- 在 RunPod、Vast.ai 和其他 GPU 容器託管服務上運作良好

內容

設定

運行 onnx-web 有幾種方法:

- 跨平台:

- 複製此儲存庫,建立虛擬環境,然後執行

pip install - 拉取並運行 OCI 容器

- 在 Windows 上:

- 克隆此儲存庫並執行

setup-*.bat腳本之一 - 下載並運行實驗性一體化捆綁包

您只需要運行伺服器,不需要編譯任何東西。用戶端 GUI 託管在 Github Pages 上,並包含在 Windows 一體化捆綁包中。

擴充設定文件已移至設定指南。

新增您自己的模型

您可以透過從 HuggingFace Hub 或 Civitai 下載或從本機檔案轉換它們來新增自己的模型,而無需進行任何程式碼變更。您還可以使用提示中的標記下載並混合其他網絡,例如 LoRA 和文字反轉。

用法

已知錯誤及解決方案

請參閱使用者指南的已知錯誤部分。

運行容器

這已移至伺服器管理指南。

製作人員

一些轉換和管道代碼是從以下程式碼複製或派生的:

-

Amblyopius/Stable-Diffusion-ONNX-FP16- GPL v3:https://github.com/Amblyopius/Stable-Diffusion-ONNX-FP16/blob/main/LICENSE

- https://github.com/Amblyopius/Stable-Diffusion-ONNX-FP16/blob/main/pipeline_onnx_stable_diffusion_controlnet.py

- https://github.com/Amblyopius/Stable-Diffusion-ONNX-FP16/blob/main/pipeline_onnx_stable_diffusion_instruct_pix2pix.py

-

d8ahazard/sd_dreambooth_extension- 非商業授權:https://github.com/d8ahazard/sd_dreambooth_extension/blob/main/license.md

- https://github.com/d8ahazard/sd_dreambooth_extension/blob/main/dreambooth/sd_to_diff.py

-

huggingface/diffusers- Apache v2:https://github.com/huggingface/diffusers/blob/main/LICENSE

- https://github.com/huggingface/diffusers/blob/main/scripts/convert_stable_diffusion_checkpoint_to_onnx.py

-

uchuusen/onnx_stable_diffusion_controlnet- GPL v3:https://github.com/uchiusen/onnx_stable_diffusion_controlnet/blob/main/LICENSE

-

uchuusen/pipeline_onnx_stable_diffusion_instruct_pix2pix- Apache v2:https://github.com/uchuusen/pipeline_onnx_stable_diffusion_instruct_pix2pix/blob/main/LICENSE

這些部分有自己的許可證,並對商業使用、修改和重新分發有附加限制。該專案的其餘部分是在 MIT 許可證下提供的,我正在努力將這些元件隔離到一個庫中。

將穩定擴散與硬體加速結合使用還有許多其他不錯的選擇,包括:

- https://github.com/Amblyopius/AMD-Stable-Diffusion-ONNX-FP16

- https://github.com/azuritecoin/OnnxDiffusersUI

- https://github.com/ForserX/StableDiffusionUI

- https://github.com/pingzing/stable-diffusion-playground

- https://github.com/quickwick/stable-diffusion-win-amd-ui

如果沒有以下人員的指導,就不可能在 AMD 上進行此設定並運行:

- https://gist.github.com/harishanand95/75f4515e6187a6aa3261af6ac6f61269

- https://gist.github.com/averad/256c507baa3dcc9464203dc14610d674

- https://github.com/AUTOMATIC1111/stable-diffusion-webui/wiki/Install-and-Run-on-AMD-GPUs

- https://www.travelneil.com/stable-diffusion-updates.html