Reversal of Thought

1.0.0

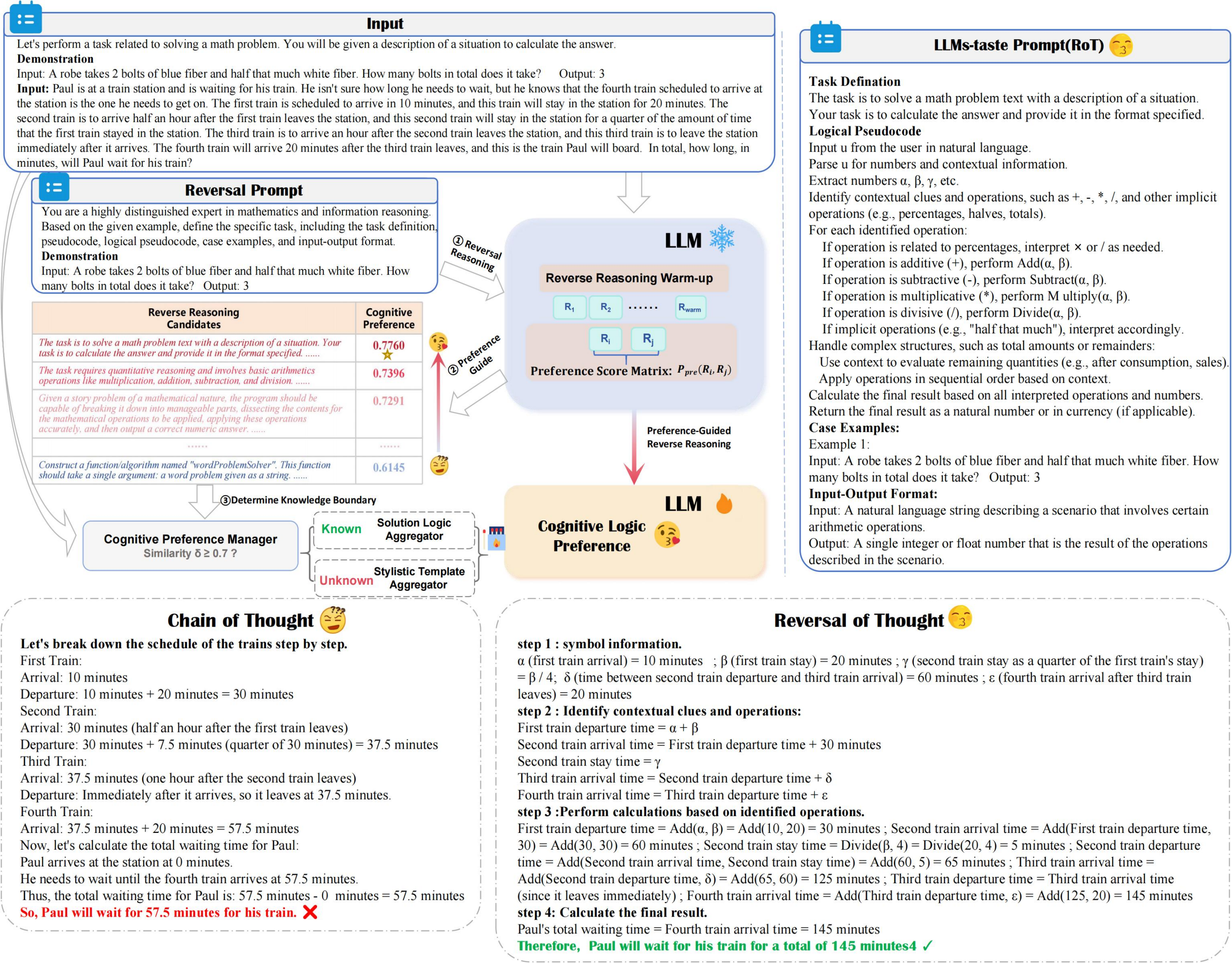

ROT提高了推理的準確性和效率,同時最大程度地降低了計算成本,利用偏好引導的反向推理以及認知偏好管理器以最佳的方式探索具有認知偏好的LLM推理。

??? reversal_demo.py

from utils . llm_utils import *

from utils . prompt import *

pipeline = Pipeline ( model_id = model_id , base_url = base_url , api_key = api_key , prob = True )

demos = "Input:... Output:..." #Suggest 2-shot Demos

llm_taste = rot_pipeline ( pipeline , reversal_of_thought , demos = demos , warmup = 5 )增強任務解決方案的LLM偏愛提示

提示提示與LLM偏愛的策略保持一致,從而優化任務解決效率。

創建各種質量檢查數據集的潛力

生成各種問答對,以改善數據集多樣性。

如果您發現我們的工作對您的研究很有用,請請我們的論文如下:

@article { yuan2024reversal ,

title = { Reversal of Thought: Enhancing Large Language Models with Preference-Guided Reverse Reasoning Warm-up } ,

author = { Yuan, Jiahao and Du, Dehui and Zhang, Hao and Di, Zixiang and Naseem, Usman } ,

journal = { arXiv preprint arXiv:2410.12323 } ,

year = { 2024 }

}