這是通過人類反饋(RLHF)進行增強學習的研究論文的集合。並將不斷更新存儲庫,以跟踪RLHF的前沿。

歡迎跟隨和明星!

很棒的RLHF(帶有人類反饋的RL)

2024

2023

2022

2021

2020年及以前

詳細的解釋

目錄

RLHF的概述

文件

代碼庫

數據集

部落格

其他語言支持

貢獻

執照

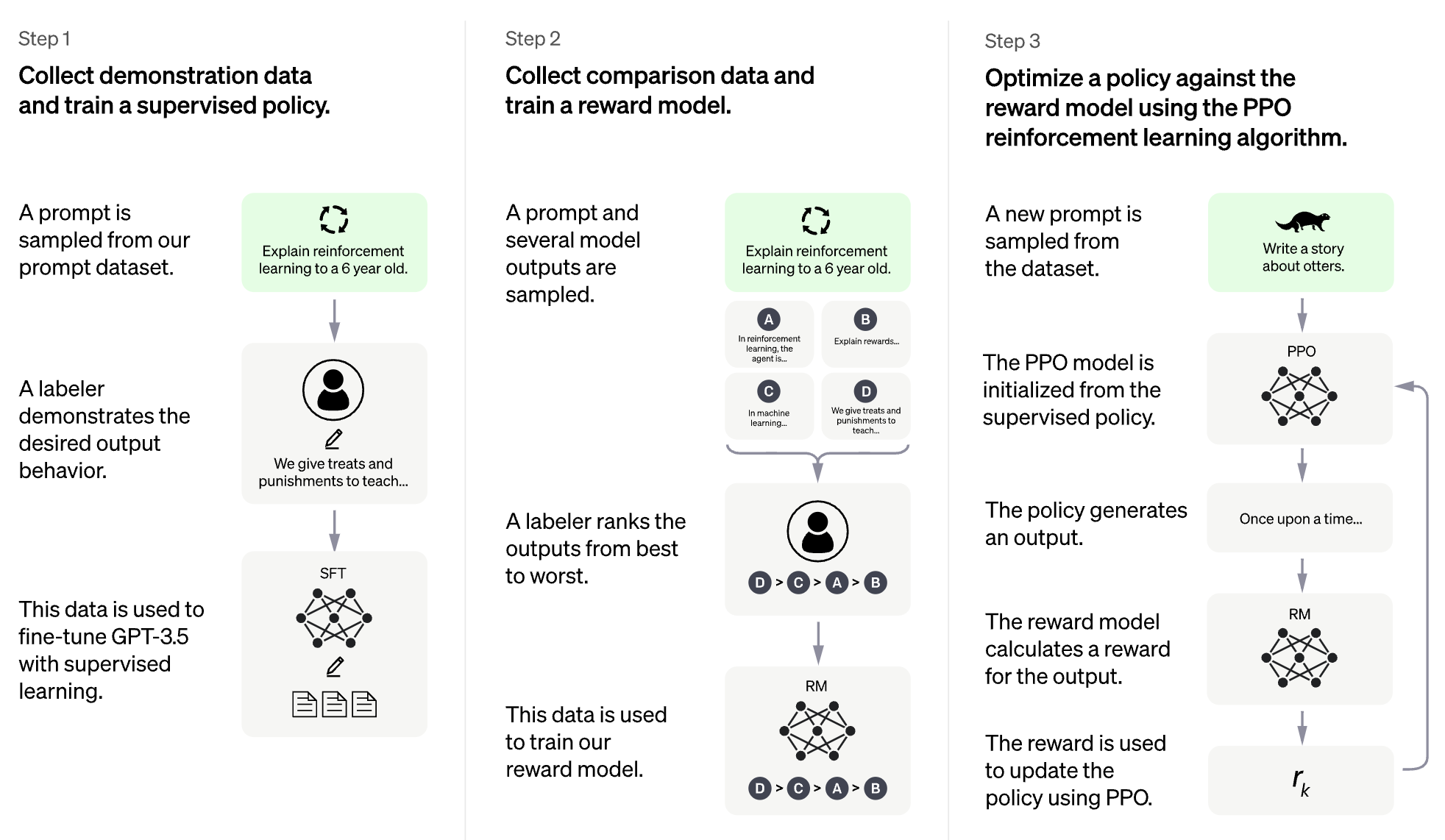

RLHF的想法是使用增強學習中的方法直接優化人類反饋的語言模型。 RLHF使語言模型能夠開始使對文本數據的一般語料庫進行訓練的模型與復雜的人類價值觀的模型。

大型語言模型(LLM)的RLHF

視頻遊戲的RLHF(例如Atari)

(以下部分是由Chatgpt自動生成的)

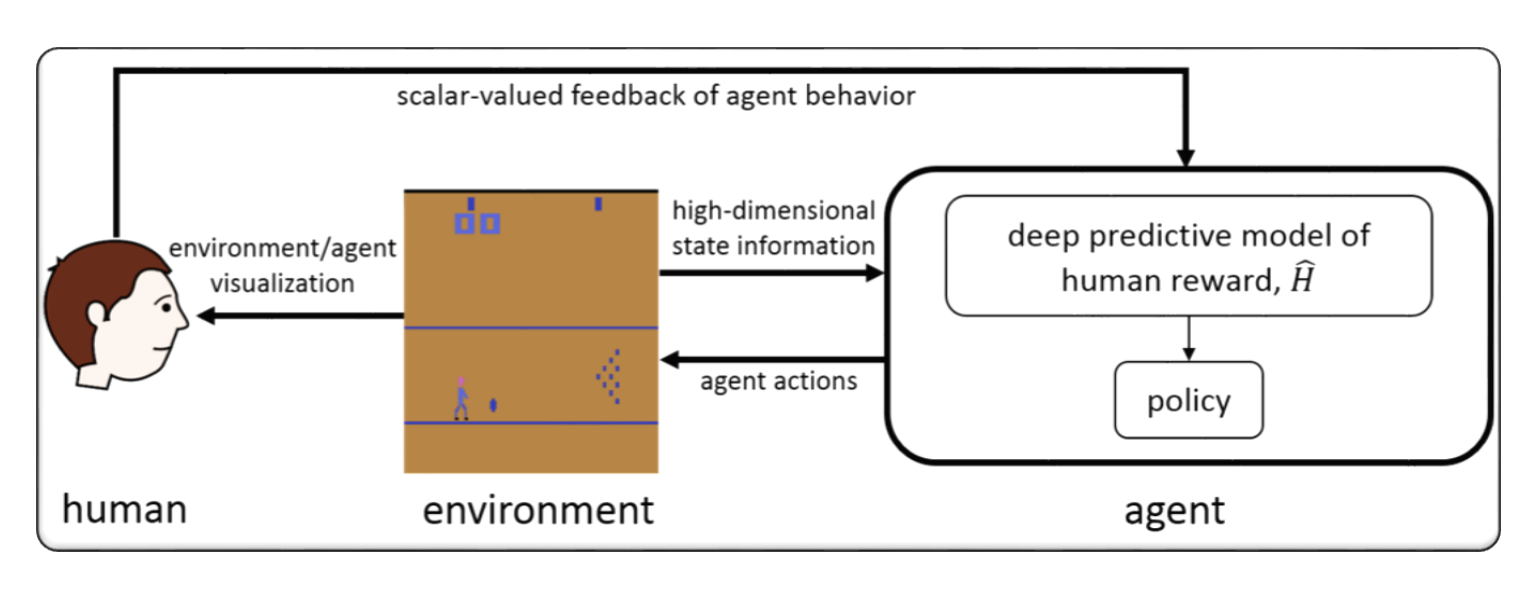

RLHF通常是指“通過人類反饋進行加強學習”。增強學習(RL)是一種機器學習,涉及培訓代理商根據環境的反饋做出決策。在RLHF中,代理商還以評級或評估其行動的形式從人類那裡收到反饋,這可以幫助其更快,準確地學習。

RLHF是人工智能中的一個活躍研究領域,在機器人技術,遊戲和個性化推薦系統等領域中進行了應用。它試圖解決RL在代理商中從環境中獲得反饋的有限訪問,並要求人類投入以提高其績效的情況。

通過人類反饋(RLHF)的增強學習是人工智能研究的快速發展領域,並且已經開發了幾種先進的技術來提高RLHF系統的性能。這裡有一些例子:

Inverse Reinforcement Learning (IRL) :IRL是一種使代理商從人類反饋中學習獎勵功能的技術,而不是依靠預定義的獎勵功能。這使得代理可以從更複雜的反饋信號中學習,例如所需行為的演示。

Apprenticeship Learning :學徒學習是一種將IRL與監督學習相結合的技術,使代理商能夠從人類的反饋和專家演示中學習。這可以幫助代理商更快,有效地學習,因為它能夠從正面和負面反饋中學習。

Interactive Machine Learning (IML) :IML是一種涉及代理商與人類專家之間積極互動的技術,使專家可以實時就代理商的行動提供反饋。這可以幫助代理商更快,更有效地學習,因為它可以在學習過程的每個步驟中都會收到有關其行動的反饋。

Human-in-the-Loop Reinforcement Learning (HITLRL) :HITLRL是一種技術,涉及將人類的反饋在多個級別的RL過程中,例如獎勵成型,行動選擇和政策優化。這可以通過利用人類和機器的優勢來幫助提高RLHF系統的效率和有效性。

以下是人類反饋(RLHF)的加強學習的例子:

Game Playing :在遊戲中,人類反饋可以幫助代理商學習在不同遊戲方案中有效的策略和策略。例如,在流行的GO遊戲中,人類專家可以為代理商提供反饋,以幫助其改善其遊戲玩法和決策。

Personalized Recommendation Systems :在推薦系統中,人類反饋可以幫助代理商學習單個用戶的偏好,從而可以提供個性化的建議。例如,代理可以使用用戶對推薦產品的反饋來了解哪些功能對他們最重要。

Robotics :在機器人技術中,人類反饋可以幫助代理商學習如何以安全有效的方式與物理環境互動。例如,機器人可以通過人類操作員的反饋在最佳採取途徑或避免哪些對象的情況下從人類操作員那裡進行反饋,從而更快地瀏覽新環境。

Education :在教育方面,人類反饋可以幫助代理商學習如何更有效地教學學生。例如,基於人工智能的導師可以使用教師的反饋,其中教學策略與不同的學生最有效,從而幫助個性化學習經驗。

format: - [title](paper link) [links] - author1, author2, and author3... - publisher - keyword - code - experiment environments and datasets

混合流:靈活有效的RLHF框架

廣明尚恩,奇張,Zilingfeng Ye,Xibin Wu,Wang Zhang,Ru Zhang,Yanghua Peng,Haibin Lin,Chuan Wu

關鍵字:靈活,高效,RLHF框架

代碼:官方

警報:通過分層獎勵建模對齊語言模型

Yuhang Lai,Siyuan Wang,Shujun Liu,Xuanjing Huang,Zhongyu Wei

關鍵字:分層獎勵,開放文本生成任務

代碼:官方

TLCR:代幣級別的連續獎勵,以從人類反饋中學習細粒度的增強

Eunseop Yoon,Hee Suk Yoon,Soohwan Eom,Gunsoo Han,Daniel Wontae Nam,Daejin Jo,Kyoung-woon,Mark A. A. Hasegawa-Johnson,Sungwoong Kim,Chang D. Yoo

關鍵字:令牌級的連續獎勵,RLHF

代碼:官方

將大型多模型與實際增強的RLHF對齊

Zhiqing Sun,Sheng Shen,Shengcao Cao,Haotian Liu,Chunyuan Li,Yikang Shen,Chuang Gan,Liang-Yan Gui,Yu-Xiong Wang,Yiming Yang,Kurt Keutzer,Trevor Darrell,Trevor Darrell,Trevor Darrell

關鍵字:實際增強RLHF,視覺和語言,人類偏好數據集

代碼:官方

通過自我獎勵對比迅速蒸餾來指導大型語言模型對齊

aiwei liu,haoping bai,Zhiyun Lu,Xiang Kong,Simon Wang,Jiulong Shan,Meng Cao,Lijie Wen

關鍵字:沒有人類偏好數據,自我獎勵,DPO

代碼:官方

對不同用戶偏好的LLM的算術控制:多目標獎勵的定向偏好對齊

Haoxiang Wang,Yong Lin,Wei Xiong,Rui Yang,Shizhe Diao,Shuang Qiu,Han Zhao,Tong Zhang

關鍵字:用戶偏好,多目標獎勵模型,拒絕採樣填充

代碼:官方

返回基礎知識:重新審核風格優化,以從LLMS中的人類反饋中學習

Arash Ahmadian,Chris Cremer,MatthiasGallé,Marzieh Fadaee,Julia Kreutzer,Olivier Pietquin,Ahmetüstün,Sara Hooker

關鍵字:在線RL優化,低計算成本

代碼:官方

通過細粒度的增強學習來改善大型語言模型,並使用最小的編輯約束

Zhipeng Chen,Kun Zhou,Wayne Xin Zhao,Junchen Wan,Fuzheng Zhang,Di Zhang,Ji-Rong Wen

關鍵字:令牌級獎勵,法學碩士

代碼:官方

RLAIF與RLHF:通過AI反饋從人類反饋中縮放增強加固

Harrison Lee,Samrat Phatale,Hassan Mansoor,Thomas Mesnard,Johan Ferret,Kellie Ren Lu,Colton Bishop,Ethan Hall,Victor Carbune,Abhinav Rastogi,Sushant Prakash,Sushant Prakash

關鍵字:來自AI反饋的RL

代碼:官方

用於雙桿鋼筋學習和RLHF的原則基於罰款的方法

漢山,楊楊,蒂亞尼·陳

關鍵字:二元優化

代碼:官方

從人類反饋中獲得強化學習的免費獎勵

Alex James Chan,Hao Sun,Samuel Holt,Mihaela van der Schaar

關鍵字:獎勵成型,RLHF

代碼:官方

一種最小化的方法來加強人類反饋學習

Gokul Swamy,Christoph Dann,Rahul Kidambi,Steven Wu,Alekh Agarwal

關鍵字:Minimax獲勝者,自我播放優先優化

代碼:官方

RLHF-V:通過細粒度懲教的行為對齊人的行為對准人類反饋,向值得信賴的MLLM

Tianyu Yu,Yuan Yao,Haoye Zhang,Taiwen HE,Yifeng Han,Ganqu Cui,Jinyi Hu,Jhiyuan Liu,Hai-Tao Zheng,Maosong Sun,Tat-Seng Chua

關鍵字:多模式大語模型,幻覺問題,從人類反饋中學習的增強

代碼:官方

RLHF工作流程:從獎勵建模到在線RLHF

Hanze Dong,Wei Xiong,Bo Pang,Haoxiang Wang,Han Zhao,Yingbo Zhou,Nan Jiang,Doyen Sahoo,Caiming Ximing Xiong,Tong Zhang

關鍵字:在線迭代RLHF,偏好建模,大語言模型

代碼:官方

MAXMIN-RLHF:朝著具有多種人類偏好的大型語言模型的公平對準

Souradip Chakraborty,Jiahao Qiu,Hui Yuan,Alec Koppel,Furong Huang,Dinesh Manocha,Amrit Singh Bedi,Mengdi Wang

關鍵字:偏好分佈的混合物,maxmin對齊目標

代碼:官方

RLHF的數據集重置策略優化

Jonathan D. Chang,Wenhao Zhan,Owen Oertell,KiantéBrantley,Dipendra Misra,Jason D. Lee,Wen Sun

關鍵字:數據集重置策略優化

代碼:官方

關於將文本到圖像擴散與偏好結合的密集獎勵觀點

Shentao Yang,Tianqi Chen,Mingyuan Zhou

關鍵字:用於文本到圖像生成的RLHF,DPO的密集獎勵改進,有效的一致性

代碼:官方

自我播放微調將弱語言模型轉換為強語模型

Zixiang Chen,Yihe Deng,Huizhuo Yuan,Kaixuan JI,Quanquan Gu

關鍵字:自我播放微調

代碼:官方

RLHF解密:對LLMS人類反饋的強化學習的批判性分析

Shreyas Chaudhari,Pranjal Aggarwal,Vishvak Murahari,Tanmay Rajpurohit,Ashwin Kalyan,Karthik Narasimhan,Ameet Deshpande,Bruno Castro da Silva

關鍵字:RLHF,Oracular獎勵,獎勵模型分析,調查

面對擴散模型的獎勵過度轉化:歸納和首要偏見的觀點

Ziyi Zhang,Sen Zhang,Yibing Zhan,Yong Luo,Yonggang Wen,Dacheng Tao

關鍵字:擴散模型,一致性,增強學習,RLHF,獎勵過度轉移,首要偏見

代碼:官方

關於大型語言模型一致性的多元化偏好

Dun Zeng,Yong Dai,Pengyu Cheng,Tianhao Hu,Wanshun Chen,Nan Du,Zenglin Xu

關鍵字:對齊共享偏好,獎勵建模指標,LLM

代碼:官方

通過分配偏好獎勵建模對齊人群反饋

Dexun Li,Cong Zhang,Kuicai Dong,Derrick Goh Xin Deik,Ruiming Tang,Yong Liu

關鍵字:RLHF,偏好分佈,對齊,LLM

超越一位偏好 - 所有對齊方式:多目標直接偏好優化

Zhanhui Zhou,Jie Liu,Chao Yang,Jing Shao,Yu Liu,Xiangyu Yue,Wanli Ouyang,Yu Qiao

關鍵字:無獎勵建模的多目標RLHF,DPO

代碼:官方

模擬的不對準:大語言模型的安全一致性可能適得其反!

Zhanhui Zhou,Jie Liu,Zhichen Dong,Jiaheng Liu,Chao Yang,Wanli Ouyang,Yu Qiao

關鍵字:LLM推理時間攻擊,DPO,在沒有培訓的情況下產生有害的LLM

代碼:官方

在一般KL規範化的偏好下,對人類反饋的NASH學習的理論分析

Chenlu Ye,Wei Xiong,Yuheng Zhang,Nan Jiang,Tong Zhang

關鍵字:基於遊戲的RLHF,NASH學習,無獎勵模式下的對齊方式

減輕RLHF的對齊稅

Yong Lin,Hangyu Lin,Wei Xiong,Shizhe Diao,Jianmeng Liu,Jipeng Zhang,Rui Pan,Haoxiang Wang,Wenbin Hu,Wenbin Hu,Hanning Zhang,Hanze Dong,Hanze Dong,Renjie Pi,Renjie Pi,Han Zhao,Han Zhao ,Nan Jiang,Heng Jiang,Heng Ji,Yuan Yao,Tong Yao,Tonn Yao,Tonn Yao,Tonn Yao,Tonn Yao,Tonn Yao,Tonn Yao,Tonn Yao,Tonn Yao,Tonn Yao,Tonn Yao,Tonn Yao

關鍵字:RLHF,對準稅,災難性遺忘

通過增強學習的培訓擴散模型

凱文·布萊克(Kevin Black),邁克爾·詹納(Michael Janner),伊隆·杜(Yilun du),伊利亞·科斯特里科夫(Ilya Kostrikov),謝爾蓋·萊文

關鍵字:增強學習,RLHF,擴散模型

代碼:官方

ALIGNDIFF:通過行為可定制的擴散模型對齊人類的偏好

Zibin Dong,Yifu Yuan,Jianye Hao,Fei Ni,Yao Mu,Yan Zheng,Yujing Hu,Tangjie LV,Changjie Fan,Zhipeng Hu

關鍵字:增強學習;擴散模型; rlhf;偏好對齊

代碼:官方

從人類反饋中獲得強化學習的免費獎勵

Alex J. Chan,Hao Sun,Samuel Holt,Mihaela van der Schaar

關鍵字:RLHF

代碼:官方

轉換和結合獎勵,以使大語模型對齊

Zihao Wang,Chirag Nagpal,Jonathan Berant,Jacob Eisenstein,Alex D'Amour,Sanmi Koyejo,Victor Veitch

關鍵字:RLHF,Aligning,LLM

參數有效的強化從人類反饋中學習

Hakim Sidahmed, Samrat Phatale, Alex Hutcheson, Zhuonan Lin, Zhang Chen, Zac Yu, Jarvis Jin, Simral Chaudhary, Roman Komarytsia, Christiane Ahlheim, Yonghao Zhu, Bowen Li, Saravanan Ganesh, Bill Byrne, Jessica Hoffmann, Hassan Mansoor, Wei Li ,Abhinav Rastogi,Lucas Dixon

關鍵字:RLHF,參數有效方法,低計算成本,LLM,VLM

通過有效的獎勵模型合奏改善從人類反饋中的強化學習

Shun Zhang,Zhenfang Chen,Sunli Chen,Yikang Shen,Zhiqing Sun,Chuang Gan

關鍵字:RLHF,獎勵合奏,高效的合奏方法

一般理論範式了解人類偏好的學習

Mohammad Gheshlaghi Azar,Mark Rowland,Bilal Piot,Daniel Guo,Daniele Calandriello,Michal Valko,RémiMunos

關鍵字:RLHF,成對偏好

細粒度的人類反饋為語言模型培訓提供了更好的獎勵

Zeqiu Wu,Yushi Hu,Weijia Shi,Nouha Dziri,Alane Suhr,Prithviraj Ammanabrolu,Noah A. Smith,Mari Ostendorf,Hannaneh Hajishirzi

關鍵字:RLHF,句子級獎勵,LLM

代碼:官方

偏好的令牌級別的語言模型指南微調

Shentao Yang,Shujian Zhang,Tengying Xia,Yihao Feng,Caiming Xiong,Mingyuan Zhou

關鍵字:RLHF,令牌級培訓指南,替代/在線培訓框架,簡約培訓目標

代碼:官方

奇妙的獎勵以及如何馴服它們:關於以任務為導向的對話系統獎勵學習的案例研究

Yihao Feng*,Shentao Yang*,Shujian Zhang,Jianguo Zhang,Caiming Xiong,Mingyuan Zhou,Huan Wang

關鍵字:RLHF,Genalized獎勵功能學習,獎勵功能利用,面向任務的對話系統,學習到級別

代碼:官方

反向偏好學習:基於偏好的RL沒有獎勵功能

Joey Hejna,Dorsa Sadigh

關鍵字:反向偏好學習,沒有獎勵模型

代碼:官方

Alpacafarm:從人類反饋中學習的方法的模擬框架

Yann Dubois,Chen Xuechen Li,Rohan Taori,Tianyi Zhang,Ishaan Gulrajani,Jimmy BA,Carlos Guestrin,Percy S. Liang,Tatsunori B. Hashimoto

關鍵字:RLHF,仿真框架

代碼:官方

對人類對齊的優先排名優化

Feifan Song,Bowen Yu,Minghao Li,Haiyang Yu,Fei Huang,Yongbin Li,Houfeng Wang

關鍵字:偏好排名優化

代碼:官方

對抗偏好優化

Pengyu Cheng,Yifan Yang,Jian Li,Yong Dai,Nan Du

關鍵字:RLHF,GAN,對抗遊戲

代碼:官方

從人類反饋中學習的迭代偏好:rlhf的橋接理論和實踐

Wei Xiong,Hanze Dong,Chenlu Ye,Ziqi Wang,Han Zhong,Heng JI,Nan Jiang,Tong Zhang

關鍵字:RLHF,迭代DPO,數學基礎

通過主動探索從人類反饋中採樣有效的加強學習

Viraj Mehta,Vikramjeet Das,Ojash Neopane,Yijia Dai,Ilija Bogunovic,Jeff Schneider,Willie Neiswanger

關鍵字:RLHF,樣本功效,探索

從統計反饋中學習的強化學習:從AB測試到螞蟻測試的旅程

Feiyang Han,Yimin Wei,Zhaofeng Liu,Yanxing Qi

關鍵字:RLHF,AB測試,RLSF

獎勵模型能夠準確分析分配轉移基礎模型的能力的基線分析

Ben Pikus,Will Levine,Tony Chen,Sean Hendryx

關鍵字:RLHF,OOD,分銷班次

通過自然語言的大型語言模型與人類反饋的數據有效對齊

DI Jin,Shikib Mehri,Devamanyu Hazarika,Aishwarya Padmakumar,Sungjin Lee,Yang Liu,Mahdi Namazifar

關鍵字:RLHF,數據效率,對齊方式

讓我們逐步加強

莎拉·潘(Sarah Pan),弗拉迪斯拉夫·萊林(Vladislav Lialin),謝林·馬卡蒂拉(Sherin Muckatira)

關鍵字:RLHF,推理

直接基於偏好的政策優化而無需獎勵建模

Gaon An,Junhyeok Lee,Xingdong Zuo,Norio Kosaka,Kyung-Min Kim,Hyun Oh Song

關鍵字:無獎勵建模,對比度學習,離線再培養費學習的RLHF

ALIGNDIFF:通過行為可定制的擴散模型對齊人類的偏好

Zibin Dong,Yifu Yuan,Jianye Hao,Fei Ni,Yao Mu,Yan Zheng,Yujing Hu,Tangjie LV,Changjie Fan,Zhipeng Hu

關鍵字:RLHF,對齊,擴散模型

尤里卡:通過編碼大語言模型的人級獎勵設計

Yecheng Jason MA,William Liang,Guanzhi Wang,De-An Huang,Osbert Bastani,Dinesh Jayaraman,Yuke Zhu,Linxi粉絲,Anima Anandkumar

關鍵字:基於LLM,獎勵功能設計

安全的RLHF:從人類反饋中學習的安全加固

Josef Dai,Xuehai Pan,Ruiyang Sun,Jiaming JI,Xinbo Xu,Mickel Liu,Yizhou Wang,Yaodong Yang

關鍵字:銷售RL,LLM微型

通過人類反饋的質量多樣性

Li Ding,Jenny Zhang,Jeff Clune,Lee Spector,Joel Lehman

關鍵字:質量多樣性,擴散模型

remax:一種簡單,有效,有效的加強學習方法,用於對齊大語言模型

Ziniu Li,Tian Xu,Yushun Zhang,Yang Yu,Ruoyu Sun,Zhi-Quan Luo

關鍵字:計算效率,差異技術

使用任務獎勵調整計算機視覺模型

AndréSusanoPinto,Alexander Kolesnikov,Yuge Shi,Lucas Beyer,Xiaohua Zhai

關鍵字:計算機視覺中的獎勵調整

事後觀察的智慧使語言模型更好

Tianjun Zhang,Fangchen Liu,Justin Wong,Pieter Abbeel,Joseph E. Gonzalez

關鍵字:事後觀點指令重新標籤,RLHF系統,無需價值網絡

代碼:官方

語言指示人類協調的強化學習

Hengyuan Hu,Dorsa Sadigh

關鍵字:人類協調,人類偏好對準,指示條件的RL

將語言模型與離線強化從人類反饋中學習

Jian Hu,Li Tao,June Yang,Chandler Zhou

關鍵字:基於決策者的對準,離線增強學習,RLHF系統

對人類對齊的優先排名優化

Feifan Song,Bowen Yu,Minghao Li,Haiyang Yu,Fei Huang,Yongbin Li和Houfeng Wang

關鍵字:受監督的人類偏好一致性,偏好排名擴展

代碼:官方

彌合差距:一項關於自然語言產生(人)反饋的調查

帕特里克·費爾南德斯(Patrick Fernandes),阿曼·麥達安(Aman Madaan),艾美·劉(Emmy Liu),安東尼奧·法林納斯(AntónioFarinhas),佩德羅·亨里克·馬丁斯(Pedro Henrique Martins),阿曼達·伯茨(Amanda Bertsch),何塞·喬西(JoséBertsch)

關鍵字:自然語言產生,人類反饋整合,反饋形式和分類法,AI反饋和基於原則的判斷

GPT-4技術報告

Openai

關鍵字:大規模,多模型,基於變壓器的模型,微調使用的RLHF

代碼:官方

數據集:Drop,Winogrande,Hellaswag,Arc,Humaneval,GSM8K,MMLU,真實

筏:生成基礎模型對齊的獎勵排名

Hanze Dong,Wei Xiong,Deepanshu Goyal,Rui Pan,Shizhe Diao,Jipeng Zhang,Kashun Shum,Tong Zhang

關鍵字:拒絕採樣登錄,替代PPO,擴散模型

代碼:官方

RRHF:對對齊語言模型的排名響應沒有人為反饋

Zheng Yuan,Hongyi Yuan,Chuanqi Tan,Wei Wang,Songfang Huang,Fei Huang

關鍵字:RLHF的新範式

代碼:官方

對人類在RL的人類偏好學習

Joey Hejna,Dorsa Sadigh

關鍵字:偏好學習,互動學習,多任務學習,通過查看人類in-in-in-in-in-in-in-in-in-in-in-in-in-in-in-in-in- in-in-in-in-in-in-in-in-in-in-in-in-in-In數據數據庫

代碼:官方

更好地對齊文本對圖像模型與人類偏好

小吳,孔齊安·孫,馮

關鍵字:擴散模型,文本到圖像,美學

代碼:官方

想像力:學習和評估文本到圖像生成的人類偏好

Jiazheng Xu,小劉,Yuchen Wu,Yuxuan Tong,Qinkai Li,Ming ding,Jie Tang,Yuxiao Dong

關鍵字:通用文本到圖像人類偏好RM,評估文本對圖像生成模型

代碼:官方

數據集:Coco,diffusionDB

使用人類反饋對齊文本對像模型

Kimin Lee,Hao Liu,Moonkyung Ryu,Olivia Watkins,Yuqing Du,Craig Boutilier,Pieter Abbeel,Mohammad Ghavamzadeh,Shixiang Shane Gu

關鍵字:文本對圖像,穩定的擴散模型,預測人類反饋的獎勵功能

Visual Chatgpt:使用視覺基礎模型說話,繪畫和編輯

Chenfei Wu,Shengming Yin,Weizhen Qi,Xiaodong Wang,Zecheng Tang,Nan Duan

關鍵字:視覺粉底模型,視覺chatgpt

代碼:官方

具有人類偏好(PHF)的訓練語言模型

Tomasz Korbak,Kejian Shi,Angelica Chen,Rasika Bhalerao,Christopher L. Buckley,Jason Phang,Samuel R. Bowman,Ethan Perez

關鍵字:預處理,離線RL,決策變壓器

代碼:官方

通過F-Divergence最小化(F-DPG)對齊語言模型與偏好

Dongyoung Go,Tomasz Korbak,GermánKruszewski,Jos Rozen,Nahyeon Ryu,Marc Dymetman

關鍵字:f-Divergence,rl帶有kl罰款

從成對或K-Wise比較的人類反饋中有原則的增強學習

Banghua Zhu,Jiantao Jiao,Michael I. Jordan

關鍵字:悲觀的MLE,最大凝集IRL

大語模型中道德自我糾正的能力

人類

關鍵字:通過增加RLHF培訓來提高道德自我糾正能力

數據集;燒烤

自然語言處理的強化學習(不是)是否?

Rajkumar Ramamurthy,Prithviraj Ammanabrolu,Kianté,Brantley,Jack Hessel,Rafet Sifa,Christian Bauckhage,Hannaneh Hajishirzi,Yejin Choi

關鍵字:使用RL,基準,表現RL算法優化語言生成器

代碼:官方

數據集:IMDB,Commongen,CNN每日郵報,Totto,WMT-16(EN-DE),NordativeQa,DailyDialog

獎勵模型的縮放定律過度優化

Leo Gao,John Schulman,Jacob Hilton

關鍵字:金獎勵模型火車代理獎勵模型,數據集大小,策略參數大小,bon,ppo

通過有針對性的人類判斷(Sparrow)改善對話代理的一致性

Amelia Glaese,Nat McAleese,MajaTrębacz等。

關鍵字:尋求信息對話代理,將良好的對話分解為自然語言規則,DPC,與模型互動以引起違反特定規則的行為(對抗性探測)

數據集:自然問題,ELI5,質量,Triviaqa,Winobias,燒烤

紅色小組語言模型以減少危害:方法,縮放行為和經驗教訓

Deep Ganguli,Liane Lovitt,Jackson Kernion等。

關鍵字:紅色團隊語言模型,調查縮放行為,閱讀組合數據集

代碼:官方

使用強化學習進行開放式對話中的動態計劃

Deborah Cohen,Moonkyung Ryu,Yinlam Chow,Orgad Keller,Ido Greenberg,Avinatan Hassidim,Michael Fink,Yossi Matias,Idan Szpektor,Craig Boutilier,Gal Elidan

關鍵字:實時,開放式對話系統,通過語言模型,CAQL,CQL,BERT對話狀態的簡潔嵌入對話狀態

夸克:可控的文本生成,並用加固的學習

Ximing Lu,Sean Welleck,Jack Hessel,Liweh Jiang,Lianhui Qin,Peter West,Prithviraj Ammanabrolu,Yejin Choi

關鍵字:在信號上微調語言模型,決策變壓器,LLM使用PPO調整

代碼:官方

數據集:寫作推廣,SST-2,Wikitext-103

通過從人類反饋中學習的強化學習培訓有用且無害的助手

Yuntao Bai,Andy Jones,Kamal Ndousse等。

關鍵字:無害的助手,在線模式,RLHF培訓的魯棒性,OOD檢測。

代碼:官方

數據集:Triviaqa,Hellaswag,Arc,OpenBookQa,Lambada,Humaneval,MMLU,真實

教授語言模型以驗證的引號(Gophercite)支持答案

Jacob Menick,Maja Trebacz,Vladimir Mikulik,John Aslanides,Francis Song,Martin Chadwick,Mia Glaese,Susannah Young,Lucy Campbell-Gillingham,Geoffrey Irving,NatMcaleese

關鍵字:引用特定證據的答案,不確定何時棄權

數據集:自然問題,ELI5,質量,真實性

培訓語言模型遵循人為反饋的指示(指示)

Long Ouyang,Jeff Wu,Xu Jiang等。

關鍵字:大語言模型,與人類意圖的對齊語言模型

代碼:官方

數據集:真實情況,realtoxicityPrompts

憲法AI:無害反饋的無害

Yuntao Bai,Saurav Kadavath,Sandipan Kundu,Amanda Askell,Jackson Kernion等。

關鍵字:來自AI反饋(RLAIF)的RL,通過自我改進,經過思考鏈風格訓練無害的AI助手,更精確地控制AI行為

代碼:官方

通過模型編寫的評估發現語言模型行為

Ethan Perez,Sam Ringer,KamilėLukošiūtė,Karina Nguyen,Edwin Chen等。

關鍵字:自動通過LMS生成評估,更多的RLHF使LMS惡化,LM寫評估是高素質

代碼:官方

數據集:燒烤,Winogender模式

通過可解釋的多個實例學習,從軌跡標籤中從軌跡標籤中進行非馬克維亞獎勵建模

約瑟夫·勞(Joseph Early),湯姆·貝利(Tom Bewley),克里斯汀·埃弗斯(Christine Evers)

關鍵字:獎勵建模(RLHF),非馬克維亞語,多個實例學習,可解釋性

代碼:官方

WebGPT:通過人類反饋(WebGPT)瀏覽器協助提問的問題

Reiichiro Nakano,Jacob Hilton,Suchir Balaji等。

關鍵字:模型搜索網絡並提供參考,模仿學習,卑詩省,長形式問題

數據集:Eli5,Triviaqa,真實

遞歸用人類反饋總結書籍

Jeff Wu,Long Ouyang,Daniel M. Ziegler,Nisan Stiennon,Ryan Lowe,Jan Leike,Paul Christiano

關鍵字:經過小型任務培訓的模型,以協助人類評估更廣泛的任務,卑詩省

數據集:書籍,敘事Qa

重新審查神經機器翻譯的增強學習的弱點

塞繆爾·基格蘭(Samuel Kiegeland),朱莉婭·克魯特策(Julia Kreutzer)

關鍵字:策略梯度的成功是由於獎勵,而不是輸出分佈的形狀,機器翻譯,NMT,域適應

代碼:官方

數據集:WMT15,IWSLT14

學會從人類反饋中總結

Nisan Stiennon,Long Ouyang,Jeff Wu,Daniel M. Ziegler,Ryan Lowe,Chelsea Voss,Alec Radford,Dario Amodei,Paul Christiano

關鍵字:關心摘要質量,培訓損失會影響模型行為,獎勵模型推廣到新數據集

代碼:官方

數據集:TL; DR,CNN/DM

來自人類偏好的微調語言模型

丹尼爾·齊格勒(Daniel M.

關鍵字:對語言的獎勵學習,以積極的情緒,摘要任務和身體描述性繼續文本

代碼:官方

數據集:TL; DR,CNN/DM

通過獎勵建模的可擴展代理對齊:研究方向

Jan Leike,David Krueger,Tom Everitt,Miljan Martic,Vishal Maini,Shane Legg

關鍵字:代理對準問題,從互動中學習獎勵,優化與RL的獎勵,遞歸獎勵建模

代碼:官方

env:atari

獎勵從人類的偏好和示威中學習的獎勵

Borja Ibarz,Jan Leike,Tobias Pohlen,Geoffrey Irving,Shane Legg,Dario Amodei

關鍵字:專家演示軌跡偏好獎勵黑客問題,人類標籤中的噪音

代碼:官方

env:atari

深馴服:在高維狀態空間中形成互動劑

Garrett Warnell,Nicholas Waytowich,Vernon Lawhern,Peter Stone

關鍵字:高維狀態,利用人類教練的輸入

代碼:第三方

env:atari

從人類的偏好中學習深度強化

Paul Christiano,Jan Leike,Tom B. Brown,Miljan Martic,Shane Legg,Dario Amodei

關鍵字:探索在成對軌跡分割之間的人類偏好中定義的目標,學習比人類反饋更複雜的東西

代碼:官方

Env:Mujoco Atari

依賴政策的人類反饋的互動學習

詹姆斯·麥格拉珊(James MacGlashan),馬克·K·霍(Mark K Ho),羅伯特·洛夫汀(Robert Loftin

關鍵字:決策受到當前政策而不是人類反饋的影響,從依賴政策的反饋中學習,這些反饋收斂到本地最佳

format: - [title](codebase link) [links] - author1, author2, and author3... - keyword - experiment environments, datasets or tasks

VERL:LLM的火山發動機增強學習

BYTEDANCE SEED MLSYS團隊和HKU:Guangming Sheng,Chi Zhang,Zilingfeng Ye,Xibin Wu,Wang Zhang,Ru Zhang,Yangua Peng,Haibin Lin,Chuan Wu

關鍵字:靈活,高效,RLHF框架

任務:RLHF,包括數學和代碼在內的推理任務。

OpenRLHF

OpenRLHF

關鍵字:70B,RLHF,DeepSpeed,Ray,VLLM

任務:易於使用,可擴展且高性能的RLHF框架(支持70B+完整調整和Lora&Mixtral&KTO)。

棕櫚 + RLHF- pytorch

Phil Wang,Yachine Zahidi,Ikko Eltociear Ashimine,Eric Alcaide

關鍵字:變形金剛,棕櫚體系結構

數據集:ENWIK8

LM-Human-Preference

丹尼爾·齊格勒(Daniel M.

關鍵字:對語言的獎勵學習,以積極的情緒,摘要任務和身體描述性繼續文本

數據集:TL; DR,CNN/DM

以下建築 - 人類反饋

Long Ouyang,Jeff Wu,Xu Jiang等。

關鍵字:大語言模型,與人類意圖的對齊語言模型

數據集:真實的realtoxicityPrompts

變壓器增強學習(TRL)

Leandro von Werra,Younes Belkada,Lewis Tunstall等。

關鍵字:使用RL,PPO,變壓器的LLM訓練LLM

任務:IMDB情緒

變壓器增強學習X(TRLX)

Jonathan Tow,Leandro von Werra等。

關鍵字:分佈式培訓框架,基於T5的語言模型,使用RL,PPO,ILQL培訓LLM

任務:使用RL使用提供的獎勵功能或獎勵標記的數據集進行微調LLM

RL4LMS(一個模塊化的RL庫,以對人類偏好進行微調語言模型)

Rajkumar Ramamurthy,Prithviraj Ammanabrolu,Kianté,Brantley,Jack Hessel,Rafet Sifa,Christian Bauckhage,Hannaneh Hajishirzi,Yejin Choi

關鍵字:使用RL,基準,表現RL算法優化語言生成器

數據集:IMDB,Commongen,CNN每日郵報,Totto,WMT-16(EN-DE),NordativeQa,DailyDialog

lamda-rlhf-pytorch

菲爾·王

關鍵字:LAMDA,注意力機構

任務:Pytorch中Google LAMDA研究論文的開源預培訓實施

Textrl

埃里克·林(Eric Lam)

關鍵字:HuggingFace的變壓器

任務:文字生成

env:PFRL,健身房

minrlhf

湯姆弗斯特

關鍵字:PPO,最小庫

任務:教育目的

深速chat

微軟

關鍵字:負擔得起的RLHF培訓

Dromedary

IBM

關鍵字:最少的人類監督,自我對準

任務:自我對準語言模型,受到最少的人類監督訓練

FG-RLHF

Zeqiu Wu,Yushi Hu,Weijia Shi等。

關鍵字:細粒度RLHF,在每個細分市場之後提供獎勵,並結合了與不同反饋類型相關的多個RMS

任務:一個框架,可以從密度和多個RMS的獎勵功能中進行培訓和學習 - SAFE-RLHF

Xuehai Pan,Ruiyang Sun,Jiaming JI等。

關鍵字:支持流行的預訓練模型,大型人體標記的數據集,用於安全約束驗證的多尺度指標,自定義參數

任務:通過安全的RLHF受約束的價值一致的LLM

format: - [title](dataset link) [links] - author1, author2, and author3... - keyword - experiment environments or tasks

HH-RLHF

本·曼恩(Ben Mann),深ganguli

關鍵字:人類偏好數據集,紅色小組數據,機器編寫

任務:有關人類偏好數據的開源數據集有關有幫助和無害性的數據

斯坦福人類偏好數據集(SHP)

Ethayarajh,Kawin和Zhang,Heidi和Wang,Yizhong和Jurafsky,Dan

關鍵字:自然發生和人工編寫的數據集,18個不同的主題領域

任務:旨在用於培訓RLHF獎勵模型

提示

Stephen H. Bach,Victor Sanh,Zheng-Xin Yong等。

關鍵字:提示英語數據集,將數據示例映射到自然語言中

任務:用於創建,共享和使用自然語言提示的工具包

結構化知識接地(SKG)資源收集

Tianbao Xie,Chen Henry Wu,Peng Shi等。

關鍵字:結構化知識接地

任務:數據集的收集與結構化知識接地有關

弗蘭收藏

Longpre Shayne,Hou Le,Vu Tu等。

任務:收集收集Flan 2021,P3,超自然說明的數據集

RLHF-Reward-Datasets

Yiting Xie

關鍵字:機器編寫的數據集

WebGPT_COMPARISON

Openai

關鍵字:人工編寫的數據集,長形式問題回答

任務:訓練一個長期的問題回答模型,以與人類的偏好保持一致

總結_from_feedback

Openai

關鍵字:人工編寫的數據集,摘要

任務:訓練摘要模型以與人類的偏好保持一致

dahoas/nimthetic-Instruct-gptj-pairwise

達霍斯

關鍵字:人工編寫的數據集,合成數據集

穩定的一致性 - 社交遊戲中的一致性學習

Ruibo Liu,Ruixin(Ray)Yang,Qiang Peng

關鍵字:用於對齊訓練的交互數據,在沙箱中運行

任務:在模擬社交遊戲中訓練記錄的交互數據

利馬

meta ai

關鍵字:沒有任何RLHF,很少經過精心策劃的提示和響應

任務:用於培訓利馬模型的數據集

[Openai] chatgpt:優化對話的語言模型

[擁抱臉]說明從人類反饋(RLHF)學習的強化學習

[Zhihu]通向agi:大型語言模型(llm)技術精要

[Zhihu]大語言模型的湧現能力:現象與解釋

[zhihu]中文hh-rlHf數據集上的ppo實踐

[W&B完全連接]從人類反饋中了解強化學習(RLHF)

[DeepMind]通過人類反饋學習

[概念]深入理解語言模型的突現能力

[概念]拆解追溯gpt-3.5各項能力的起源

[要點]語言模型的加強學習

[YouTube]約翰·舒爾曼(John Schulman) - 從人類反饋中學習的強化:進步和挑戰

[OpenAi / Arize] Openai對人類反饋進行加固學習

[ENCORD]從人類反饋(RLHF)進行計算機視覺的強化指南

[Weixun Wang] RL(HF)+LLM的概述

土耳其

我們的目的是使此回購變得更好。如果您有興趣貢獻,請參考此處以獲取貢獻的說明。

Awesome RLHF在Apache 2.0許可下發布。