openai autogen dev studio

1.0.0

使用OpenAI代理生成遊戲和程序。建在Microsoft Autogen之上。

配x 正在進行中

當前代碼有效,但:

- 有,並且會有破裂的變化:

- 始終檢查您隱藏的

.env.jsonc文件是否匹配了最後一個env.sample.jsonc結構。- 始終通過

poetry install更新您的依賴關係。- 為了大大減少令牌使用:緩存,逐步的過程,對話分裂,更好的提示,需要優化很多事情。

- 該代碼需要清理一些。

- Microsoft Autogen仍處於早期階段,並包含一些錯誤。

- 許多硬編碼的東西可以通過配置文件自定義。

- 首先,我只專注於幾種編程語言。

有一些令人驚嘆的項目做類似的事情,但我希望找到一種解決雄心勃勃的計劃生成的方法。

您要么需要OpenAI API鍵或Azure OpenAI API鍵。

不僅僅是“示例”程序,不要依靠GPT-3.5 (無論是turbo還是標準)。如果您的目標是更複雜的應用程序, GPT-4是必須的,甚至是GPT-4-32k 。

使用OpenAI API可能會迅速耗盡您的令牌限制。對於更廣泛的項目,建議使用Azure OpenAI API。

如果您有雄心勃勃的目標,請注意成本!始終監視令牌的使用以及您的代理商在做什麼。雖然AI可以是一種強大的工具,但它不一定比僱用真正的開發人員便宜。

conda create -n autogen python=3.10

conda activate autogen

pip install poetry

poetry install

cp env.sample.jsonc env.jsonc編輯您的env.json以添加API鍵並自定義安裝。

只是:

make run OADS will automatically generate the program source code in ./project directory.

您可以通過:

make clean重要的是:功能將行不通。

根據我的測試,Autogen似乎與文本生成Web UI支持的任何開源LLM一起使用。

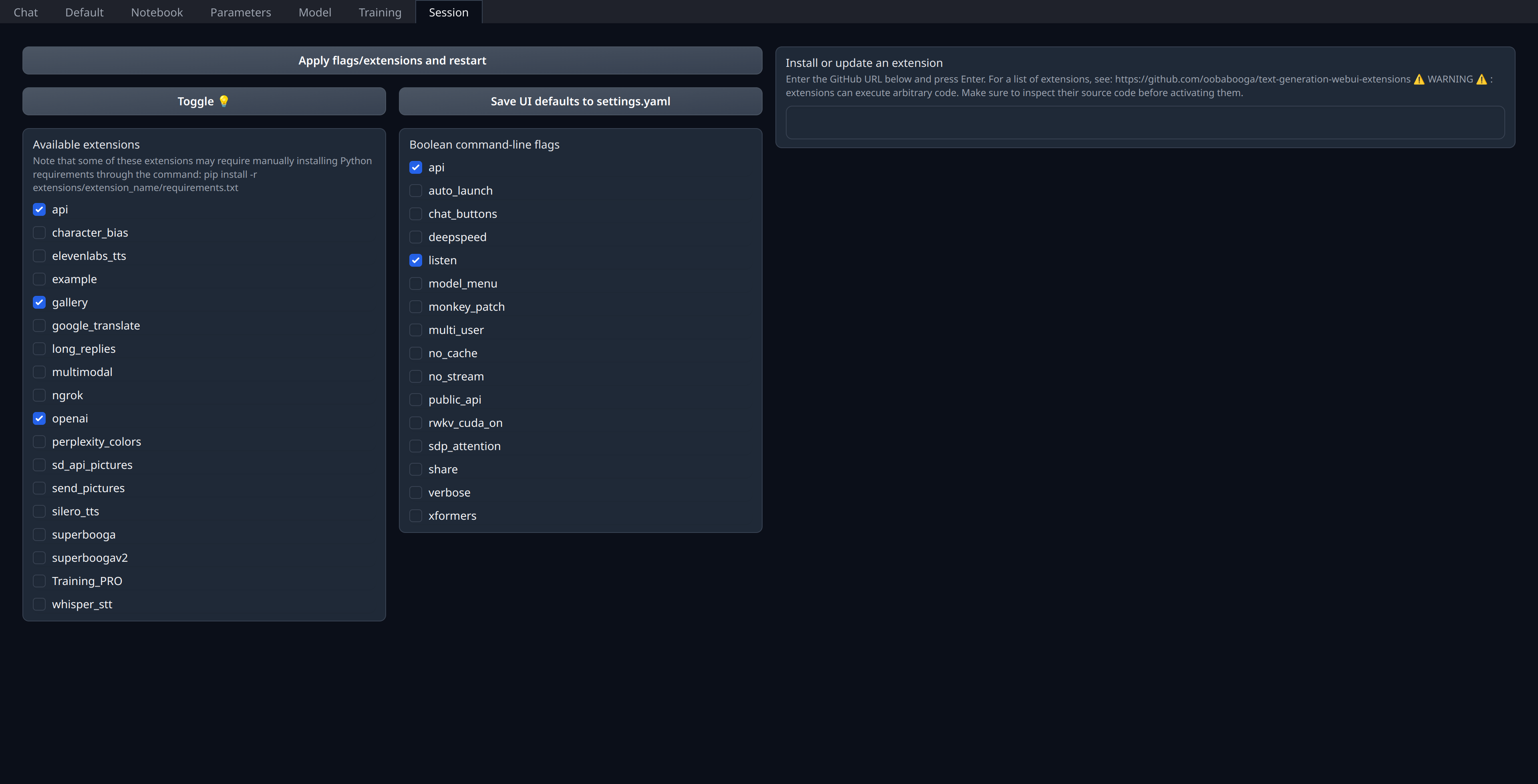

您只需要在Web UI的“會話”選項卡中啟用openai擴展:

確保您的5001端口打開或搭接是遠程服務器,因為這是露出類似OpenAi的API的地方。

我親自將當前模型部署在RunPod(不關聯)上,並使用thebloke/cuda11.8.0-ubuntu22.04-oneclick:latest圖像,即使我認為對於llama.cpp&co似乎有些過時。

"models" : [

// Custom deployment of (for example) `Open-Orca/Mistral-7B-OpenOrca`

// using "Text generation web UI" with `OpenAI` extension enabled:

// https://github.com/oobabooga/text-generation-webui/tree/main/extensions/openai#an-openedai-api-openai-like

// This can be any inference endpoint compatible following OpenAI API specs,

// regardless of the model you use behind it.

{

"model" : "Open-Orca/LlongOrca-13B-16k" ,

"api_base" : "http://localhost:5001" , // Or your remote server URL

"api_key" : "sk-111111111111111111111111111111111111111111111111" ,

"api_type" : "open_ai"

}

] ,