أصدرت Meta AI بشكل صادم نموذجًا أساسيًا للغة متعددة الوسائط يسمى SPIRIT LM، وهو إنجاز تاريخي يمكنه مزج النص والكلام بحرية! وهو يعتمد على نموذج لغة نصية تم تدريبه مسبقًا مع 7 مليارات معلمة، ويمتد إلى وضع الكلام من خلال التدريب المستمر، وتحقيق فهم مزدوج الوسائط وإنشاء النص والكلام، ويمكنه أيضًا مزج الاثنين، مما يؤدي إلى تأثيرات تطبيق غير متوقعة. سيأخذك محرر Downcodes إلى فهم متعمق للوظائف القوية لـ SPIRIT LM والإنجازات التكنولوجية التي تقف وراءها.

قامت Meta AI مؤخرًا بفتح مصدر لنموذج لغة أساسي متعدد الوسائط يسمى SPIRIT LM، والذي يمكنه مزج النص والكلام بحرية، مما يفتح إمكانيات جديدة للمهام متعددة الوسائط للصوت والنص.

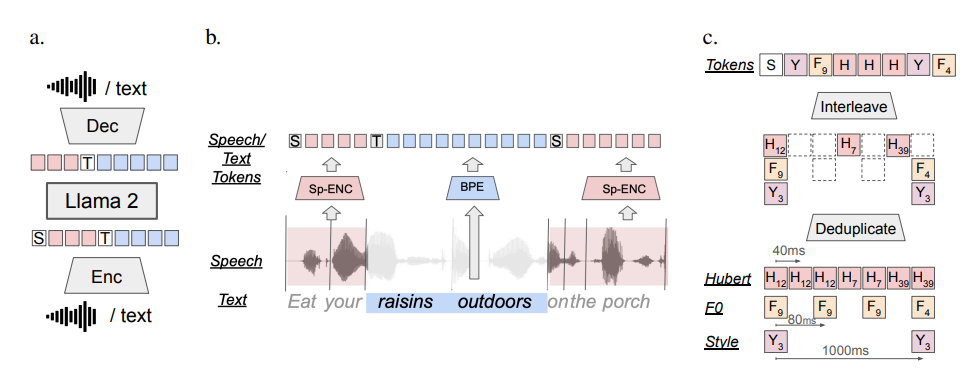

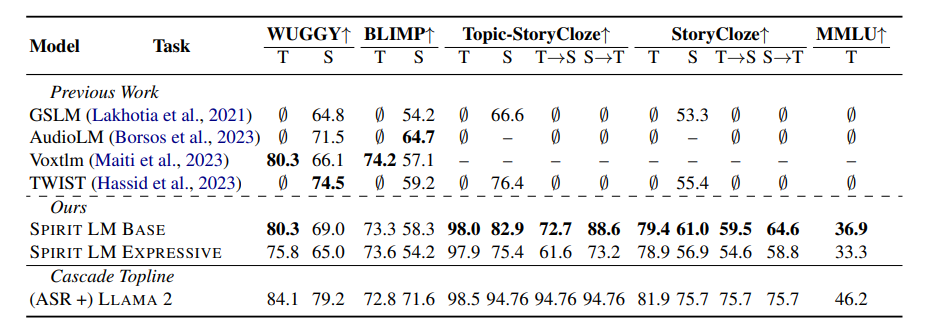

يعتمد SPIRIT LM على نموذج لغة نصية تم تدريبه مسبقًا مكون من 7 مليارات معلمة ويمتد إلى طرائق الكلام من خلال التدريب المستمر على وحدات النص والكلام. يمكنه فهم النص وإنشاءه مثل نموذج نص كبير، ويمكنه أيضًا فهم الكلام وتوليده معًا لإنشاء تأثيرات سحرية مختلفة، على سبيل المثال، يمكنك استخدامه للتعرف على الكلام، وتحويل الكلام إلى يمكنك أيضًا استخدامه لتركيب الكلام لتحويل النص إلى كلام؛ ويمكنك أيضًا استخدامه لتصنيف الكلام لتحديد المشاعر التي يعبر عنها جزء من الكلام.

والأمر الأكثر قوة هو أن SPIRIT LM جيد أيضًا بشكل خاص في "التعبير العاطفي"! يمكنه التعرف على مجموعة متنوعة من نغمات وأنماط الصوت المختلفة وتوليدها، مما يجعل صوت الذكاء الاصطناعي يبدو أكثر طبيعية وعاطفية. يمكنك أن تتخيل أن الصوت الناتج عن SPIRIT LM لم يعد صوت الآلة الباردة، بل يشبه صوت شخص حقيقي يتحدث، مليئًا بالفرح والغضب والحزن والفرح!

من أجل جعل الذكاء الاصطناعي "عاطفيًا" بشكل أفضل، قام باحثو Meta أيضًا بتطوير نسختين خصيصًا من SPIRIT LM:

"الإصدار الأساسي" (BASE): يركز هذا الإصدار بشكل أساسي على المعلومات الصوتية للكلام، وهو "التركيب الأساسي" للكلام.

"الإصدار التعبيري" (EXPRESSIVE): بالإضافة إلى معلومات الصوت، يضيف هذا الإصدار أيضًا معلومات النغمة والأسلوب، مما يمكن أن يجعل صوت الذكاء الاصطناعي أكثر حيوية وتعبيرًا.

إذًا، كيف تقوم SPIRIT LM بكل هذا؟

ببساطة، تم تدريب SPIRIT LM استنادًا إلى LLAMA2، وهو نموذج نص كبير قوي للغاية تم إصداره مسبقًا بواسطة Meta. قام الباحثون "بتغذية" كمية كبيرة من بيانات النص والكلام إلى LLAMA2 واعتمدوا طريقة "تدريب مشذر" خاصة حتى يتمكن LLAMA2 من تعلم قواعد النص والكلام في نفس الوقت.

من أجل اختبار قدرة SPIRIT LM على "التعبير العاطفي"، صمم باحثو Meta أيضًا معيار اختبار جديد - "مقياس الحفاظ على المشاعر في الكلام والنص" (STSP). يحتوي معيار الاختبار هذا على مجموعة متنوعة من مطالبات الكلام والنص التي تعبر عن مشاعر مختلفة لاختبار ما إذا كان نموذج الذكاء الاصطناعي يمكنه التعرف بدقة على الكلام والنص وتوليدهما مع المشاعر المقابلة. تظهر النتائج أن "إصدار التعبير" من SPIRIT LM يؤدي أداءً جيدًا في الاحتفاظ بالعواطف وهو حاليًا أول نموذج للذكاء الاصطناعي يمكنه الاحتفاظ بالمعلومات العاطفية عبر الطرائق!

بالطبع، اعترف باحثو Meta أيضًا بأن SPIRIT LM لا يزال لديه العديد من المجالات التي تحتاج إلى التحسين. على سبيل المثال، يدعم SPIRIT LM حاليًا اللغة الإنجليزية فقط ويحتاج إلى توسيعه ليشمل لغات أخرى في المستقبل. حجم نموذج SPIRIT LM ليس كبيرًا بما يكفي، ومن الضروري الاستمرار في توسيع نطاق النموذج وتحسين أداء النموذج في المستقبل.

يعد SPIRIT LM إنجازًا كبيرًا لشركة Meta في مجال الذكاء الاصطناعي، فهو يفتح الباب أمامنا لعالم الذكاء الاصطناعي "السبر والعاطفي". أعتقد أنه في المستقبل القريب، سنرى المزيد من التطبيقات المثيرة للاهتمام التي تم تطويرها استنادًا إلى SPIRIT LM، بحيث لا يتمكن الذكاء الاصطناعي من التحدث ببلاغة فحسب، بل يمكنه أيضًا التعبير عن المشاعر مثل الأشخاص الحقيقيين، والتواصل معنا بشكل طبيعي وودي أكثر!

عنوان المشروع: https://speechbot.github.io/spiritlm/

عنوان الورقة: https://arxiv.org/pdf/2402.05755

بشكل عام، حقق المصدر المفتوح لـ SPIRIT LM تقدمًا مثيرًا في مجال الذكاء الاصطناعي متعدد الوسائط، ويبشر ظهوره بأن الذكاء الاصطناعي سيحقق اختراقات أكبر في التفاعل الصوتي والتعبير العاطفي في المستقبل الاهتمام بهذا المجال على آخر الأخبار، يرجى متابعة!