في الآونة الأخيرة، انتبه محرر Downcodes إلى أخبار مثيرة للقلق: تبين أن أداة النسخ المدعومة بالذكاء الاصطناعي المستخدمة على نطاق واسع في الصناعة الطبية، والتي تعتمد على تقنية Whisper الخاصة بـ OpenAI، تحتوي على "هلوسة" وقد تولد محتوى كاذبًا. وقد أثار هذا مخاوف بشأن سلامة وموثوقية تكنولوجيا الذكاء الاصطناعي في المجال الطبي. ستقوم هذه المقالة بتحليل هذه الحادثة بالتفصيل، واستكشاف مخاطرها المحتملة واستجابة OpenAI.

في الآونة الأخيرة، اكتسبت أداة نسخ الذكاء الاصطناعي المدعومة بتقنية Whisper من OpenAI شعبية في الصناعة الطبية. يستخدم العديد من الأطباء ومنظمات الرعاية الصحية هذه الأداة لتسجيل وتلخيص لقاءات المرضى.

ووفقا لتقرير صادر عن شبكة ABC News، وجد الباحثون أن هذه الأداة يمكن أن تسبب "الهلوسة" في بعض الحالات، وفي بعض الأحيان تقوم بتلفيق المحتوى بالكامل.

نجحت أداة النسخ، التي طورتها شركة تدعى Nabla، في نسخ أكثر من 7 ملايين محادثة طبية ويستخدمها حاليًا أكثر من 30 ألف طبيب و40 نظامًا صحيًا. ومع ذلك، تدرك نابلا احتمالية إصابة شركة Whisper بالهلوسة، وتقول إنها تعمل على معالجة هذه المشكلة.

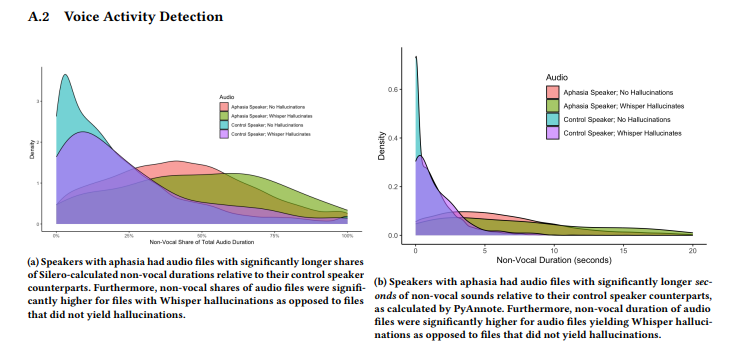

وجدت دراسة أجراها فريق من الباحثين من جامعة كورنيل وجامعة واشنطن وغيرهما أن ويسبر يعاني من الهلوسة في حوالي 1٪ من نسخه. في هذه الحالات، تقوم الأداة بشكل عشوائي بتوليد عبارات لا معنى لها خلال فترات الصمت من التسجيل، والتي تعبر أحيانًا عن مشاعر عنيفة. جمع الباحثون عينات صوتية من AphasiaBank التابع لـ TalkBank، ولاحظوا أن الصمت شائع بشكل خاص عندما يتحدث الأشخاص الذين يعانون من اضطرابات النطق.

شاركت أليسون كوينكي، الباحثة في جامعة كورنيل، بعض الأمثلة على وسائل التواصل الاجتماعي التي تظهر المحتوى الهلوسة الناتج عن تطبيق Whisper. ووجد الباحثون أن المحتوى الذي أنشأته الأداة يتضمن أيضًا مصطلحات طبية مختلقة وحتى عبارات مثل "شكرًا على المشاهدة" والتي تبدو وكأنها كلمات من مقاطع فيديو على YouTube.

تم تقديم البحث في مؤتمر FAccT التابع لجمعية آلات الحوسبة في البرازيل في شهر يونيو، ولكن من غير الواضح ما إذا كان قد تم مراجعته من قبل النظراء. وفيما يتعلق بهذه القضية، قالت المتحدثة باسم OpenAI، تايا كريستيانسون، في مقابلة مع موقع "The Verge" إنهم يأخذون هذه القضية على محمل الجد وسيواصلون العمل الجاد لتحسينها، خاصة في الحد من الهلوسة. وفي الوقت نفسه، ذكرت أنه عند استخدام Whisper على منصة API الخاصة بهم، هناك سياسات استخدام واضحة تحظر استخدام الأداة في بيئات معينة لصنع القرار عالية المخاطر.

تسليط الضوء على:

تُستخدم أداة النسخ Whisper على نطاق واسع في الصناعة الطبية وقد سجلت 7 ملايين محادثة طبية.

⚠️ وجدت الأبحاث أن Whisper "يهلوس" في حوالي 1% من النسخ، مما يؤدي في بعض الأحيان إلى إنشاء محتوى لا معنى له.

وتقول شركة OpenAI إنها تعمل على تحسين أداء الأداة، خاصة في تقليل الهلوسة.

بشكل عام، تتمتع تكنولوجيا الذكاء الاصطناعي بآفاق واسعة للتطبيق في المجال الطبي، ولكنها تواجه أيضًا العديد من التحديات. إن ظهور ظاهرة "الهلوسة" لدى ويسبر يذكرنا بضرورة التعامل مع تكنولوجيا الذكاء الاصطناعي بحذر وتعزيز الرقابة على سلامتها وموثوقيتها لضمان تطبيقها الآمن والفعال في المجال الطبي وحماية حقوق المرضى وسلامتهم. سيستمر محرر Downcodes في الاهتمام بالتطور اللاحق لهذه الحادثة.