لقد كانت طبيعة "الصندوق الأسود" لنماذج اللغات الكبيرة (LLM) دائمًا مشكلة مهمة يعاني منها مجال الذكاء الاصطناعي. إن عدم إمكانية تفسير نتائج مخرجات النموذج يجعل من الصعب ضمان موثوقيتها ومصداقيتها. لحل هذه المشكلة، أطلقت OpenAI تقنية جديدة تسمى Prover-Verifier Games (PVG)، والتي تهدف إلى تحسين إمكانية التفسير والتحقق من مخرجات LLM. سيشرح لك محرر Downcodes هذه التقنية بالتفصيل.

أصدرت OpenAI مؤخرًا تقنية جديدة تسمى Prover-Verifier Games (PVG)، والتي تهدف إلى حل مشكلة "الصندوق الأسود" الخاصة بمخرجات نماذج الذكاء الاصطناعي.

تخيل أن لديك مساعدًا فائق الذكاء، ولكن عملية تفكيره تشبه الصندوق الأسود وليس لديك أي فكرة عن كيفية التوصل إلى استنتاجاته. هل يبدو هذا غير مريح بعض الشيء؟ نعم، هذه هي المشكلة التي تواجهها العديد من نماذج اللغات الكبيرة (LLM) حاليًا؟ على الرغم من قوتها، إلا أنه من الصعب التحقق من دقة المحتوى الذي تنشئه.

عنوان URL للورقة: https://cdn.openai.com/prover-verifier-games-improve-legibility-of-llm-outputs/legibility.pdf

ولحل هذه المشكلة، أطلقت شركة OpenAI تقنية PVG. ببساطة، هو السماح للنماذج الصغيرة (مثل GPT-3) بالإشراف على إخراج النماذج الكبيرة (مثل GPT-4). إن الأمر أشبه بلعب لعبة. إن Prover هو المسؤول عن إنشاء المحتوى، وVerifier هو المسؤول عن تحديد ما إذا كان المحتوى صحيحًا. يبدو مثيرا للاهتمام؟

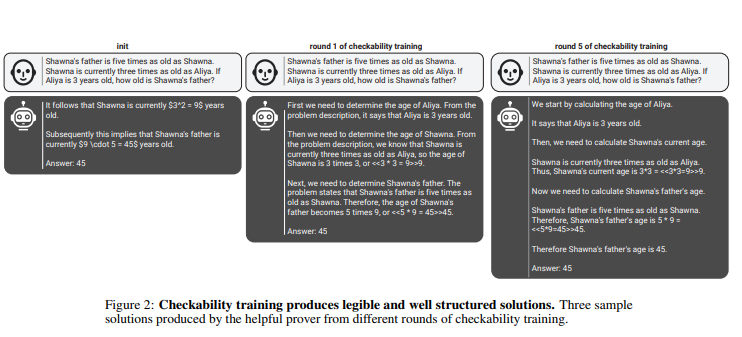

في هذه القاعدة، يقوم المثبتون والمتحققون باستمرار بتحسين قدراتهم من خلال جولات متعددة من التدريب التكراري. يستخدم القائمون على التحقق التعلم الخاضع للإشراف للتنبؤ بصحة المحتوى، بينما يستخدم القائمون على التحقق التعلم المعزز لتحسين المحتوى الذي يقومون بإنشائه. والأكثر إثارة للاهتمام هو أن هناك نوعين من الأمثال: الأمثال المفيدة والأمثال الماكرة. يسعى المثبتون المفيدون إلى إنشاء محتوى صحيح ومقنع، بينما يحاول المثبتون الماهرون إنشاء محتوى غير صحيح ولكنه مقنع بنفس القدر، وبالتالي يتحدى حكم المدقق.

تؤكد penAI على أنه من أجل تدريب نموذج تحقق فعال، هناك حاجة إلى كمية كبيرة من بيانات التسمية الحقيقية والدقيقة لتحسين قدرات التعرف عليه. بخلاف ذلك، حتى لو تم استخدام تقنية PVG، فقد يظل المحتوى الذي تم التحقق منه معرضًا لخطر الإخراج غير القانوني.

تسليط الضوء على:

تعمل تقنية PVG على حل مشكلة "الصندوق الأسود" للذكاء الاصطناعي من خلال التحقق من إخراج النماذج الكبيرة بنماذج صغيرة.

يعتمد إطار التدريب على نظرية اللعبة ويحاكي التفاعل بين المثبت والمتحقق، مما يحسن دقة مخرجات النموذج وإمكانية التحكم فيها.

مطلوب قدر كبير من البيانات الحقيقية لتدريب نموذج التحقق للتأكد من أنه يتمتع بما يكفي من الحكم والقوة.

وبشكل عام، توفر تقنية PVG الخاصة بشركة OpenAI فكرة جديدة لحل مشكلة "الصندوق الأسود" لنماذج الذكاء الاصطناعي، لكن فعاليتها لا تزال تعتمد على بيانات التدريب عالية الجودة. إن التطوير المستقبلي لهذه التكنولوجيا يستحق التطلع إليه، لأنه سيعزز تطوير نماذج الذكاء الاصطناعي في اتجاه أكثر موثوقية وقابلية للتفسير وجديرة بالثقة. يتطلع محرر Downcodes إلى رؤية ظهور المزيد من التقنيات المبتكرة المماثلة.