سيساعدك محرر Downcodes على تفسير تقرير البحث العالمي الصادر عن Checkmarx، والذي يكشف عن الوضع الحالي للاستخدام الواسع النطاق لأدوات برمجة الذكاء الاصطناعي في مجال تطوير البرمجيات والمخاطر الأمنية التي يجلبها. تظهر بيانات التقرير أنه على الرغم من أن بعض الشركات قد حظرت صراحة استخدام أدوات برمجة الذكاء الاصطناعي، إلا أن معدلات اعتمادها لا تزال مرتفعة، مما يسلط الضوء على التحديات التي تواجهها الشركات في إدارة الذكاء الاصطناعي التوليدي. ويقدم التقرير أيضًا مناقشة متعمقة حول حوكمة أدوات الذكاء الاصطناعي للمؤسسات، وتقييم المخاطر الأمنية، وثقة المطورين في أدوات الذكاء الاصطناعي، مما يوفر مرجعًا مهمًا للمؤسسات للاستفادة بشكل فعال من أدوات الذكاء الاصطناعي.

وفقًا لدراسة عالمية أصدرتها شركة Checkmarx للأمن السحابي، على الرغم من أن 15% من الشركات تحظر صراحةً استخدام أدوات برمجة الذكاء الاصطناعي، إلا أن جميع فرق التطوير تقريبًا (99%) لا تزال تستخدم هذه الأدوات. وتعكس هذه الظاهرة صعوبة التحكم في استخدام الذكاء الاصطناعي التوليدي في عملية التطوير الفعلية.

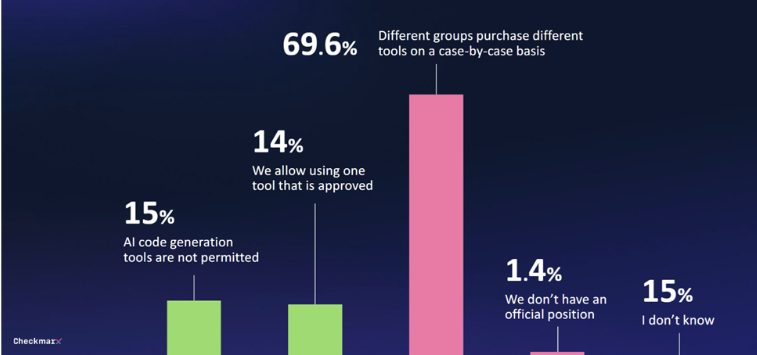

وجدت الدراسة أن 29% فقط من الشركات أنشأت أي شكل من أشكال نظام الحوكمة لأدوات الذكاء الاصطناعي التوليدية. 70% من الشركات ليس لديها استراتيجية مركزية، وغالباً ما تكون قرارات الشراء الخاصة بالإدارات المختلفة مؤقتة وتفتقر إلى إدارة موحدة.

مع تزايد استخدام المطورين لأدوات برمجة الذكاء الاصطناعي، أصبحت المشكلات الأمنية مصدر قلق متزايد. يشعر 80% من المشاركين بالقلق بشأن التهديدات المحتملة التي قد يجلبها المطورون عند استخدام الذكاء الاصطناعي، و60% منهم يشعرون بالقلق بشكل خاص بشأن "الهلوسة" المحتملة التي يسببها الذكاء الاصطناعي.

على الرغم من هذه المخاوف، لا يزال الكثير من الناس مهتمين بإمكانيات الذكاء الاصطناعي. أبدى 47% من المشاركين استعدادهم للسماح للذكاء الاصطناعي بإجراء تغييرات على التعليمات البرمجية دون إشراف، بينما أعرب 6% فقط عن عدم ثقتهم الكاملة في إجراءات أمان الذكاء الاصطناعي في بيئات البرمجيات.

وأشار كوبي تزرويا، كبير مسؤولي المنتجات في Checkmarx: "تكشف ردود مسؤولي أمن المعلومات حول العالم أن المطورين يستخدمون الذكاء الاصطناعي لتطوير التطبيقات، على الرغم من أن أدوات الذكاء الاصطناعي هذه لا يمكنها إنشاء تعليمات برمجية آمنة بشكل موثوق، مما يعني أن فرق الأمان تتعامل مع عدد كبير من تعليمات برمجية جديدة ومن المحتمل أن تكون ضارة."

ويظهر تقرير مؤشر اتجاه العمل الخاص بشركة مايكروسوفت أيضًا أن العديد من الموظفين يستخدمون أدوات الذكاء الاصطناعي الخاصة بهم دون توفيرها، وغالبًا ما لا يناقشون ذلك بشكل علني، مما يعيق التنفيذ المنهجي للذكاء الاصطناعي التوليدي في العمليات التجارية.

تسليط الضوء على:

1. ** 15% من الشركات تحظر أدوات برمجة الذكاء الاصطناعي، لكن 99% من فرق التطوير لا تزال تستخدمها**

2. ** 29% فقط من الشركات أنشأت نظام حوكمة لأدوات الذكاء الاصطناعي التوليدية**

3. **47% من المشاركين على استعداد للسماح للذكاء الاصطناعي بإجراء تغييرات غير خاضعة للرقابة على التعليمات البرمجية**

بشكل عام، يسلط التقرير الضوء على حاجة الشركات إلى تعزيز سياسات الإدارة والأمن لأدوات برمجة الذكاء الاصطناعي وتحقيق التوازن بين الراحة التي يوفرها الذكاء الاصطناعي والمخاطر المحتملة. وينبغي للشركات صياغة استراتيجية موحدة والاهتمام بالثغرات الأمنية التي قد يجلبها الذكاء الاصطناعي، حتى تتمكن من الاستفادة بشكل أفضل من تكنولوجيا الذكاء الاصطناعي لتحسين كفاءة التطوير. يوصي محرر Downcodes بالاهتمام بتقارير متابعة Checkmarx لمعرفة المزيد حول التطورات في مجال أمن الذكاء الاصطناعي.