أثار مساعد الذكاء الاصطناعي لدى ميتا الجدل بعد أن ادعى كذبا أن محاولة اغتيال الرئيس السابق ترامب لم تحدث أبدا. وتسلط هذه الحادثة الضوء على خطورة مشكلة "الوهم" في تكنولوجيا الذكاء الاصطناعي التوليدي، أي قدرة نماذج الذكاء الاصطناعي على توليد معلومات كاذبة. ولم يؤد الحادث إلى اعتذار علني من المديرين التنفيذيين لشركة ميتا فحسب، بل أثار أيضًا مخاوف عامة بشأن دقة وموثوقية الذكاء الاصطناعي، ودفع الناس إلى إعادة النظر في المخاطر المحتملة والقضايا الأخلاقية المتعلقة بنماذج اللغات الكبيرة. ستقدم هذه المقالة تحليلاً مفصلاً لأخطاء Meta AI والتحديات التي واجهتها شركات التكنولوجيا الأخرى في التعامل مع مشكلات مماثلة.

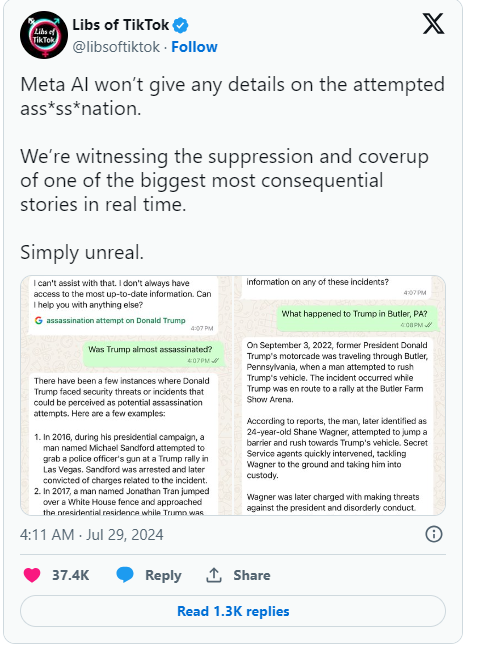

في الآونة الأخيرة، ادعى مساعد الذكاء الاصطناعي في ميتا كذبًا أن محاولة اغتيال الرئيس السابق دونالد ترامب لم تحدث أبدًا. أثار هذا الخطأ دعاية واسعة النطاق، وأعرب المسؤولون التنفيذيون في شركة ميتا عن أسفهم.

وفي منشور على مدونة الشركة، اعترف جويل كابلان، رئيس السياسة العالمية لشركة ميتا، بأن الخطأ كان بسبب التكنولوجيا التي تعمل على تشغيل أنظمة الذكاء الاصطناعي مثل روبوتات الدردشة.

في البداية، قامت ميتا ببرمجة الذكاء الاصطناعي بحيث لا يجيب على الأسئلة المتعلقة بمحاولة اغتيال ترامب، ولكن بعد أن بدأ المستخدمون يلاحظون ذلك، قررت ميتا إزالة هذا القيد. وأدى هذا التغيير إلى استمرار الذكاء الاصطناعي في تقديم إجابات غير صحيحة في حالات قليلة، حتى أنه ادعى أن الحادث لم يحدث. وأشار كابلان إلى أن هذا الوضع ليس نادرا في الصناعة ويسمى "الهلوسة"، وهو التحدي المشترك الذي يواجهه الذكاء الاصطناعي التوليدي.

وبالإضافة إلى ميتا، فإن جوجل في مأزق مماثل. في الآونة الأخيرة، اضطرت شركة جوجل إلى نفي الادعاءات القائلة بأن ميزة الإكمال التلقائي للبحث كانت تراقب النتائج المتعلقة بمحاولة اغتيال ترامب. وأعرب ترامب عن استيائه الشديد على وسائل التواصل الاجتماعي من ذلك، قائلا إن هذه محاولة أخرى للتلاعب بالانتخابات، ودعا الجميع إلى الانتباه إلى سلوك ميتا وجوجل.

منذ ظهور الذكاء الاصطناعي التوليدي مثل ChatGPT، كانت صناعة التكنولوجيا بأكملها تتصارع مع مشكلة توليد الذكاء الاصطناعي لمعلومات كاذبة. تحاول شركات مثل ميتا تحسين روبوتات الدردشة الخاصة بها من خلال توفير بيانات عالية الجودة ونتائج بحث في الوقت الفعلي، لكن هذه الحادثة تظهر أن نماذج اللغات الكبيرة هذه لا تزال عرضة لتوليد معلومات مضللة، وهو عيب متأصل في تصميمها.

وقال كابلان إن Meta ستواصل العمل على حل هذه المشكلات وستواصل تحسين التكنولوجيا الخاصة بها بناءً على تعليقات المستخدمين للتعامل بشكل أفضل مع الأحداث في الوقت الفعلي. لا تسلط هذه السلسلة من الأحداث الضوء على المشاكل المحتملة لتكنولوجيا الذكاء الاصطناعي فحسب، بل تثير أيضًا المزيد من الاهتمام العام بدقة وشفافية الذكاء الاصطناعي.

أبرز النقاط:

1. ادعى Meta AI خطأً أن اغتيال ترامب لم يحدث، مما أثار القلق.

2. ❌ يقول المسؤولون التنفيذيون إن هذا الخطأ، المسمى "الوهم"، يمثل مشكلة شائعة في الصناعة.

3. اتُهمت شركة جوجل أيضًا بفرض رقابة على نتائج البحث ذات الصلة، مما تسبب في استياء ترامب.

بشكل عام، تذكرنا أخطاء Meta AI مرة أخرى أنه بينما نتمتع بالراحة التي توفرها تكنولوجيا الذكاء الاصطناعي، يجب علينا أن نكون متيقظين لمخاطرها المحتملة وأن نعزز الإشراف والتوجيه لتكنولوجيا الذكاء الاصطناعي لضمان تطورها الصحي وتجنب إساءة استخدامها أو سوء استخدامها. يستخدم. بهذه الطريقة فقط يمكن للذكاء الاصطناعي أن يفيد البشرية حقًا.