في مجال تطوير البرمجيات، يؤدي تطبيق أدوات تشفير الذكاء الاصطناعي إلى إطلاق ثورة صامتة. تستخدم فرق التطوير البرمجة بمساعدة الذكاء الاصطناعي على نطاق واسع، ومع ذلك، تفتقر إدارة الشركة إلى الإشراف والرقابة الفعالة على استخدام أدوات الذكاء الاصطناعي. أدى هذا إلى إطلاق "لعبة القط والفأر" بين المطورين والإدارة فيما يتعلق بتطبيق أدوات الذكاء الاصطناعي والمخاطر الأمنية الناتجة.

في عالم التكنولوجيا، هناك لعبة القط والفأر تجري بين المطورين والإدارة. أبطال هذه اللعبة هم أدوات تشفير الذكاء الاصطناعي التي تم حظرها صراحةً من قبل الشركة ولكن لا يزال المطورون يستخدمونها بهدوء.

على الرغم من أن 15% من الشركات تحظر صراحة استخدام أدوات تشفير الذكاء الاصطناعي، إلا أن جميع فرق التطوير تقريبًا (99%) تستخدمها، وفقًا لبحث عالمي جديد أجرته شركة Checkmarx للأمن السحابي. تكشف هذه الظاهرة التحديات في التحكم في استخدام الذكاء الاصطناعي التوليدي.

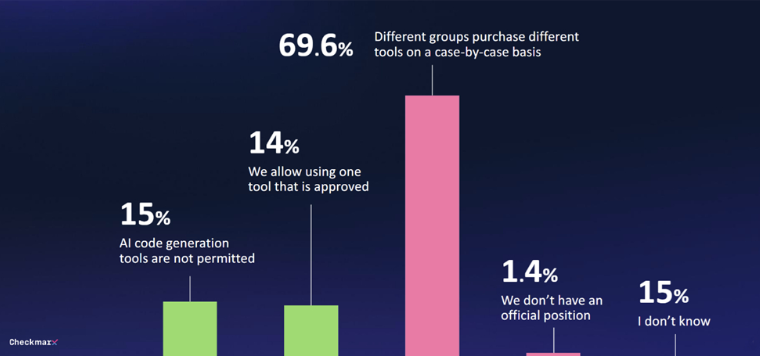

29% فقط من الشركات لديها شكل من أشكال الحوكمة لأدوات الذكاء الاصطناعي التوليدية. في 70% من الحالات، لا توجد استراتيجية موحدة ويتم اتخاذ قرارات الشراء بشكل مخصص من قبل الأقسام المختلفة. يجعل هذا الموقف من الصعب على الإدارة التحكم في استخدام أدوات تشفير الذكاء الاصطناعي.

مع انتشار أدوات تشفير الذكاء الاصطناعي، أصبحت المشكلات الأمنية بارزة بشكل متزايد. يشعر 80% من المشاركين بالقلق بشأن التهديدات المحتملة التي قد يجلبها المطورون عند استخدام الذكاء الاصطناعي، خاصة 60% ممن عبروا عن مخاوفهم بشأن "الهلوسة" التي يسببها الذكاء الاصطناعي.

على الرغم من المخاوف، فإن الاهتمام بإمكانيات الذكاء الاصطناعي لا يزال قويا. 47% من المشاركين منفتحون على السماح للذكاء الاصطناعي بإجراء تغييرات غير خاضعة للرقابة على التعليمات البرمجية. وقال 6% فقط إنهم لا يثقون في إجراءات أمان الذكاء الاصطناعي في بيئات البرمجيات.

وقال تسرويا: "تكشف ردود مسؤولي أمن المعلومات العالميين عن حقيقة أن المطورين يستخدمون الذكاء الاصطناعي في تطوير التطبيقات حتى لو لم يتمكنوا من إنشاء تعليمات برمجية آمنة بشكل موثوق باستخدام الذكاء الاصطناعي، مما يعني أن فرق الأمن بحاجة إلى التعامل مع سيل من الهجمات الجديدة والضعيفة". ".

وأظهر تقرير حديث من مؤشر اتجاهات العمل الخاص بشركة Microsoft نتائج مماثلة، حيث يستخدم العديد من الموظفين أدوات الذكاء الاصطناعي الخاصة بهم عندما لا يتم توفير أي منها. وفي كثير من الأحيان، لا يناقشون هذا الاستخدام، الذي يعيق التكامل المنهجي للذكاء الاصطناعي التوليدي في العمليات التجارية.

على الرغم من الحظر الصريح، لا يزال 99% من فرق التطوير يستخدمون أدوات الذكاء الاصطناعي لإنشاء التعليمات البرمجية. 29% فقط من الشركات أنشأت آليات حوكمة لاستخدام الذكاء الاصطناعي التوليدي. في 70% من الحالات، يتم اتخاذ القرارات المتعلقة باستخدام أدوات الذكاء الاصطناعي من قبل الأقسام المختلفة على أساس مخصص. وفي الوقت نفسه، تتزايد المخاوف الأمنية. 47% من المشاركين منفتحون على السماح للذكاء الاصطناعي بإجراء تغييرات غير خاضعة للرقابة على التعليمات البرمجية. تواجه فرق الأمن التحدي المتمثل في التعامل مع كميات كبيرة من التعليمات البرمجية التي يحتمل أن تكون عرضة للخطر والتي تم إنشاؤها بواسطة الذكاء الاصطناعي.

تستمر "لعبة القط والفأر" هذه بين المطورين والإدارة، وعلينا أن ننتظر ونرى إلى أين سيتجه مستقبل أدوات برمجة الذكاء الاصطناعي.

لقد أصبح تطبيق أدوات تشفير الذكاء الاصطناعي اتجاهًا، ولكن لا يمكن تجاهل المخاطر الأمنية التي يجلبها. تحتاج الشركات إلى إنشاء آلية حوكمة سليمة لتحقيق التوازن بين تحسينات الكفاءة التي يجلبها الذكاء الاصطناعي والمخاطر الأمنية المحتملة من أجل التكيف بشكل أفضل مع هذه الموجة التكنولوجية.