يحذر تقرير بحثي حديث أصدرته شركة Google من أن الذكاء الاصطناعي التوليدي (GenAI) يلوث الإنترنت بمحتوى زائف. وأشار التقرير إلى أن هناك حالات لا حصر لها من إساءة استخدام GenAI، بدءًا من التلاعب بالصور الشخصية وحتى تلفيق الأدلة، معظمها بغرض التأثير على الرأي العام أو الاحتيال أو الربح. أصبحت جوجل نفسها أيضًا صانعًا للمعلومات المضللة بسبب منتجات الذكاء الاصطناعي التي قدمت اقتراحات سخيفة، مما يجعل تحذيراتها أكثر إثارة للقلق ويدفع الناس إلى التفكير بعمق في المخاطر المحتملة لـ GenAI.

في الآونة الأخيرة، حذر باحثون في جوجل من أن الذكاء الاصطناعي التوليدي (GenAI) يدمر الإنترنت بمحتوى مزيف. وهذا ليس مجرد تحذير، ولكنه أيضًا وقت للتأمل الذاتي.

ومن عجيب المفارقات أن جوجل تلعب دوراً مزدوجاً في هذه "الحرب بين الحق والباطل". من ناحية، فهو مروج مهم للذكاء الاصطناعي التوليدي، ومن ناحية أخرى، فهو أيضًا منتج للمعلومات المضللة. تحتوي ميزة النظرة العامة على الذكاء الاصطناعي من Google على اقتراحات سخيفة مثل "وضع الغراء على البيتزا" و"تناول الصخور"، وفي النهاية كان لا بد من حذف هذه الرسائل الخاطئة يدويًا.

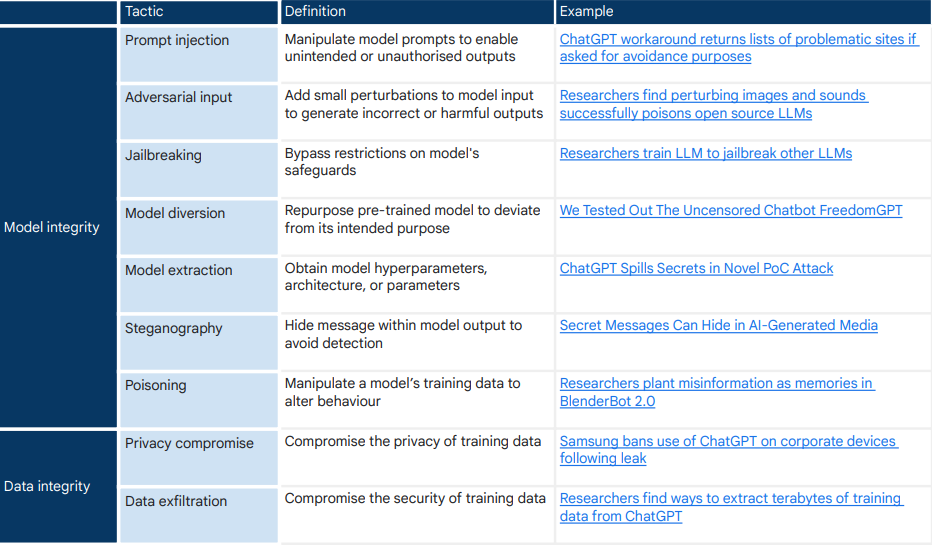

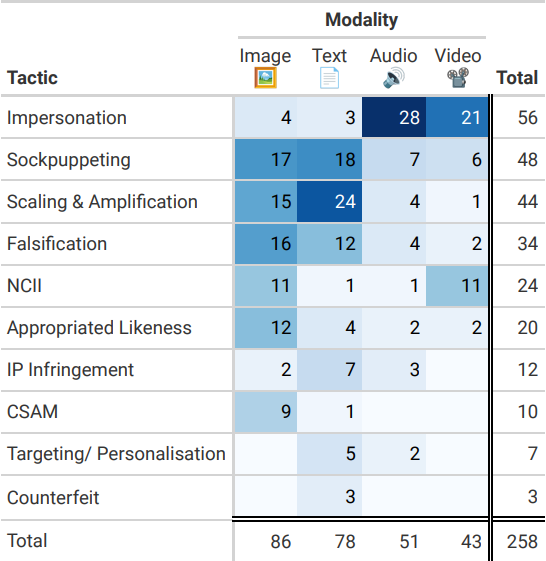

أجرى فريق البحث في Google تحقيقًا متعمقًا في 200 تقرير إخباري حول إساءة استخدام الذكاء الاصطناعي التوليدي، ووجد أن التلاعب بالصور البشرية وتلفيق الأدلة كانت أكثر أساليب إساءة الاستخدام شيوعًا. والغرض من هذه التصرفات ليس أكثر من التأثير على الرأي العام أو الاحتيال أو تحقيق الربح. ورغم أن مخاطر الذكاء الاصطناعي التوليدي لم ترتفع بعد إلى مستوى "التهديد الوجودي"، إلا أنها ما يحدث الآن وقد تتفاقم في المستقبل.

وجد الباحثون أن معظم حالات إساءة استخدام GenAI كانت استخدامًا عاديًا للنظام ولم تتضمن سلوك "كسر الحماية". ويمثل هذا النوع من "العمليات الروتينية" 90%. يتيح توفر GenAI على نطاق واسع وإمكانية الوصول إليه والواقعية المفرطة أشكالًا لا حصر لها من سوء الاستخدام على المستوى الأدنى. تكلفة توليد معلومات كاذبة منخفضة للغاية!

تأتي المواد البحثية لجوجل إلى حد كبير من تقارير وسائل الإعلام. هل هذا يعني أن استنتاجات البحث متحيزة من قبل وسائل الإعلام؟ تميل وسائل الإعلام أكثر إلى الإبلاغ عن الأحداث المثيرة، مما قد يتسبب في انحياز مجموعة البيانات نحو أنواع معينة من سوء الاستخدام. تشير 404Media إلى أن هناك الكثير من الانتهاكات غير المبلغ عنها للذكاء الاصطناعي التوليدي والتي لم نكن على علم بها بعد.

يمكن التحايل على "أسوار" أدوات الذكاء الاصطناعي بذكاء من خلال بعض النصائح. على سبيل المثال، يمكن لأداة استنساخ الصوت المدعمة بالذكاء الاصطناعي الخاصة بـ ElevenLabs تقليد أصوات الزملاء أو المشاهير بدرجة عالية من الدقة. يمكن لمستخدمي Civitai إنشاء صور للمشاهير تم إنشاؤها بواسطة الذكاء الاصطناعي، وعلى الرغم من أن النظام الأساسي لديه سياسة ضد NCII (الصور الحميمة دون موافقة)، فلا يوجد ما يمنع المستخدمين من استخدام أدوات مفتوحة المصدر لإنشاء NCII على أجهزتهم الخاصة.

فعندما تنتشر المعلومات الكاذبة، فإن الفوضى التي تعم شبكة الإنترنت سوف تضع اختباراً هائلاً لقدرة الناس على التمييز بين الحقيقة والباطل. وسوف نظل محاصرين في حالة دائمة من الشك، "هل هذا حقيقي؟" وإذا تُرِك هذا الأمر دون معالجة، فإن تلوث البيانات العامة بواسطة المحتوى الناتج عن الذكاء الاصطناعي قد يؤدي أيضا إلى إعاقة استرجاع المعلومات وتشويه التصورات الجماعية للواقع الاجتماعي السياسي أو الإجماع العلمي.

ساهمت Google في انتشار المحتوى الزائف الناتج عن الذكاء الاصطناعي التوليدي. الرصاصة التي أطلقت منذ سنوات عديدة أصابته أخيرًا بين حاجبيه اليوم. قد تكون أبحاث جوجل بداية للخلاص الذاتي ودعوة للاستيقاظ لمجتمع الإنترنت بأكمله.

عنوان الورقة: https://arxiv.org/pdf/2406.13843

لا شك أن تقرير Google هذا يبدو بمثابة تحذير للتطور المستقبلي لـ GenAI. إن كيفية تحقيق التوازن بين التطور التكنولوجي والسيطرة على المخاطر، وكيفية الاستجابة بفعالية لانتشار المعلومات الكاذبة التي تجلبها GenAI، هي تحديات مشتركة تواجه مجتمع التكنولوجيا العالمي والمجتمع. ونحن نتطلع إلى المزيد من الأبحاث والإجراءات للمحافظة بشكل مشترك على صحة ونقاء الإنترنت.