حققت نماذج اللغة المرئية (VLMs) تقدمًا كبيرًا في مجال الذكاء الاصطناعي، لكنها لا تزال تواجه تحديات في معالجة الصور عالية الدقة والنصوص المتنوعة. غالبًا ما تستخدم النماذج الحالية أجهزة تشفير مرئية ثابتة، وهي غير فعالة وتفتقر إلى الدقة في مجموعات البيانات المختلفة. كما أن الافتقار إلى التنوع وخصوصية المهام في مجموعة بيانات التدريب يحد من أدائها، خاصة في مهام المجال المتخصصة مثل تفسير الرسوم البيانية.

مع التطور السريع للذكاء الاصطناعي، أدى تكامل القدرات البصرية واللغوية إلى تقدم كبير في نماذج اللغة المرئية (VLMs). تم تصميم هذه النماذج لمعالجة وفهم البيانات المرئية والنصية في وقت واحد، وتستخدم على نطاق واسع في سيناريوهات مثل وصف الصورة، والإجابة على الأسئلة المرئية، والتعرف البصري على الأحرف، وتحليل المحتوى متعدد الوسائط.

لعبت VLMs دورًا مهمًا في تطوير الأنظمة المستقلة، وتعزيز التفاعل بين الإنسان والحاسوب، وأدوات معالجة المستندات الفعالة، مما أدى بنجاح إلى سد الفجوة بين هاتين الطريقتين للبيانات. ومع ذلك، لا تزال هناك العديد من التحديات في معالجة البيانات المرئية عالية الدقة ومدخلات النص المتنوعة.

لقد عالجت الأبحاث الحالية هذه القيود جزئيًا، لكن أجهزة التشفير المرئية الثابتة التي تعتمدها معظم النماذج تفتقر إلى القدرة على التكيف مع الدقة العالية وأحجام الإدخال المتغيرة. وفي الوقت نفسه، غالبًا ما يؤدي الجمع بين نماذج اللغة المدربة مسبقًا وأجهزة التشفير المرئية إلى عدم الكفاءة لأنها لم يتم تحسينها للمهام متعددة الوسائط. على الرغم من أن بعض النماذج تقدم تقنيات حوسبة متفرقة لإدارة التعقيد، إلا أن الدقة في مجموعات البيانات المختلفة لا تزال غير كافية. علاوة على ذلك، فإن مجموعات بيانات التدريب الخاصة بالنماذج الموجودة غالبًا ما تفتقر إلى التنوع وخصوصية المهام، مما يحد من أدائها. على سبيل المثال، يكون أداء العديد من النماذج ضعيفًا في المهام المتخصصة مثل تفسير المخططات أو التحليل المكثف للمستندات.

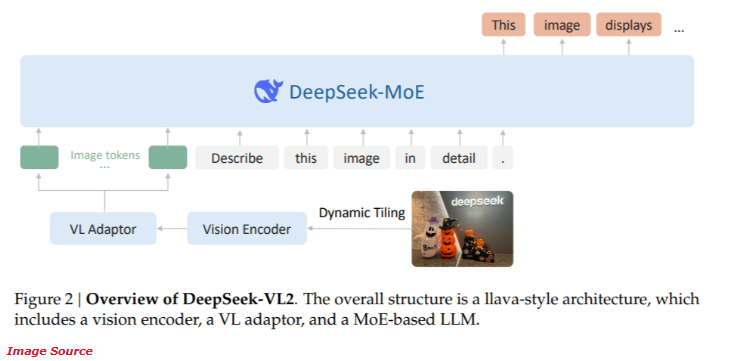

أطلقت DeepSeek-AI مؤخرًا سلسلة DeepSeek-VL2 الجديدة من نماذج اللغة المرئية للخبراء الهجين مفتوحة المصدر (MoE). تجمع هذه السلسلة من النماذج بين أحدث التقنيات المبتكرة، بما في ذلك التقطيع الديناميكي للتشفير المرئي، وآلية الانتباه الكامن متعدد الرؤوس، وإطار عمل DeepSeek-MoE.

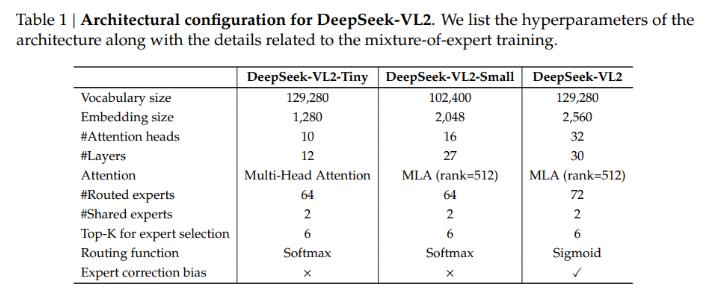

توفر سلسلة DeepSeek-VL2 ثلاثة تكوينات مختلفة للمعلمات:

- DeepSeek-VL2-Tiny: 3.37 مليار معلمة (1 مليار معلمة تنشيط)

- DeepSeek-VL2-Small: 16.1 مليار معلمة (2.8 مليار معلمة تنشيط)

- DeepSeek-VL2: 27.5 مليار معلمة (4.5 مليار معلمة تنشيط)

تضمن قابلية التوسع هذه قدرتها على التكيف مع احتياجات التطبيقات المختلفة وميزانيات الحوسبة.

تم تصميم بنية DeepSeek-VL2 لتحسين الأداء مع تقليل المتطلبات الحسابية. تضمن طريقة التقطيع الديناميكي معالجة الصور عالية الدقة دون فقدان التفاصيل المهمة، مما يجعلها مثالية لتحليل المستندات ومهام الترجمة المرئية. علاوة على ذلك، فإن آلية الانتباه الكامن متعدد الرؤوس تمكن النموذج من معالجة كميات كبيرة من البيانات النصية بكفاءة، مما يقلل من الحمل الحسابي المرتبط عادةً بمعالجة مدخلات اللغة الكثيفة. يغطي تدريب DeepSeek-VL2 مجموعات بيانات متنوعة متعددة الوسائط، مما يسمح له بأداء جيد في مجموعة متنوعة من المهام مثل التعرف البصري على الأحرف، والإجابة المرئية على الأسئلة، وتفسير المخططات.

وفقًا لاختبارات الأداء، حقق التكوين الصغير دقة تبلغ 92.3% في مهمة التعرف البصري على الأحرف، متجاوزًا بشكل كبير النماذج الحالية. في اختبار تحديد المواقع المرئية، تحسن النموذج من الدقة بنسبة 15% مقارنة بمنتج الجيل السابق.

وفي الوقت نفسه، يقلل DeepSeek-VL2 من متطلبات موارد الحوسبة بنسبة 30% مع الحفاظ على الدقة المتطورة. وتبين هذه النتائج تفوق هذا النموذج في معالجة الصور والنصوص عالية الدقة.

مدخل المشروع: https://huggingface.co/collections/deepseek-ai/deepseek-vl2-675c22accc456d3beb4613ab

أبرز النقاط:

توفر سلسلة DeepSeek-VL2 مجموعة متنوعة من تكوينات المعلمات للتكيف مع احتياجات التطبيقات المختلفة.

تعمل تقنية التقطيع الديناميكي على تحسين كفاءة معالجة الصور عالية الدقة وهي مناسبة لتحليل المستندات المعقدة.

يؤدي النموذج أداءً جيدًا في مهام التعرف البصري على الأحرف والتعريب البصري، مع دقة محسنة بشكل ملحوظ.

حققت نماذج سلسلة DeepSeek-VL2 اختراقات جديدة في مجال نماذج اللغة المرئية بفضل بنيتها المبتكرة وأدائها الممتاز. إن مزاياه في الصور عالية الدقة ومعالجة النصوص المعقدة تجعله يظهر إمكانات كبيرة في العديد من سيناريوهات التطبيق ويستحق المزيد من الاهتمام والبحث.