تم تصميم أحدث نماذج الذكاء الاصطناعي من السلسلة o من OpenAI لتحسين أمان أنظمة الذكاء الاصطناعي من خلال فهم أعمق للقواعد وقدرات التفكير المنطقي. يختلف هذا النموذج عن الاعتماد فقط على التعلم النموذجي في الماضي، حيث يمكنه فهم إرشادات الأمان وتطبيقها بشكل استباقي لحظر الطلبات الضارة بشكل فعال. توضح المقالة تفاصيل عملية التدريب المكونة من ثلاث مراحل لنموذج o1 وأدائه بما يتجاوز أنظمة الذكاء الاصطناعي السائدة الأخرى في اختبارات الأمان. ومع ذلك، حتى مع تحسين نموذج o1، لا تزال هناك إمكانية للتلاعب، مما يسلط الضوء على التحديات المستمرة في مجال سلامة الذكاء الاصطناعي.

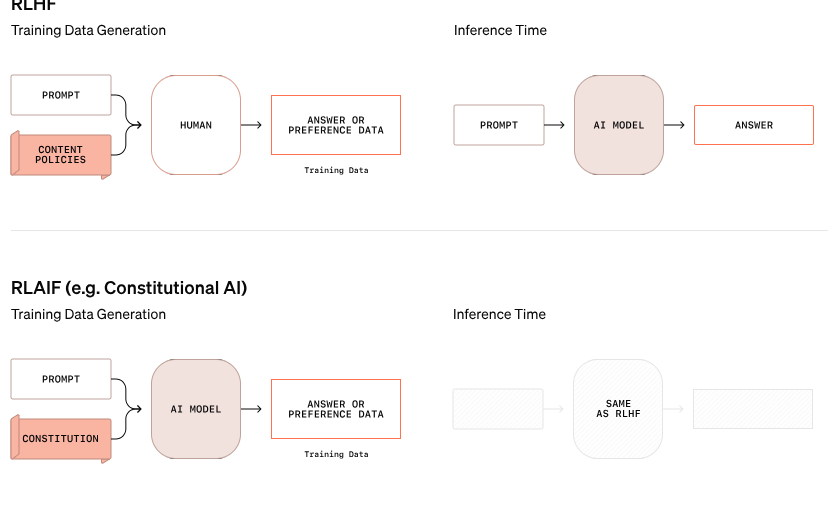

أعلنت OpenAI عن نهج جديد لأمن الذكاء الاصطناعي يهدف إلى تحسين أمان أنظمة الذكاء الاصطناعي من خلال تغيير الطريقة التي تتعامل بها مع قواعد الأمان. لم يعد نموذج O-Series الجديد يعتمد فقط على تعلم السلوك الجيد والسيئ من الأمثلة، ولكنه قادر على فهم إرشادات السلامة المحددة والتفكير فيها بشكل فعال.

في أحد الأمثلة من بحث OpenAI، عندما حاول مستخدم الحصول على تعليمات لنشاط غير قانوني عبر نص مشفر، نجح النموذج في فك تشفير المعلومات ولكنه رفض الطلب، مشيرًا على وجه التحديد إلى قاعدة الأمان التي سيتم انتهاكها. توضح عملية الاستدلال خطوة بخطوة مدى فعالية النموذج في اتباع إرشادات السلامة ذات الصلة.

تنقسم عملية التدريب لهذا النموذج o1 إلى ثلاث مراحل. أولاً، يتعلم النموذج كيفية المساعدة. بعد ذلك، ومن خلال التعلم الخاضع للإشراف، يدرس النموذج إرشادات محددة للسلامة. أخيرًا، يستخدم النموذج التعلم المعزز للتدرب على تطبيق هذه القواعد، وهي خطوة تساعد النموذج على فهم إرشادات السلامة واستيعابها حقًا.

في اختبارات OpenAI، كان أداء نموذج o1 الذي تم إطلاقه حديثًا أفضل بكثير من الأنظمة السائدة الأخرى من حيث الأمان، مثل GPT-4o وClaude3.5Sonnet وGemini1.5Pro. أظهر الاختبار، الذي تضمن كيفية رفض النموذج للطلبات الضارة والسماح للطلبات المناسبة بالمرور، أن نموذج o1 حقق أعلى الدرجات في كل من الدقة ومقاومة محاولات كسر الحماية.

قال المؤسس المشارك لـ OpenAI Wojciech Zaremba على منصات التواصل الاجتماعي إنه فخور جدًا بهذا العمل "المواءم المدروس" ويعتقد أن هذا النوع من نموذج الاستدلال يمكن مواءمته بطريقة جديدة تمامًا، خاصة عند تطوير الذكاء العام الاصطناعي (AGI). ويمثل ضمان توافق النظام مع القيم الإنسانية تحديًا كبيرًا.

على الرغم من ادعاءات OpenAI بالتقدم، أظهر متسلل يُدعى "Pliny the Liberator" أنه حتى نماذج o1 وo1-Pro الجديدة يمكن التلاعب بها لخرق الإرشادات الأمنية. نجح بليني في الحصول على النموذج لإنشاء محتوى للبالغين وحتى مشاركة تعليمات صنع زجاجات المولوتوف، على الرغم من أن النظام رفض هذه الطلبات في البداية. تسلط هذه الحوادث الضوء على صعوبة السيطرة على أنظمة الذكاء الاصطناعي المعقدة هذه لأنها تعمل على أساس الاحتمالات وليس القواعد الصارمة.

وقال زاريمبا إن OpenAI لديها حوالي 100 موظف مخصصين لسلامة الذكاء الاصطناعي والاتساق مع القيم الإنسانية. وأثار تساؤلات حول أساليب المنافسين في مجال الأمن، ولا سيما XAI الخاص بـ Elon Musk، والذي يعطي الأولوية لنمو السوق على التدابير الأمنية وAnthropic، التي أطلقت مؤخرًا وكيلًا للذكاء الاصطناعي دون ضمانات مناسبة، ويعتقد زاريمبا أن هذا سيجلب "ردود فعل سلبية كبيرة" إلى OpenAI.

المدونة الرسمية: https://openai.com/index/deliberative-alignment/

أبرز النقاط:

يمكن لنماذج سلسلة o الجديدة من OpenAI التفكير بشكل استباقي بشأن قواعد الأمان وتحسين أمان النظام.

يتفوق نموذج o1 على أنظمة الذكاء الاصطناعي السائدة الأخرى في رفض الطلبات الضارة والدقة.

وعلى الرغم من التحسينات، لا يزال من الممكن التلاعب بالنماذج الجديدة، ولا تزال التحديات الأمنية شديدة.

بشكل عام، حققت نماذج السلسلة o الخاصة بـ OpenAI تقدمًا كبيرًا في مجال أمان الذكاء الاصطناعي، ولكنها كشفت أيضًا عن التعقيد والتحديات المستمرة لأمن نماذج اللغات الكبيرة. في المستقبل، يجب مواصلة بذل المزيد من الجهود للتعامل بشكل حقيقي وفعال مع المخاطر الأمنية للذكاء الاصطناعي.