مع التطور السريع لنماذج اللغة الكبيرة متعددة الوسائط (MLLM)، أصبح التكامل الفعال لطرائق اللغة والبصرية والكلام نقطة ساخنة للبحث. ومع ذلك، فإن التحديات الناجمة عن الاختلافات الأساسية في بيانات الوسائط المختلفة، مثل المعلومات المكانية للرؤية ومعلومات السلاسل الزمنية للكلام، تعيق التفاعل الفعال متعدد الوسائط. غالبًا ما تعتمد الأساليب الحالية على وحدات ASR وTTS المستقلة، مما يزيد من زمن الوصول ويقلل من سلاسة التفاعل. تقدم هذه المقالة VITA-1.5، وهو نموذج لغة متعدد الوسائط واسع النطاق يدمج الرؤية واللغة والكلام، بهدف حل هذه المشكلات.

في الآونة الأخيرة، تم إحراز تقدم كبير في نماذج اللغات الكبيرة متعددة الوسائط (MLLM)، وخاصة في تكامل الطرائق البصرية والنصية. ومع ذلك، مع تزايد شعبية التفاعل بين الإنسان والحاسوب، أصبحت أهمية طرائق الكلام بارزة بشكل متزايد، وخاصة في أنظمة الحوار متعدد الوسائط. لا يعد الصوت وسيلة رئيسية لنقل المعلومات فحسب، بل إنه يعمل أيضًا على تحسين طبيعة التفاعلات وملاءمتها بشكل كبير.

ومع ذلك، نظرًا للاختلافات الأساسية بين البيانات المرئية والكلامية، فإن دمجها في MLLM ليس بالأمر الهين. على سبيل المثال، تنقل البيانات المرئية المعلومات المكانية، بينما تنقل بيانات الكلام التغييرات الديناميكية في السلاسل الزمنية. تجلب هذه الاختلافات الأساسية تحديات أمام التحسين المتزامن للطريقتين، مما يؤدي في كثير من الأحيان إلى صراعات أثناء عملية التدريب. بالإضافة إلى ذلك، تعتمد أنظمة تحويل الكلام إلى كلام التقليدية على وحدات منفصلة للتعرف التلقائي على الكلام (ASR) وتحويل النص إلى كلام (TTS)، مما يزيد من زمن الوصول ويقلل من التماسك، مما يحد من فائدتها في تطبيقات الوقت الفعلي.

ولمواجهة هذه التحديات، أطلق الباحثون VITA-1.5، وهو نموذج لغوي متعدد الوسائط واسع النطاق يدمج الرؤية واللغة والكلام. يستخدم VITA-1.5 طريقة تدريب ثلاثية المراحل مصممة بعناية لتقديم البيانات المرئية والكلامية تدريجيًا للتخفيف من تعارضات الوسائط مع الحفاظ على أداء قوي متعدد الوسائط.

في المرحلة الأولى، يركز النموذج على التدريب البصري اللغوي، وبناء قدرات بصرية قوية من خلال تدريب المحولات البصرية وضبط النموذج باستخدام التسميات التوضيحية وبيانات الأسئلة والأجوبة المرئية.

تقدم المرحلة الثانية معالجة إدخال الصوت، من خلال تدريب برنامج تشفير الصوت باستخدام البيانات المقترنة لنسخ الكلام، ثم ضبطه باستخدام بيانات أسئلة وأجوبة الكلام، حتى يتمكن النموذج من فهم إدخال الصوت والاستجابة له بشكل فعال. أخيرًا، في المرحلة الثالثة، يتم تدريب وحدة فك ترميز الصوت لتحقيق إخراج الكلام من طرف إلى طرف دون الحاجة إلى وحدات TTS خارجية، وبالتالي تمكين VITA-1.5 من إنشاء ردود كلام سلسة وتعزيز الطبيعة والتفاعلية للحوار متعدد الوسائط أنظمة.

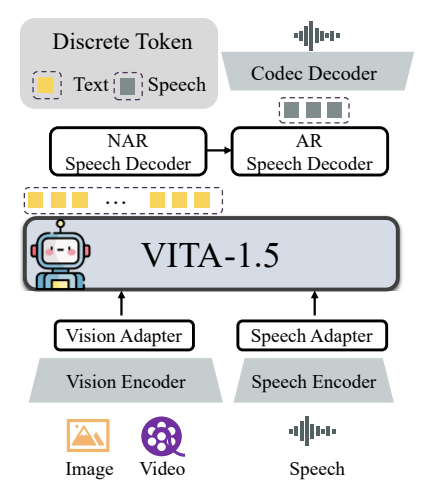

تتضمن البنية العامة لـ VITA-1.5 أجهزة تشفير ومحولات مرئية وصوتية للاتصال بنماذج اللغات الكبيرة. يحتوي الإخراج على وحدة توليد الكلام من طرف إلى طرف بدلاً من استخدام نموذج TTS خارجي مثل الإصدار VITA-1.0 الأصلي. يستخدم جهاز التشفير المرئي InternViT-300M، ويبلغ حجم الصورة المدخلة 448 × 448 بكسل، وكل صورة تولد 256 رمزًا مرئيًا.

بالنسبة للصور عالية الدقة، يعتمد VITA-1.5 استراتيجية تصحيح ديناميكية لالتقاط التفاصيل المحلية. يتم التعامل مع الفيديو كنوع خاص من إدخال الصور المتعددة، مع أخذ عينات من الإطارات بناءً على طول الفيديو. تتكون وحدة التشفير الصوتي من طبقات تلافيفية متعددة الاختزال و24 كتلة محولات، بمعدل إطار إخراج يبلغ 12.5 هرتز. يتكون محول الصوت من طبقات تلافيفية متعددة مع اختزال 2x. يتم استخدام TiCodec كنموذج ترميز، والذي يقوم بتشفير إشارة الكلام المستمرة إلى رموز خطاب منفصلة بتردد 40 هرتز، وهو قادر على فك تشفيرها مرة أخرى إلى إشارة الكلام بمعدل أخذ عينات يبلغ 24000 هرتز. لتمكين النموذج من إخراج الرموز المميزة للكلام، تتم إضافة جهازي فك ترميز الكلام بعد الرموز المميزة للنص: وحدة فك ترميز الكلام غير الانحداري (NAR) ووحدة فك ترميز الكلام الانحداري التلقائي (AR).

تغطي بيانات التدريب الخاصة بـ VITA-1.5 نطاقًا واسعًا من الفئات، مثل بيانات الترجمة وبيانات الأسئلة والأجوبة، بما في ذلك الصينية والإنجليزية. في مراحل التدريب المختلفة، يتم أخذ عينات من مجموعات فرعية من مجموعة البيانات بأكملها بشكل انتقائي لخدمة أهداف مختلفة. يتم تنفيذ استراتيجية التدريب على ثلاث مراحل:

المرحلة الأولى: التدريب البصري اللغوي، بما في ذلك المحاذاة البصرية والفهم البصري والضبط البصري تحت الإشراف، ويهدف إلى سد الفجوة بين الرؤية واللغة وتمكين النموذج من فهم محتوى الصورة والإجابة على الأسئلة البصرية.

المرحلة 2: تم تصميم ضبط إدخال الصوت، بما في ذلك محاذاة الصوت والضبط الدقيق للصوت تحت الإشراف، لتمكين النموذج من فهم إدخال الصوت والتفاعل من خلال الأسئلة الصوتية والإجابات النصية.

المرحلة الثالثة: تم تصميم ضبط إخراج الصوت، بما في ذلك التدريب على برنامج الترميز وتدريب وحدة فك ترميز NAR + AR، لتمكين النموذج من إنشاء مخرجات الكلام وتحقيق التفاعل الصوتي الشامل.

أجرى الباحثون تقييمًا شاملاً لمعايير مختلفة لفهم الصور والفيديو والكلام وقارنوا النتائج بنماذج مفتوحة المصدر ونماذج خاصة. تظهر النتائج أن VITA-1.5 يُظهر قدرات إدراكية واستدلالية قابلة للمقارنة مع MLLM الرائدة في مهام الصور والفيديو، ويحقق تحسينات كبيرة في قدرات الكلام. على سبيل المثال، في معيار فهم الصورة، يعمل VITA-1.5 على قدم المساواة مع أحدث النماذج مفتوحة المصدر بل ويتجاوز بعض النماذج مغلقة المصدر. فيما يتعلق بفهم الفيديو، يعمل VITA-1.5 على قدم المساواة مع أفضل النماذج مفتوحة المصدر. بالإضافة إلى ذلك، حقق VITA-1.5 دقة رائدة في مهام ASR باللغتين الصينية والإنجليزية، متجاوزًا نماذج الكلام الاحترافية.

بشكل عام، نجح VITA-1.5 في دمج الرؤية والكلام من خلال استراتيجية تدريب ثلاثية المراحل مصممة بعناية، مما يحقق قدرات قوية في فهم الرؤية والكلام، مما يتيح التفاعل الفعال بين الكلام دون الاعتماد على وحدة ASR أو TTS المنفصلة. من المتوقع أن يعزز هذا البحث تقدم النماذج مفتوحة المصدر في مجال التفاعل متعدد الوسائط في الوقت الفعلي.

عنوان المشروع: https://github.com/VITA-MLLM/VITA

يمثل ظهور VITA-1.5 مرحلة جديدة في تطوير نماذج لغوية متعددة الوسائط وواسعة النطاق. إن إمكانات توليد الكلام الشاملة والأداء الممتاز في مهام فهم الصور والفيديو والكلام ستبني بيئة أكثر طبيعية وسلاسة نموذج لغة متعدد الوسائط للمستقبل توفر الأنظمة التفاعلية الديناميكية إمكانيات جديدة. تستحق نتيجة البحث هذه الاهتمام ومن المتوقع أن تلعب دورًا مهمًا في التطبيقات العملية.