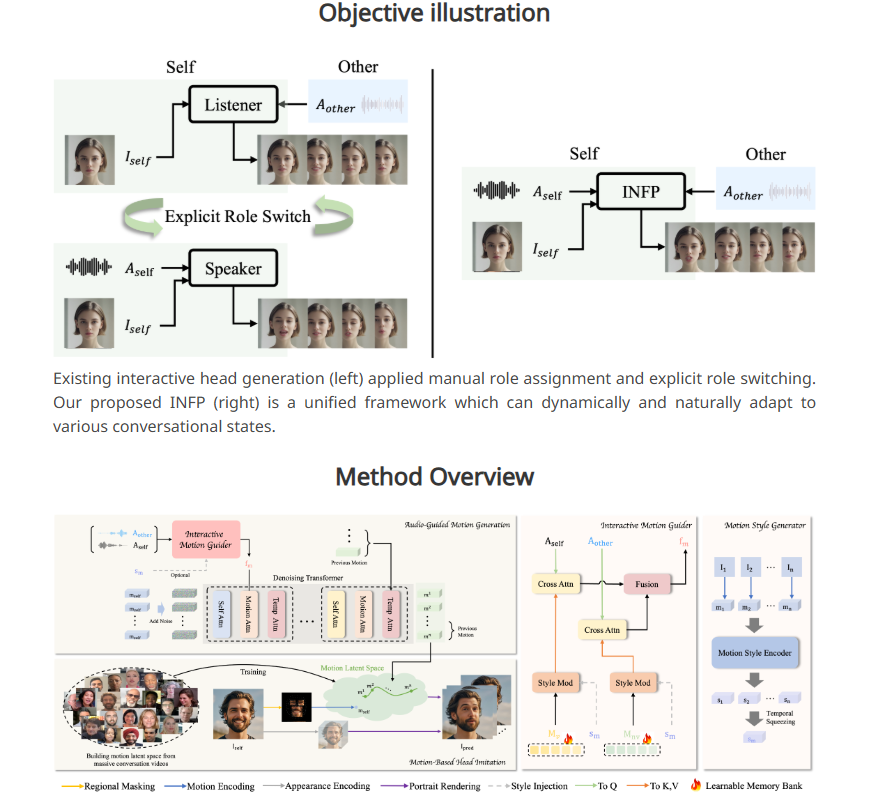

أطلقت ByteDance نظامًا جديدًا للذكاء الاصطناعي، INFP، والذي يمكّن الصور الشخصية الثابتة من "التحدث" والتفاعل من خلال إدخال الصوت. على عكس التكنولوجيا التقليدية، لا يحتاج INFP إلى تحديد الأدوار يدويًا، حيث يمكن للنظام الحكم تلقائيًا بناءً على المحادثة، مما يحسن الكفاءة والراحة بشكل كبير. تكمن تقنيتها الأساسية في خطوتين "تقليد الرأس القائم على الحركة" و"توليد الحركة الموجهة بالصوت". ومن خلال تحليل تعبيرات الوجه وحركات الرأس وإدخال الصوت في المحادثات، فإنها تولد أنماط حركة طبيعية وسلسة لجعل الصور الثابتة تأتي. الى الحياة. من أجل تدريب INFP، قامت ByteDance أيضًا ببناء مجموعة بيانات DyConv تحتوي على أكثر من 200 ساعة من مقاطع فيديو المحادثة الحقيقية لضمان إخراج عالي الجودة للنظام.

هناك خطوتان رئيسيتان لسير عمل INFP. في الخطوة الأولى، التي تسمى "تقليد الرأس القائم على الحركة"، يستخرج النظام التفاصيل من الفيديو عن طريق تحليل تعبيرات وجه الأشخاص وحركات الرأس أثناء المحادثات. يتم تحويل بيانات الحركة هذه إلى تنسيق يمكن استخدامه في الرسوم المتحركة اللاحقة، مما يسمح للصور الثابتة بمطابقة حركة الشخصية الأصلية.

والخطوة الثانية هي "توليد الحركة الموجهة بالصوت"، حيث يقوم النظام بإنشاء أنماط حركة طبيعية بناءً على إدخال الصوت. وقام فريق البحث بتطوير "دليل الحركة" الذي يقوم بتحليل الصوت من كلا الطرفين في المحادثة لإنشاء أنماط حركة للتحدث والاستماع. يقوم مكون الذكاء الاصطناعي المسمى Diffusion Transformer بتحسين هذه الأنماط تدريجيًا، مما يؤدي إلى حركة سلسة وواقعية تتطابق تمامًا مع محتوى الصوت.

ومن أجل تدريب النظام بشكل فعال، أنشأ فريق البحث أيضًا مجموعة بيانات حوار تسمى DyConv، والتي تجمع أكثر من 200 ساعة من مقاطع فيديو الحوار الحقيقي. بالمقارنة مع قواعد بيانات المحادثة الموجودة مثل ViCo وRealTalk، تتمتع DyConv بمزايا فريدة في التعبير العاطفي وجودة الفيديو.

وتقول ByteDance إن INFP يتفوق على الأدوات الموجودة في العديد من المجالات الرئيسية، لا سيما في مطابقة حركات الشفاه مع الكلام، والحفاظ على ملامح الوجه الفردية، وإنشاء حركات طبيعية متنوعة. علاوة على ذلك، كان أداء النظام جيدًا بنفس القدر عند إنشاء مقاطع فيديو يتم فيها سماع المحاور فقط.

على الرغم من أن INFP يدعم حاليًا إدخال الصوت فقط، إلا أن فريق البحث يستكشف إمكانية توسيع النظام ليشمل الصور والنصوص. والهدف المستقبلي هو أن نكون قادرين على إنشاء رسوم متحركة واقعية لجسم الشخصية بالكامل. ومع ذلك، وبالنظر إلى أن هذا النوع من التكنولوجيا يمكن استخدامه لإنشاء مقاطع فيديو مزيفة ونشر معلومات مضللة، يخطط فريق البحث لتقييد استخدام التكنولوجيا الأساسية للمؤسسات البحثية، على غرار إدارة مايكروسوفت لنظام الاستنساخ الصوتي المتقدم الخاص بها.

تعد هذه التكنولوجيا جزءًا من استراتيجية الذكاء الاصطناعي الأوسع لشركة ByteDance، وبالاعتماد على تطبيقاتها الشهيرة TikTok وCapCut، تمتلك ByteDance منصة تطبيقات مبتكرة واسعة النطاق للذكاء الاصطناعي.

مدخل المشروع: https://grisoon.github.io/INFP/

أبرز النقاط:

يمكن لـ INFP السماح للصور الثابتة "بالتحدث" من خلال الصوت وتحديد دور الحوار تلقائيًا.

يعمل النظام في خطوتين: أولا، يستخرج تفاصيل الحركة في المحادثات البشرية، وثانيا، يحول الصوت إلى أنماط حركة طبيعية.

تحتوي مجموعة بيانات DyConv من ByteDance على أكثر من 200 ساعة من مقاطع فيديو المحادثة عالية الجودة للمساعدة في تحسين أداء النظام.

يُظهر إطلاق نظام INFP القوة الابتكارية التي تتمتع بها ByteDance في مجال الذكاء الاصطناعي، حيث إن إمكانات التطوير المستقبلية لديها هائلة، ولكن يجب أيضًا التعامل مع المخاطر الأخلاقية المحتملة بعناية. يجب أن يكون التقدم التكنولوجي موجهًا دائمًا نحو المصالح الاجتماعية والتأكد من استخدامه لصالح البشرية.