تقدم هذه المقالة طريقة LLM2CLIP التي طورتها Microsoft بالتعاون مع جامعة Tongji ، والتي تهدف إلى تحسين أداء التشفير البصري لنموذج المقطع وحل حدوده في التعامل مع أوصاف النص الطويلة والمعقدة. يعزز LLM2CLIP بشكل كبير قدرة النموذج على مطابقة الصور والنص من خلال دمج نماذج اللغة الكبيرة (LLMS) وتقديم تقنية "تباين العنوان". توضح النتائج التجريبية لهذه الطريقة على مجموعات بيانات متعددة أنه في مهام استرجاع الصورة إلى النص والرسالة ، لا سيما مهام استرجاع النص الطويلة والقصيرة ، فإنها تتجاوز نماذج المقطع التقليدي و EVA ويظهرون معالجة قوية عبر اللغة قدرة.

في مجال العلوم والتكنولوجيا اليوم ، يعد مقطع (صورة ما قبل التدريب اللغوية المتناقضة) نموذجًا أساسيًا مهمًا متعدد الوسائط. فهو يجمع بين الإشارات المرئية والنصية في مساحة ميزة مشتركة باستخدام خسائر التعلم على النقيض على أزواج نص صور واسعة النطاق.

بصفته باحثًا ، يمكن أن يدعم المقطع مهام مختلفة مثل تصنيف الصفر والكشف والتجزئة واسترجاع نص الصور. وفي الوقت نفسه ، بصفته مستخرجًا من الميزات ، يهيمن على جميع مهام التمثيل عبر الوسائط تقريبًا مثل فهم الصور وفهم الفيديو وتوليد نص أو صورة نصية. ما هو قوي في مقطع هو قدرته على توصيل الصور باللغة الطبيعية والتقاط المعرفة الإنسانية ، وذلك بفضل تدريبها على بيانات الشبكة الواسعة النطاق ، والتي تحتوي على أوصاف نصية مفصلة.

ومع ذلك ، فإن المقطع لديه قيود معينة في التعامل مع أوصاف النص الطويلة والمعقدة. للتغلب على هذه المشكلة ، اقترح الباحثون من جامعة Microsoft و Tongji طريقة LLM2CLIP ، بهدف تعزيز تعلم التمثيل البصري من خلال دمج نماذج اللغة الكبيرة (LLMS). تحل هذه الطريقة بجرأة محل تشفير نص مقطع الأصلي وتستخدم المعرفة الغنية لـ LLMS لتحسين أداء المشفر البصري للمقطع. وجدت الدراسة أن دمج LLMS مباشرة في مقطع يؤدي إلى تدهور الأداء ، لذلك يجب معالجة هذا التحدي.

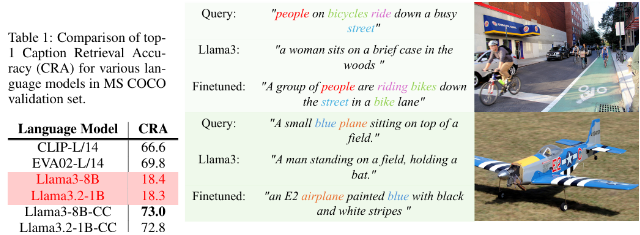

تعمل طريقة LLM2CLIP بشكل كبير على تحسين قدرة LLM على فصل عناوين الصور من خلال تقديم تقنية "تباين العنوان النقيلي" ، وبالتالي تحقيق تحسين كبير في الأداء.

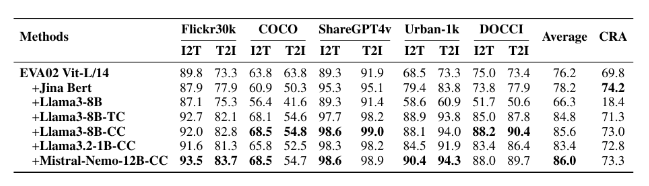

استخدم الباحثون مجموعات بيانات بأحجام مختلفة لتجارب الضبط الدقيقة ، بما في ذلك CC-3M الصغيرة ، CC-3M و CC-12M ، بالإضافة إلى CC-3M ، CC-12M ، YFCC-15M و RECAPTION-1B. تبين النتائج أن النموذج الذي تم تدريبه باستخدام LLM2CLIP يؤدي بشكل أفضل من نماذج المقطع التقليدي و EVA في مهام الاسترجاع من صورة إلى نص إلى نص.

من خلال الجمع بين التدريب متعدد الوسائط ونماذج مثل LLAVA 1.5 ، كان أداء LLM2CLIP جيدًا في جميع المعايير تقريبًا ، خاصة عند التعامل مع مهام استرجاع النص الطويلة والقصيرة ، مما يؤدي إلى تحسين أداء نموذج EVA02 السابق بنسبة 16.5 ٪. هذا النهج المبتكر لا يحول مقطعًا من ببساطة معالجة البيانات الإنجليزية إلى نموذج قوي للعبة ، بل يضع أيضًا أساس الأبحاث المستقبلية حول التدريب على المقطع.

النموذج: https://huggingface.co/Collections/Microsoft/llm2clip-672323a266173cfa40b32d4c

الرمز: https://github.com/microsoft/llm2clip/

ورقة: https://arxiv.org/abs/2411.04997

نقاط:

LLM2CLIP هو نهج مبتكر اقترحته جامعة Microsoft و Tongji بالتعاون مع جامعة Tongji ، بهدف تحسين أداء التشفير البصري عن طريق استبدال مشفرات نص Clip.

تعزز هذه الطريقة بشكل كبير قدرة النموذج على مطابقة الصور مع النص من خلال تقنية "تباين العنوان" ، متجاوزًا النماذج الحديثة.

تُظهر تجارب LLM2CLIP على مجموعات بيانات متعددة أنها تؤدي أفضل من النماذج التقليدية في مهام استرجاع النص الطويلة والقصيرة ، مما يؤدي إلى تطوير نماذج متعددة اللغة.

باختصار ، توفر طريقة LLM2CLIP أفكارًا جديدة لتحسين نموذج المقطع. روابط الموارد ذات الصلة مريحة للقراء للتعلم والبحث.