أجرى الباحثون في جامعة برينستون وجامعة ييل أبحاثًا متعمقة حول قدرة التفكير "سلسلة التفكير (COT)" لنماذج اللغة الكبيرة (LLM) وأصدرت التقارير ذات الصلة. استغرقت الدراسة تكسير كلمة مرور التحول كمهمة اختبار واختارت ثلاثة LLMS GPT-4 و CLAUDE3 و LLAMA3.1 للتحليل ، بهدف الكشف عن الآلية الكامنة وراء استنتاج المهد. لقد وجدت الأبحاث أن تفكير COT الخاص بـ LLM ليس سببًا منطقيًا رمزيًا بسيطًا ، ولكنه نتيجة للتفاعل المعقد للعوامل المتعددة ، والذي يوفر منظوراً جديداً لنا لفهم قدرة التفكير في LLM.

أصدر الباحثون في جامعة برينستون وجامعة ييل مؤخرًا تقريراً عن قدرة "ربط سلسلة (COT)" في نموذج اللغة الكبير (LLM) ، مما يكشف عن سر التفكير في المهد: إنه ليس منطقيًا رمزيًا فقط على القواعد المنطقية ، ولكن فهو يجمع بين الذاكرة والاحتمالية والتفكير في الضوضاء.

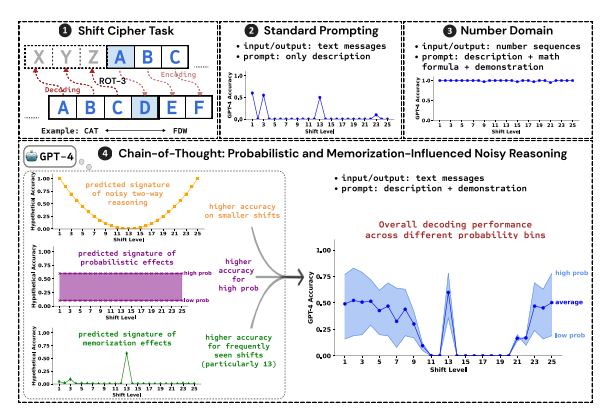

استخدم الباحثون تكسير كلمة مرور التحول كمهمة اختبار لتحليل أداء LLMS الثلاثة ، GPT-4 ، CLAUDE3 و LLAMA3.1. تعد كلمات مرور التحول طريقة ترميز بسيطة ، ويتم استبدال كل حرف بأحرف تتحرك للأمام في الأبجدية بأرقام ثابتة. على سبيل المثال ، حرك الأبجدية للأمام بنسبة 3 أرقام ويصبح "CAT" "FDW".

تظهر نتائج البحث أن العوامل الرئيسية الثلاثة التي تؤثر على فعالية استدلال المهد هي:

الاحتمال: تميل LLM إلى إنشاء مخرجات ذات احتمال أعلى ، حتى لو كانت خطوة الاستدلال تشير إلى إجابات ذات احتمال أقل. على سبيل المثال ، إذا كانت خطوة التفكير تشير إلى "Staz" ، ولكن "Stay" هي الكلمة الأكثر شيوعًا ، فقد "LLM" تصحيح نفسها "وإخراج" البقاء ".

الذاكرة: تتذكر LLM كمية كبيرة من البيانات النصية أثناء التدريب المسبق ، مما يؤثر على دقة استنتاج سريره. على سبيل المثال ، يعد ROT-13 كلمة مرور التحول الأكثر شيوعًا ، ولديه LLM دقة أعلى بكثير على ROT-13 من الأنواع الأخرى من كلمات مرور التحول.

تفكير الضوضاء: عملية التفكير في LLM ليست دقيقة تمامًا ، ولكن هناك درجة معينة من الضوضاء. مع زيادة إزاحة كلمة مرور التحول ، تزداد الخطوات الوسيطة المطلوبة لفك التشفير ، ويصبح تأثير استنتاج الضوضاء أكثر وضوحًا ، مما يؤدي إلى انخفاض في دقة LLM.

ووجد الباحثون أيضًا أن تفكير COT الخاص بـ LLM يعتمد على تكييف الذات ، أي يحتاج LLM إلى إنشاء النص بشكل صريح كسياق لخطوات التفكير اللاحقة. إذا تم توجيه LLM إلى "التفكير بصمت" دون إخراج أي نص ، فسيتم تقليل قدرتها على التفكير إلى حد كبير. بالإضافة إلى ذلك ، فإن فعالية خطوة العرض التوضيحي لها تأثير ضئيل على استنتاج المهد.

توضح هذه الدراسة أن تفكير COT الخاص بـ LLM ليس سببًا رمزيًا مثاليًا ، ولكنه يجمع بين عوامل متعددة مثل الذاكرة والاحتمال والتفكير في الضوضاء. لا يوضح LLM خصائص سيد الذاكرة في عملية التفكير في COT ، ولكن أيضًا يوضح نمط سيد الاحتمال. يساعدنا هذا البحث على فهم أعمق لقدرات التفكير في LLM وتوفير رؤى قيمة للتطوير المستقبلي لأنظمة الذكاء الاصطناعى الأكثر قوة.

عنوان الورق: https://arxiv.org/pdf/2407.01687

باختصار ، هذه الدراسة ذات أهمية كبيرة لفهم آلية التفكير لنماذج اللغة الكبيرة ، وتوفر نتائجها مرجعًا قيمة لتحسين قدرات التفكير في LLM في المستقبل وتطوير أنظمة الذكاء الاصطناعى الأكثر قوة. تؤكد الدراسة على تأثير العوامل مثل الاحتمال والذاكرة والضوضاء على التفكير في LLM ، مما يوفر اتجاهات جديدة للباحثين في مجال الذكاء الاصطناعي.