ControlAnimate

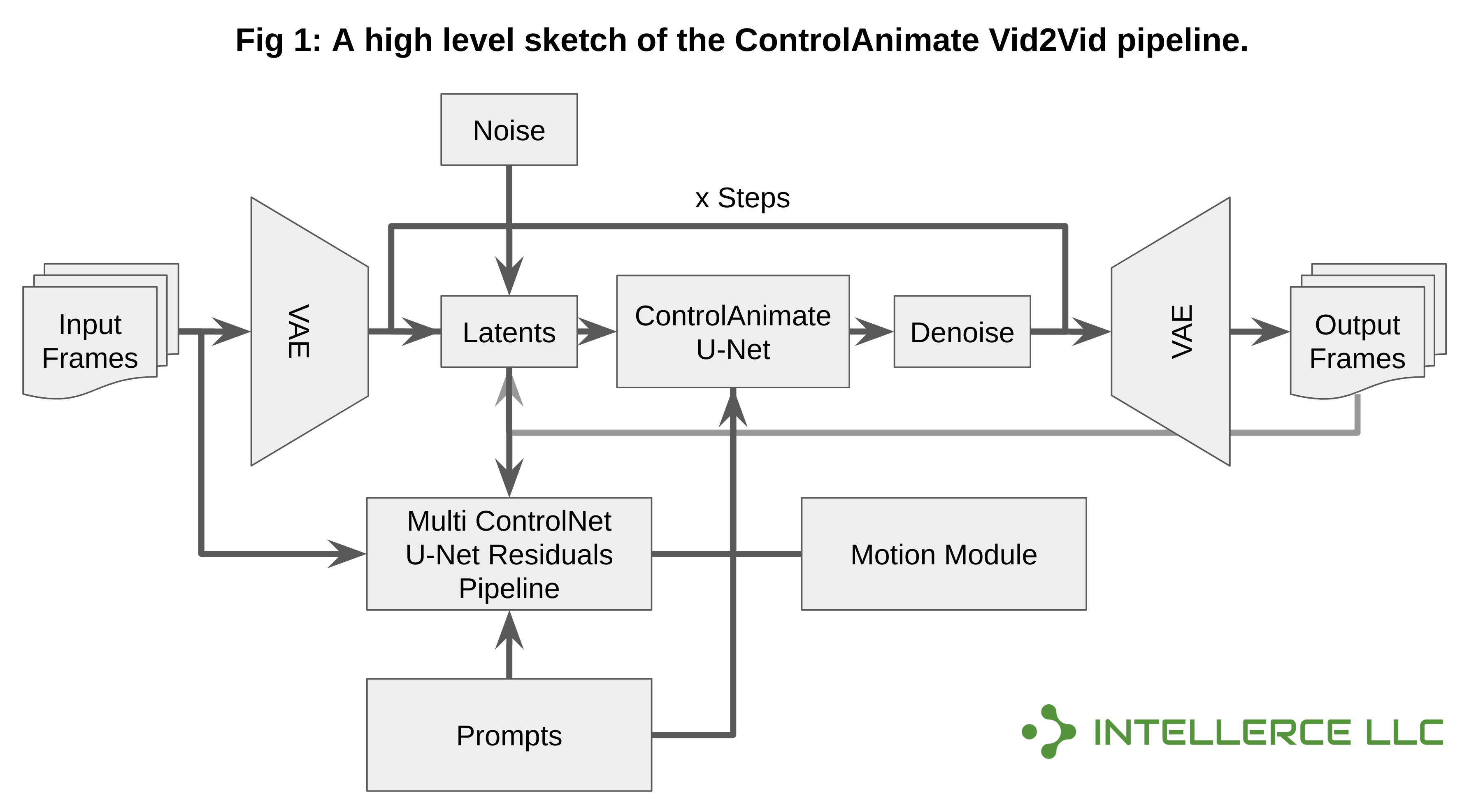

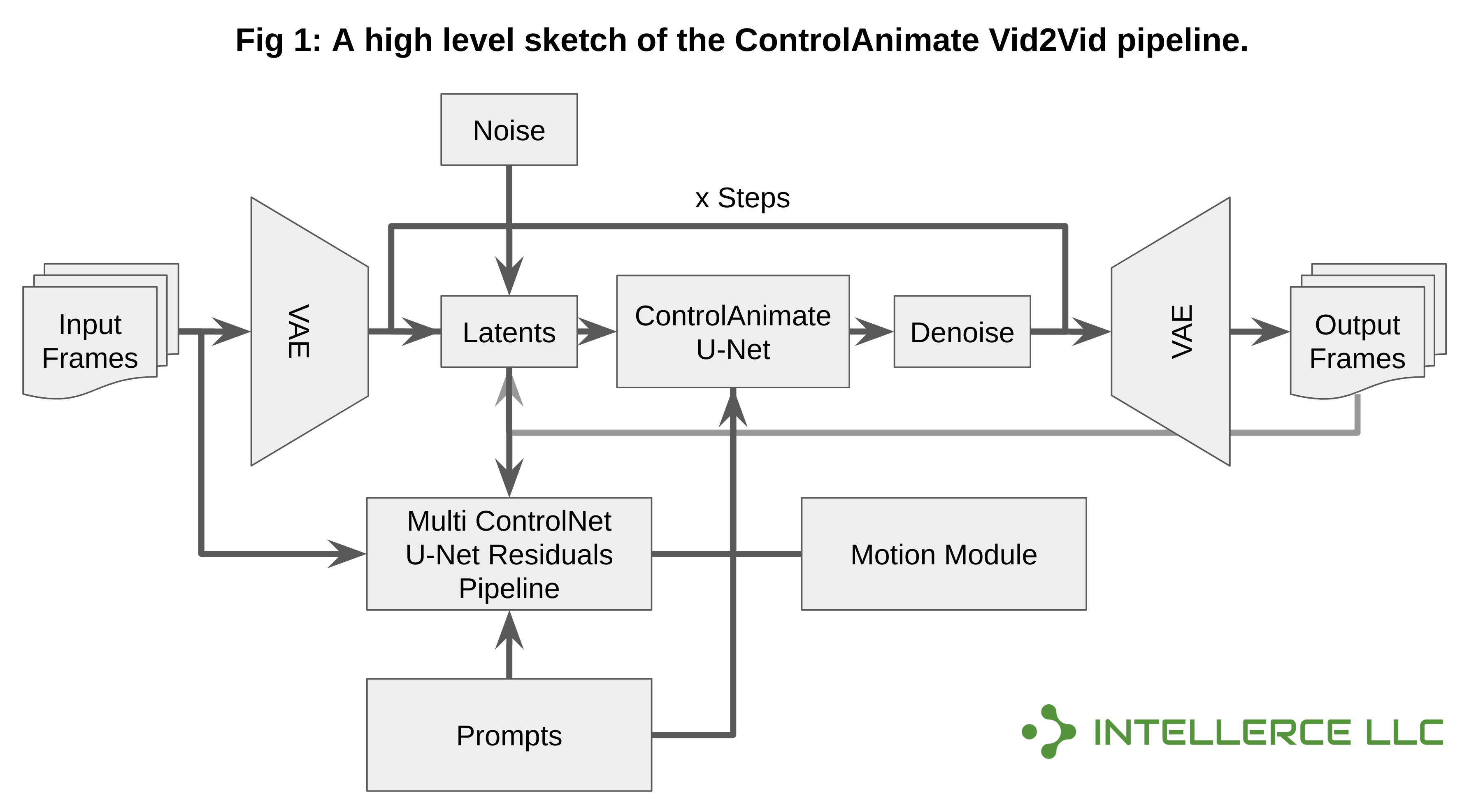

- Kombination von AnimateDiff mit Multi-ControlNet und Img2Img für Vid2Vid-Anwendungen. Diese kleine Bibliothek konzentriert sich insbesondere auf Vid2Vid-Anwendungen, indem sie ControlNet (oder Multi-ControlNet) zur Steuerung der Videogenerierung und AnimateDiff für Konsistenz verwendet.

- Darüber hinaus wird Img2Img verwendet, um konsistentere Videos zu erstellen (nach der ersten Epoche). Ähnlich wie AnimateDiff ermöglicht es die Verwendung von DreamBooth/LoRA-Modellen zusätzlich zum Stable Diffusion 1.5-Basismodell.

- Dies ist eine Erstveröffentlichung. Bitte rechnen Sie daher mit möglichen Problemen und Fehlern. Feedback, Vorschläge und Funktionswünsche sind willkommen.

Nachricht

- 20. November 2023 – Unterstützt jetzt IP-Adapter, Xformer und Farbanpassung!

- 12. November 2023 – Unterstützt jetzt LCM-LoRA und ControlNet für alle Kombinationen!

- 7. November 2023 – Unterstützt jetzt Latent Consistency Model (LCM) – Erzielung einer 10-fachen Leistungssteigerung!

Unterstützte Funktionen

- ? IP-Adapter (wird zur Erhöhung der Ähnlichkeit von Stapeln von AnimateDiff-Frames verwendet)

- ? Latent-Konsistenzmodell LoRA (LCM-LoRA)

- ? Latent-Konsistenzmodell (LCM) nativ

- ? Multi-ControlNet kann mit LCM usw. kombiniert werden.

- ? Gewichtung von Eingabeaufforderungen und lange Eingabeaufforderungen (Compel)

- ? DreamBooth & LoRA

- ? FFMPEG-Interpolation

- ? Farbabstimmung zwischen Chargen für verbesserte Konsistenz

- ? Latente Überlappung (Img2Img & ControlNet) und Frame-Überlappung (Blending)

- ? Gesichtsverbesserung und Upscaling (GFPGAN & RealESRGAN)

- ? Beliebige Bildrate, Dauer und Auflösungsabtastung des Eingabevideos

- ? xformers aktiviert

Kompatibilität und Anforderungen

- Diese Codebasis wurde nur unter Linux (Ubuntu 22.04) getestet. Es wurde auf einem Intel-Rechner mit NVIDIA Gefore RTX 3090 (24 GB VRAM) getestet und erfordert mindestens 16 GB RAM.

Installation

- Stellen Sie sicher, dass Sie Anaconda installiert haben (https://www.anaconda.com/download).

- Stellen Sie außerdem sicher, dass FFMPEG ordnungsgemäß installiert und eingerichtet ist (Sie können diesen Anleitungen für die Installation folgen: „Anleitung 1“ und falls weiterhin Probleme auftreten: „Anleitung 2“ – Sie können den FFMPEG-Pfad in der Konfigurations-/Eingabeaufforderungs-YAML festlegen Dateien)

git clone [email protected]:intellerce/controlanimate.git

cd ControlAnimate

bash download.sh

conda env create -f env.yml

Vid2Vid

- Führen Sie nach dem Festlegen der Konfigurationsdatei „configs/prompts/SampleConfig.yaml“ einfach Folgendes aus (vergessen Sie nicht, auf eine gültige Eingabevideodatei zu verweisen):

conda activate controlanimate

bash start.sh

Getestet auf einer Maschine mit einer einzelnen RTX 3090.

Zeitnahe Gewichtung

- Die prompte Gewichtung basiert auf Compel. Sie können + oder (...)+ für Wichtigkeit verwenden oder Gewichtungen wie folgt hinzufügen: (cat)1.2 Ebenso können Sie das negative Vorzeichen (-) verwenden, um die Gewichtung zu reduzieren oder Gewichtungen unter 1 zu verwenden. Weitere Informationen finden Sie unter https:// Weitere Informationen finden Sie unter github.com/damian0815/compel/blob/main/Reference.md.

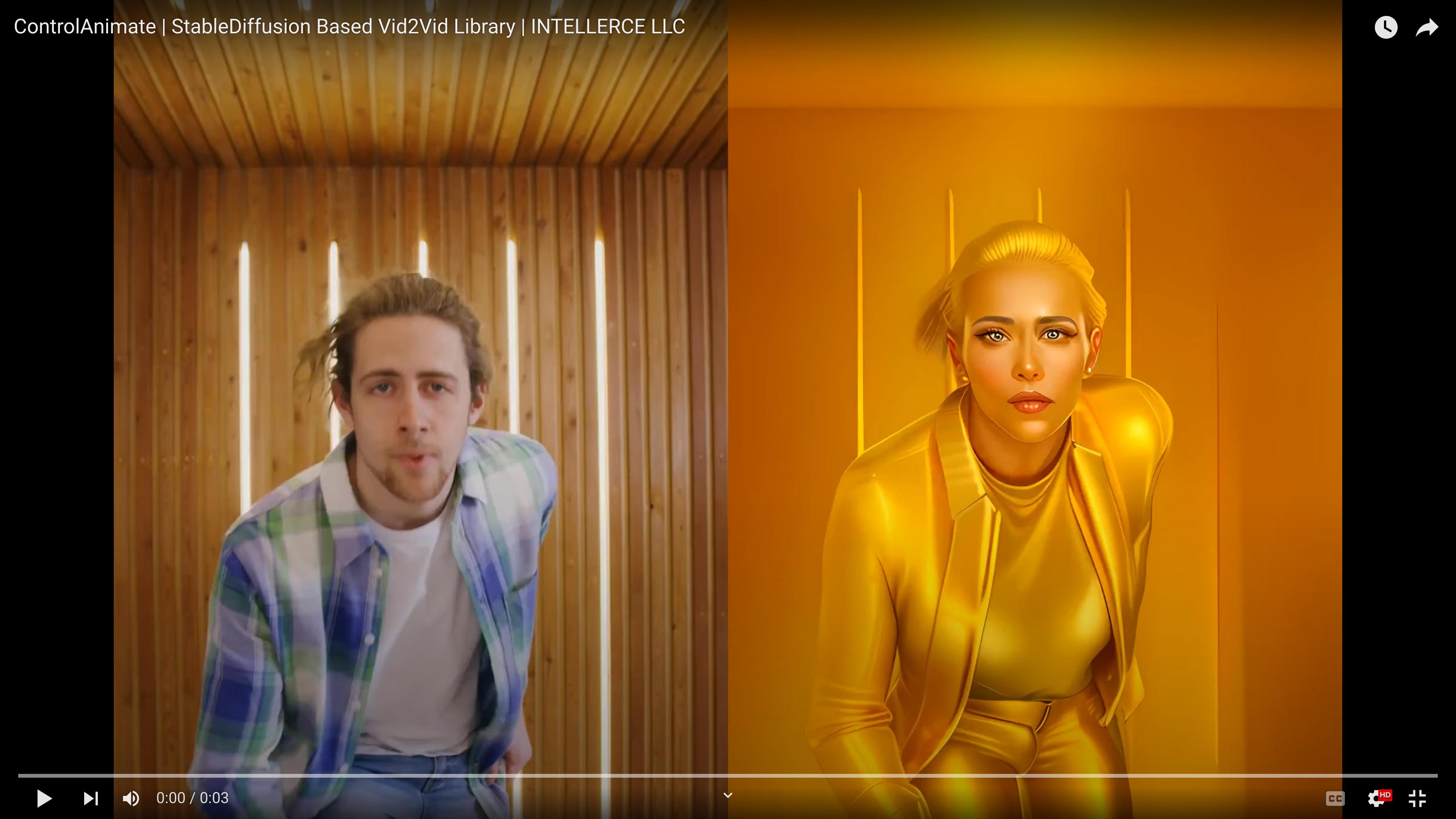

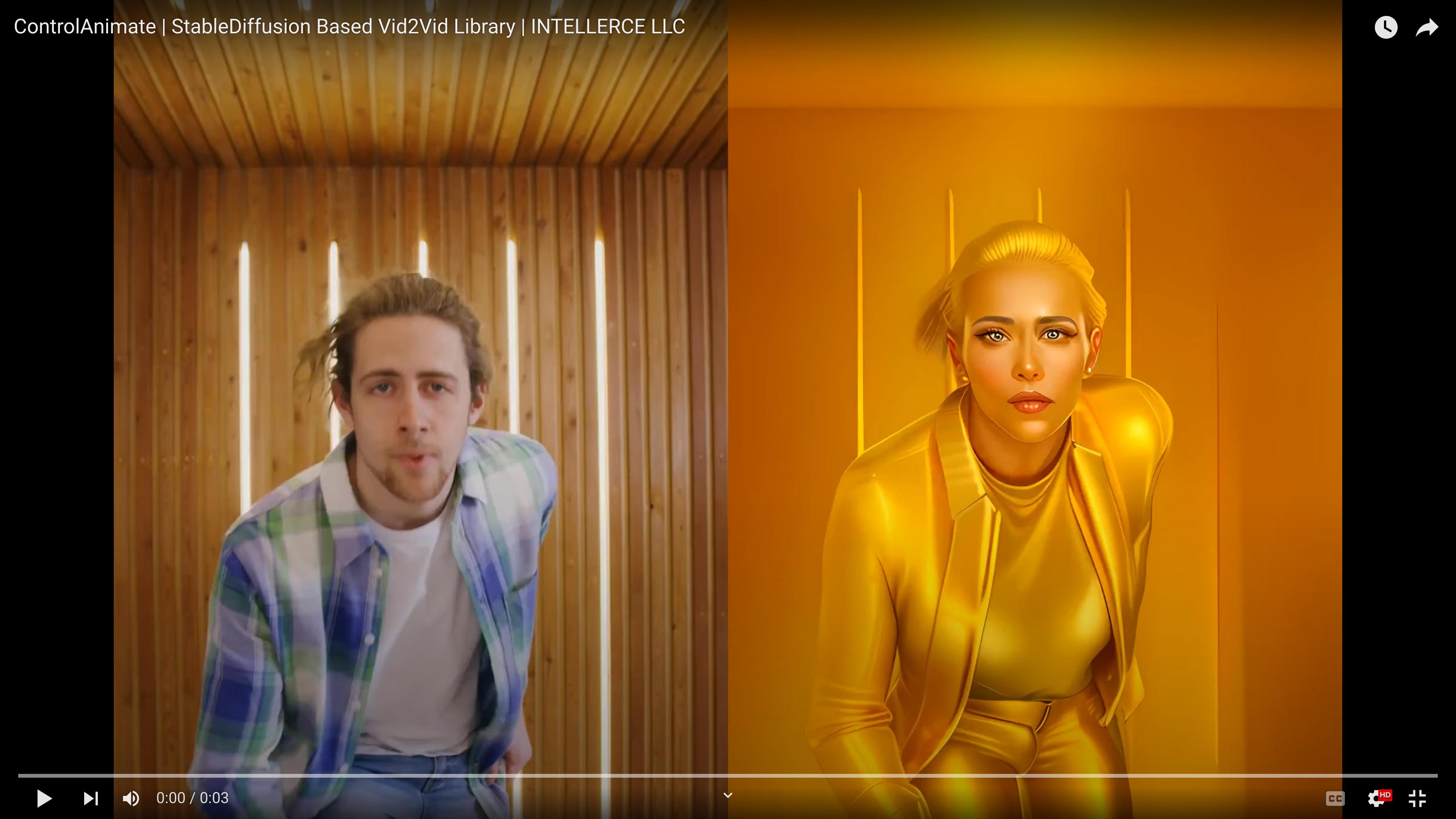

Ergebnisse

- Vier ControlNets und latente Überlappung (configs/prompts/SampleConfig.yaml)

- LCM (kein ControlNet) (configs/prompts/SampleConfigLCM.yaml)

- LCM-LoRA + Multi-ControlNet (configs/prompts/SampleConfigLCMLoRA.yaml)

- IP-Adapter + LCM-LoRA + Multi-ControlNet (configs/prompts/SampleConfigIPAdapter.yaml)

Todo

Kontaktieren Sie uns

Hamed Omidvar, Ph.D. : [email protected]

Vahideh Akhlaghi, Ph.D. : [email protected]

Lizenz

Diese Codebasis wird unter der Apache v2.0-Lizenz veröffentlicht. Die Lizenzen der Codebasen, auf denen dieses Repository basiert, finden Sie auf den entsprechenden Github-/Website-Seiten.

Danksagungen

Diese Codebasis wurde auf den folgenden Repositories aufgebaut und/oder von diesen inspiriert: AnimateDiff Diffusers IP-Adapter Video2Video Color Matcher

Die Autoren möchten Kalin Ovtcharov (Extropolis Corp.) für sein unschätzbares Feedback und seine Vorschläge danken.