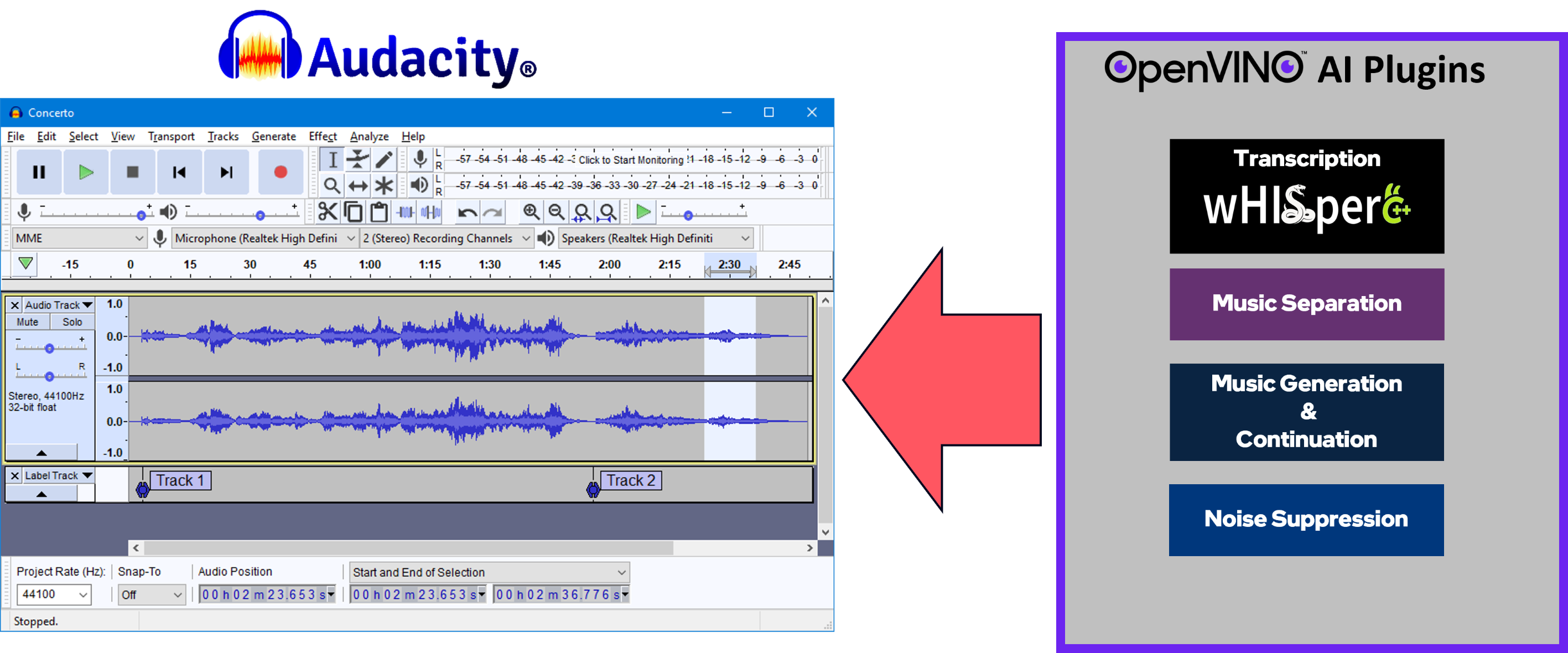

Un ensemble d'effets, de générateurs et d'analyseurs compatibles avec l'IA pour Audacity®. Ces fonctionnalités d'IA fonctionnent 100% localement sur votre PC ? -- aucune connexion Internet n'est nécessaire ! OpenVINO™ est utilisé pour exécuter des modèles d'IA sur les accélérateurs pris en charge trouvés sur le système de l'utilisateur, tels que le CPU, le GPU et le NPU.

Séparation de la musique – Séparez une piste mono ou stéréo en tiges individuelles : batterie, basse, voix et autres instruments.

Suppression du bruit : supprime le bruit de fond d'un échantillon audio.

Génération et continuation de musique - Utilise MusicGen LLM pour générer des extraits de musique ou pour générer une suite d'un extrait de musique existant.

Whisper Transcription – utilise murmur.cpp pour générer une piste d'étiquette contenant la transcription ou la traduction d'une sélection donnée d'audio parlé ou de voix.

Allez ici pour trouver les packages d’installation et les instructions pour la dernière version de Windows.

Instructions de construction de Windows

Instructions de construction Linux

Nous vous invitons à soumettre un problème ici pour

Questions

Rapports de bogues

Demandes de fonctionnalités

Commentaires de toute nature : comment pouvons-nous améliorer ce projet ?

Vos contributions sont les bienvenues et valorisées, quelle que soit leur taille. N'hésitez pas à soumettre une pull-request !

Équipe de développement Audacity® et Muse Group - Merci pour votre soutien !

Audacity® GitHub -- https://github.com/audacity/audacity

L'analyseur de transcription et de traduction Whisper utilise murmur.cpp (avec le backend OpenVINO™) : https://github.com/ggerganov/whisper.cpp

Music Generation & Continuation utilise le modèle MusicGen, de Meta.

Nous prenons actuellement en charge MusicGen-Small et MusicGen-Small-Stereo

Les pipelines txt-to-music ont été portés de Python vers C++, faisant référence à la logique du projet Hugging Face Transformers : https://github.com/huggingface/transformers

L'effet Music Separation utilise le modèle Demucs v4 de Meta (https://github.com/facebookresearch/demucs), qui a été porté pour fonctionner avec OpenVINO™

Suppression du bruit :

Portage des modèles et du pipeline à partir d'ici : https://github.com/Rikorose/DeepFilterNet

Nous avons également utilisé le fork/branche de @grazder (https://github.com/grazder/DeepFilterNet/tree/torchDF-changes) pour mieux comprendre l'implémentation de Rust, et nous avons donc également basé une partie de notre implémentation C++ sur torch_df_offline.py trouvé ici.

Citations :

@inproceedings{schroeter2022deepfilternet2,title = {{DeepFilterNet2} : Vers une amélioration de la parole en temps réel sur les appareils intégrés pour l'audio pleine bande},author = {Schröter, Hendrik et Escalante-B., Alberto N. et Rosenkranz, Tobias et Maier, Andreas},booktitle={17e atelier international sur l'amélioration du signal acoustique (IWAENC 2022)},année = {2022},

} @inproceedings{schroeter2023deepfilternet3,title = {{DeepFilterNet} : amélioration de la parole en temps réel motivée par la perception},author = {Schröter, Hendrik et Rosenkranz, Tobias et Escalante-B., Alberto N. et Maier, Andreas},booktitle={ INTERSPEECH},année = {2023},

}noise-suppression-denseunet-ll : de l'Open Model Zoo d'OpenVINO™ : https://github.com/openvinotoolkit/open_model_zoo

DeepFilterNet2 et DeepFilterNet3 :

OpenVINO™ Notebooks - Nous avons beaucoup appris de cet ensemble impressionnant de notebooks Python et nous l'utilisons toujours pour découvrir les dernières/meilleures pratiques pour la mise en œuvre de pipelines d'IA à l'aide d'OpenVINO™ !