Récemment, la popularité des applications d’IA pour grands modèles de langage (LLM) a entraîné une concurrence féroce dans le domaine du matériel. AMD a lancé sa dernière série d'APU Strix Point et ses processeurs Ryzen AI présentent des avantages significatifs dans la gestion des tâches LLM, avec des performances dépassant de loin la série Lunar Lake d'Intel. L'éditeur de Downcodes vous donnera une compréhension approfondie des performances de la série Strix Point APU et de l'innovation technologique qui la sous-tend.

Récemment, AMD a publié sa dernière série d'APU Strix Point, mettant l'accent sur les performances exceptionnelles de la série dans les applications d'IA à grand langage (LLM), dépassant de loin les processeurs de la série Lunar Lake d'Intel. Alors que la demande en charges de travail d’IA continue de croître, la concurrence pour le matériel devient de plus en plus féroce. En réponse au marché, AMD a lancé des processeurs IA conçus pour les plates-formes mobiles, visant des performances plus élevées et une latence plus faible.

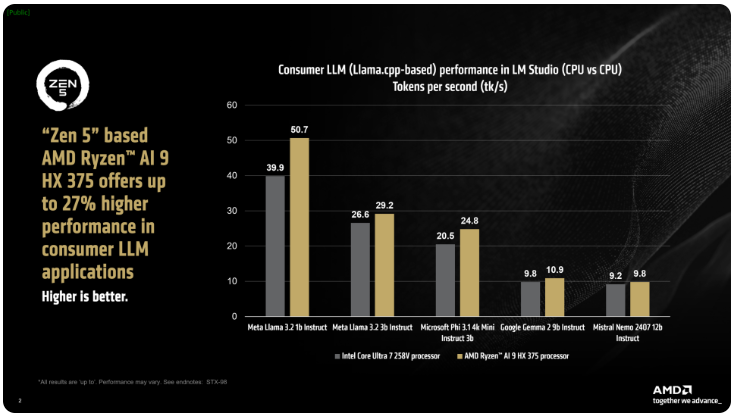

AMD a déclaré que le processeur Ryzen AI300 de la série ix Point peut augmenter considérablement le nombre de jetons traités par seconde lors du traitement des tâches AI LLM. Par rapport au Core Ultra258V d'Intel, les performances du Ryzen AI9375 se sont améliorées de 27 %. Bien que le Core Ultra7V ne soit pas le modèle le plus rapide de la série L Lake, son nombre de cœurs et de threads est proche de celui des processeurs Lunar Lake haut de gamme, ce qui montre la compétitivité des produits AMD dans ce domaine.

L'outil LM Studio d'AMD est une application orientée consommateur basée sur le framework llama.cpp, conçue pour simplifier l'utilisation de grands modèles de langage. Le framework optimise les performances des processeurs x86. Bien qu'un GPU ne soit pas requis pour exécuter LLM, l'utilisation d'un GPU peut accélérer davantage le traitement. Selon le test, le Ryzen AI9HX375 peut atteindre une latence 35 fois inférieure dans le modèle Meta Llama3.21b Instruct, traitant 50,7 jetons par seconde. En comparaison, le Core Ultra7258V ne représente que 39,9 jetons.

De plus, l'APU Strix Point est également équipé d'une puissante carte graphique intégrée Radeon basée sur l'architecture RDNA3.5, qui peut décharger des tâches sur l'iGPU via l'API ulkan pour améliorer encore les performances de LLM. Grâce à la technologie de mémoire graphique variable (VGM), le processeur Ryzen AI300 peut optimiser l'allocation de mémoire, améliorer l'efficacité énergétique et, à terme, atteindre une amélioration des performances allant jusqu'à 60 %.

Lors de tests comparatifs, AMD a utilisé les mêmes paramètres sur la plate-forme Intel AI Playground et a constaté que le Ryzen AI9HX375 était 87 % plus rapide que le Core Ultra7258V sur Microsoft Phi3.1 et 13 % plus rapide sur le modèle Mistral7b Instruct0.3. Pourtant, les résultats sont plus intéressants par rapport au Core Ultra9288V, le produit phare de la série Lunar Lake. Actuellement, AMD s'efforce de rendre plus populaire l'utilisation de grands modèles de langage via LM Studio, dans le but de faciliter le démarrage d'un plus grand nombre d'utilisateurs non techniques.

Le lancement de la série d'APU AMD Strix Point marque une nouvelle intensification de la concurrence dans le domaine des processeurs d'IA et indique également que les futures applications d'IA bénéficieront d'un support matériel plus puissant. Ses améliorations en termes de performances et d’efficacité énergétique offriront aux utilisateurs une expérience d’IA plus fluide et plus puissante. L'éditeur de Downcodes continuera de prêter attention aux derniers développements dans ce domaine et de proposer des rapports plus passionnants aux lecteurs.