L'éditeur de Downcodes a appris qu'Ai2, une institution de recherche à but non lucratif sur l'IA, a récemment publié sa nouvelle série de modèles de langage OLMo2, qui est la deuxième génération de sa série « Open Language Model » (OLMo). OLMo2 adhère au concept de code source entièrement ouvert, et ses données, outils et codes de formation sont entièrement ouverts. Ceci est particulièrement important dans le domaine de l'IA d'aujourd'hui et représente une nouvelle hauteur dans le développement de l'IA open source. Contrairement à d'autres modèles qui prétendent être « ouverts », OLMo2 suit strictement la définition de l'Open Source Initiative, répond aux normes strictes de l'IA open source et fournit à la communauté IA un support technique solide et de précieuses ressources d'apprentissage.

Ai2, une organisation de recherche sur l'IA à but non lucratif, a récemment publié sa nouvelle série OLMo2, qui est le modèle de deuxième génération de la série « Open Language Model » (OLMo) lancée par l'organisation. La sortie d'OLMo2 fournit non seulement un support technique solide à la communauté IA, mais représente également le dernier développement de l'IA open source avec son code source entièrement open source.

Contrairement à d'autres modèles de langage « ouverts » actuellement sur le marché comme la série Llama de Meta, OLMo2 répond à la définition stricte de l'Open Source Initiative, ce qui signifie que les données de formation, les outils et le code utilisés pour son développement sont publics et accessibles à tous. utiliser. Tel que défini par l'Open Source Initiative, OLMo2 répond aux exigences de l'organisation en matière de norme « IA open source », qui a été finalisée en octobre de cette année.

Ai2 a mentionné dans son blog que pendant le processus de développement d'OLMo2, toutes les données de formation, codes, plans de formation, méthodes d'évaluation et points de contrôle intermédiaires étaient complètement ouverts, dans le but de promouvoir l'innovation et la découverte dans la communauté open source grâce à des ressources partagées. "En partageant ouvertement nos données, nos solutions et nos découvertes, nous espérons fournir à la communauté open source les ressources nécessaires pour découvrir de nouvelles méthodes et technologies innovantes", a déclaré Ai2.

La série OLMo2 comprend deux versions : l'une est OLMo7B avec 7 milliards de paramètres et l'autre est OLMo13B avec 13 milliards de paramètres. Le nombre de paramètres affecte directement les performances du modèle, et les versions avec plus de paramètres peuvent généralement gérer des tâches plus complexes. OLMo2 a bien performé sur les tâches de texte courantes, étant capable d'effectuer des tâches telles que répondre à des questions, résumer des documents et écrire du code.

Remarque sur la source de l'image : l'image est générée par l'IA et l'image est autorisée par le fournisseur de services Midjourney

Pour entraîner OLMo2, Ai2 a utilisé un ensemble de données contenant cinq mille milliards de jetons. Le jeton est la plus petite unité du modèle linguistique. 1 million de jetons équivaut approximativement à 750 000 mots. Les données de formation comprennent du contenu provenant de sites Web de haute qualité, d'articles universitaires, de forums de discussion de questions-réponses et de manuels de mathématiques synthétiques, et sont soigneusement sélectionnées pour garantir l'efficacité et la précision du modèle.

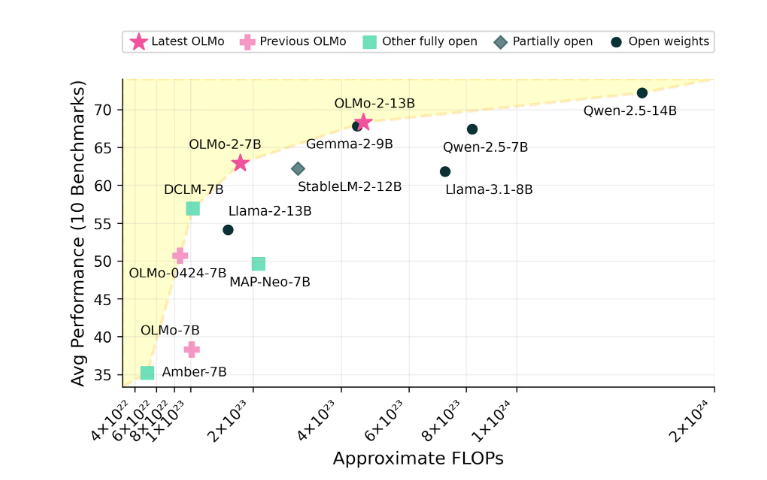

Ai2 est confiant dans les performances d’OLMo2, affirmant qu’il a rivalisé en performances avec des modèles open source tels que Meta’s Llama3.1. Ai2 a souligné que les performances d'OLMo27B ont même dépassé Llama3.18B et sont devenues actuellement l'un des modèles de langage entièrement ouverts les plus puissants. Tous les modèles OLMo2 et leurs composants peuvent être téléchargés gratuitement via le site officiel d'Ai2 et suivent la licence Apache2.0, ce qui signifie que ces modèles peuvent être utilisés non seulement à des fins de recherche mais également pour des applications commerciales.

La nature open source d’OLMo2 favorisera grandement la coopération ouverte et l’innovation dans le domaine de l’IA, offrant ainsi aux chercheurs et aux développeurs un espace de développement plus large. Nous attendons avec impatience qu’OLMo2 apporte davantage de percées et d’applications à l’avenir.