iFlytek a publié un grand modèle interactif multimodal d'iFlytek, marquant une nouvelle étape dans le domaine de l'intelligence artificielle. Ce modèle brise les limites de l'interaction vocale unique dans le passé et réalise l'intégration transparente de l'interaction humaine vocale, visuelle et numérique, offrant aux utilisateurs une expérience interactive plus vivante, réelle et pratique. Les éditeurs de Downcodes vous donneront une compréhension approfondie des fonctions et des avantages de cet étonnant modèle d'interaction multimodale, et de la manière dont il changera la façon dont nous interagissons avec l'intelligence artificielle.

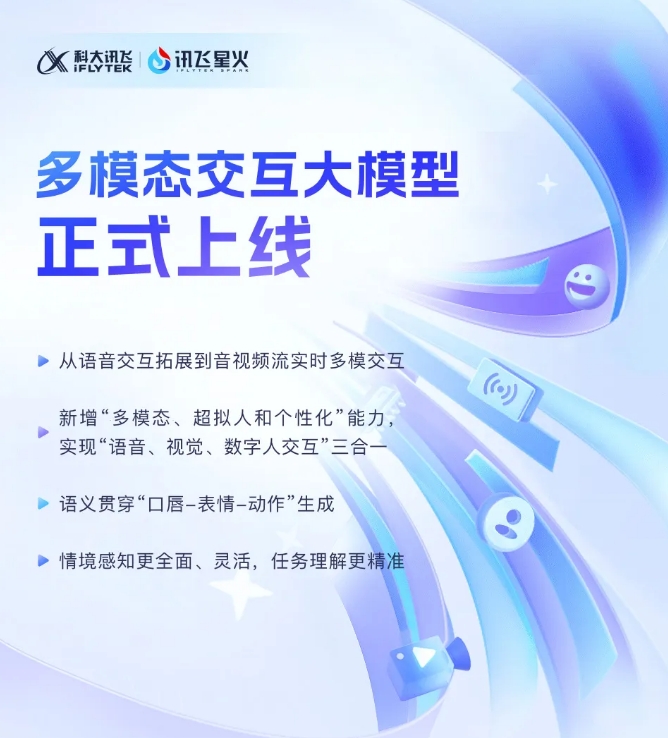

iFlytek a récemment annoncé que son nouveau grand modèle interactif multimodal iFlytek Spark avait été officiellement mis en service. Cette avancée technologique marque l'expansion d'iFlytek d'une technologie d'interaction vocale unique à une nouvelle étape d'interaction multimodale en temps réel de flux audio et vidéo. Le nouveau modèle intègre des fonctions d'interaction humaine vocale, visuelle et numérique, et les utilisateurs peuvent réaliser une intégration transparente des trois en un seul clic.

Le lancement du modèle interactif multimodal d'iFlytek introduit pour la première fois une technologie humaine numérique super-anthropomorphe. Cette technologie peut faire correspondre avec précision les mouvements du torse et des membres de l'humain numérique avec le contenu vocal, générer rapidement des expressions et des mouvements et améliorer considérablement la capacités de l’IA, vivacité et réalisme. En intégrant le texte, la parole et les expressions, le nouveau modèle peut atteindre une cohérence sémantique intermodale, rendant l'expression émotionnelle plus réaliste et cohérente.

De plus, iFlytek Spark prend en charge la technologie d'interaction ultra-rapide super-anthropomorphique et utilise un réseau neuronal unifié pour réaliser directement une modélisation de bout en bout de la voix à la voix, rendant la réponse plus rapide et plus fluide. Cette technologie peut détecter avec précision les changements émotionnels et ajuster librement le rythme, la taille et la personnalité du son selon les instructions, offrant ainsi une expérience interactive plus personnalisée.

En termes d'interaction visuelle multimodale, iFlytek Spark peut « comprendre le monde » et « tout reconnaître », et percevoir de manière globale des scènes d'arrière-plan spécifiques, l'état logistique et d'autres informations, rendant la compréhension des tâches plus précise. En intégrant diverses informations telles que la voix, les gestes, le comportement et les émotions, le modèle peut apporter des réponses appropriées et offrir aux utilisateurs une expérience interactive plus riche et plus précise.

SDK grand modèle interactif multimodal : https://www.xfyun.cn/solutions/Multimodel

L'émergence du grand modèle interactif multimodal iFlytek Spark indique que la technologie de l'intelligence artificielle évolue dans une direction plus intelligente et plus humaine. Ses fonctions puissantes et ses opérations pratiques apporteront sûrement une nouvelle expérience interactive aux utilisateurs et apporteront des possibilités illimitées à tous les horizons. Nous attendons avec impatience qu'iFlytek Spark nous apporte d'autres surprises à l'avenir !