L'éditeur de Downcodes a appris que DeepSeek, une filiale du géant chinois du capital-investissement Magic Square Quantitative, a récemment publié son dernier modèle de langage à grande échelle axé sur l'inférence, R1-Lite-Preview. Ce modèle n'est actuellement ouvert au public que via la plateforme de chatbot Web DeepSeek Chat, et ses performances ont attiré une large attention, approchant ou dépassant même le modèle o1-preview récemment publié par OpenAI. DeepSeek est connu pour ses contributions à l'écosystème de l'IA open source, et ce lancement poursuit son engagement en faveur de l'accessibilité et de la transparence.

DeepSeek, une filiale du géant chinois du capital-investissement Huifang Quantitative, a récemment publié son dernier modèle de langage à grande échelle axé sur l'inférence, R1-Lite-Preview. Le modèle n'est actuellement disponible au public que via DeepSeek Chat, une plateforme de chatbot Web.

DeepSeek est connu pour ses contributions innovantes à l'écosystème de l'IA open source, et cette nouvelle version vise à apporter au public des capacités d'inférence de haut niveau tout en maintenant un engagement en faveur de l'accessibilité et de la transparence. Bien que R1-Lite-Preview ne soit actuellement disponible que dans les applications de chat, il a attiré une large attention avec des performances proches, voire supérieures, du modèle o1-preview récemment publié par OpenAI.

R1-Lite-Preview utilise un raisonnement de type « pensée en chaîne », qui peut montrer les différents processus de réflexion qu'il traverse lorsqu'il répond aux requêtes des utilisateurs.

Bien que certaines chaînes de pensée puissent sembler absurdes ou fausses aux humains, dans l'ensemble, les réponses de R1-Lite-Preview sont très précises et peuvent même résoudre les « pièges » rencontrés par certains modèles d'IA puissants traditionnels tels que les séries GPT-4o et Claude. Par exemple, combien y a-t-il de R dans le mot « fraise » ? « Lequel est le plus gros, 9,11 ou 9,9 ? »

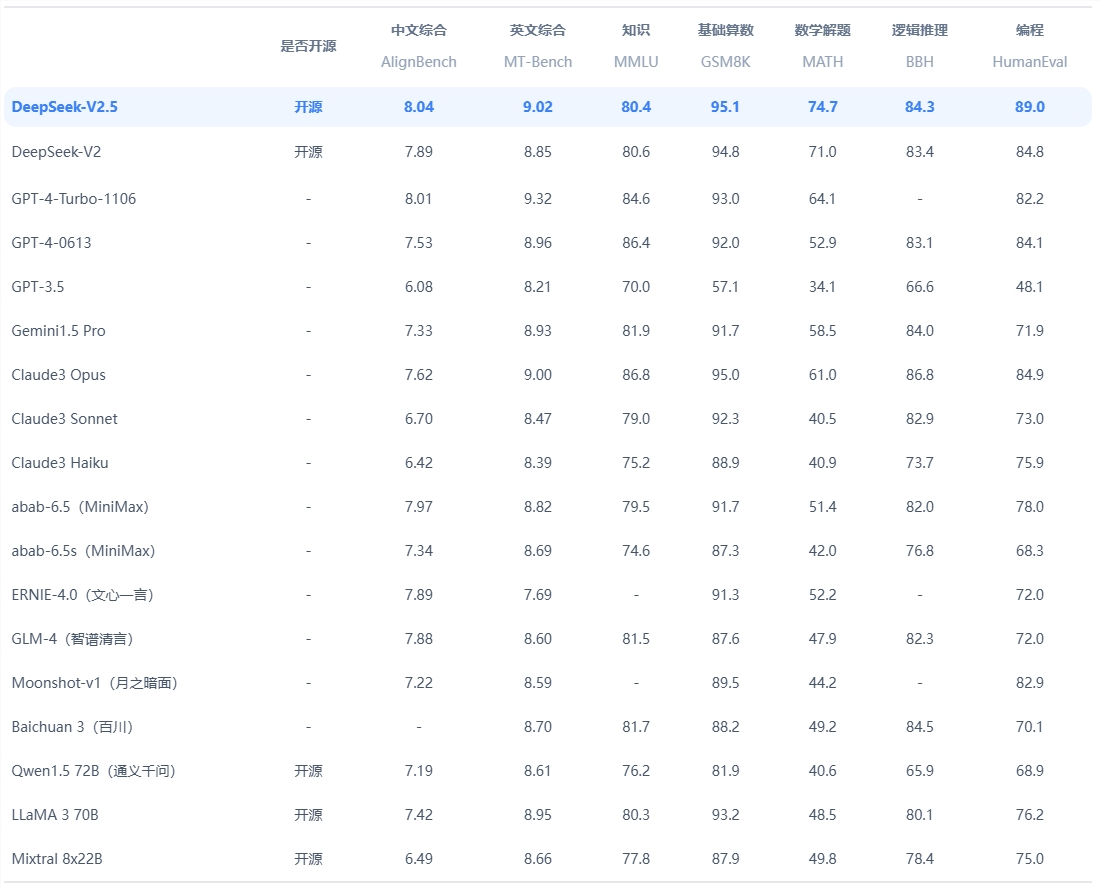

Selon DeepSeek, le modèle excelle dans les tâches qui nécessitent un raisonnement logique, une réflexion mathématique et une résolution de problèmes en temps réel. Ses performances dépassent le niveau d'OpenAI o1-preview dans les benchmarks établis tels que l'AIME (American Invitational Mathematics Examination) et MATH.

De plus, DeepSeek a publié des données étendues sur le modèle, démontrant une amélioration constante de la précision lorsque le modèle dispose de plus de temps, ou de « jetons de réflexion », pour résoudre le problème. Le graphique souligne qu'à mesure que la profondeur de la réflexion augmente, le score du modèle sur des critères tels que l'AIME s'améliore.

La version actuelle de R1-Lite-Preview fonctionne bien dans les tests de référence clés, capable de gérer une gamme de tâches allant des mathématiques complexes aux scénarios logiques, avec des scores comparables à ceux des meilleurs modèles d'inférence tels que GPQA et Codeforces. Le processus de raisonnement transparent du modèle permet aux utilisateurs d'observer ses étapes logiques en temps réel, renforçant ainsi le sens de responsabilité et la crédibilité du système.

Il convient de noter que DeepSeek n'a pas publié le code complet pour une analyse ou une analyse comparative indépendante par des tiers, et n'a pas non plus fourni d'interface API pour des tests indépendants. La société n'a pas encore publié d'articles de blog ou de documents techniques pertinents décrivant la formation ou les tests de. Structure R1-Lite-Preview, ce qui rend l'origine encore pleine de doutes.

R1-Lite-Preview est actuellement disponible gratuitement via DeepSeek Chat (chat.deepseek.com), mais son mode avancé « réflexion approfondie » est limité à 50 messages par jour, permettant aux utilisateurs de découvrir ses puissantes capacités. DeepSeek prévoit de publier des versions open source des modèles de la série R1 et des API associées pour soutenir davantage le développement de la communauté open source de l'IA.

DeepSeek continue de stimuler l'innovation dans l'espace de l'IA open source, et la sortie de R1-Lite-Preview ajoute une nouvelle dimension à son inférence et à son évolutivité. Alors que les entreprises et les chercheurs explorent les applications de l'IA à forte inférence, l'engagement de DeepSeek en faveur de l'ouverture garantira que ses modèles deviendront une ressource importante pour le développement et l'innovation.

Entrée officielle : https://www.deepseek.com/

Dans l'ensemble, R1-Lite-Preview démontre la forte force de DeepSeek dans le domaine des modèles de langage à grande échelle, et son plan open source mérite également d'être attendu. Cependant, le manque de divulgation du code et des documents techniques jette également une couche de mystère sur ses détails techniques. L'éditeur de Downcodes continuera de prêter attention aux progrès ultérieurs de DeepSeek.