L'éditeur de Downcodes a appris que l'Allen Institute for Artificial Intelligence (Ai2) a récemment publié Molmo, une nouvelle famille de modèles d'IA multimodaux open source. Ses performances sont étonnantes, dépassant même celles d'OpenAI GPT-4o et Anthropic dans plusieurs tests de référence tiers. .Claude3.5Sonnet et Gemini1.5 de Google. Non seulement Molmo analyse les images téléchargées par les utilisateurs, mais il utilise également 1 000 fois moins de données pendant l'entraînement que ses concurrents, grâce à ses techniques d'entraînement uniques. Cette avancée démontre l’engagement d’Ai2 en faveur de la recherche ouverte, en mettant à la disposition de la communauté et de l’entreprise au sens large des modèles hautes performances ainsi que des pondérations et des données ouvertes.

Molmo accepte non seulement les images téléchargées par les utilisateurs pour analyse, mais utilise également « 1 000 fois moins de données que ses concurrents » pour la formation, grâce à ses techniques de formation uniques.

Cette version démontre l’engagement d’Ai2 en faveur de la recherche ouverte, en fournissant des modèles hautes performances avec des pondérations et des données ouvertes destinés à être utilisés par la communauté et les entreprises au sens large. La famille Molmo comprend quatre modèles principaux, à savoir le Molmo-72B, le Molmo-7B-D, le Molmo-7B-O et le MolmoE-1B. Le Molmo-72B est le modèle phare, contenant 7,2 milliards de paramètres, et ses performances sont particulièrement remarquables.

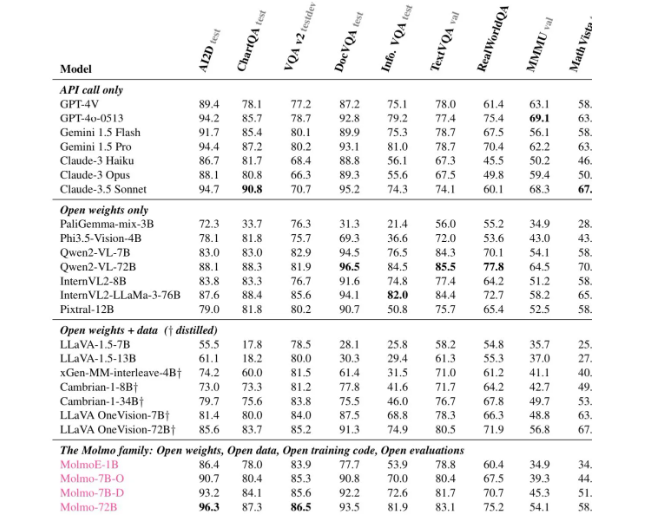

Selon diverses évaluations, le Molmo-72B a reçu les meilleurs scores sur 11 critères importants et s'est classé deuxième derrière -4o en termes de préférence des utilisateurs. Ai2 a également lancé un modèle OLMoE, en utilisant une approche de « combinaison de petits modèles » pour améliorer la rentabilité.

L'architecture de Molmo a été soigneusement conçue pour une efficacité et des performances supérieures. Tous les modèles utilisent le modèle CLIP ViT-L/14336px d'OpenAI comme encodeur visuel pour traiter les images multi-échelles en commandes visuelles. La partie modèle de langage est le décodeur Transformer, qui a différentes capacités et ouvertures.

En termes de formation, Mol subit deux étapes de formation : d'abord, une pré-formation multi-modèles, et ensuite, une mise au point supervisée. Contrairement à de nombreux modèles modernes, Molmo ne s'appuie pas sur un apprentissage par renforcement avec retour humain, mais met à jour les paramètres du modèle via un processus de formation soigneusement ajusté.

Molmo a obtenu de bons résultats dans plusieurs tests, en particulier dans des tâches complexes telles que la lecture de documents et le raisonnement visuel, démontrant ainsi ses solides capacités. Ai2 a publié ces modèles et ensembles de données sur Hugging Face et lancera davantage de modèles et de rapports techniques étendus dans les mois à venir afin de fournir davantage de ressources aux chercheurs.

Si vous souhaitez en savoir plus sur les capacités de Molmo, des démonstrations publiques sont désormais disponibles sur le site officiel de Molmo (https://molmo.allenai.org/).

Souligner:

Le modèle d’IA modal open source d’Ai2Molmo surpasse les meilleurs produits du secteur.

? Mol-72B fonctionne bien dans plusieurs benchmarks, juste derrière GPT4o.

Il est très ouvert et les modèles et ensembles de données peuvent être utilisés librement par les chercheurs.

Dans l’ensemble, l’émergence de Molmo marque une avancée majeure dans le domaine de l’IA multimodale, et sa nature open source fournit également des ressources précieuses aux chercheurs du monde entier. L'éditeur de Downcodes espère que Molmo sera plus largement utilisé et développé à l'avenir et favorisera le progrès continu de la technologie de l'IA.