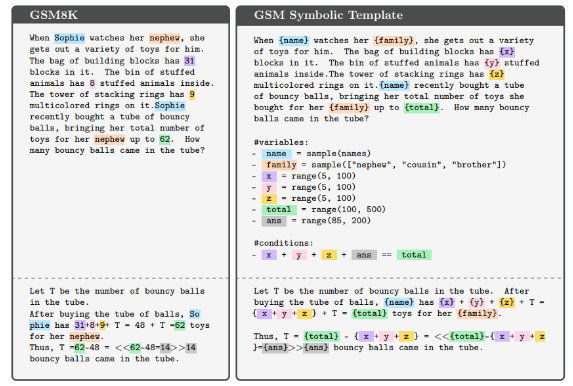

L'éditeur de Downcodes a appris que des chercheurs d'Apple ont lancé un nouveau test de référence appelé GSM-Symbolic pour les capacités de raisonnement mathématique des grands modèles de langage (LLM). Ce test est basé sur GSM8K et est conçu pour évaluer de manière plus complète les capacités de raisonnement de LLM, plutôt que de s'appuyer uniquement sur sa correspondance de modèles probabiliste. Bien que GSM8K soit populaire, il présente des problèmes tels que la pollution des données et les fluctuations de performances. GSM-Symbolic surmonte ces défauts en générant des problèmes mathématiques diversifiés à partir de modèles symboliques, garantissant ainsi une évaluation plus précise.

Récemment, des chercheurs d'Apple ont mené une étude approfondie des capacités de raisonnement mathématique des grands modèles de langage (LLM) et ont lancé une nouvelle référence appelée GSM-Symbolic.

Ce nouveau benchmark est développé sur la base du GSM8K, qui est principalement utilisé pour évaluer les capacités mathématiques de base. Bien que les performances de nombreux LLM se soient améliorées par rapport au GSM8K, la communauté scientifique se pose encore des questions sur les capacités de raisonnement de ces modèles, estimant que les mesures d'évaluation existantes ne reflètent peut-être pas pleinement leurs véritables capacités. Des recherches ont montré que les LLM s'appuient souvent sur une correspondance de modèles probabilistes plutôt que sur un véritable raisonnement logique, ce qui les rend très sensibles aux petits changements d'entrée.

Dans la nouvelle étude, les chercheurs ont utilisé des modèles symboliques pour générer divers problèmes mathématiques fournissant des évaluations plus fiables. Les résultats expérimentaux montrent que les performances du LLM diminuent considérablement lorsque la valeur numérique ou la complexité du problème augmente. De plus, même l'ajout d'informations superficiellement pertinentes pour le problème, mais qui ne sont pas réellement inutiles, peut entraîner une dégradation des performances du modèle jusqu'à 65 %. Ces résultats confirment une fois de plus que le LLM s'appuie davantage sur la correspondance de modèles plutôt que sur le raisonnement logique formel lors du raisonnement.

L'ensemble de données GSM8K contient plus de 8 000 problèmes mathématiques de niveau scolaire, et sa popularité soulève plusieurs risques, tels que la contamination des données et les fluctuations de performances causées par de petits changements de problèmes. Afin de répondre à ces enjeux, l'émergence du GSM-Symbolic permet de maîtriser efficacement la diversité des problématiques. Ce benchmark évalue plus de 20 modèles ouverts et fermés à l'aide de 5 000 échantillons provenant de 100 modèles, démontrant les connaissances et les limites des capacités de raisonnement mathématique de LLM.

Des expériences préliminaires montrent que les performances des différents modèles sur GSM-Symbolic varient considérablement et que la précision globale est inférieure aux performances signalées sur GSM8K. L'étude a en outre exploré l'impact de la modification des noms et des valeurs des variables sur LLM, et les résultats ont montré que les modifications des valeurs avaient un impact plus important sur les performances. De plus, la complexité du problème affecte également directement la précision, les problèmes complexes entraînant une dégradation significative des performances. Ces résultats suggèrent que le modèle peut s'appuyer davantage sur la correspondance de modèles que sur de véritables capacités de raisonnement lorsqu'il s'agit de problèmes mathématiques.

Cette étude met en évidence les limites des évaluations GSM8K actuelles et introduit un nouveau benchmark, GSM-Symbolic, conçu pour évaluer les capacités de raisonnement mathématique des LLM. Dans l’ensemble, les résultats indiquent que les LLM doivent encore améliorer leurs capacités de raisonnement logique lorsqu’ils traitent des problèmes complexes.

Article : https://arxiv.org/abs/2410.05229

Dans l’ensemble, le benchmark GSM-Symbolic proposé par Apple offre une nouvelle perspective pour évaluer les capacités de raisonnement mathématique des grands modèles de langage. Il révèle également que LLM peut encore améliorer son raisonnement logique, ce qui ouvre la voie à de futures améliorations du modèle. Nous attendons avec impatience davantage de recherches à l’avenir pour promouvoir davantage le développement des capacités de raisonnement du LLM.