La nature de « boîte noire » des grands modèles de langage (LLM) a toujours été un problème important dans le domaine de l'intelligence artificielle. Le caractère ininterprétable des résultats du modèle rend difficile la garantie de sa fiabilité et de sa crédibilité. Pour résoudre ce problème, OpenAI a lancé une nouvelle technologie appelée Prover-Verifier Games (PVG), qui vise à améliorer l'interprétabilité et la vérifiabilité des résultats du LLM. L’éditeur de Downcodes vous expliquera cette technologie en détail.

OpenAI a récemment publié une nouvelle technologie appelée Prover-Verifier Games (PVG), qui vise à résoudre le problème de la « boîte noire » de la sortie des modèles d'intelligence artificielle.

Imaginez que vous disposez d’un assistant super intelligent, mais que son processus de réflexion est comme une boîte noire et que vous n’avez aucune idée de la manière dont il parvient à ses conclusions. Cela semble-t-il un peu gênant ? Oui, c'est le problème auquel sont actuellement confrontés de nombreux grands modèles de langage (LLM). Bien que puissants, l’exactitude du contenu qu’ils génèrent est difficile à vérifier.

URL de l'article : https://cdn.openai.com/prover-verifier-games-improve-legibility-of-llm-outputs/legibility.pdf

Pour résoudre ce problème, OpenAI a lancé la technologie PVG. En termes simples, il s'agit de laisser les petits modèles (tels que GPT-3) superviser la sortie des grands modèles (tels que GPT-4). C'est comme jouer à un jeu. Le prouveur est responsable de générer le contenu et le vérificateur est responsable de déterminer si le contenu est correct. Cela vous semble intéressant ?

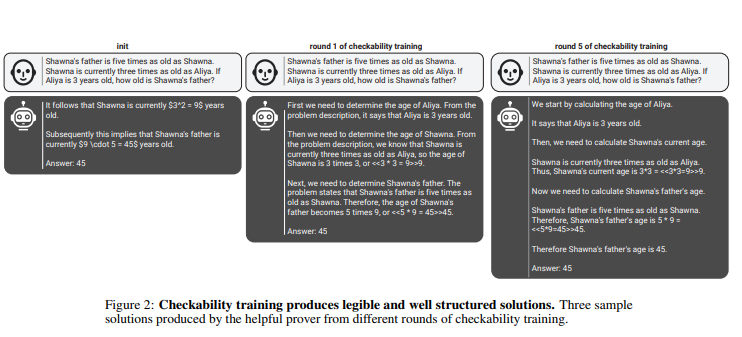

Dans le cadre de cette règle, les prouveurs et les vérificateurs améliorent continuellement leurs capacités grâce à plusieurs cycles de formation itérative. Les vérificateurs utilisent l'apprentissage supervisé pour prédire l'exactitude du contenu, tandis que les prouveurs utilisent l'apprentissage par renforcement pour optimiser le contenu qu'ils génèrent. Plus intéressant encore, il existe deux types de prouveurs : les prouveurs utiles et les prouveurs rusés. Les prouveurs utiles s'efforcent de générer un contenu correct et convaincant, tandis que les prouveurs astucieux tentent de générer un contenu incorrect mais tout aussi convaincant, remettant ainsi en question le jugement du vérificateur.

penAI souligne que pour former un modèle de vérificateur efficace, une grande quantité de données d'étiquette réelles et précises est nécessaire pour améliorer ses capacités de reconnaissance. Sinon, même si la technologie PVG est utilisée, le contenu vérifié risque toujours d’être publié illégalement.

Souligner:

La technologie PVG résout le problème de la « boîte noire » de l'IA en vérifiant la sortie de grands modèles avec de petits modèles.

? Le cadre de formation est basé sur la théorie des jeux et simule l'interaction entre le prouveur et le vérificateur, améliorant ainsi la précision et la contrôlabilité des résultats du modèle.

? Une grande quantité de données réelles est nécessaire pour entraîner le modèle de vérificateur afin de garantir qu'il dispose d'un jugement et d'une robustesse suffisants.

Dans l’ensemble, la technologie PVG d’OpenAI offre une nouvelle idée pour résoudre le problème de la « boîte noire » des modèles d’intelligence artificielle, mais son efficacité repose toujours sur des données d’entraînement de haute qualité. Le développement futur de cette technologie mérite d’être attendu, car il favorisera le développement de modèles d’intelligence artificielle dans une direction plus fiable, explicable et digne de confiance. L’éditeur de Downcodes a hâte de voir émerger d’autres technologies innovantes similaires.