Le domaine de l’intelligence artificielle évolue chaque jour et le raisonnement causal est devenu un sujet de recherche brûlant ces dernières années. Les modèles traditionnels d’apprentissage automatique sont souvent insuffisants en matière de raisonnement logique et ont du mal à comprendre la relation causale derrière les événements. Aujourd'hui, l'éditeur de Downcodes présentera un document de recherche d'institutions telles que Microsoft et le MIT, qui propose une stratégie révolutionnaire de formation à l'apprentissage automatique qui améliore considérablement les capacités de raisonnement logique des grands modèles, et même des petits modèles Transformer. Elle est comparable au GPT-. 4 en capacités de raisonnement. Examinons de plus près ce résultat de recherche impressionnant.

À l’ère de l’explosion de l’information, nous sommes quotidiennement confrontés à des appareils intelligents. Vous êtes-vous déjà demandé comment ces types apparemment intelligents savent apporter un parapluie parce qu’il pleut ? Derrière cela se cache en réalité une profonde révolution dans le raisonnement causal ?

Un groupe de chercheurs d'institutions universitaires renommées, dont Microsoft et le MIT, ont développé une stratégie révolutionnaire de formation en apprentissage automatique. Cette stratégie pallie non seulement les lacunes des grands modèles d'apprentissage automatique en matière de raisonnement logique, mais permet également d'obtenir des améliorations significatives grâce aux étapes suivantes :

Méthode de formation unique : les chercheurs ont utilisé une nouvelle méthode de formation qui peut différer des techniques de formation conventionnelles en apprentissage automatique.

Améliorations du raisonnement logique : leur approche améliore considérablement les capacités de raisonnement logique des grands modèles, résolvant ainsi les défis existants.

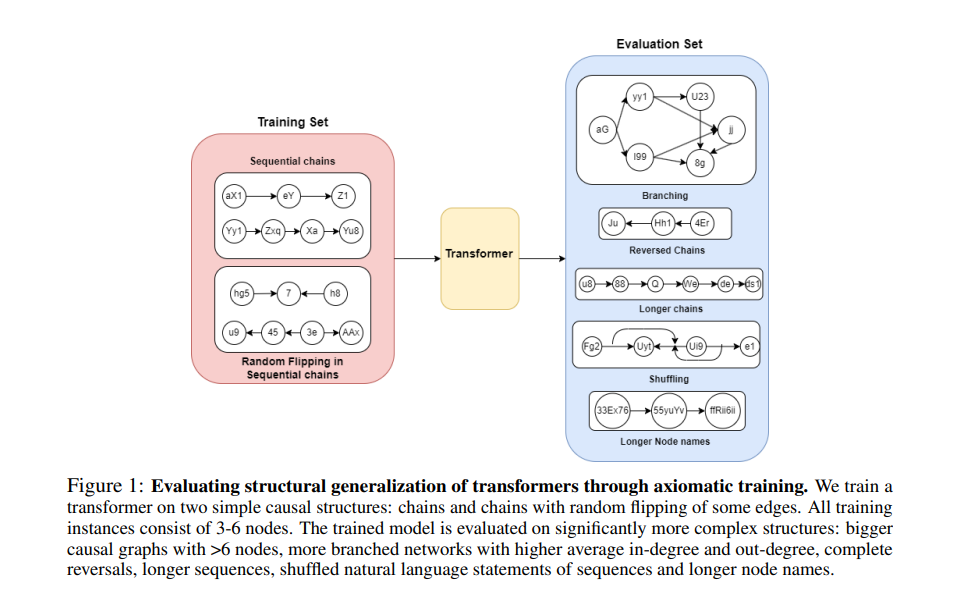

Utiliser la causalité pour construire un ensemble de formation : l'équipe de recherche utilise un modèle de causalité pour construire un ensemble de données de formation. Ce modèle peut révéler le lien de causalité entre les variables et aider à former un modèle capable de comprendre la logique causale derrière les données.

Enseigner les axiomes de base du modèle : ils enseignent directement les prémisses de base en logique et en mathématiques au modèle pour l'aider à effectuer un meilleur raisonnement logique.

Les performances étonnantes du petit modèle Transformer : bien que les paramètres du modèle ne soient que de 67 millions, le modèle Transformer formé via cette méthode est comparable au GPT-4 en termes de capacités de raisonnement.

Le raisonnement causal peut sembler réservé aux philosophes, mais en fait, il a déjà pénétré tous les aspects de nos vies. Pour l’intelligence artificielle, maîtriser le raisonnement causal, c’est comme apprendre à expliquer le monde en utilisant « parce que… alors… ». Mais l’IA ne naît pas avec cela, elle a besoin d’apprendre, et ce processus d’apprentissage est l’histoire de cet article.

Méthode de formation aux axiomes :

Imaginez que vous ayez un élève très intelligent mais qui n’a aucune idée des causes et des effets dans le monde. Comment l’enseigner ? Les chercheurs ont trouvé une solution : la formation aux axiomes. Cela revient à donner à l’IA un « manuel de causalité » et à lui permettre d’apprendre à identifier et à appliquer les règles de causalité grâce à ce manuel.

Les chercheurs ont mené des expériences avec le modèle de transformateur et ont constaté que cette méthode de formation fonctionne vraiment. Non seulement l'IA a appris à identifier des relations causales sur des graphiques à petite échelle, mais elle a également pu appliquer ces connaissances à des graphiques plus grands, même si ! Il n’a jamais vu une situation aussi vaste auparavant.

La contribution de cette recherche est qu’elle fournit une nouvelle méthode permettant à l’IA d’apprendre l’inférence causale à partir de données passives. Cela revient à donner à l’IA une nouvelle façon de « penser » afin qu’elle puisse mieux comprendre et expliquer le monde.

Cette recherche nous permet non seulement de voir la possibilité pour l’IA d’apprendre le raisonnement causal, mais nous ouvre également la porte à des scénarios d’application possibles de l’IA dans le futur. Peut-être que dans un avenir proche, nos assistants intelligents seront capables non seulement de répondre aux questions, mais aussi de nous expliquer pourquoi quelque chose se passe.

Adresse papier : https://arxiv.org/pdf/2407.07612v1

Dans l’ensemble, ces recherches ont apporté des améliorations significatives aux capacités de raisonnement causal de l’intelligence artificielle et ont fourni de nouvelles orientations et possibilités pour le développement futur de l’IA. L’éditeur de Downcodes attend avec impatience l’application de cette technologie dans davantage de domaines, permettant à l’IA de mieux comprendre et servir les humains.