La technologie de génération d'image en vidéo (I2V) évolue rapidement dans le but de créer des vidéos plus réalistes et contrôlées. L'éditeur de Downcodes présentera aujourd'hui un nouveau framework appelé Motion-I2V, qui a fait une percée significative dans le domaine de la génération I2V grâce à la modélisation explicite du mouvement. Développé par des chercheurs tels que Xiaoyu Shi et Zhaoyang Huang, ce cadre est innovant dans la mesure où il décompose le processus de conversion d'image en vidéo en deux étapes et combine intelligemment les couches de prédiction du champ de mouvement et de synchronisation d'amélioration du mouvement pour obtenir une qualité supérieure, plus cohérente et plus cohérente. génération vidéo contrôlable.

Avec le développement rapide de la technologie de l’intelligence artificielle, la technologie de génération d’image en vidéo (I2V) est devenue un sujet de recherche brûlant. Récemment, une équipe composée de chercheurs tels que Xiaoyu Shi et Zhaoyang Huang a introduit un nouveau cadre appelé Motion-I2V, qui permet une génération d'image en vidéo plus cohérente et contrôlable grâce à une modélisation de mouvement explicite. Cette avancée technologique améliore non seulement la qualité et la cohérence de la génération vidéo, mais offre également aux utilisateurs une expérience de contrôle sans précédent.

Dans le domaine de la génération image-vidéo, comment maintenir la cohérence et la contrôlabilité des vidéos générées a toujours été un problème technique. Les méthodes I2V traditionnelles apprennent directement le mappage complexe des images aux vidéos, tandis que le framework Motion-I2V décompose de manière innovante ce processus en deux étapes et introduit une modélisation explicite du mouvement dans les deux étapes.

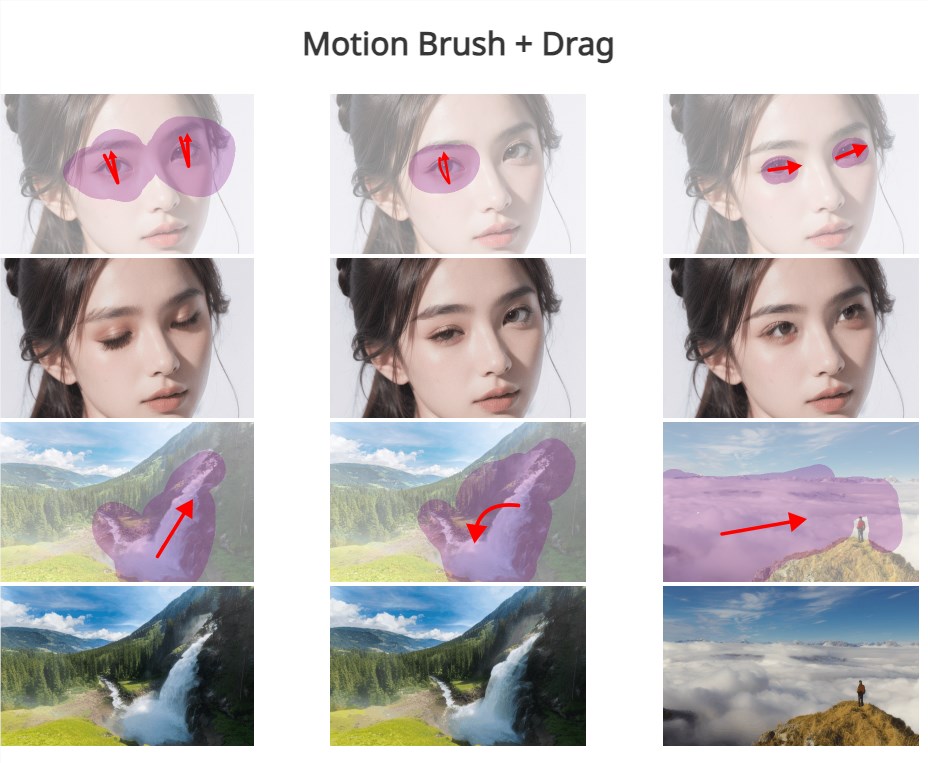

Dans un premier temps, Motion-I2V propose un prédicteur de champ de mouvement basé sur la diffusion qui se concentre sur la dérivation des trajectoires des pixels de l'image de référence. La clé de cette étape est de prédire la carte du champ de mouvement entre l’image de référence et toutes les images futures à l’aide de l’image de référence et des signaux textuels. La deuxième étape est chargée de propager le contenu de l'image de référence dans la trame composite. En introduisant une nouvelle couche temporelle augmentée par le mouvement, l'attention temporelle 1D est améliorée, le champ de réception temporel est élargi et la complexité de l'apprentissage direct de modèles spatio-temporels complexes est atténuée.

Par rapport aux méthodes existantes, Motion-I2V présente des avantages évidents. Que ce soit dans des scénarios tels que "un réservoir en mouvement rapide", "une BMW bleue roulant vite", "trois glaçons clairs" ou un "escargot rampant", Motion-I2V produit une vidéo plus cohérente, même en haute qualité. maintenu sous une large gamme de mouvements et de changements d’angle de vision.

De plus, Motion-I2V aide également les utilisateurs à contrôler avec précision les trajectoires et les zones de mouvement grâce à des trajectoires clairsemées et des annotations de zone, offrant ainsi plus de capacités de contrôle que de s'appuyer uniquement sur des instructions textuelles. Cela améliore non seulement l'expérience interactive de l'utilisateur, mais offre également la possibilité de personnaliser la génération vidéo.

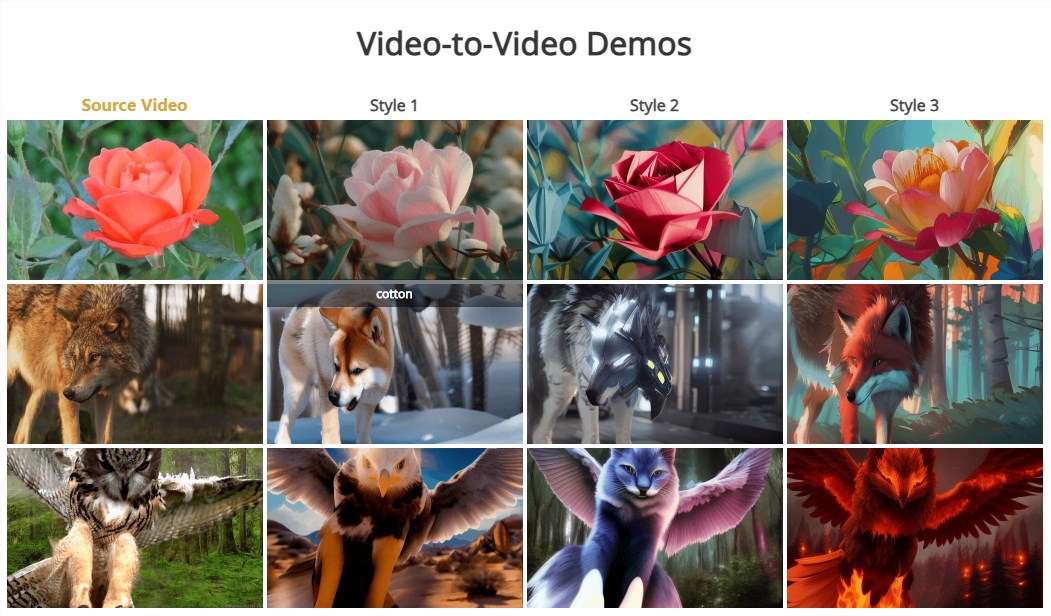

Il convient de mentionner que la deuxième étape de Motion-I2V prend également naturellement en charge la conversion vidéo-vidéo sans échantillon, ce qui signifie que la conversion vidéo de différents styles ou contenus peut être réalisée sans échantillons d'entraînement.

Le lancement du framework Motion-I2V marque une nouvelle étape dans la technologie de génération d'image en vidéo. Il permet non seulement d'améliorer considérablement la qualité et la cohérence, mais montre également un grand potentiel en matière de contrôle et de personnalisation par l'utilisateur. À mesure que la technologie continue de mûrir et de s'améliorer, nous avons des raisons de croire que Motion-I2V jouera un rôle important dans la production cinématographique et télévisuelle, la réalité virtuelle, le développement de jeux et d'autres domaines, offrant aux gens une expérience visuelle plus riche et plus vivante.

Adresse du document : https://xiaoyushi97.github.io/Motion-I2V/

Adresse github : https://github.com/GUN/Motion-I2V

L'émergence du framework Motion-I2V a apporté de nouvelles possibilités à la technologie I2V, et ses améliorations en termes de qualité, de cohérence et de contrôle utilisateur de la génération vidéo méritent d'être attendues. À l'avenir, avec le développement de la technologie, je pense que Motion-I2V sera appliqué dans davantage de domaines et nous apportera une expérience visuelle plus excitante. Attendez-vous à des applications plus innovantes basées sur ce cadre.