Récemment, l’expérience utilisateur du chatbot IA d’Anthropic, Claude, a suscité de vives discussions. Un grand nombre de commentaires d'utilisateurs sont apparus sur Reddit, indiquant que les performances de Claude ont diminué, se manifestant spécifiquement par une perte de mémoire et une diminution de la capacité de codage. Cet incident a déclenché de nombreuses discussions sur l'évaluation des performances et l'expérience utilisateur des grands modèles de langage, et a une fois de plus mis en évidence les défis auxquels sont confrontées les entreprises d'IA pour maintenir la stabilité des modèles.

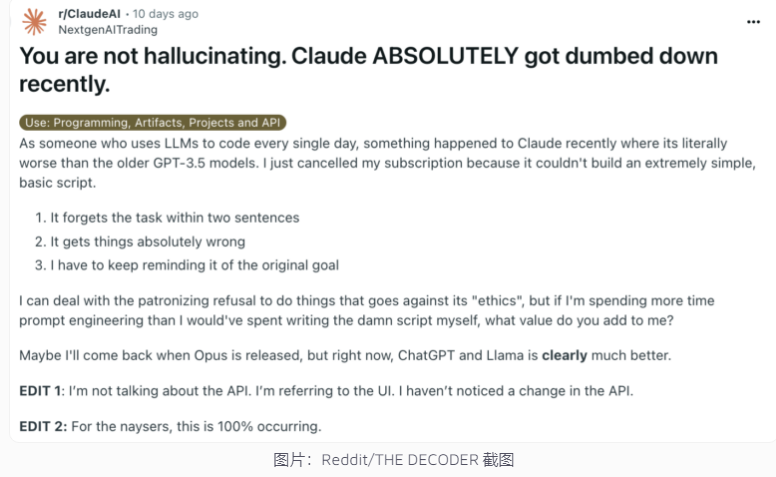

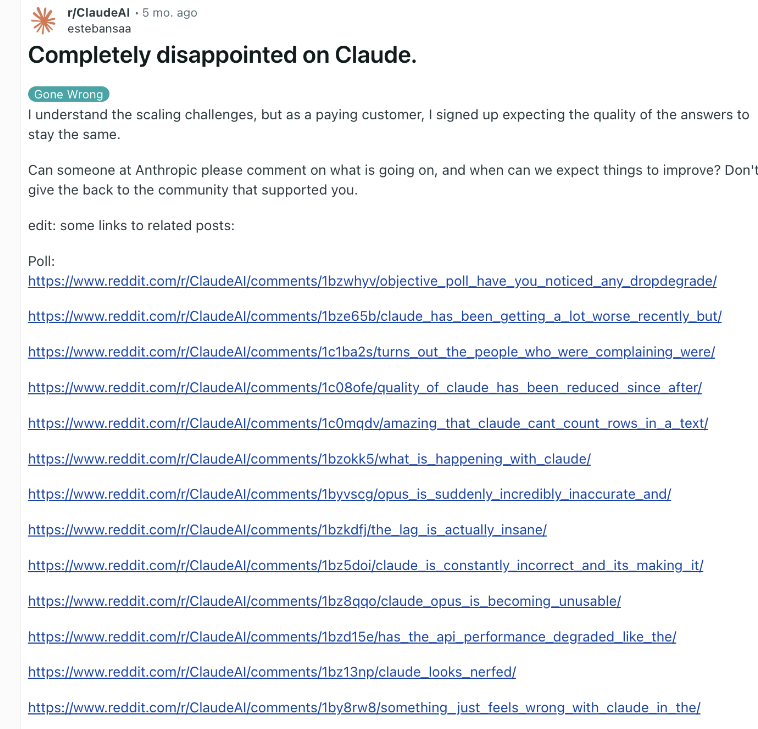

Récemment, Claude, le chatbot IA d’Anthropic, a de nouveau été impliqué dans une controverse sur les performances. Un article sur Reddit affirmant que Claude était devenu beaucoup plus stupide a récemment attiré l'attention, de nombreux utilisateurs signalant avoir subi une baisse des capacités de Claude, notamment une perte de mémoire et une diminution de sa capacité à coder.

En réponse, Alex Albert, directeur d'Anthropic, a répondu que l'enquête de la société n'avait trouvé aucun problème courant et a confirmé qu'aucune modification n'avait été apportée au modèle Claude3.5Sonnet ou au pipeline d'inférence. Pour améliorer la transparence, Anthropic a publié les invites système du modèle Claude sur son site officiel.

Ce n’est pas la première fois que des utilisateurs signalent une dégradation de l’IA et l’entreprise l’a nié. Fin 2023, ChatGPT d’OpenAI était également confronté à des doutes similaires. Selon les initiés de l'industrie, les raisons de ce phénomène peuvent inclure : les attentes des utilisateurs qui augmentent avec le temps, les changements naturels dans la production de l'IA, les limitations temporaires des ressources informatiques, etc.

Cependant, ces facteurs peuvent toujours conduire à une dégradation des performances perçue par l'utilisateur, même si le modèle sous-jacent ne subit pas de changements significatifs. OpenAI a un jour souligné que le comportement de l’IA lui-même est imprévisible et que maintenir et évaluer les performances de l’IA générative à grande échelle constitue un défi de taille.

Anthropic a déclaré qu'il continuerait à prêter attention aux commentaires des utilisateurs et à travailler dur pour améliorer la stabilité des performances de Claude. L’incident met en évidence les défis auxquels les entreprises d’IA sont confrontées pour maintenir la cohérence des modèles, ainsi que l’importance d’accroître la transparence dans l’évaluation des performances et la communication de l’IA.

La controverse sur les performances de Claude reflète la complexité du développement et du déploiement de grands modèles de langage, ainsi que l'écart entre les attentes des utilisateurs et les applications réelles. À l’avenir, les entreprises d’IA devront améliorer encore la stabilité des modèles et maintenir une communication plus efficace avec les utilisateurs afin de garantir que la technologie d’IA puisse continuer à fournir des services fiables aux utilisateurs.