Le dernier grand modèle multimodal à usage général d'Alibaba, mPLUG-Owl3, a déclenché une tempête dans le domaine de l'intelligence artificielle grâce à ses puissantes capacités de compréhension multimodale et son incroyable efficacité de raisonnement. Il peut comprendre 2 heures de contenu vidéo en 4 secondes et répondre avec précision aux diverses questions soulevées par les utilisateurs, démontrant d'excellentes performances en matière de compréhension d'images, de vidéos et de textes. Cette avancée technologique constitue non seulement une étape importante dans le monde universitaire, mais annonce également un changement futur dans la manière dont l’IA interagit avec les humains.

À l’ère de l’explosion de l’information, nous utilisons des images et des vidéos pour enregistrer nos vies et partager notre bonheur au quotidien. Mais avez-vous déjà pensé à ce qui se passerait s’il existait une technologie permettant aux machines non seulement de comprendre ces images et vidéos comme les humains, mais aussi de communiquer avec nous en profondeur ?

Le dernier grand modèle multimodal à usage général mPLUG-Owl3 publié par l'équipe Alibaba, avec son incroyable efficacité et sa capacité de compréhension, nous permet de regarder un film de 2 heures en 4 secondes. Ce n'est pas seulement un modèle, mais plutôt ! C'est un assistant IA capable de voir, d'écouter, de parler et de penser.

mPLUG-Owl3, le nom sonne comme un hibou portant des lunettes, intelligent et alerte. Sa principale capacité est la compréhension de longues séquences d’images. Qu’il s’agisse d’une série de photos ou d’une vidéo, il peut en comprendre le contenu et même comprendre le scénario.

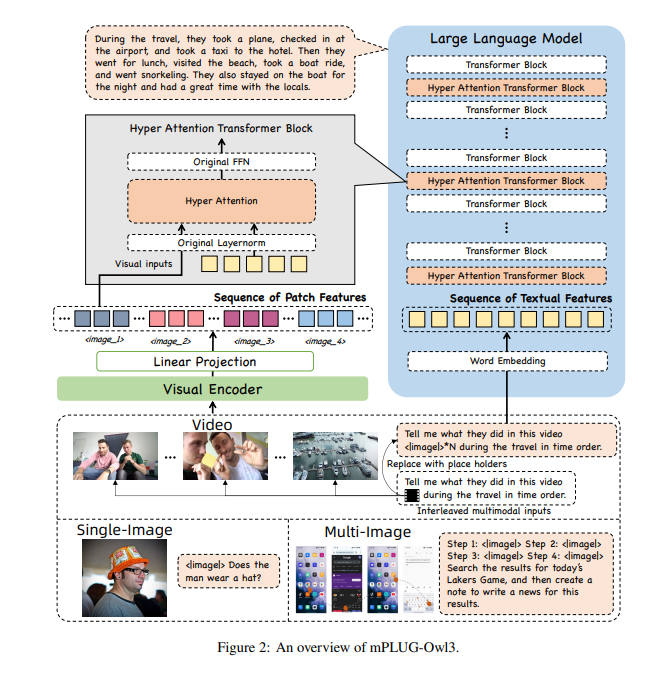

Afin de permettre à mPLUG-Owl3 de traiter autant d’informations, les chercheurs l’ont équipé d’un module super cerveau-hyper-attention. Ce module est comme un super cerveau pour l'IA, capable de traiter simultanément des informations visuelles et linguistiques, permettant à l'IA de comprendre à la fois les images et les informations textuelles associées.

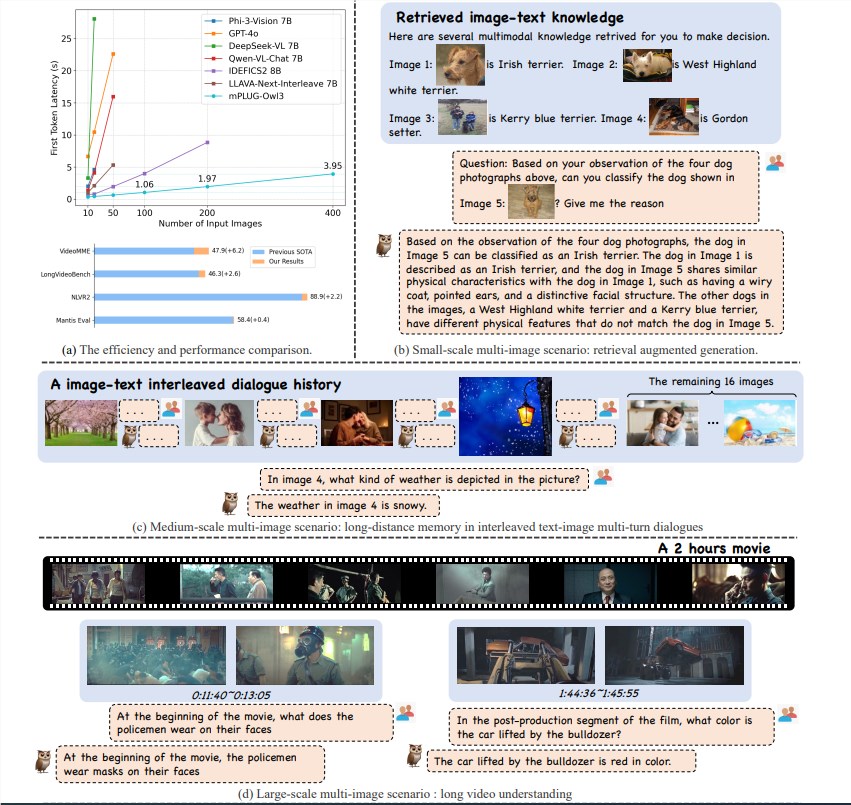

Le modèle mPLUG-Owl3 a réalisé une avancée majeure dans le domaine de la compréhension multimodale grâce à son excellente efficacité de raisonnement. Il atteint non seulement SOTA (état de l'art) dans des tests de référence multi-scénarios tels qu'une image unique, plusieurs images, vidéo, etc., mais réduit également de 6 fois la latence du premier jeton et le nombre d'images pouvant être traitées. par une seule carte graphique A100 augmente de 8 fois, atteignant 400 feuilles.

mPLUG-Owl3 peut comprendre avec précision les connaissances multimodales entrantes et les utiliser pour répondre aux questions. Il peut même vous indiquer sur quelles connaissances il fonde son jugement, ainsi que les bases détaillées de son jugement.

mPLUG-Owl3 peut comprendre correctement les relations de contenu dans différents matériaux et mener un raisonnement approfondi. Qu'il s'agisse de différences stylistiques ou de reconnaissance de caractères, il gère tout cela avec facilité.

mPLUG-Owl3 est capable de regarder et de comprendre des vidéos d'une durée maximale de 2 heures et peut commencer à répondre aux questions des utilisateurs dans les 4 secondes, quelle que soit la partie de la vidéo concernée par la question.

mPLUG-Owl3 utilise un module Hyper Attention léger pour étendre le bloc Transformer en un nouveau module capable d'interagir avec des fonctionnalités graphiques et textuelles et de modéliser du texte. Cette conception réduit considérablement le nombre de nouveaux paramètres supplémentaires introduits, ce qui rend le modèle plus facile à entraîner, et l'efficacité de l'entraînement et de l'inférence est également améliorée.

En expérimentant sur un large éventail d'ensembles de données, mPLUG-Owl3 obtient des résultats SOTA sur la plupart des benchmarks multimodaux à image unique. Dans les évaluations multi-images, il surpasse les modèles spécifiquement optimisés pour les scénarios multi-images. Sur LongVideoBench, il a surpassé les modèles existants, démontrant son excellente capacité à comprendre les vidéos longues.

La sortie d'Alibaba mPLUG-Owl3 constitue non seulement un saut technologique, mais offre également de nouvelles possibilités d'application de grands modèles multimodaux. À mesure que la technologie continue de s'améliorer, nous espérons que mPLUG-Owl3 apportera d'autres surprises à l'avenir.

Adresse papier : https://arxiv.org/pdf/2408.04840

Code : https://github.com/X-PLUG/mPLUG-Owl/tree/main/mPLUG-Owl3

Expérience en ligne : https://huggingface.co/spaces/mPLUG/mPLUG-Owl3

L'émergence de mPLUG-Owl3 marque une nouvelle étape dans le développement de la technologie multimodale des grands modèles. Ses capacités de traitement efficaces et ses capacités de compréhension précise ouvrent de larges perspectives pour les futures applications technologiques de l'IA. Je crois qu'à mesure que la technologie continue de mûrir, mPLUG-Owl3 apportera plus de commodité et de surprises à la vie des gens. Dans l'attente de applications plus innovantes basées sur mPLUG-Owl3.