L'API Anthropic introduit une nouvelle fonctionnalité tant attendue : la mise en cache des indices, qui améliorera considérablement l'efficacité et l'économie des modèles Claude. Cette fonctionnalité permet aux développeurs de mettre en cache les informations contextuelles fréquemment utilisées entre les appels d'API, réduisant ainsi les calculs redondants et réduisant les coûts et la latence. Pour les scénarios d'application qui doivent traiter de grandes quantités d'informations contextuelles, tels que les agents conversationnels, les assistants de codage et le traitement de documents volumineux, la mise en cache des indices apportera d'énormes améliorations de performances. Cette mise à jour est actuellement en version bêta publique pour Claude3.5 Sonnet et Claude3 Haiku, avec des plans d'extension pour Claude3 Opus.

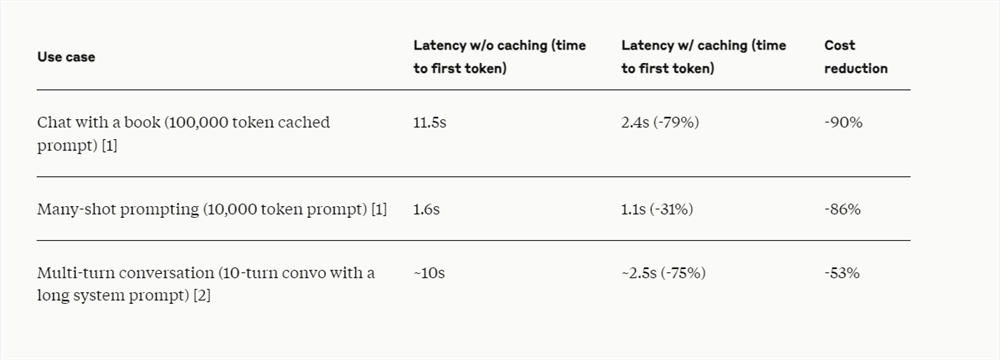

L'API Anthropic a récemment lancé la mise en cache des invites, afin que les développeurs puissent désormais mettre en cache les informations contextuelles couramment utilisées entre les appels d'API. Grâce à la mise en cache des indices, les clients sont en mesure de fournir aux modèles Claude davantage de connaissances de base et d'exemples de sortie tout en réduisant considérablement le coût des indices longs, en réduisant les frais jusqu'à 90 % et la latence jusqu'à 85 %.

Cette fonctionnalité est actuellement disponible dans les versions bêta publiques de Claude3.5Sonnet et Claude3Haiku, et prendra également en charge Claude3Opus à l'avenir.

La fonctionnalité de mise en cache des invites est particulièrement utile dans les scénarios dans lesquels un grand nombre de contextes d'invite doivent être référencés à plusieurs reprises dans plusieurs requêtes, comme dans les proxys conversationnels pour réduire le coût et la latence des longues conversations, en particulier lorsqu'elles contiennent des instructions complexes ou des téléchargements de documents. L'assistant de saisie semi-automatique et les questions et réponses sur la base de code peuvent être améliorés en conservant une version résumée de la base de code dans l'invite ; lorsque vous travaillez avec des documents volumineux, le cache d'invite permet d'intégrer du matériel complet sans augmenter les temps de réponse, pour les systèmes qui impliquent plusieurs séries de questions ; appels et itérations d'outils Les scénarios modifiés de recherche de proxy et d'utilisation des outils, la mise en cache des invites peuvent également améliorer considérablement les performances.

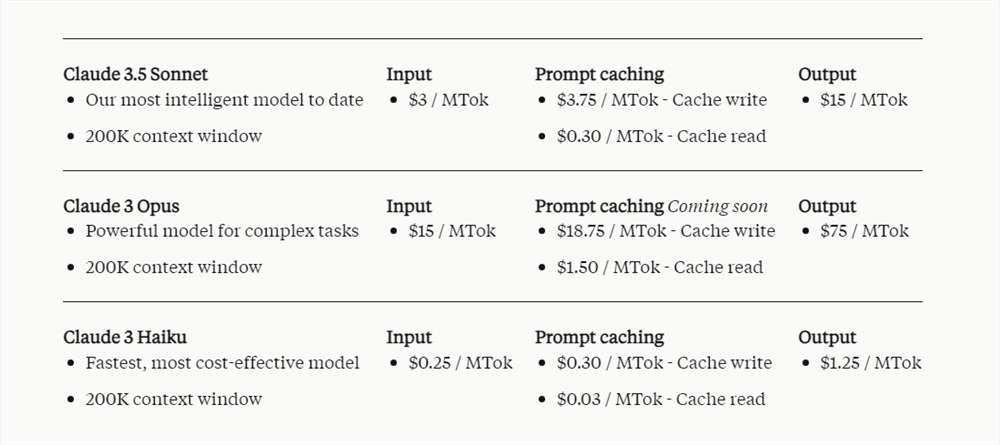

Le prix du cache de pourboires dépend du nombre de jetons d’entrée mis en cache et de la fréquence d’utilisation. L'écriture dans le cache coûte 25 % de plus que le prix de base du jeton d'entrée, tandis que l'utilisation du contenu mis en cache coûte beaucoup moins cher, à seulement 10 % du prix de base du jeton d'entrée.

Il est rapporté que Notion, en tant que client d'Anthropic API, a intégré la fonction de mise en cache rapide dans son assistant d'intelligence artificielle Notion AI. En réduisant les coûts et en augmentant la vitesse, Notion optimise les opérations internes et offre aux utilisateurs une expérience plus avancée et plus rapide.

Le lancement de la fonction de mise en cache rapide reflète les efforts d'Anthropic pour optimiser les performances du modèle Claude et réduire les coûts d'utilisation, en fournissant aux développeurs des solutions d'IA plus rentables et en améliorant encore la praticité du modèle Claude dans divers scénarios d'application. Les réussites de Notion prouvent également la valeur pratique de cette fonctionnalité.