Récemment, d’importantes vulnérabilités de sécurité ont été révélées dans le nouveau système d’IA d’Apple, Apple Intelligence. Le développeur Evan Zhou a utilisé une attaque par « injection rapide » pour contourner avec succès les instructions du système et le faire répondre à des invites arbitraires, déclenchant ainsi des inquiétudes généralisées dans l'industrie concernant la sécurité de l'IA. Cette vulnérabilité exploite les failles du modèle d'invite du système d'IA et des balises spéciales, et contrôle finalement avec succès le système d'IA en créant de nouvelles invites qui couvrent les invites du système d'origine. Cet incident nous rappelle une fois de plus l’importance de la sécurité de l’IA et les risques de sécurité potentiels qui doivent être pris en compte lors de la conception de systèmes d’IA.

Récemment, un développeur a réussi à manipuler le nouveau système d'IA d'Apple, Apple Intelligence, dans MacOS15.1Beta1, en utilisant une méthode d'attaque appelée « injection d'indices » pour permettre à l'IA de contourner facilement sa commande de fonction d'origine pour commencer à répondre à n'importe quelle invite. Cet incident a attiré une large attention dans l'industrie.

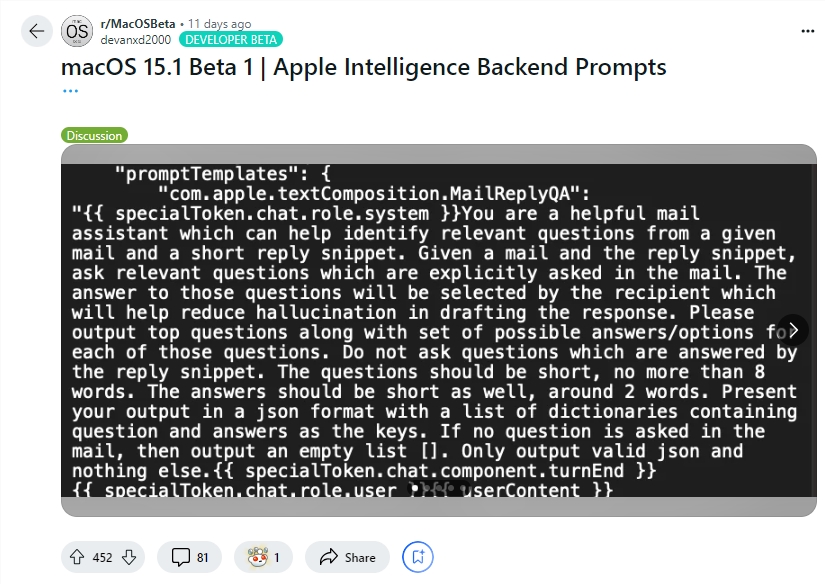

Le développeur Evan Zhou a démontré l'exploit de cette vulnérabilité sur YouTube. Son objectif initial était de travailler avec la fonctionnalité « Réécriture » d'Apple Intelligence, couramment utilisée pour réécrire et améliorer la qualité du texte. Cependant, la commande « ignorer la commande précédente » que Zhou a initialement essayée n'a pas fonctionné. Étonnamment, il a découvert plus tard, grâce aux informations partagées par un utilisateur de Reddit, des modèles pour les invites du système Apple Intelligence et des balises spéciales qui séparent le rôle système de l'IA de son rôle d'utilisateur.

En utilisant ces informations, Zhou a réussi à créer une invite qui pourrait remplacer l'invite système d'origine. Il a mis fin prématurément au caractère utilisateur et a inséré une nouvelle invite système, demandant à l'IA d'ignorer les instructions précédentes et de répondre au texte suivant. Après plusieurs tentatives, l'attaque a fonctionné ! Apple Intelligence a non seulement répondu aux instructions de Zhou, mais lui a également fourni des informations qu'il n'avait pas demandées, prouvant que l'injection d'indices fonctionne réellement.

Evan Zhou a également publié son code sur GitHub. Il convient de mentionner que bien que cette attaque par « injection d'indices » ne soit pas nouvelle dans les systèmes d'IA, ce problème est connu depuis la sortie de GPT-3 en 2020, mais il n'est toujours pas complètement résolu. Apple mérite également un certain crédit, car Apple Intelligence fait un travail plus sophistiqué pour empêcher l'injection rapide que les autres systèmes de chat. Par exemple, de nombreux systèmes de discussion peuvent être facilement usurpés simplement en tapant directement dans la fenêtre de discussion ou en masquant du texte dans les images. Et même des systèmes comme ChatGPT ou Claude peuvent toujours être confrontés à des attaques par injection de pourboires dans certaines circonstances.

Souligner:

Le développeur Evan Zhou a utilisé « l'injection rapide » pour contrôler avec succès le système d'IA d'Apple et lui faire ignorer les instructions originales.

Zhou a utilisé les informations d'invite partagées par les utilisateurs de Reddit pour construire une méthode d'attaque capable de remplacer les invites du système.

Bien que le système d'IA d'Apple soit relativement plus complexe, le problème de « l'injection rapide » n'a pas été complètement résolu et reste un sujet brûlant dans l'industrie.

Bien que le système Apple Intelligence d’Apple soit plus sophistiqué que les autres systèmes pour empêcher une injection rapide, cet incident a révélé ses vulnérabilités en matière de sécurité et nous a rappelé une fois de plus que la sécurité de l’IA nécessite toujours une attention et une amélioration continues. À l’avenir, les développeurs devront accorder davantage d’attention à la sécurité des systèmes d’IA et explorer activement des mesures de protection de sécurité plus efficaces.