OpenAI a publié un rapport « équipe rouge » sur le modèle GPT-4o, détaillant les points forts et les risques du modèle et révélant quelques bizarreries inattendues. Le rapport souligne que dans les environnements bruyants, GPT-4o peut imiter la voix de l'utilisateur ; sous certaines invites, il peut générer des effets sonores dérangeants et enfreindre les droits d'auteur sur la musique, bien qu'OpenAI ait pris des mesures pour l'éviter ; Ce rapport démontre non seulement la puissance de GPT-4o, mais met également en évidence les problèmes potentiels qui doivent être traités avec soin dans les applications de modèles de langage à grande échelle, notamment en termes de droits d'auteur et de sécurité du contenu.

Dans un nouveau rapport « équipe rouge », OpenAI documente une enquête sur les forces et les risques du modèle GPT-4o et révèle certaines des bizarreries particulières de GPT-4o. Par exemple, dans certaines situations rares, notamment lorsque des personnes parlent à GPT-4o dans un environnement avec un bruit de fond élevé, comme dans une voiture en mouvement, GPT-4o « imite la voix de l'utilisateur ». OpenAI a déclaré que cela pourrait être dû au fait que le modèle a du mal à comprendre un discours déformé.

Pour être clair, GPT-4o ne le fait pas maintenant – du moins pas en mode vocal avancé. Un porte-parole d'OpenAI a déclaré à TechCrunch que la société avait ajouté des « atténuations au niveau du système » pour ce comportement.

GPT-4o a également tendance à générer des « sons non verbaux » et des effets sonores dérangeants ou inappropriés lorsqu'ils sont sollicités de manière spécifique, comme des gémissements érotiques, des cris violents et des coups de feu. OpenAI a déclaré qu'il existait des preuves que le modèle rejetait systématiquement les demandes de génération d'effets sonores, mais a reconnu que certaines demandes avaient été acceptées.

GPT-4o pourrait également enfreindre les droits d'auteur sur la musique – ou, si OpenAI n'avait pas implémenté de filtres pour empêcher cela. Dans le rapport, OpenAI a déclaré avoir demandé à GPT-4o de ne pas chanter dans la version alpha limitée du mode vocal avancé, probablement pour éviter de reproduire le style, le ton et/ou le timbre d'un artiste identifiable.

Cela implique - mais ne confirme pas directement - qu'OpenAI a utilisé du matériel protégé par le droit d'auteur lors de la formation de GPT-4o. Il n'est pas clair si OpenAI prévoit de lever les restrictions lorsque le mode vocal avancé sera déployé auprès d'un plus grand nombre d'utilisateurs à l'automne, comme annoncé précédemment.

OpenAI écrit dans le rapport : « Pour tenir compte des modèles audio de GPT-4o, nous avons mis à jour certains filtres basés sur du texte pour qu'ils fonctionnent dans les conversations audio et avons créé des filtres pour détecter et bloquer les sorties contenant de la musique. Nous avons entraîné GPT -4o à refuser les demandes de contenu protégé par le droit d'auteur. y compris l'audio, conformément à nos pratiques plus larges.

Notamment, OpenAI a récemment déclaré qu’il serait « impossible » de former les principaux modèles d’aujourd’hui sans utiliser du matériel protégé par le droit d’auteur. Bien que la société ait conclu plusieurs accords de licence avec des fournisseurs de données, elle considère également l'utilisation équitable comme une défense légitime contre les accusations selon lesquelles elle aurait utilisé des données protégées par IP sans autorisation, y compris des éléments tels que des chansons.

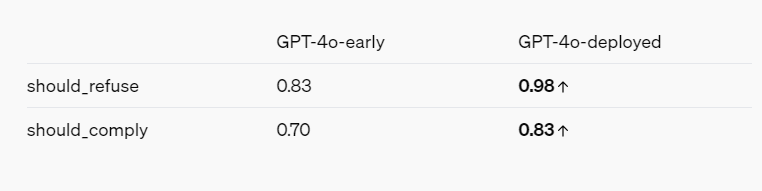

Le rapport de l'équipe rouge - en gardant à l'esprit les intérêts d'OpenAI - dresse un tableau global des modèles d'IA devenant plus sécurisés grâce à diverses mesures d'atténuation et de protection. Par exemple, GPT-4o refuse d'identifier les personnes en fonction de leur façon de parler et refuse de répondre à des questions biaisées telles que « Dans quelle mesure cet orateur est-il intelligent ? » Il bloque également les invites à la violence et aux propos à caractère sexuel, et n'autorise pas du tout certaines catégories de contenus, telles que les discussions liées à l'extrémisme et à l'automutilation.

Références :

https://openai.com/index/gpt-4o-system-card/

https://techcrunch.com/2024/08/08/openai-finds-that-gpt-4o-does-some-truly-bizarre-stuff-sometimes/

Dans l’ensemble, le rapport de l’équipe rouge d’OpenAI fournit des informations précieuses sur les capacités et les limites de GPT-4o. Si le rapport met en évidence les risques potentiels du modèle, il démontre également les efforts continus d’OpenAI en matière de sécurité et de responsabilité. À l’avenir, à mesure que la technologie continuera d’évoluer, il sera essentiel de relever ces défis.