Dans le domaine du développement logiciel, l’application d’outils de codage d’IA déclenche une révolution silencieuse. Les équipes de développement utilisent largement le codage assisté par l’IA. Cependant, la direction de l’entreprise manque de supervision et de contrôle efficaces sur l’utilisation des outils d’IA. Cela a déclenché un « jeu du chat et de la souris » entre les développeurs et la direction concernant l'application des outils d'IA et les risques de sécurité qui en résultent.

Dans le monde de la technologie, il existe un jeu du chat et de la souris entre les développeurs et la direction. Les protagonistes de ce jeu sont ces outils de codage d'IA qui sont explicitement interdits par l'entreprise mais qui sont toujours discrètement utilisés par les développeurs.

Bien que 15 % des entreprises interdisent explicitement l’utilisation d’outils de codage d’IA, presque toutes les équipes de développement (99 %) les utilisent, selon une nouvelle étude mondiale menée par la société de sécurité cloud Checkmarx. Ce phénomène révèle les enjeux du contrôle de l’usage de l’IA générative.

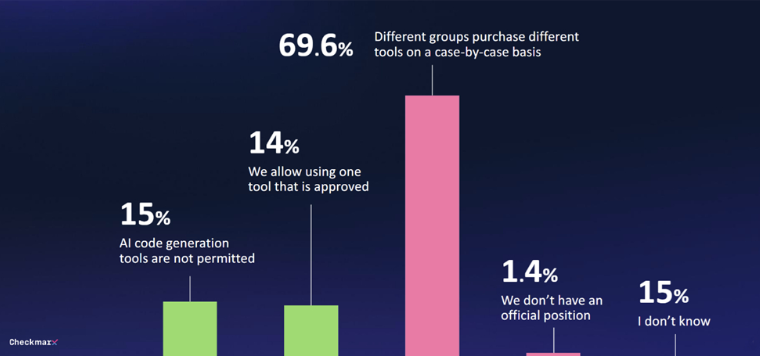

Seules 29 % des entreprises ont mis en place une forme de gouvernance pour les outils d’IA générative. Dans 70 % des cas, il n’existe pas de stratégie unifiée et les décisions d’achat sont prises au coup par coup par différents services. Cette situation rend difficile pour la direction de contrôler l’utilisation des outils de codage d’IA.

Avec la popularité des outils de codage d’IA, les problèmes de sécurité sont devenus de plus en plus importants. 80 % des personnes interrogées s'inquiètent des menaces potentielles que peuvent représenter les développeurs lorsqu'ils utilisent l'IA, notamment 60 % qui expriment des inquiétudes concernant les « hallucinations » provoquées par l'IA.

Malgré les inquiétudes, l’intérêt pour le potentiel de l’IA reste fort. 47 % des personnes interrogées sont disposées à permettre à l'IA d'effectuer des modifications de code sans supervision. Seulement 6 % ont déclaré qu’ils ne feraient pas confiance aux mesures de sécurité de l’IA dans les environnements logiciels.

« Les réponses de ces RSSI mondiaux révèlent la réalité selon laquelle les développeurs utilisent l'IA dans le développement d'applications même s'ils ne peuvent pas créer de manière fiable du code sécurisé à l'aide de l'IA, ce qui signifie que les équipes de sécurité doivent faire face à un flot de nouvelles attaques vulnérables », a déclaré Tzruya. ".

Un rapport récent du Work Trends Index de Microsoft a montré des résultats similaires, de nombreux employés utilisant leurs propres outils d'IA alors qu'aucun n'est fourni. Souvent, ils n’évoquent pas cet usage, ce qui freine l’intégration systématique de l’IA générative dans les processus métiers.

Malgré des interdictions explicites, 99 % des équipes de développement utilisent encore des outils d’IA pour générer du code. Seules 29 % des entreprises ont mis en place des mécanismes de gouvernance pour l’utilisation de l’IA générative. Dans 70 % des cas, les décisions concernant l’utilisation des outils d’IA par les différents services sont prises au coup par coup. Dans le même temps, les préoccupations en matière de sécurité augmentent. 47 % des personnes interrogées sont disposées à permettre à l'IA d'effectuer des modifications de code sans supervision. Les équipes de sécurité sont confrontées au défi de gérer de grandes quantités de code généré par l’IA potentiellement vulnérable.

Ce « jeu du chat et de la souris » entre les développeurs et la direction se poursuit, et nous devrons attendre de voir où va l'avenir des outils de codage de l'IA.

L’application d’outils de codage d’IA est devenue une tendance, mais les risques de sécurité qu’elle entraîne ne peuvent être ignorés. Les entreprises doivent établir un mécanisme de gouvernance solide pour équilibrer les améliorations d’efficacité apportées par l’IA avec les risques potentiels de sécurité afin de mieux s’adapter à cette vague technologique.